Communications Nature

le volume 10, Numéro de l'article: 3674 (2019)

Abstract

Les neurones dopaminergiques du cerveau moyen codent des erreurs de prédiction de récompense (RPE) utilisées pour mettre à jour les prévisions de valeur. Ici, nous examinons si les signaux RPE codés par les neurones à dopamine du cerveau moyen sont modulés par le coût payé pour obtenir des récompenses, en enregistrant à partir des neurones à dopamine chez des singes éveillés se comportant lors de l'exécution d'une tâche de saccade exigeante. Les réponses des neurones dopaminergiques aux signaux prédictifs de récompense et de remise de récompenses augmentaient après l'exécution d'une action coûteuse par rapport à une action moins coûteuse, ce qui suggère que les EPP sont améliorés après l'exécution d'une action coûteuse. Au niveau comportemental, les associations stimulus-récompense sont apprises plus rapidement après une action coûteuse que comparée à une action moins coûteuse. Ainsi, les informations sur le coût de l'action sont traitées dans le système de récompense de la dopamine d'une manière qui amplifie le signal RPE de la dopamine suivant, ce qui favorise un apprentissage plus rapide dans des situations de coût élevé.

Introduction

Les humains et les animaux préfèrent une récompense reçue après avoir déployé beaucoup d'efforts pour l'obtenir par rapport à la même récompense après un effort moindre1,2,3. Un certain nombre d'explications ont été avancées pour expliquer cet effet, telles que la justification de l'effort4,5 et l'effet de contraste6, dans lequel une plus grande valeur est attribuée à un résultat obtenu après un effort rémunéré. Cependant, il reste difficile de savoir si et comment le traitement des informations de récompense dans le cerveau est modulé par les efforts déployés pour obtenir une récompense.

Nous nous sommes concentrés spécifiquement sur le système de dopamine du cerveau moyen, étant donné le rôle de ce système dans la promotion de l'adaptation comportementale aux récompenses.7,8,9. Les neurones dopaminergiques sont connus pour représenter des signaux d'erreur de prédiction de récompense (RPE) susceptibles de faciliter l'apprentissage des prédictions de récompense par les ganglions de la base10,11,12,13,14,15,16,17. La force du RPE dépend de la quantité, de la qualité, de la valeur subjective ou de l’utilité de la récompense.7,18,19,20,21. De plus, l'activité dopaminergique est modulée par les coûts et / ou l'effort22,23. Sur cette base, nous avons postulé que le signal RPE dopaminergique serait directement modulé par le coût payé pour obtenir une récompense. De plus, comme le signal RPE est impliqué de manière causale dans l'apprentissage intermédiaire des associations stimulus-récompense24,25,26, nous avons émis l’hypothèse que le coût payé pour obtenir la récompense augmenterait directement la vitesse d’apprentissage des associations stimulant-récompense.

Pour tester nos hypothèses, nous avons mesuré le comportement et l'activité dopaminergique chez deux singes japonais alors qu'ils effectuaient une tâche d'effort basée sur la saccade. Les singes réagissent plus rapidement à un signal prédictif de récompense présenté après une action à coût élevé (HC) par rapport à celui après une action à faible coût (LC). L'activité des neurones dopaminergiques aux signaux prédictifs de récompense est augmentée du coût payé. En outre, la rapidité d'apprentissage de l'association stimulus-récompense est également améliorée par le coût payé. Par conséquent, nous suggérons que le coût payé pour obtenir des récompenses augmente le signal RPE dans les neurones dopaminergiques et améliore ainsi les associations stimulus-récompense.

Résultats

Tâche de saccade HLC (High-Low Cost)

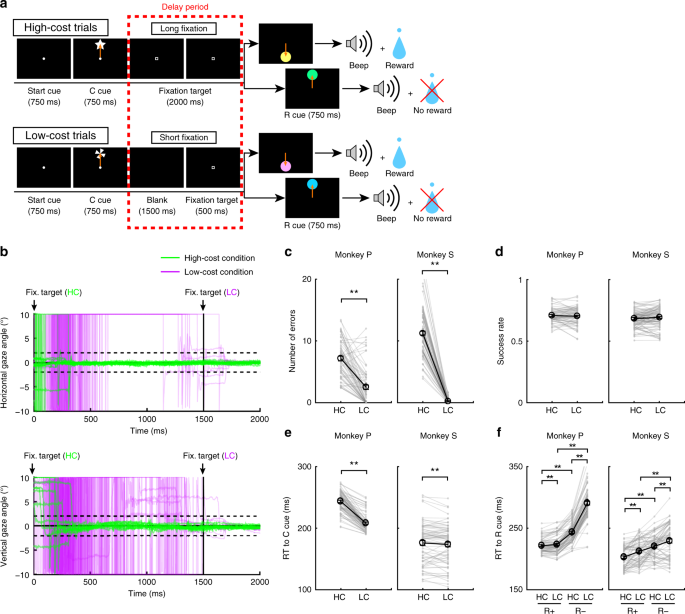

Pour examiner l’effet du coût payé sur le comportement et sur l’activité des neurones dopaminergiques, les singes ont effectué une tâche de saccade avec deux conditions de coût (Fig. 1a, voir Méthodes). Dans des essais avec HC, les singes ont rapidement saccadé la cible et ont maintenu leur regard sur elle sans clignoter pendant une longue période (Fig. 1b; lignes vertes). Au contraire, lors des essais de LC, les singes ont commencé à regarder librement avant de se fixer pendant une période plus courte (Fig. 1b, lignes violettes). Parce que maintenir une fixation longue est difficile pour les singes, ils ont fait plus d’erreurs lors des retards dans les essais de HC (Fig. 1c). Pour contrôler une différence conséquente de probabilité de récompense entre les essais HC et les essais LC, nous avons inséré des avortements forcés dans une partie des essais LC afin d’égaliser les taux de réussite et les probabilités de récompense entre les types d’essais (Fig. 1d).

Tâche de saccade HLC. a La tâche de saccade du HLC. Les indices de coût (repère C) signalaient la quantité d'effort nécessaire pour obtenir une récompense potentielle. Une longue fixation a été nécessaire pendant la période de retard dans les essais à coût élevé. Le signal de récompense (repère R) indique si les singes pourraient obtenir une récompense ou non. b L'évolution temporelle de l'angle du regard pendant la période de retard. Les panneaux supérieur et inférieur montrent les angles de regard horizontaux et verticaux, respectivement. Les lignes vertes et violettes indiquent l'angle de regard dans les essais à coût élevé (essais 50 dans chaque panel) et dans les essais à faible coût (essais 50 dans chaque panel), respectivement. c Le nombre d’erreurs commises pendant le délai dans les essais à coût élevé et à faible coût (**P < 0.01; jumelé à deux queues t tester; t67 = 8.8, P = 4.8 × 10-15, n = 68 pour le singe P; t83 = 26.6, P ≈ 0, n = 84 pour Monkey S). Les cercles noirs et les barres d'erreur indiquent la moyenne et le SEM. d Les taux de réussite des essais à coût élevé et à faible coût (deux paires couplées t tester; t67 = 0.51, P = 0.61, n = 68 pour le singe P; t83 = 0.79, P = 0.43, n = 84 pour Monkey S). e RT aux indices de coût (**P <0.01; jumelé à deux queues t tester; t67 = 20.4, P ≈ 0, n = 68 pour le singe P; t69 = 2.0, P = 1.2 × 10-3, n = 70 pour Monkey S). f RT aux signaux de récompense (**P <0.01; jumelé à deux queues t tester; Singe P (n = 68): HC + contre LC +, t67 = 3.5, P = 9.2 × 10-4; HC− contre LC−, t67 = 24.5, P ≈ 0; HC + contre HC−, t67 = 21.6, P ≈ 0; LC + contre LC−, t67 = 28.5, P ≈ 0; Singes (n = 70): HC + contre LC +, t69 = 5.6, P = 4.4 × 10-7; HC− contre LC−, t69 = 4.8, P = 8.4 × 10-5; HC + vs. HC−, t69 = 18.0, P ≈ 0; LC + contre LC−, t69 = 5.9, P = 1.1 × 10-7)

Le coût payé augmente la valeur des signaux prédictifs de récompense

Pour obtenir des preuves implicites d'une différence dans l'évaluation subjective des indices du singe, nous avons testé les temps de réaction (RT) des singes. En particulier, nous nous attendions à ce que si les singes attribuent une valeur subjective plus élevée à une option qu’une autre, ils devraient afficher des temps de réponse plus rapides pour l’option la plus valorisée.27. Lorsque les RT ont été comparés entre les signaux de coût, les deux singes ont montré des RT plus rapides pour le LC que pour le signal HC (Fig. 1e), démontrant une préférence implicite pour la condition LC. Lorsque les RT ont été comparés entre les signaux de récompense, les deux singes ont montré des RT plus rapides pour récompenser (R +) des signaux que pas de signaux de récompense (R−) (Fig. 1f), indiquant qu'ils préféraient les indices R + aux indices R−. En outre, les deux singes ont montré des RT plus rapides au RHC+ queue comparée à la RLC+ queue et à la RHC- queue comparée à la RLC- queue (Fig. 1f), ce qui indique qu'ils valorisaient davantage les signaux prédictifs de récompense dans le HC comparé à la condition de LC.

De plus, nous avons inclus des essais de choix dans la tâche HLC Saccade pour tester les préférences manifestes des singes entre les signaux (Fig. Supplémentaire). 1a). Les singes ont choisi préférentiellement le signal LC lorsqu'ils choisissent un signal de coût (Fig. Supplémentaire). 1b). Monkey S a choisi préférentiellement le RHC+ cue lors de l'exécution de la tâche de choix entre RHC+ et RLC+ queue, mais pas de préférence entre RHC- et RLC- indices (Fig. Supplémentaire) 1c, d). En revanche, le singe P ne montre aucune préférence manifeste entre RHC+ et RLC+ indices, mais néanmoins préféré le RHC- cue lors du choix entre RHC- et RLC- indices (Fig. Supplémentaire) 1c, d).

Résultats électrophysiologiques dans la tâche de saccade HLC

Nous avons enregistré l'activité d'une seule unité à partir de neurones situés dans la substance noire (SNC) et dans la région tegmentale ventrale (VTA) au cours de la tâche de saccade HLC. Nous avons identifié les neurones dopaminergiques 70 chez les deux singes (Fig. 2a; Neurones 18 et 52 de Monkey P et S, respectivement). L’examen histologique a confirmé que les neurones étaient situés dans ou autour de la SNc / VTA (Fig. 2b).

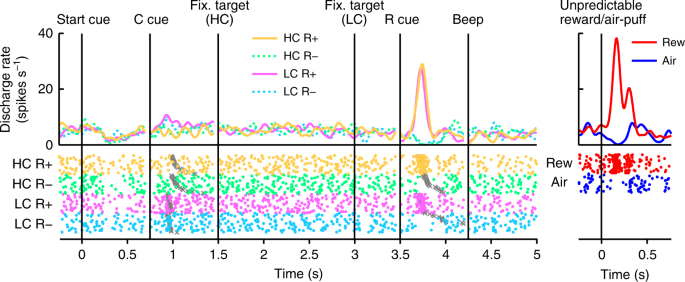

En figue. 2, nous montrons l’activité d’un neurone dopaminergique représentatif. Ce neurone a montré une activation modeste au signal de LC, et une activation ou une suppression phasique de la récompense (RHC+ et RLC+) ou pas d'indice de récompense (RHC- et RLC-), respectivement (Fig. 2, Fig. Supplémentaire 3). Le neurone a également montré une activation phasique à la récompense imprévisible ainsi qu'une suppression phasique en réponse à un stimulus aversif, une bouffée d'air imprévisible (Fig. 2, panneau de droite). En outre, le neurone a montré une suppression modeste du signal de départ, mais n'a pas répondu à la délivrance de récompense. La population entière de neurones dopaminergiques que nous avons enregistrés a tous montré des réponses similaires au signal de départ et à la délivrance de récompense (Fig. 4a, b). Dans la tâche HLC Saccade, un coût d’effort était payé avant d’obtenir la récompense. Parce que le coût prévu réduit l'activité des neurones dopaminergiques22,23, les réponses neuronales dopaminergiques seraient supprimées au moment de la présentation de la séquence de départ16.

Activité d'un neurone dopaminergique représentatif dans la tâche de saccade HLC. Les fonctions de densité de pointes (convolues avec une fonction gaussienne) et les tracés matriciels sont alignés sur la date de début du signal de départ, le repère de coût (repère C), la cible de fixation, le repère de récompense (repère R) et le bip. Chaque couleur représente une condition (jaune: HC +, vert: HC−, rose: LC +, cyan: LC−), respectivement. Les moments du début de la saccade sont indiqués par des croix grises. Les réponses des neurones dopaminergiques à la récompense imprévisible ou au souffle d'air sont également représentées dans le panneau de droite (rouge: récompense imprévisible, bleu: le souffle d'air imprévisible).

Les neurones dopaminergiques codent des informations sur la récompense et le coût

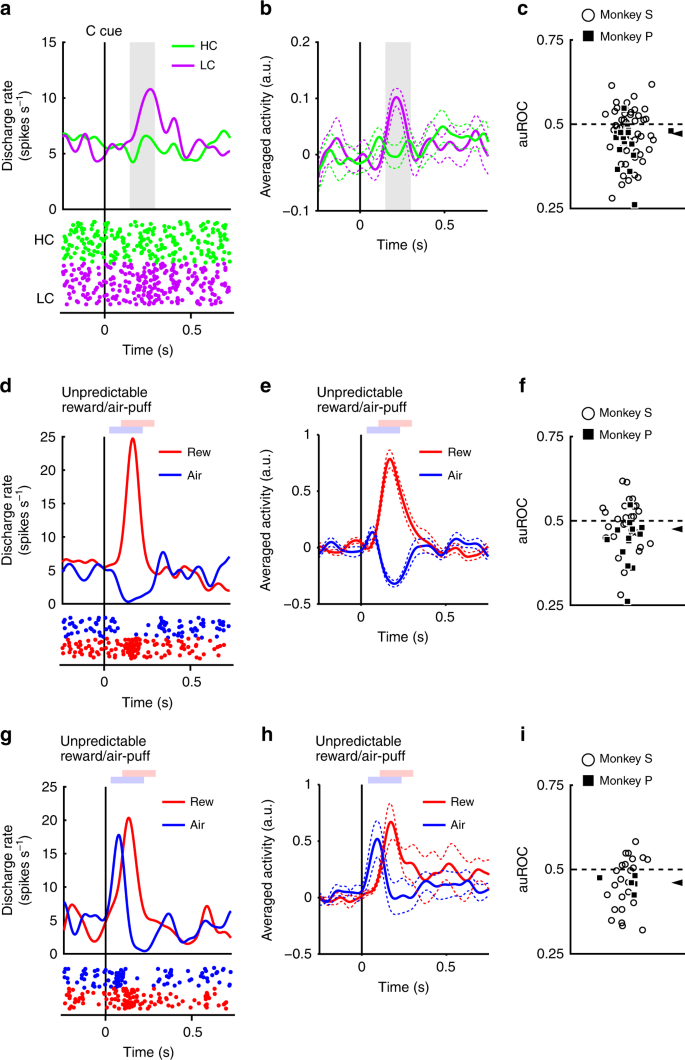

Les neurones ont répondu de manière phasique au signal de LC, mais de manière moins robuste au signal de HC (Fig. 3a, b). Les réponses évoquées aux signaux de condition de coût ont montré une réponse plus faible au signal de HC que le signal de LC (test bilatéral de Wilcoxon P <3.2 × 10-4, n = 70). Nous avons quantifié l'effet du coût prédit sur les réponses neuronales à l'aide d'une analyse des caractéristiques de fonctionnement du récepteur (ROC). La distribution de l'aire sous la courbe ROC (auROC) était significativement <0.5 (Fig. 3c; test bilatéral de Wilcoxon signé; P = 5.4 × 10-4, n = 70), indiquant que les réponses au signal HC étaient plus petites que celles au signal LC. Il a déjà été démontré que le coût prévu réduisait l'activité des neurones dopaminergiques, conformément à nos résultats22,23. De plus, la population de neurones dopaminergiques présentait une activation significative du signal de LC sans montrer de suppression significative du signal de HC (Fig. 4c, d). Ces résultats suggèrent que les neurones dopaminergiques codent et intègrent des informations sur la récompense et le coût au moment de la présentation du signal de coût.

Réponses neuronales dopaminergiques aux signaux de coût. a Une réponse neuronale dopaminergique représentative aux indices de coût. Les fonctions de densité de pointe ont été calculées à partir de l'activité normalisée d'un neurone dopaminergique enregistré à partir du singe P. Les lignes colorées indiquent les fonctions de densité de pointe et les points colorés indiquent le moment de la pointe. Les couleurs vertes et violettes indiquent une activité dans les essais à coût élevé et à faible coût, respectivement. La ligne verticale indique le moment de la présentation des indices de coût. La zone de couleur grise indique la période pour calculer la cadence de tir en réponse aux signaux de condition. b Activité en moyenne de la population des neurones dopaminergiques enregistrée du singe P aux signaux de condition. Les lignes continues Les lignes pointillées représentent la moyenne et la SEM, respectivement. c La répartition des zones sous les ROC permet de quantifier l’effet du coût prévu sur la réponse neuronale au signal de coût. Les carrés remplis et les cercles ouverts indiquent les données des singes P et S, respectivement. La pointe de la flèche indique la médiane de la auROC (0.47). d, g Réponses représentatives du type de neurone dopaminergique de type motivationnel (d) ou neurone dopaminergique de type saillance (g) à la récompense imprévisible ou souffle d'air. Les courbes rouges et bleues indiquent la réponse à une récompense imprévisible et à une bouffée d’air imprévisible, respectivement. La ligne verticale indique le moment de la récompense imprévisible ou de la livraison d'une bouffée d'air. Les carrés rouge et bleu pâles indiquent la période au cours de laquelle le taux de mise à feu est calculé en réponse à une récompense imprévisible ou à une bouffée d'air. e, h Activité en moyenne dans la population des neurones dopaminergiques du type valeur de motivation (e) ou de neurones dopaminergiques de type saillance (h) à la récompense imprévisible ou souffle d'air. f, i La distribution des AUROC calculée à partir des neurones dopaminergiques de type valeur motivationnelle (f) ou de neurones dopaminergiques de type saillance (i). Les pointes de flèche indiquent les médianes des auROC (f 0.48; i 0.46)

Deux sous-types distincts de neurones dopaminergiques ont déjà été décrits: la valeur motivationnelle et les neurones saillants.28,29. Nous avons trouvé des preuves dans notre population de neurones dopaminergiques de profils de réponse compatibles avec les deux sous-types. Les neurones de type valeur ont montré une suppression phasique des stimuli aversifs de la bouffée d’air (Fig. 3d, e). Inversement, les neurones de saillance ont montré une activation phasique des stimuli aversifs (Fig. 3g, h). La longue fixation dans l’essai HC est également désagréable et aversive; par conséquent, il est possible que les deux sous-types de neurones dopaminergiques présentent des profils de réponse différents aux signaux de condition de coût. Si les neurones dopaminergiques représentent des stimuli et des coûts aversifs de la même manière, les neurones de valeur devraient montrer une activité réduite du signal HC en raison de son caractère agressif. D'autre part, l'activité des neurones saillants devrait augmenter au signal de HC car ils augmentent également à des stimuli désagréables. Cependant, les réponses évoquées des deux types de neurones étaient plus petites pour le signal de HC que pour le signal de LC (test du test de rang signé de Wilcoxon à deux queues; P = 0.021, n = 41 et P = 0.0044, n = 29 pour la valeur et les types saillance, respectivement), et l'analyse ROC a montré des réponses plus faibles au HC par rapport au signal LC dans les deux sous-types (Fig. 3f, i; test bilatéral de Wilcoxon signé; P = 0.030, n = 41 et P = 0.0058, n = 29 pour la valeur et les types saillance, respectivement). Ainsi, le coût prédit réduit l'activité dans les deux sous-types de neurones dopaminergiques. Ces résultats indiquent que les informations sur les coûts sont traitées par les neurones dopaminergiques d'une manière qualitativement différente des stimuli aversifs.

Dans la tâche de saccade HLC, nous avons inséré un avortement forcé dans une partie des essais LC pour égaliser les taux de réussite et la probabilité de récompense entre les types d'essai. Cette manipulation a augmenté l'incertitude d'obtention d'une récompense ou le risque de non-récompense dans la condition LC. Par conséquent, l'activité plus élevée des neurones dopaminergiques et la valorisation accrue des singes pour la LC par rapport au signal HC pourraient être dues à la différence de risque ou d'incertitude entre les conditions de coût. Cependant, nous n'avons trouvé aucune relation entre le nombre d'abandons forcés et la différence des RT (Fig. 5a, b), et nous avons trouvé une corrélation positive entre le nombre d’avortements forcés et le auROC (Fig. 5c). Nous avons également comparé les réponses dopaminergiques aux signaux de coût après un avortement et après des essais corrects, mais nous n'avons trouvé aucune différence entre les deux conditions de coût (Fig. Supplémentaire). 5d). Ces résultats indiquent que le nombre d’avortements forcés dans la condition de LC n’explique ni l’augmentation de la valeur ni l’activation dopaminergique accrue du signal de LC.

Augmentation des réponses dopaminergiques pour récompenser les coûts de revient

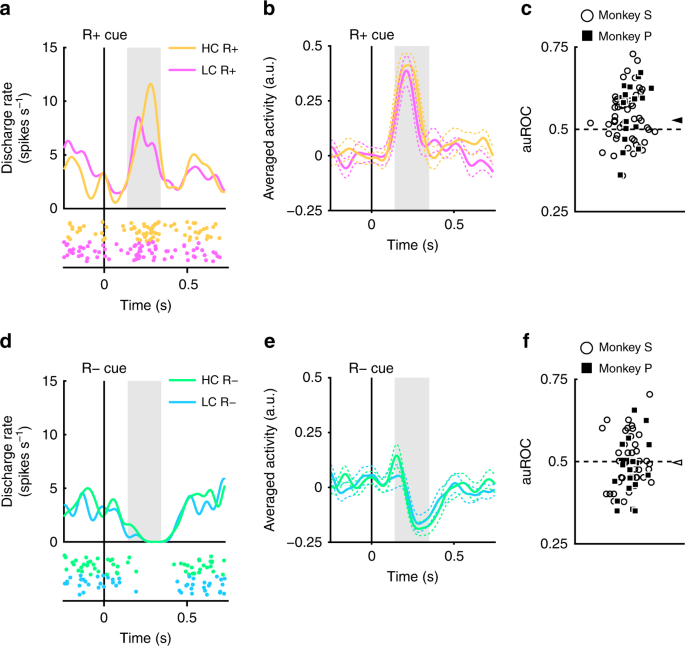

Les neurones dopaminergiques enregistrés présentaient une activation et une suppression phasiques pour récompenser et aucun indice prédictif de récompense, respectivement (Fig. 2). Nous avons ensuite évalué si ces réponses étaient modulées par le coût précédemment engagé. Un exemple de neurone représentatif et de neurones à population moyenne présentant une activation plus importante du RHC+ queue que le RLC+ cue sont représentés sur la figure 4a et b, respectivement. (test de rang signé de Wilcoxon bilatéral; P = 7.4 × 10-5, n = 70). La distribution des auROC était> 0.5, indiquant que la réponse au RHC+ cue était plus grande que pour le RLC+ queue (Fig. 4c; test bilatéral de Wilcoxon signé; P = 1.4 × 10-4, n = 70). Ces résultats indiquent que la réponse au signal de prédiction de récompense dans la condition HC est significativement plus grande que dans la condition LC. Par conséquent, nos résultats suggèrent que le signal positif-RPE représenté par les neurones dopaminergiques est augmenté du coût précédemment engagé.

Réponses neuronales dopaminergiques pour récompenser les signaux. a Un exemple de réponse neuronale aux signaux R +. Les fonctions de densité de pointes ont été calculées à partir de l'activité du neurone dopaminergique enregistré chez le singe P. Les lignes et les points colorés indiquent la densité des pointes et leur synchronisation, respectivement. Les couleurs jaune et rose indiquent une activité dans les essais à coût élevé et à faible coût, respectivement. La ligne verticale indique la synchronisation de la présentation R + cue. La zone grisée indique la période au cours de laquelle le taux de déclenchement est calculé comme réponse aux signaux de récompense. b Activité moyenne en population des neurones dopaminergiques enregistrés du singe P aux signaux R +. Les lignes pleines et les lignes pointillées représentent respectivement la moyenne et la SEM. c La distribution des auROC pour quantifier l’effet du coût payé sur la réponse neuronale aux signaux R +. Les carrés remplis et les cercles ouverts indiquent les données des singes P et S, respectivement. La flèche indique la médiane des auROC (0.53). d Une réponse représentative aux R. cues. Les couleurs vert et cyan indiquent des essais à coût élevé et à faible coût, respectivement. La ligne verticale indique la synchronisation de la présentation R− cue. e Activité en moyenne de la population des neurones dopaminergiques enregistrée du singe P aux signaux R−. f La distribution des auROC pour quantifier l’effet du coût payé sur la réponse neuronale aux signaux R−. La flèche indique la médiane de la auROC (0.50)

Les neurones dopaminergiques ont également montré une suppression phasique des signaux R− (Fig. 4d, e). Cependant, les réponses des neurones dopaminergiques aux signaux R− ne montrent pas de différence significative en fonction du coût encouru (test de Wilcoxon à deux queues signé); P = 0.25, n = 70), et l'analyse ROC n'a révélé aucune preuve d'un biais dans la distribution des réponses (Fig. 4f; Test de rang signé de Wilcoxon, P = 0.35; n = 70). Ainsi, le coût payé n'était pas reflété dans le signal de RPE négatif suscité par les signaux de non-prédiction de récompense. Cela peut être dû à un effet plancher: l'activité spontanée du neurone dopaminergique est faible (environ 5 Hz); et par conséquent, il se peut qu'il n'y ait pas une plage dynamique suffisante pour coder de manière adéquate une telle différence de coût dépensé pour la réponse RPE négative (Fig. 4d, e).

Nous avons également examiné l 'effet du coût payé sur les signaux de récompense pour les neurones à dopamine de type valeur et saillance séparément, mais les deux types de neurones à dopamine ont présenté un modèle de réponse similaire (Fig. Supplémentaire). 6a – h). Par conséquent, le coût payé engendre un effet similaire sur la réponse aux signaux de récompense dans les neurones à dopamine de type valeur et saillance.

Les durées de fixation réelles des singes n'étaient pas constantes, mais variaient essai par essai (Fig. 1b). Par conséquent, il était possible que les réponses de la dopamine aux signaux de récompense soient modulées par les durées de fixation réelles, essai par essai. Cependant, nous n’avons trouvé aucune corrélation significative entre elles pour chaque condition de coût et de récompense (Fig. Supplémentaire. 7un d). De plus, les RT du signal de récompense étaient également modulés par les conditions de coût et de récompense (Fig. 1f). Une possibilité est que les réponses des neurones dopaminergiques pourraient être expliquées par les RT aux signaux de récompense, essai par essai. Cependant, nous n’avons trouvé aucune corrélation significative entre les RT et les réponses normalisées de la dopamine aux signaux de récompense (Fig. Supplémentaire). 7e – h). Ces résultats suggèrent que les réponses dopaminergiques sont indépendantes des RT et des durées de fixation de chaque essai, mais qu'elles sont modulées en fonction du montant du coût requis et de la récompense attendue, qui sont fixés pour chaque type d'essais.

En outre, il est également possible que les avortements forcés dans la condition LC génèrent à la fois les préférences des singes et l'activation accrue des neurones dopaminergiques à l'aide de l'indicateur de récompense dans la condition HC. Si c'est le cas, le nombre d'abandons forcés doit être lié à la fois aux préférences et au degré d'activation renforcée. Cependant, le nombre d’avortements forcés n’a eu d’effet ni sur la préférence des singes ni sur l’activation des neurones dopaminergiques aux signaux de récompense (Fig. Supplémentaire). 8). Par conséquent, les RT plus rapides et les réponses DA supérieures au RHC+ queue que le RLC+ cue ne sont pas dus aux avortements forcés insérés dans la condition LC.

Les coûts engagés augmentent les réponses de la dopamine pour récompenser la délivrance

La réponse des neurones dopaminergiques aux signaux R + devrait provenir de la réponse à la récompense elle-même, car les neurones dopaminergiques modifient leur réponse aux signaux prédictifs de la récompense par rapport à l'association stimulus-récompense.8,30. Par conséquent, nous nous attendions à ce que les neurones dopaminergiques montrent une amélioration de la réponse payée, liée au coût, pour récompenser la délivrance. Pour mesurer l’activité des neurones dopaminergiques jusqu’à la distribution de la récompense, les singes ont exécuté la tâche incertaine de la CLH avec deux nouveaux signaux de récompense (Fig. 5a). Étant donné que les récompenses ont été distribuées dans seulement la moitié des présentations de message de récompense, les signaux de récompense ne prédisaient pas de manière fiable ni différemment la distribution des récompenses. Ceci a été fait pour maximiser la réactivité des neurones dopaminergiques à la réception d'une récompense (imprévue), afin d'augmenter notre sensibilité pour détecter une modulation de la réactivité des neurones en fonction du coût dépensé.

HLC tâche incertaine. a La tâche incertaine HLC. Dans cette tâche, des indices de récompense incertains, dans lesquels des récompenses ont été fournies 50% du temps, quel que soit le repère présenté, ont été utilisés. b RT aux signaux de coût dans les essais à coût élevé et à faible coût. Seul le singe P a montré une RT plus rapide pour la réplique LC que la réplique HC (**P <0.01; jumelé à deux queues t tester; t4 = 9.0, P = 8.5 × 10-4, n = 5 pour le singe P; t18 = 1.4, P = 0.19, n = 19 pour le singe S). Les cercles noirs et les barres d'erreur indiquent la moyenne et le SEM. c RT aux signaux de récompense dans les essais à coût élevé et à faible coût. Il n’existait aucune différence entre les RT et les indices de récompense entre les conditions coûteuses et faibles (conditions de paire à deux queues). t tester; t4 = 0.97, P = 0.39, n = 5 pour le singe P; t18 = 0.99, P = 0.39, n = 19 pour le singe S)

Lorsque les RT ont été comparés entre les indices de coût, le singe P a montré une RT plus rapide pour le repère LC que le repère HC (Fig. 5b). Il n’y avait aucune différence entre les RT et les signaux de récompense entre les conditions HC et LC chez les deux singes (Fig. 5c).

Dans la tâche incertaine de la CLH, les neurones dopaminergiques ont montré une activation modeste au signal de LC mais ne répondaient pas aux signaux de récompense car ils n'étaient pas prédictifs de la récompense (Fig. 6a). Dans l’ensemble de la population, les réponses évoquées étaient plus petites pour le HC que le signal de LC (Fig. 6b; test bilatéral de Wilcoxon signé; P = 2.7 × 10-3, n = 19), et les analyses ROC ont montré des réponses plus faibles au signal HC (Fig. 6c; test bilatéral de Wilcoxon signé; P = 5.5 × 10-3, n = 19). La réponse neuronale pour récompenser la délivrance dans la condition HC était plus grande que la LC (Fig. 6d; test bilatéral de Wilcoxon signé; P = 0.036, n = 19). La distribution des auROC était> 0.5, indiquant une réponse de livraison de récompense plus élevée dans le HC par rapport aux essais LC (Fig. 6e; test bilatéral de Wilcoxon signé; P = 0.049, n = 19). Ces résultats indiquent que la réponse de livraison de récompense est améliorée dans l'essai HC et que le coût payé augmente le signal de RPE positif à la livraison de récompense.

Réponse neuronale dopaminergique à la délivrance de la récompense. a Représentant l'activité des neurones dopaminergiques dans la tâche incertaine HLC. Chaque couleur représente les conditions (jaune: HC +, vert: HC−, rose: LC +, cyan: LC−). Les moments du début de la saccade sont indiqués par des croix grises. Les réponses de ce neurone dopaminergique à la récompense imprévisible et au souffle d'air sont également représentées dans le panneau de droite (rouge: récompense imprévisible, bleu: souffle d'air imprévisible). b Activité moyenne de population des neurones dopaminergiques enregistrés du singe S aux indices de condition. Les couleurs vertes et violettes indiquent une activité dans les essais à coût élevé et à faible coût, respectivement. Les lignes pleines et les lignes pointillées représentent respectivement la moyenne et la SEM. La zone de couleur grise indique la fenêtre de temps pour calculer la cadence de déclenchement en réponse aux signaux de condition. c La distribution des auROC pour quantifier l’effet du coût prévu sur la réponse neuronale aux signaux de coût. Les carrés remplis indiquent les données du singe P (n = 3) et les cercles vides indiquent les données du singe S (n = 16). La pointe de flèche indique la médiane de la auROC (0.44). d Activité en moyenne de la population des neurones dopaminergiques enregistrée du singe S à la délivrance de récompense. Les couleurs jaune et rose indiquent une activité dans les essais à coût élevé et à faible coût, respectivement. La zone de couleur grise indique la fenêtre de temps pour calculer le taux de déclenchement en réponse à la remise de la récompense. e La distribution des auRC pour quantifier l’effet du coût payé sur la réponse neuronale à la délivrance de récompense. La flèche indique la médiane de la auROC (0.55)

De plus, nous avons comparé les réponses dopaminergiques après l’absence de récompense. Les AURC ne montrent pas de distribution biaisée, ce qui indique que le coût payé n’a pas d’effet sur les EPR négatifs au moment du résultat (Fig. Supplémentaire). 9a). Les neurones dopaminergiques n’ont montré aucune différence entre les réponses au RHC Et RLC repères (Fig. supplémentaire) 9b).

Les coûts engagés améliorent la vitesse d'apprentissage

Étant donné que les RPE pour récompenser la prestation sont augmentés par le coût payé, sous l'hypothèse que les RPE sont directement impliqués dans la médiation de l'apprentissage stimulus-récompense, nous nous attendions à ce que les RPE améliorés se reflètent dans le comportement d'apprentissage via une vitesse d'apprentissage améliorée24. Pour tester l’effet du coût payé sur l’apprentissage, les singes ont effectué la tâche d’exploration HLC (Fig. 7a; voir Méthodes). Dans cette tâche, deux signaux de récompense (R + et R−) ont été présentés simultanément et les singes ont dû en choisir un. Nous avons égalisé les taux de réussite et les probabilités de récompense entre les types d’essais (test bilatéral couplé). t tester; t48 = 0.15, P = 0.89, n = 49 pour le singe P; t85 = 1.2, P = 0.25, n = 86 pour le singe S). Lorsque les RT ont été comparés pour les indices de coût, les deux singes ont montré des RT plus rapides au signal LC que le signal HC (Fig. 7b; jumelé à deux queues t tester; t48 = 12.9, P ≈ 0, n = 49 pour le singe P; t85 = 3.4, P = 9.4 × 10-4, n = 86 pour le singe S). En comparant les RT aux signaux de récompense, le singe S a montré des RT plus rapides dans la condition HC que LC (Fig. 7c; jumelé à deux queues t tester; t48 = 1.3, P = 0.19, n = 49 pour le singe P; t85 = 2.8, P = 6.8 × 10-3, n = 86 pour le singe S). Lors de la comparaison des RT au cours de la première et de la seconde moitié de la session d'apprentissage séparément, les RT au signal LC étaient plus rapides qu'au signal HC au cours de la première (Fig. 10) et la seconde moitié de la session (Fig. supplémentaire) 10c). Au contraire, les RT du singe S à la queue de récompense dans la condition HC étaient plus rapides que dans la condition LC pendant seulement la deuxième moitié de la session (Fig. Supplémentaire). 10d) mais pas la première moitié (Fig. supplémentaire) 10b).

Tâche d'exploration HLC. a La tâche d'exploration HLC. Dans cette tâche, les singes devaient choisir entre les indices R + et R−, générés de manière aléatoire au cours de chaque session d'apprentissage. S'ils choisissaient la R + cue, ils pourraient obtenir une récompense et s'ils choisissaient la R-cue, ils ne l'obtiendraient pas. b RT aux signaux de coût dans les essais à coût élevé et à faible coût. Les singes ont montré des RT plus rapides que la réplique à faible coût (**P < 0.01; jumelé à deux queues t tester). Les cercles noirs et les barres d'erreur indiquent les moyennes et les SEM. c RT aux signaux de récompense dans les essais à coût élevé et à faible coût. Monkey S a montré des RT plus rapides aux signaux de récompense dans un état de coût élevé

Dans la tâche d'exploration HLC, des indices de récompense ont été générés au hasard dans chaque session d'apprentissage. Par conséquent, les singes devaient apprendre la relation entre les signaux de récompense et les récompenses à chaque session. À mesure que les essais progressaient au cours d’une session, les singes choisissaient plus fréquemment les signaux R + dans chaque condition de coût (Fig. 8a). Pour quantifier la vitesse d'apprentissage, nous ajustons une fonction exponentielle cumulative aux données, en incorporant deux paramètres libres. a et b, indiquant l 'inclinaison de la courbe et du plateau, respectivement (Fig. supplémentaire. 11a, b). Le rapport de log entre les paramètres de raideur (log aHC/aLC) était significativement plus grand que zéro, indiquant un paramètre de raideur plus grand dans HC que dans les essais avec LC (Fig. 8b; à deux queues t tester; t48 = 2.1, P = 0.042, moyenne = 0.58, n = 49 pour le singe P; t85 = 2.5, P = 0.013, moyenne = 0.19, n = 86 pour le singe S). Le rapport logarithmique entre les paramètres du plateau (log bHC/bLC), n’était pas différent de zéro et n’indiquait aucune différence entre les conditions de coût (Fig. 8c; à deux queues t tester; t48 = 0.76, P = 0.45, moyenne = −0.0024, n = 49 pour le singe P; t85 = 0.56, P = 0.58, moyenne = 0.010, n = 86 pour le singe S). Ces résultats indiquent que la vitesse d'apprentissage est plus rapide dans les essais HC. Ensuite, nous avons modélisé des courbes d'apprentissage à l'aide d'un modèle d'apprentissage par renforcement (RL) (voir Méthodes). Ce modèle comprend des paramètres de taux d'apprentissage (αHC et αLC) et les taux d’exploration (βHC et βLC) pour les deux conditions de coût (Fig. supplémentaire 11c, d). Lors de l’adaptation au comportement, nous avons constaté que le rapport de log entre les paramètres de vitesse d’apprentissage (log αHC/αLC) était plus grand que zéro, indiquant un paramètre de vitesse d'apprentissage significativement plus grand sous HC que dans les essais avec LC (Fig. 8d; à deux queues t tester; t48 = 2.3, P = 0.026, moyenne = 0.50, n = 49 pour le singe P; t85 = 2.2, P = 0.034, moyenne = 0.25, n = 86 pour le singe S) tandis que le paramètre β n'a montré aucune différence (Fig. 8e; à deux queues t tester; t48 = 0.77, P = 0.44, moyenne = 0.0097, n = 49 pour le singe P; t85 = 0.64, P = 0.52, moyenne = 0.038, n = 86 pour le singe S). Ici, nous avons estimé les paramètres de taux d'apprentissage pour chaque condition de coût (αHC et αLC) séparément pour expliquer les vitesses d’apprentissage plus rapides en condition de HC. Toutefois, si les taux d’apprentissage sont identiques entre les conditions de coût, le rapport entre les paramètres de taux d’apprentissage estimés (αHC/αLC) peut être considéré comme une valeur d’amplification pour les RPE dans l’état HC. Par conséquent, ces résultats suggèrent qu’une amplification des RPE peut expliquer une vitesse d’apprentissage plus rapide en condition de HC.

Test de vitesse d'apprentissage. a Processus d'apprentissage moyen des singes P et S. La proportion de choix R + est tracée en fonction de l'essai. Les points verts et violets indiquent les données des essais à coût élevé et à faible coût, respectivement. Les lignes en pointillés représentent le processus d'apprentissage lissé. Les fonctions exponentielles cumulatives ont été ajustées aux points de données et représentées sous forme de lignes continues. b Le rapport de log entre les paramètres d'ajustement a dans les conditions de coût élevé et faible lorsque les données étaient ajustées avec une fonction cumulative exponentielle (*P <0.05; test de rang signé de Wilcoxon bilatéral). Les cercles noirs et les barres d'erreur indiquent la moyenne et le SEM. c Le rapport de log entre les paramètres d'ajustement b dans les conditions de coût élevé et faible lorsque les données étaient ajustées avec une fonction exponentielle cumulative. d Le rapport de log entre le paramètre de vitesse d'apprentissage α dans les conditions de coût élevé et faible lorsque les données étaient adaptées à un modèle d’apprentissage par renforcement. e Le rapport de log entre le paramètre d'ajustement β dans les conditions coûteuses et élevées lorsque les données ont été ajustées à un modèle d'apprentissage par renforcement

Nous avons également essayé d'expliquer le processus d'apprentissage avec des modèles RL alternatifs qui prennent en compte la possibilité que les singes connaissent l'anti-corrélation entre stimuli et récompense à chaque essai. Dans ces modèles, la valeur de l’option non choisie est mise à jour parallèlement à celle choisie (Fig. Supplémentaire). 12). Même en appliquant de tels modèles alternatifs aux données, le paramètre du taux d’apprentissage était significativement plus grand dans le HC comparé à la condition LC (Fig. Supplémentaire). 12b, f) pendant que le paramètre β n'a montré aucune différence (Fig. supplémentaire. 12d, h). Ainsi, notre découverte concernant une amplification du signal RPE dans la condition HC est robuste à la forme du modèle RL ajusté aux données.

a lieu

Nous avons étudié l'effet du coût payé sur la valeur des signaux prédictifs de récompense et sur les réponses phasiques des neurones à dopamine du cerveau moyen. Les singes ont montré une valorisation accrue des signaux prédictifs de récompense suite à l'exécution d'une action entraînant un coût plus élevé. Les neurones dopaminergiques ont montré une augmentation des réponses à la fois au signal prédictif de récompense et à la délivrance de récompense, après un coût plus élevé. En outre, les singes ont montré des vitesses d'apprentissage plus rapides lorsqu'un coût plus élevé était nécessaire pour obtenir une récompense.

Plusieurs études ont montré qu'un coût payé augmente les préférences pour un indice prédictif de récompense1,2,3. Dans la présente étude, les singes ont montré des RT plus rapides pour les signaux prédictifs de récompense dans la condition de HC comparés à ceux dans la condition de LC, ce qui correspond à la possibilité que la valeur de signal de récompense soit augmentée par le coût payé27. Une autre possibilité est que le temps de fixation plus long associé à une attention accrue à la cible saccade dans l'état de HC, réduise donc les TR après une fixation plus longue dans l'essai HC. Cependant, nous n'avons pas trouvé de différence entre les RT et les indices R dans les essais HC et LC dans la tâche incertaine HLC. En outre, dans la première moitié de la session d’exploration HLC. Les RT aux indices R n'étaient pas significativement différents entre les essais HC et LC. Ces résultats indiquent donc qu’une fixation plus longue n’est pas une explication probable des TR plus courtes observées aux signaux prédictifs de la récompense. En plus de l’effet des coûts payés sur les RT de récompense, le coût a également affecté les RT aux indices non prédictifs, malgré le fait qu’aucune récompense n’a été remise après les présentations de repères. Une étude antérieure avait signalé un phénomène similaire, dans la mesure où les sujets de singe présentaient des RT plus courtes dans des essais non récompensés, lorsque des récompenses plus préférées étaient utilisées dans les autres essais de chaque bloc.30. L’une des interprétations possibles de l’effet dans cette étude est qu’une plus grande motivation globale à réagir dans le bloc avec une récompense plus préférée affectait les TR aussi au signal de non-récompense dans le bloc. De même, dans la présente étude, l'attente d'une récompense plus précieuse dans les essais sur HC pourrait avoir modulé les RT sur le signal de non-récompense dans les essais sur HC dans notre tâche. En outre, l’effet du coût payé sur les RT sur les signaux de récompense était plus faible que celui sur les signaux sans prédiction de récompense. Ceci est probablement un artéfact du fait que, parce que les singes ont fait une saccade plus rapidement au RLC+ cue en premier lieu, il y a une possibilité réduite de détecter un raccourcissement des RT à la RHC+ queue. Par conséquent, la différence de RT entre les indices R + serait faible en conséquence.

Les singes ont également effectué des essais de choix entre le RHC Et RLC indices dans la tâche HLC. Cependant, alors que le singe S a montré une préférence pour le RHC+ signal du RLC+ cue, le singe P n'a montré aucune telle préférence. Cette différence pourrait s'expliquer par une différence de contexte entre la saccade HLC et les essais de choix. Dans les essais avec choix, deux indices prédictifs de récompense ont été présentés au lieu d’un indice prédictif de récompense. De plus, les singes n’obtiennent aucune récompense après leur choix, même s’ils choisissent l’indicateur prédictif, ce qui signifie que le test de choix a été fait en extinction. La procédure d'extinction a été mise en place pour s'assurer que le choix du singe était dicté par les connaissances acquises lors des essais d'effort, au lieu d'être confondu avec un nouvel apprentissage des essais de choix. Cependant, cette procédure peut avoir pour effet secondaire que le singe puisse rapidement apprendre à reconnaître la procédure d'extinction dans le contexte du choix et qu'il n'y a aucune raison de choisir les stimuli préférés. Néanmoins, l'un des singes a en fait manifesté une préférence pour le signe de récompense dans la condition de HC.

Au moment de la présentation d'un signal qui prédit une obligation ultérieure de payer un coût, l'activité des neurones à dopamine était réduite, conformément aux études précédentes.22,23. Dans notre étude, nous n'avons pas observé de diminution globale du nombre de neurones dopaminergiques répondant à la fois aux indices de HC et de LC par rapport aux valeurs initiales. Cela suggère qu’un signal RPE négatif ne se produit pas à ce moment-là malgré le coût suivant. L'absence de RPE négatif reflète probablement l'intégration d'une prévision de la récompense future attendue plus tard dans le procès. Les neurones dopaminergiques ont montré une activation significative dans l’essai LC et l’activité était supérieure à celle de l’essai HC. Ceci suggère que les informations de coût sont incorporées dans le signal RPE acheminé par les neurones dopaminergiques. Ainsi, les neurones dopaminergiques codent à la fois les informations de récompense et de coût et la réponse de l'EPR reflète la somme du coût et de la récompense.

Nous avons démontré que le signal RPE représenté par les neurones dopaminergiques est renforcé par le coût payé au moment de la présentation des signaux de récompense (dans la tâche HLC saccade) et par la remise de la récompense (dans la tâche incertaine HLC). Le montant objectif de la récompense offerte dans les essais de HC et de LC était égal; par conséquent, la modification des signaux RPE devrait être provoquée par un processus non sensoriel. Cette possibilité est étayée par plusieurs études indiquant un effet contextuel sur les signaux EPR de la dopamine, compatibles avec le traitement de la valeur subjective et / ou de l'utilité des neurones dopaminergiques.11,19,20,21,31,32,33,34. Si le signal RPE est plus grand, cela devrait produire une mise à jour plus rapide de la valeur de repère, ce qui aurait par conséquent un impact sur la vitesse d'apprentissage des associations stimulus-récompense. Des études antérieures ont montré une modification de la vitesse d'apprentissage par des facteurs non sensoriels24,35. Parallèlement à cela, les singes ont montré des vitesses d'apprentissage plus rapides dans le HC par rapport à la condition de LC. Nous avons constaté que l'amélioration de la vitesse d'apprentissage par le coût payé peut être expliquée par un modèle RL avec un RPE amplifié. Il était difficile de séparer les effets de l'EPR amplifié et du taux d'apprentissage accru dans nos expériences; Cependant, nous avons trouvé un signal RPE dopaminergique amplifié dans l'état HC. En outre, une étude IRMf antérieure a montré que le paramètre de vitesse d'apprentissage est représenté dans le cortex antérieur du cingulum et que l'activité de la VTA n'est pas liée au paramètre de vitesse d'apprentissage dans des environnements volatils.36. Par conséquent, nous affirmons que le signal RPE codé par les neurones dopaminergiques est amplifié par le coût payé et que le signal RPE accru améliore la vitesse d'apprentissage.

Lorsque le signal RPE a été généré au moment de la présentation de la récompense et de la distribution de la récompense, les singes avaient déjà payé le coût. Par conséquent, un mécanisme possible pour le signal RPE amélioré est qu'une récompense obtenue après un transfert de contrôle pourrait être plus gratifiante. Une attente accrue d'une récompense plus précieuse après la HC pourrait renforcer la motivation pour terminer l'essai, raccourcissant ainsi la RT aux indications de récompense dans les essais de HC.

Une autre interprétation possible de nos résultats est que le soulagement apporté par la suppression de l'action coûteuse peut servir de récompense aux singes. Des études d'imagerie par résonance magnétique fonctionnelle (IRMf) ont montré que le soulagement de la douleur pouvait être une récompense pour les participants humains.37,38; par conséquent, le coût pourrait jouer un rôle similaire en tant que stimulant aversif à la douleur. Si le soulagement des coûts est gratifiant et si cela se traduit par une activité dopaminergique, nous nous attendrions à ce que les neurones dopaminergiques répondent à la fin de la fixation longue, ce qui correspond au moment de la présentation du signal de récompense. Cependant, nous n'avons pas observé de différence d'activité dopaminergique au moment de la présentation des signaux de récompense ni de différence entre les TR et les indices R entre les essais HC et LC dans la tâche incertaine HLC. Par conséquent, nous suggérons que le soulagement des coûts ne fournit pas une explication adéquate de l’effet que nous avons observé dans les neurones dopaminergiques.

De plus, les neurones dopaminergiques présentaient des réponses qualitativement différentes au stimulus aversif par rapport au signal prédictif des coûts. Une explication possible à cela est que le coût de l’effort était moins important que le souffle aérien ou la récompense, parce que le coût de l’effort était temporairement étendu sur plusieurs secondes, les singes effectuant la fixation et non la ponctuation. Par conséquent, les neurones dopaminergiques peuvent ne pas avoir été activés aux signaux de coût moins saillants. Une autre possibilité est que les neurones dopaminergiques de type saillant répondent aux événements après lesquels certains mouvements ont été induits. Lorsque la récompense ou le souffle d'air est remis aux singes, ils effectuent certains mouvements tels que le léchage ou le clignotement des yeux. Cependant, dans la tâche de saccade HLC, les singes devaient garder leur regard sur la cible de fixation sans aucun mouvement, au moindre coût. En fait, une étude récente a montré que la libération de dopamine dans le noyau accumbens après un signal prédictif de récompense est atténuée à moins que le mouvement ne soit correctement initié.39. Le coût de nos expériences n’impliquant pas l’initiation du mouvement, il pourrait en résulter une réponse incohérente des neurones dopaminergiques de type saillant. Dans les deux cas, nous pouvons conclure que les informations sur les coûts sont traitées différemment des informations négatives.

En conclusion, nous suggérons que le coût payé augmente la valeur des signaux prédictifs de récompense, ce qui augmente à son tour le signal RPE codé dans les neurones à dopamine du cerveau moyen. Cet effet a conduit à une prédiction comportementale selon laquelle le taux d'apprentissage d'un animal serait amélioré pour les signaux prédictifs de récompense suite à l'expérience d'un HC. C'est bien ce que nous avons observé. Ainsi, nos observations sur l'activité des neurones dopaminergiques nous ont amenés à émettre l'hypothèse de l'existence d'un effet comportemental, ainsi que d'un mécanisme de calcul présumé sous-tendant cet effet, que nous avons ensuite confirmé. Nos résultats représentent donc un exemple de la façon dont la triangulation peut se produire entre les mesures de données neuronales, la théorie informatique et le comportement: approfondir la compréhension du traitement neuronal dans le cerveau peut fournir des informations sur le comportement et ses fondements informatiques sous-jacents.

Méthodologie

Animaux

Nous avons utilisé deux singes japonais mâles (Macaca fuscata; poids corporel, 6.5 kg = Singe P; poids corporel, 9.0 kg = Singe S). Nous avons implanté un poteau sur le crâne du singe afin qu'il puisse être fixé à une chaise ultérieurement. Une chambre d'enregistrement a également été implantée pour permettre le montage d'un micromanipulateur à électrodes. La chambre d'enregistrement était inclinée 45 ° latéralement dans le plan coronal et positionnée aux coordonnées stéréotaxiques: 15 mm en avant du canal externe. Après une période de récupération, les singes ont été formés pour effectuer la tâche de saccade. À la fin de la formation, nous avons percé un trou dans le crâne à l'intérieur de la chambre d'enregistrement pour l'insertion des électrodes. Tous les protocoles relatifs aux soins des animaux ont été approuvés par le Comité d’expérimentation animale de l’Université de Tamagawa et conformes au Guide pour le soin et l’utilisation des animaux de laboratoire des National Institutes of Health.

Tâche comportementale

Les singes ont été entraînés à exécuter la tâche de saccade HLC (Fig. 1a), Tâche incertaine HLC (Fig. 5a) et la tâche d’exploration HLC (Fig. 7a). Toutes les tâches ont été effectuées dans une pièce sombre. Les singes étaient assis sur une chaise devant un 22 pouces. Moniteur LCD (S2232W, Eizo) avec leurs montants de tête implantés fixés au fauteuil. La distance entre leurs yeux et l'écran était de 70 cm. Lorsqu'un signal de départ (cercle blanc, diamètre de 0.3 °) était présenté au centre de l'affichage, le singe devait maintenir son regard sur le signal. Le signal de départ a disparu au bout de 750 ms, puis un indice de coût a été présenté (étoile et moulin à vent pour les essais HC et LC, respectivement). Les singes ont été tenus de saccader au signal de coût pendant les 750 ms de présentation du signal. S'ils ne saccadèrent pas au signal, le procès fut interrompu et le même procès recommencé. Au cours des essais HC, la cible de fixation (carré blanc 0.3 ° × 0.3 °) a été présentée juste après la disparition de l'indicateur de coût pour 2000 ms (saccade HLC et tâches incertaines HLC) ou 1500 ms (tâche d'exploration HLC) et les singes étaient nécessaires pour y saccader et y garder les regards. Si les singes déplaçaient leur regard au-delà d'une fenêtre de fixation de 4 ° × 4 °, la tâche était abandonnée. La fenêtre de fixation a été activée 400 ms après la présentation du point de fixation car les singes avaient besoin de temps pour se préparer à la saccade et pour ajuster leur fixation. Par conséquent, les singes devaient se fixer pendant au moins 1600 ms (saccade HLC et tâches incertaines HLC) ou 1100 ms (tâche d'exploration HLC) dans les essais HC. Dans les essais LC, un écran blanc a été affiché pendant 1500 ms (saccade HLC et tâches incertaines HLC) ou 1000 ms (tâche d'exploration HLC), puis la cible de fixation est apparue pendant 500 ms. Parce que la fenêtre de fixation a été activée 400 ms après la présentation du point de fixation, les singes devaient se fixer sur la cible pendant au moins 100 ms dans les essais LC. Les singes ont présenté plus d'erreurs dans l'essai HC; par conséquent, un abandon forcé a été inséré au hasard 100 ms avant la présentation du signal de récompense (400 ms après la présentation de la cible de fixation qui est le moment de l'apparition de la fenêtre de fixation) dans l'essai LC pour égaliser le taux de réussite. Après avoir fixé la cible, un ou deux signaux de récompense ont été présentés et les singes ont dû saccader au signal. S'ils réussissaient à faire une saccade au signal de récompense, un bip sonore était émis 750 ms après la présentation du signal de récompense. Lorsque les singes ont fait une saccade au signal R +, 0.3 ml d'eau a été délivré en même temps que le bip. Aucune récompense n'a été délivrée quand ils ont fait une saccade au signal R−.

Dans la tâche HLC Saccade, quatre cercles de couleur ont été utilisés comme signaux de récompense (RHC+: jaune; RHC-: vert; RLC+: rose; RLC-: bleu; Figue. 1a). Une session expérimentale a consisté en 80 essais de saccades, 20 essais de récompenses imprévisibles, 20 essais de bouffées d'air imprévisibles et 5 essais de choix. Les essais de saccade comprenaient 40 essais HC et 40 essais LC, qui comprenaient tous deux 20 essais avec récompense et 20 essais sans récompense. Dans les essais de récompense imprévisible ou de bouffée d'air, 0.3 ml de récompense d'eau ou 0.2 MPa de bouffée d'air (150 ms pour le singe P; 200 ms pour le singe S) a été administré au visage des singes sans être repéré. Les essais de choix comprenaient un essai dans lequel des singes ont fait un choix entre les indices R + (RHC+ vs. RLC+) dans l'essai HC, entre les repères R (RHC- contre RLC-) dans l’essai HC, entre R + (RHC+ vs. RLC+) indices dans le procès LC, entre R− (RHC- contre RLC-) repères dans l 'essai LC, et entre les repères de coût (Fig. Supplémentaire. 1) Dans les essais avec un choix entre les signaux de récompense, la structure de la tâche était identique à celle de la tâche saccade avant la présentation du repère de récompense. Ensuite, au lieu de présenter un signal de récompense, deux signaux de récompense ont été présentés dans les épreuves de choix et aucune récompense n’a été remise après la présentation du message de récompense, même si les singes ont fait le choix entre les signaux R +.

Pour tester la réponse des neurones dopaminergiques à la délivrance, les singes ont effectué la tâche incertaine HLC (Fig. 5a) Cette tâche était similaire à celle de la saccade HLC, à l’exception des indices de récompense. Dans cette tâche, nous avons utilisé deux signaux de récompense (au lieu des quatre utilisés dans la tâche HLC Saccade), l'un pour l'essai HC et l'autre pour l'essai LC. La récompense a été livrée dans la moitié des essais après la présentation de la récompense. Une session expérimentale comprenait des essais sur les saccades 80, des essais sur les récompenses imprévisibles 20 et des essais sur des souffles aériens imprévisibles 20. Les essais saccades comprenaient des essais 40 HC et 40 LC, qui comprenaient tous deux des essais de récompense 20 et des essais de récompense 20 no. Dans les épreuves imprévisibles, une récompense ou une bouffée d’air a été livrée sans le moindre indice.

Dans la tâche d’exploration HLC, deux signaux de récompense (RHC+, RHC- ou RLC+, RLC-) ont été présentés simultanément et les singes ont été obligés de saccade à un des signaux de récompense (Fig. 7a) S'ils choisissaient le cue R +, ils recevaient une récompense en eau. Quatre signaux de récompense (RHC +, RHC-, RLC +, RLC-) ont été générés pour chaque session d’exploration et les singes ont dû apprendre à associer les indices et les récompenses essai par essai. Une session expérimentale comprenait des essais sur 100 HC et des essais sur 100 LC. Nous avons constaté que pour la tâche d'exploration, si nous fixions la durée de fixation à 2000 ms dans la condition HC afin qu'elle corresponde à la durée de la condition HC dans les autres tâches, les singes effectuaient la tâche avec un très faible taux de réussite, peut-être à cause la difficulté de la tâche et / ou le faible taux de récompense qui en résulte. Par conséquent, pour réduire les difficultés de la tâche et augmenter le taux de réussite, nous avons utilisé une durée de fixation en 1500 ms comme coût de la tâche d’exploration HLC.

Les tâches ont été contrôlées à l'aide d'un progiciel disponible dans le commerce (TEMPO, Reflective Computing, St. Louis, MO, USA). Un programme personnalisé utilisant une interface de programmation d'application (OpenGL) a été utilisé pour la présentation visuelle du stimulus. Les stimuli visuels pour le coût et les indices de récompense ont été créés par les auteurs.

Enregistrement et acquisition de données

L'emplacement de la substance noire a été estimé à l'aide d'images IRM. Une électrode en tungstène revêtue d’époxy (diamètre de la tige, 0.25 mm, 0.5 – 1.5 MΩ mesurée à 1000 Hz, FHC) a été insérée dans la substance noire à l’aide d’un micromanipulateur (MO-972, Narishige, Tokyo, Japon) monté sur la chambre d’enregistrement avec un tube de guidage en acier inoxydable. Les signaux de tension ont été amplifiés (× 10,000) et filtrés (0.5 – 2 kHz). Les potentiels d'action d'un seul neurone ont été isolés avec un algorithme d'appariement de matrice (OmniPlex, Plexon, Dallas, TX, USA). Les mouvements oculaires ont été contrôlés par un système de caméra infrarouge à une fréquence d'échantillonnage de 500 Hz (Primate iView X Hi-Speed, SMI, Teltow, Allemagne). La synchronisation des potentiels d'action et des événements comportementaux a été enregistrée avec une résolution temporelle de 1 kHz.

L'analyse des données

Pour analyser le comportement des singes, les RT ont été déterminés comme étant l'intervalle de temps entre le début du stimulus et le moment où les singes ont initié la saccade. Le début de la saccade a été déterminé en calculant le moment où la position du regard dépassait les écarts-types 5 par rapport à la position moyenne du regard avant la présentation du signal.

Dans la tâche d'exploration HLC, le comportement de choix des singes a été quantifié en ajustant une fonction exponentielle cumulative. La fonction (P) décrit la proportion de choix correct comme suit:

De t signifie procès, a et b indiquer la pente et le plateau de la courbe, respectivement. Cette fonction a été ajustée indépendamment aux données pour les deux conditions de coût. Les paramètres de la fonction ont été recherchés afin de maximiser la probabilité d'observer les données d'une seule session et les données moyennées. Une méthode de bootstrap a été appliquée pour estimer les intervalles de confiance lors de l'ajustement aux données moyennées. Un modèle RL standard a également été utilisé pour quantifier les données comportementales. Les valeurs de stimulus Vj(t) pour le choix choisi j (j = 1 pour la condition HC; j = 2 pour la condition LC) ont été mis à jour comme suit:

De αj indiquer les taux d'apprentissage, qui ont été limités à des valeurs comprises entre 0 et 1. R(t) indique le montant de la récompense (1: récompensé, 0: pas de récompense) à l'essai t.

La probabilite Pj(t) de choisir un stimulus j sur les deux stimuli au procès t est donné par la règle softmax

De βj indique l'étendue de l'exploration.

Nous avons enregistré l'activité neuronale pendant la saccade HLC et la tâche incertaine HLC mais pas la tâche d'exploration HLC. La tâche d'exploration HLC a été mise en œuvre comme une étude purement comportementale. Les neurones dopaminergiques ont été identifiés s'ils présentaient chacune des propriétés suivantes: un faible taux de décharge tonique (<6 Hz), une longue durée de la forme d'onde de pointe (> 300 μs) et une réponse phasique à la récompense imprévisible (Fig. 2a) Nous avons analysé des essais dans lesquels les singes pouvaient mener à bien l'essai sans erreur (fixation au freinage, pas de saccade ou avortement artificiel). La cadence moyenne de décharge des neurones a été calculée avec les cellules 1 ms et lissée avec un noyau gaussien (σ = 30 ms, largeur = 4σ) pour produire des fonctions de densité de pointes. Les réponses des neurones dopaminergiques à chaque événement de tâche ont été calculées en tant que taux de déclenchement normalisé par rapport à l'activité spontanée (taux de déclenchement moyen au cours des 500 ms avant le début du signal de début). Les cadences de tir ont été calculées dans des fenêtres temporelles déterminées pour chaque événement de tâche et chaque sujet. Ces fenêtres temporelles ont été déterminées à partir de l'activité moyenne de la population. Nous avons défini les points de début et de fin des fenêtres de temps déterminées sur la base des temps de montée et de descente de la réponse en moyenne de la population, en utilisant comme référence des études antérieures sur la dopamine chez le singe (Fig. 3) La fenêtre temporelle pour le repère de départ a été définie comme 200 – 400 ms après le début du repère de démarrage pour les neurones enregistrés à partir des singes P et S. La fenêtre temporelle pour le repère de condition a été définie comme 150 – 300 ms après le déclenchement du repère de condition pour le singe P et 200 – 400 ms pour le singe S. La fenêtre temporelle de la récompense a été définie comme suit: 140 – 350 ms après le déclenchement de la réplique de récompense pour le singe P et 220 – 420 ms pour le singe S. La fenêtre temporelle de la remise de récompense a été définie comme 225– 475 ms après le bip du singe P et 200 – 450 ms pour le singe S. La fenêtre temporelle de la distribution imprévisible de récompenses a été définie sous la forme 100 – 300 ms après la remise de récompense pour le singe P et 150 – 300 ms pour le singe S. la fenêtre temporelle pour le souffle d'air imprévisible était définie par 30 – 230 ms après la livraison du souffle d'air pour le singe P et 50 – 200 ms pour le singe S.

Nous avons classé tous les neurones dopaminergiques enregistrés en deux catégories distinctes, la valeur motivationnelle et les types de saillance. Si la réponse d'un neurone aux stimuli de la bouffée d'air était inférieure à l'activité spontanée, le neurone était classé comme étant du type valeur motivationnelle (Fig. 3d, e) En revanche, si la réponse d’un neurone aux stimuli de la bouffée d’air était supérieure à celle de l’activité spontanée, le neurone était classé comme étant du type saillant (Fig. 3g, h).

Pour quantifier l'activité neuronale différentielle entre les conditions de la tâche, une analyse ROC a été effectuée. Nous avons calculé la auROC pour chaque neurone. L'auROC plus petit ou plus grand que 0.5 indique une réponse plus petite ou plus grande dans l'essai HC, respectivement. Parce que le nombre de neurones dans certains ensembles de données neuronales était petit, nous avons utilisé le test de rang signé de Wilcoxon pour réduire l'effet des valeurs aberrantes pour quantifier la distribution biaisée des auROC.

Un logiciel disponible dans le commerce, MATLAB (MathWorks, Natick, MA, USA), a été utilisé pour effectuer toutes les analyses de données.

Examen histologique

Après l'expérience d'enregistrement, les deux singes ont été euthanasiés et une analyse histologique a été réalisée pour vérifier la position d'enregistrement (Fig. 2b) Les singes ont été euthanasiés par l’administration d’une dose létale de pentobarbital sodique (70 mg kg-1) et perfusé avec 4% formaldéhyde dans un tampon phosphate. Des coupes coronales en série (épaisseur, 10, um) ont été coupées et immunocolorifiées avec un anticorps anti-tyrosine hydroxylase (TH) (chaque section 25; anticorps anti-TH, 1: 500; Merck, Darmstadt, Allemagne) ou une coloration de Nissl (toutes les sections 25). .

Résumé du rapport

De plus amples informations sur le design de la recherche sont disponibles dans Résumé de la recherche sur la nature lié à cet article.

Disponibilité des données

Les données utilisées dans l'analyse de cette étude sont disponibles auprès de l'auteur correspondant sur demande raisonnable. Un résumé de rapport pour cet article est disponible en tant que fichier d’informations supplémentaires. Les données source sous-jacentes des Figs. 1, 3-8 et figures supplémentaires. 1, 4-12 sont fournis sous forme de fichier de données source.

Disponibilité du code

Les codes Matlab utilisés dans l'analyse de cette étude sont disponibles auprès de l'auteur correspondant sur demande raisonnable.

Bibliographie

- 1.

Clement, TS, Feltus, JR, Kaiser, DH & Zentall, TR «L'éthique du travail» chez les pigeons: la valeur de la récompense est directement liée à l'effort ou au temps requis pour obtenir la récompense. Psychon. Taureau. Tour. 7, 100 – 106 (2000).

- 2.

Klein, ED, Bhatt, RS & Zentall, TR Contraste et la justification de l'effort. Psychon. Taureau. Tour. 12, 335 – 339 (2005).

- 3.

Zentall, TR & Singer, RA Contraste intra-essai: les pigeons préfèrent les renforçateurs conditionnés qui suivent un événement relativement plus plutôt que moins aversif. J. Exp. Anal. Comportement 88, 131 – 149 (2007).

- 4.

Aronson, E. & Mills, J. L'effet de la gravité de l'initiation sur le goût pour un groupe. J. anormal. Soc. Psychol. 59, 177 – 181 (1959).

- 5.

Festinger, L. Une théorie de la dissonance cognitive. (Stanford University Press, Californie, 1957).

- 6.

Alessandri, J., Darcheville, JC, Delevoye-Turrell, Y. & Zentall, TR Préférence pour les récompenses qui suivent un plus grand effort et un plus grand retard. Apprendre le comportement. 36, 352 – 358 (2008).

- 7.

Schultz, W., Carelli, RM & Wightman, RM Signaux dopaminergiques phasiques: de la valeur de récompense subjective à l'utilité économique formelle. Curr. Opin. Comportement Sci. 5, 147 – 154 (2015).

- 8.

Schultz, W., Dayan, P. & Montague, PR Un substrat neuronal de prédiction et de récompense. Sciences 275, 1593 – 1599 (1997).

- 9.

Bromberg-Martin, ES, Matsumoto, M. & Hikosaka, O. Dopamine dans le contrôle motivationnel: gratifiant, aversif et alerte. Neuron 68, 815 – 834 (2010).

- 10.

Bayer, HM & Glimcher, PW Les neurones dopaminergiques du cerveau moyen codent pour un signal d'erreur de prédiction de récompense quantitative. Neuron 47, 129 – 141 (2005).

- 11.

Nakahara, H., Itoh, H., Kawagoe, R., Takikawa, Y. & Hikosaka, O. Les neurones dopaminergiques peuvent représenter une erreur de prédiction dépendant du contexte. Neuron 41, 269 – 280 (2004).

- 12.

Tobler, PN, Fiorillo, CD & Schultz, W. Codage adaptatif de la valeur de récompense par les neurones dopaminergiques. Sciences 307, 1642 – 1645 (2005).

- 13.

Nomoto, K., Schultz, W., Watanabe, T. & Sakagami, M. Réponses dopaminergiques temporairement étendues à des stimuli prédictifs de récompense exigeants en termes de perception. J. Neurosci. 30, 10692 – 10702 (2010).

- 14.

Watabe-Uchida, M., Zhu, L., Ogawa, SK, Vamanrao, A. & Uchida, N. Cartographie du cerveau entier des entrées directes aux neurones dopaminergiques du mésencéphale. Neuron 74, 858 – 873 (2012).

- 15.

Tanaka, SC et al. La prévision des récompenses immédiates et futures recrute différemment les boucles des ganglions cortico-basaux. Nat. Neurosci. 7, 887 – 893 (2004).

- 16.

Haber, SN, Kim, KS, Mailly, P. & Calzavara, R. Les entrées corticales liées à la récompense définissent une grande région striatale chez les primates qui s'interface avec des connexions corticales associatives, fournissant un substrat pour un apprentissage incitatif. J. Neurosci. 26, 8368 – 8376 (2006).

- 17.

Doya, K. Modulateurs de la prise de décision. Nat. Neurosci. 11, 410 – 416 (2008).

- 18.

Roesch, MR, Calu, DJ & Schoenbaum, G. Les neurones dopaminergiques codent la meilleure option chez les rats décidant entre des récompenses différées ou de taille différente. Nat. Neurosci. 10, 1615 – 1624 (2007).

- 19.

Lak, A., Stauffer, WR & Schultz, W. Les réponses aux erreurs de prédiction de la dopamine intègrent la valeur subjective de différentes dimensions de récompense. Proc. Natl Acad. Sci. Etats-Unis 111, 2343 – 2348 (2014).

- 20.

Stauffer, WR, Lak, A. & Schultz, W. Les réponses d'erreur de prédiction de récompense de dopamine reflètent une utilité marginale. Curr. Biol. 24, 2491 – 2500 (2014).

- 21.

Noritake, A., Ninomiya, T. & Isoda, M. Suivi et évaluation de la récompense sociale dans le cerveau du macaque. Nat. Neurosci. 21, 1452 – 1462 (2018).

- 22.

Pasquereau, B. & Turner, RS Codage limité de l'effort par les neurones dopaminergiques dans une tâche de compromis coût-bénéfice. J. Neurosci. 33, 8288 – 8300 (2013).

- 23.

Varazzani, C., San-Galli, A., Gilardeau, S. & Bouret, S. Noradrénaline et neurones dopaminergiques dans le compromis récompense / effort: une comparaison électrophysiologique directe chez les singes qui se comportent. J. Neurosci. 20, 7866 – 7877 (2015).

- 24.

Watanabe, N., Sakagami, M. & Haruno, M. Le signal d'erreur de prédiction de récompense amélioré par l'interaction striatum-amygdale explique l'accélération de l'apprentissage de récompense probabiliste par l'émotion. J. Neurosci. 33, 4487 – 4493 (2013).

- 25.

Di Ciano, P., Cardinal, RN, Cowell, RA, Little, SJ & Everitt, B. Implication différentielle des récepteurs NMDA, AMPA / kainate et dopamine dans le noyau accumbens dans l'acquisition et la performance du comportement d'approche pavlovienne. J. Neurosci. 21, 9471 – 9477 (2001).

- 26.

Flagel, SB et al. Un rôle sélectif de la dopamine dans l’apprentissage stimulus-récompense. Nature 469, 53 – 57 (2011).

- 27.

Blough, DS Effets de l'amorçage, de la discriminabilité et du renforcement sur les composants du temps de réaction de la recherche visuelle sur le pigeon. J. Exp. Psychol. Anim. Comportement Processus. 26, 50 – 63 (2000).

- 28.

Matsumoto, M. & Hikosaka, O. Deux types de neurones dopaminergiques véhiculent distinctement des signaux de motivation positifs et négatifs. Nature 459, 837 – 841 (2009).

- 29.

Matsumoto, M. & Takada, M. Représentations distinctes des signaux cognitifs et motivationnels dans les neurones dopaminergiques du mésencéphale. Neuron 79, 1011 – 1024 (2013).

- 30.

Watanabe, M. et al. Réactions comportementales reflétant les attentes de récompense différentielles chez les singes. Exp. Brain Res. 140, 511 – 518 (2001).

- 31.

Takikawa, Y., Kawagoe, R. & Hikosaka, O. Un rôle possible des neurones dopaminergiques du mésencéphale dans l'adaptation à court et à long terme des saccades à la cartographie position-récompense. J. Neurophysiol. 92, 2520 – 2529 (2004).

- 32.

Kobayashi, S. & Schultz, W. Influence des retards de récompense sur les réponses des neurones dopaminergiques. J. Neurosci. 28, 7837 – 7846 (2008).

- 33.

Enomoto, K. et al. Les neurones dopaminergiques apprennent à coder la valeur à long terme de multiples récompenses futures. Proc. Natl Acad. Sci. Etats-Unis 108, 15462 – 15467 (2011).

- 34.

Lak, A., Nomoto, K., Keramati, M., Sakagami, M. & Kepecs, A. Les neurones dopaminergiques du cerveau moyen signalent la croyance en l'exactitude du choix lors d'une décision perceptive. Curr. Biol. 27, 821 – 832 (2017).

- 35.

Williams, BA & McDevitt, MA Inhibition et superconditionnement. Psychol. Sci. 13, 454 – 459 (2002).

- 36.

Behrens, TE, Woolrich, MW, Walton, ME & Rushworth, MF Apprendre la valeur de l'information dans un monde incertain. Nat. Neurosci. 10, 1214 – 1221 (2007).

- 37.

Seymour, B. et al. Les processus neuronaux aversifs appétits de l'adversaire sont à la base de l'apprentissage prédictif du soulagement de la douleur. Nat. Neurosci. 8, 1234 – 1240 (2005).

- 38.

Kim, H., Shimojo, S. & O'Doherty, JP Est-ce qu'éviter un résultat aversif est gratifiant? Substrats neuronaux d'apprentissage d'évitement dans le cerveau humain. PLoS Biol. 4, e233 (2006).

- 39.

Syed, EC et al. L'initiation de l'action façonne le codage de la dopamine mésolimbique des récompenses futures. Nat. Neurosci. 19, 34 – 36 (2016).

Remerciements

Ce travail a été financé par les subventions MEXT / JSPS pour la recherche scientifique (Kakenhi). Les numéros de subvention JP16H06571 et JP18H03662 to MS. ) et le programme de coopération sur la recherche sur le cerveau nippo-américain. Cette recherche a été financée par le projet national sur les bio-ressources de l'Institut national des sciences physiologiques (AMNR) de l'Agence japonaise pour la recherche et le développement en médecine (AMED). Nous remercions Bernard W. Balleine et Andrew R. Delamater pour leur aide dans la rédaction du document.