Nature Communications

volume 10, Artikel nummer: 3674 (2019)

Abstract

Het is bekend dat dopamine-neuronen in de middenhersenen coderen voor beloningsvoorspellingsfouten (RPE) die worden gebruikt om waardevoorspellingen bij te werken. Hier onderzoeken we of RPE-signalen die worden gecodeerd door dopamine-neuronen in de middenhersenen worden gemoduleerd door de kosten die worden betaald om beloningen te verkrijgen, door opname van dopamine-neuronen in wakker gedragen apen tijdens het uitvoeren van een inspannende saccade-taak. De neuronreacties van Dopamine op signalen die beloning voorspelden en op het leveren van beloningen waren verhoogd na het uitvoeren van een kostbare actie vergeleken met een minder dure actie, wat suggereert dat RPE's worden verbeterd na de uitvoering van een kostbare actie. Op gedragsniveau worden stimulus-beloningsassociaties sneller geleerd na het uitvoeren van een kostbare actie in vergelijking met een minder dure actie. Aldus wordt informatie over actiekosten verwerkt in het dopamine-beloningssysteem op een manier die het volgende dopamine RPE-signaal versterkt, wat op zijn beurt sneller leren bevordert in situaties van hoge kosten.

Introductie

Mensen en dieren geven de voorkeur aan een beloning die wordt ontvangen na veel inspanning om deze te verkrijgen in vergelijking met dezelfde beloning na een kleinere hoeveelheid inspanning1,2,3. Voor dit effect is een aantal verklaringen gegeven, zoals inspanningsverantwoording4,5 en het contrasteffect6, waarin meer waarde wordt toegekend aan een resultaat verkregen na betaalde inspanning. Het blijft echter onduidelijk of en hoe de verwerking van beloningsinformatie in de hersenen wordt gemoduleerd door de inspanning die wordt geleverd om een beloning te verkrijgen.

We hebben ons specifiek gericht op het dopamine-systeem in de middenhersenen, gezien de rol van dit systeem bij het bevorderen van gedragsaanpassing aan beloningen7,8,9. Van dopamine-neuronen is bekend dat ze beloningsvoorspellingsfouten (RPE) signalen vertegenwoordigen die het leren van beloningsvoorspellingen door de basale ganglia kunnen vergemakkelijken10,11,12,13,14,15,16,17. De sterkte van de RPE hangt af van de kwantiteit, kwaliteit en subjectieve waarde of het nut van de beloning7,18,19,20,21. Bovendien wordt dopaminerge activiteit gemoduleerd door kosten en / of inspanning22,23. Op basis hiervan stelden we dat het dopaminerge RPE-signaal direct zou worden gemoduleerd door de betaalde kosten om een beloning te verkrijgen. Omdat het RPE-signaal bovendien causaal betrokken is bij het bemiddelen bij het leren van stimulus-beloningsassociaties24,25,26, hebben we de hypothese dat de kosten die worden betaald om de beloning te verkrijgen, direct de leersnelheid van stimulus-beloningsverenigingen verhogen.

Om onze hypothesen te testen, hebben we zowel het gedrag als de dopaminerge activiteit gemeten bij twee Japanse apen, terwijl ze een op saccade gebaseerde inspanningstaak uitvoerden. Apen reageren sneller op een beloningsvoorspellende keu die wordt gepresenteerd na een actie met hoge kosten (HC) in vergelijking met die na een actie met lage kosten (LC). De activiteit van dopaminerge neuronen voor de beloningsvoorspellende signalen worden verhoogd met de betaalde kosten. Bovendien wordt de leersnelheid van de stimulus-beloningsvereniging ook verbeterd door de betaalde kosten. Daarom suggereren we dat de kosten die worden betaald om beloningen te verkrijgen het RPE-signaal in dopamine-neuronen verhogen en daarmee stimulus-beloningsassociaties verbeteren.

Resultaten

High-Low cost (HLC) saccadetaak

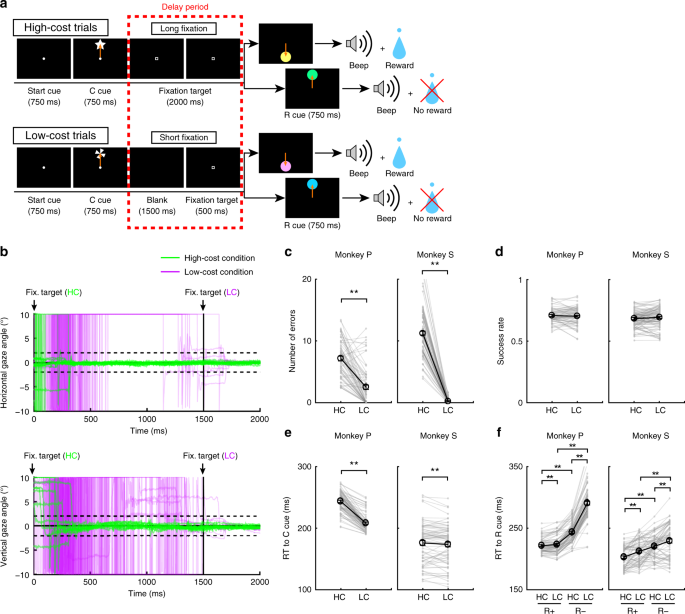

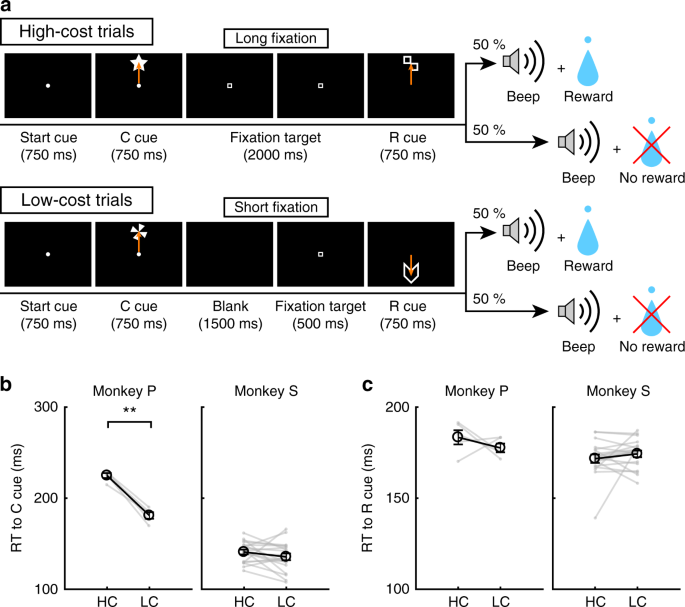

Om het effect van betaalde kosten op gedrag en op dopamine-neuronactiviteit te onderzoeken, voerden de apen een saccade-taak uit met twee kostencondities (Fig. 1a, zie Methoden). In HC-proeven maakten de apen snel een saccade naar het doel en hielden hun blik erop zonder te knipperen voor een langere periode (fig. 1b; groene lijnen). Bij LC-proeven daarentegen keken de apen eerst vrij rond voordat ze zich voor een kortere periode fixeerden (Fig. 1b, paarse lijnen). Omdat het handhaven van een lange fixatie moeilijk is voor apen, maakten ze meer fouten tijdens vertragingen bij HC-proeven (Fig. 1c). Om te controleren op een consequent verschil in beloningskans tussen HC-proeven en LC-proeven, hebben we gedwongen abortussen in een deel van de LC-proeven ingevoegd om de succespercentages en beloningskansen tussen proeftypen gelijk te maken (Fig. 1d).

HLC saccadetaak. a De HLC-saccadetaak. Cost cues (C cue) gaven de hoeveelheid inspanning aan die nodig was om een mogelijke beloning te behalen. Een lange fixatie was vereist tijdens de vertragingsperiode bij dure onderzoeken. De beloning cue (R cue) geeft aan of de apen een beloning kunnen krijgen of niet. b Het tijdsverloop van de blikhoek tijdens de vertragingsperiode. De bovenste en onderste panelen tonen respectievelijk de horizontale en verticale blikhoeken. Groene en paarse lijnen geven respectievelijk de kijkhoek aan in dure onderzoeken (50-onderzoeken in elk paneel) en in goedkope onderzoeken (50-onderzoeken in elk paneel). c Het aantal fouten tijdens de vertragingsperiode in de dure en goedkope proeven (**P < 0.01; tweezijdige paren t test; t67 = 8.8, P = 4.8 x 10-15, n = 68 voor Monkey P; t83 = 26.6, P ≈ 0, n = 84 voor Monkey S). Zwarte cirkels en foutbalken geven gemiddelde en SEM aan. d Succespercentages in de dure en goedkope proeven (tweezijdig gekoppeld) t test; t67 = 0.51, P = 0.61, n = 68 voor Monkey P; t83 = 0.79, P = 0.43, n = 84 voor Monkey S). e RT's naar de kostprijs (**P <0.01; tweezijdige paren t test; t67 = 20.4, P ≈ 0, n = 68 voor Monkey P; t69 = 2.0, P = 1.2 x 10-3, n = 70 voor Monkey S). f RT's naar de beloningscues (**P <0.01; tweezijdige paren t test; Monkey P (n = 68): HC + vs. LC +, t67 = 3.5, P = 9.2 x 10-4; HC− versus LC−, t67 = 24.5, P ≈ 0; HC + versus HC−, t67 = 21.6, P ≈ 0; LC + versus LC-, t67 = 28.5, P ≈ 0; Aap S (n = 70): HC + vs. LC +, t69 = 5.6, P = 4.4 x 10-7; HC− versus LC−, t69 = 4.8, P = 8.4 x 10-5; HC + vs. HC−, t69 = 18.0, P ≈ 0; LC + versus LC-, t69 = 5.9, P = 1.1 x 10-7)

Betaalde kosten verhogen de waarde van beloningsvoorspellende signalen

Om impliciet bewijs te verkrijgen voor een verschil in de subjectieve waardering van signalen van de aap, hebben we de reactietijden (RT's) van de apen getest. We verwachtten met name dat als de apen een hogere subjectieve waarde toekennen aan de ene optie dan de andere, ze snellere RT's zouden moeten tonen voor de meer gewaardeerde optie27. Toen RT's werden vergeleken tussen de kostensignalen, vertoonden beide apen snellere RT's voor de LC in vergelijking met de HC-keu (Fig. 1e), waarmee een impliciete voorkeur voor de LC-voorwaarde wordt aangetoond. Toen RT's werden vergeleken tussen beloningssignalen, vertoonden beide apen snellere RT's voor het belonen van (R +) signalen dan geen belonings (R−) signalen (Fig. 1f), wat aangeeft dat ze R + signalen verkozen boven R− signalen. Bovendien vertoonden beide apen snellere RT's naar de RHC+ cue vergeleken met de RLC+ cue en naar de RHC- cue vergeleken met de RLC- cue (Fig. 1f), wat aangeeft dat ze meer waarde hechten aan de beloningsvoorspellende signalen in de HC in vergelijking met de LC-conditie.

Bovendien namen we keuzeproeven op in de HLC-saccadetaak om de openlijke voorkeuren van apen tussen signalen te testen (aanvullende Fig. 1a). De apen kozen bij voorkeur de LC-keu bij het kiezen tussen kostensignalen (aanvullende Fig. 1b). Monkey S koos bij voorkeur de RHC+ cue bij het uitvoeren van de keuzetaak tussen RHC+ en RLC+ cue, maar geen voorkeur tussen RHC- en RLC- signalen (aanvullende Fig. 1c, d). Aap P daarentegen vertoonde geen openlijke voorkeur tussen RHC+ en RLC+ signalen, maar gaf toch de voorkeur aan de RHC- cue bij het kiezen tussen RHC- en RLC- signalen (aanvullende Fig. 1c, d).

Elektrofysiologische resultaten in de HLC-saccadetaak

We registreerden activiteit van afzonderlijke eenheden van neuronen die zich in de substantia nigra pars compacta (SNc) en ventrale tegmentale zone (VTA) bevonden tijdens de HLC-saccadetaak. We identificeerden 70 dopamine-neuronen over de twee apen (aanvullende Fig. 2a; 18 en 52 neuronen van respectievelijk Monkey P en S). Histologisch onderzoek bevestigde dat de neuronen zich in of rond de SNc / VTA bevonden (aanvullende Fig. 2b).

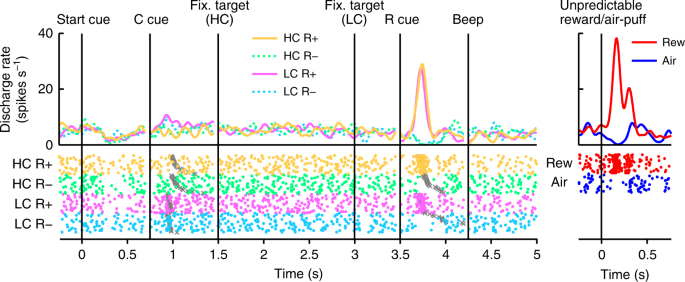

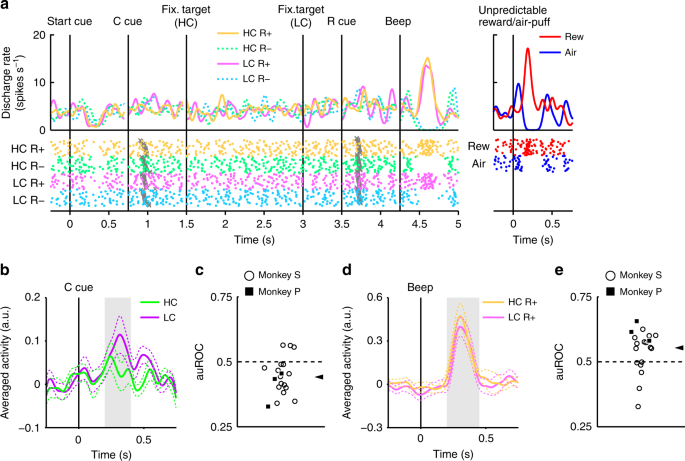

In Fig. 2, tonen we de activiteit van een representatief dopamine-neuron. Dit neuron vertoonde bescheiden activering van de LC cue en fasische activering of onderdrukking van de beloning (RHC+ en RLC+) of geen beloningscues (RHC- en RLC-) respectievelijk (Fig. 2Aanvullende Fig. 3). Het neuron vertoonde ook fasische activering voor de onvoorspelbare beloning evenals fasische onderdrukking in reactie op een aversieve stimulus, een onvoorspelbare luchtwolk (Fig. 2, rechter paneel). Bovendien vertoonde het neuron een bescheiden onderdrukking van het startsein, maar reageerde het niet op beloning. De hele populatie dopamine-neuronen die we hebben opgenomen, vertoonden allemaal vergelijkbare reacties op de startkeuze en beloning (aanvullende afbeelding. 4a, b). In de HLC-saccadetaak werden inspanningskosten betaald voordat de beloning werd verkregen. Omdat de voorspelde kosten de activiteit van dopamine-neuronen verminderden22,23, dopamine neuron responsen zouden worden onderdrukt op het moment van start cue presentatie16.

Activiteit van een representatief dopamine-neuron in de HLC-saccadetaak. Spike-dichtheidfuncties (geconvolueerd met een Gauss-functie) en rasterplots zijn uitgelijnd met de begintijd van de start-cue, de cost cue (C cue), het fixatiedoel, de beloningscue (R cue) en de pieptoon. Elke kleur vertegenwoordigt een voorwaarde (geel: HC +, groen: HC−, roze: LC +, cyaan: LC−), respectievelijk. De timing van het begin van de saccade wordt aangegeven door grijze kruisjes. De reacties van de dopamine-neuronen op de onvoorspelbare beloning of luchtwolk worden ook weergegeven in het rechterpaneel (rood: onvoorspelbare beloning, blauw: onvoorspelbaar luchtwolk)

Dopamine neuronen coderen informatie over zowel beloning als kosten

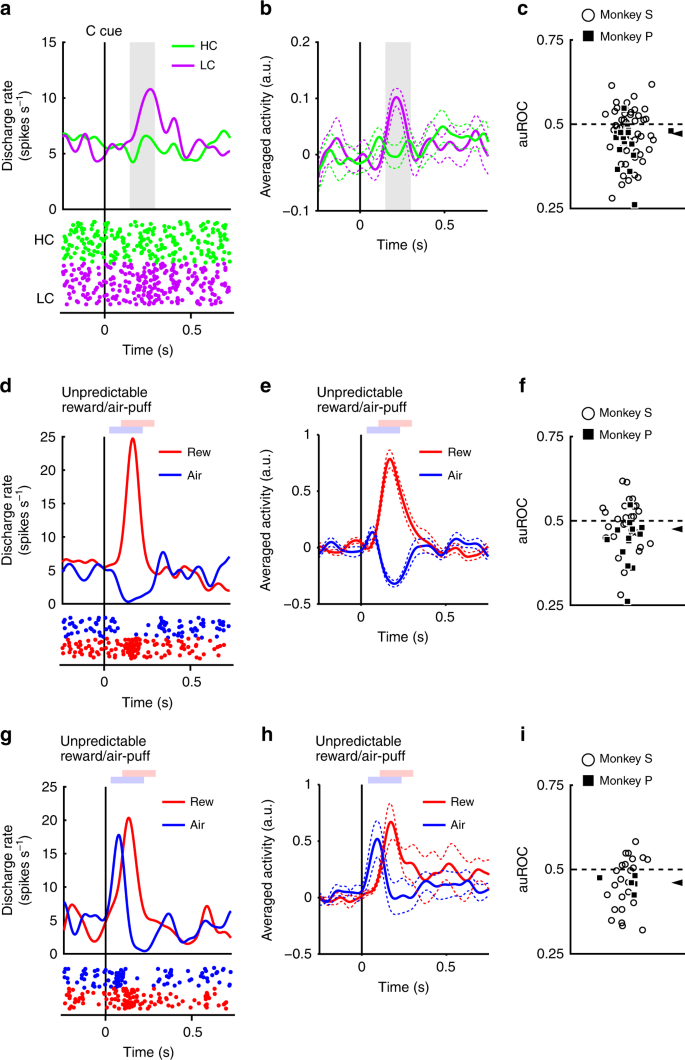

De neuronen reageerden fasisch op het LC-signaal, maar minder robuust op het HC-signaal (Fig. 3a, b). Opgewekte responsen op de signalen van de kostenconditie vertoonden een kleinere respons op de HC cue dan LC cue (tweezijdige Wilcoxons ondertekende rangtest, P <3.2 × 10-4, n = 70). We hebben het effect van de voorspelde kosten op neuronale reacties gekwantificeerd met behulp van een ROC-analyse (Receiver Operating Characteristic). De verdeling van het gebied onder de ROC-curve (auROC) was significant <0.5 (Fig. 3c; tweestaartige test met Wilcoxon-rang; P = 5.4 x 10-4, n = 70), wat aangeeft dat HC-cue-responsen kleiner waren dan op de LC-cue. Eerder is gevonden dat voorspelde kosten de activiteit van dopamine-neuronen verminderen, in overeenstemming met onze resultaten22,23. Bovendien vertoonde de populatie dopamine-neuronen een significante activering van de LC-keu terwijl ze geen significante onderdrukking van HC-signalen vertoonde (aanvullende Fig. 4c, d). Deze resultaten suggereren dat dopamine-neuronen informatie over zowel beloning als kosten coderen en integreren ten tijde van de presentatie van de kostprijs.

Dopamine-neuronreacties op kostenaanwijzingen. a Een representatieve reactie van dopamine-neuronen op de kostencues. De piekdichtheidsfuncties werden berekend uit de genormaliseerde activiteit van een dopamine-neuron geregistreerd van de aap P. De gekleurde lijnen geven de piekdichtheidsfuncties aan en gekleurde stippen geven de piektiming aan. Groene en paarse kleuren duiden op activiteit in respectievelijk de dure en goedkope proeven. De verticale lijn geeft de timing van de cost cue-presentatie aan. Het grijsgekleurde gebied geeft de periode aan om de vuursnelheid te berekenen als reactie op de conditiesignalen. b Populatiegemiddelde activiteit van de dopamine-neuronen geregistreerd van aap P tot de conditiesignalen. De ononderbroken lijnen, de stippellijnen vertegenwoordigen respectievelijk gemiddelde en SEM. c De verdeling van de gebieden onder de ROC's om het effect van de voorspelde kosten op de neuronale respons op de kosten te kwantificeren. Gevulde vierkanten en open cirkels geven respectievelijk gegevens aan van aap P en S. De pijlpunt geeft de mediaan van de auROC (0.47) aan. d, g Representatieve reacties van het motiverende waarde type dopamine neuron (d) of type dopamine neuron (g) naar de onvoorspelbare beloning of luchtwolk. Rode en blauwe curven geven respectievelijk de reactie op onvoorspelbare beloning en onvoorspelbare luchtwolk aan. De verticale lijn geeft de timing aan van de onvoorspelbare beloning of air-puff-afgifte. Lichtrode en blauwe vierkanten geven de periode aan om de schietsnelheid te berekenen als de reactie op de onvoorspelbare beloning of luchtwolk. e, h Populatiegemiddelde activiteit van dopamine neuronen van het motivationele type (e) of type dopamine neuronen (h) naar de onvoorspelbare beloning of luchtwolk. f, i De verdeling van de auROC's berekend op basis van het motiverende type dopamine-neuronen (f) of type dopamine neuronen (i). De pijlpunten geven de mediaan van de auROC's aan (f 0.48; i 0.46)

Twee verschillende subtypen dopamine-neuronen zijn eerder beschreven: motivationele waarde en salience-neuronen28,29. We hebben in onze dopamine-neuronenpopulatie bewijs gevonden van responspatronen die consistent zijn met beide subtypen. Neuronen van het waardetype vertoonden fasische onderdrukking van de aversieve stimuli van de luchtwolk (Fig. 3d, e). Omgekeerd vertoonden salience-neuronen een fasische activering van de aversieve stimuli (Fig. 3g, h). De lange fixatie in de HC-proef is ook onaangenaam en aversief; daarom is het mogelijk dat de twee dopamine-neuronsubtypen verschillende responspatronen vertonen op de kostencondities. Als dopamine-neuronen aversieve stimuli en kosten op een vergelijkbare manier vertegenwoordigen, zouden waarde-neuronen een verminderde activiteit voor de HC-keu moeten vertonen vanwege zijn aversiviteit. Aan de andere kant zouden saillante neuronen in activiteit naar de HC-cue moeten toenemen omdat ze ook toenemen tot onaangename stimuli. Opgeroepen responsen van beide typen neuronen waren echter kleiner voor de HC cue vergeleken met de LC cue (tweestaartige Wilcoxons ondertekende rangtest; P = 0.021, n = 41 en P = 0.0044, n = 29 voor respectievelijk de waarde en de saillantie-typen), en de ROC-analyse toonde kleinere reacties op de HC in vergelijking met de LC-cue in beide subtypen (Fig. 3f, i; tweestaartige test met Wilcoxon-rang; P = 0.030, n = 41 en P = 0.0058, n = 29 voor respectievelijk de typen waarde en saillantie). Aldus voorspelde kostenverlaagde activiteit in beide subtypen van dopamine-neuronen. Deze resultaten geven aan dat kosteninformatie door dopamine-neuronen op een kwalitatief andere manier wordt verwerkt dan aversieve stimuli.

In de HLC-saccadetaak hebben we een gedwongen abortus ingevoegd in een deel van de LC-onderzoeken om de slagingspercentages en de beloningskans tussen proeftypen gelijk te maken. Deze manipulatie verhoogde de onzekerheid van het verkrijgen van een beloning of het risico van geen beloning in de LC-toestand. Daarom kan de hogere activiteit van dopamine-neuronen en de verhoogde waardering van de apen voor de LC ten opzichte van de HC-cue te wijten zijn aan het verschil in risico of onzekerheid tussen de kostencondities. We vonden echter geen verband tussen het aantal geforceerde abortussen en het verschil in RT's (aanvullend Fig. 5a, b), en we vonden een positieve correlatie tussen het aantal geforceerde abortussen en de auROC (aanvullende Fig. 5c). We vergeleken ook dopamine-responsen met de kostprijs na abortus versus na correcte proeven, maar vonden geen verschil in beide kostencondities (aanvullende Fig. 5d). Deze resultaten geven aan dat het aantal geforceerde abortussen in de LC-toestand geen verklaring is voor de toename van de waardering of de verbeterde dopaminerge activering van de LC-cue.

Verhoogde dopamine-reacties om cue te belonen met betaalde kosten

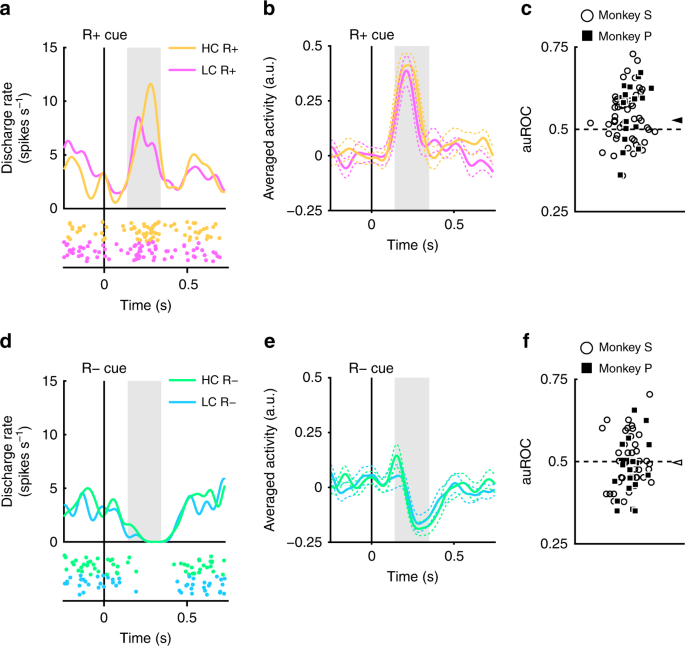

De opgenomen dopamine-neuronen bleken respectievelijk fasische activering en onderdrukking voor beloning en geen beloningsvoorspellende signalen te tonen (Fig. 2). Vervolgens hebben we beoordeeld of deze reacties werden gemoduleerd op basis van de eerder gemaakte kosten. Een voorbeeld van een representatief neuron en populatiegemiddelde neuronen die een grotere activering op de R vertonenHC+ cue dan de RLC+ cue worden getoond in figuur 4a en b, respectievelijk (tweezijdige Wilcoxon-ondertekende rangtest; P = 7.4 x 10-5, n = 70). De verdeling van auROC's was> 0.5, wat aangeeft dat de respons op de RHC+ cue was groter dan bij de RLC+ cue (Fig. 4c; tweestaartige test met Wilcoxon-rang; P = 1.4 x 10-4, n = 70). Deze resultaten geven aan dat de respons op de beloningsvoorspellende cue in de HC-conditie significant groter is dan in de LC-conditie. Daarom suggereren onze bevindingen dat het positieve RPE-signaal dat wordt vertegenwoordigd door dopamine-neuronen wordt verhoogd met de eerder gemaakte kosten.

Dopamine neuron reacties op beloning signalen. a Een voorbeeld van een neuronreactie op de R + signalen. De spijkerdichtheidsfuncties werden berekend uit de activiteit van dopamine-neuron geregistreerd van aap P. De gekleurde lijnen en stippen geven respectievelijk spijkerdichtheid en spijkertiming aan. Gele en roze kleuren duiden op activiteit in respectievelijk de dure en goedkope proeven. De verticale lijn geeft de timing van de R + cue-presentatie aan. Het grijs gekleurde gebied geeft de periode aan om de vuursnelheid te berekenen als reactie op de beloningscues. b Populatie-gemiddelde activiteit van de dopamine-neuronen geregistreerd van aap P tot de R + -cues. De ononderbroken lijnen en de onderbroken lijnen vertegenwoordigen respectievelijk gemiddelde en SEM. c De verdeling van de auROC's om het effect van de betaalde kosten op de neuronale respons op de R + signalen te kwantificeren. Gevulde vierkanten en open cirkels geven respectievelijk gegevens aan van aap P en S. De pijlpunt geeft de mediaan van de auROC's (0.53) aan. d Een representatieve reactie op de R-signalen. Groene en cyaan kleuren geven respectievelijk dure en goedkope proeven aan. De verticale lijn geeft de timing van de R-cue-presentatie aan. e Populatiegemiddelde activiteit van de dopamine-neuronen geregistreerd van aap P tot de R-signalen. f De verdeling van de auROC's om het effect van de betaalde kosten op de neuronale respons op de R-signalen te kwantificeren. De pijlpunt geeft de mediaan van de auROC aan (0.50)

De dopamine-neuronen vertoonden ook fasische onderdrukking van de R-signalen (Fig. 4d, e). De reacties van de dopamine-neuronen op de R-signalen vertoonden echter geen significant verschil als functie van de gemaakte kosten (tweestaartige Wilcoxons ondertekende rangtest; P = 0.25, n = 70), en de ROC-analyse bracht geen enkel bewijs aan het licht voor een vertekening in de responsverdeling (Fig. 4f; Wilcoxons ondertekende rangtest, P = 0.35; n = 70). De betaalde kosten werden dus niet weerspiegeld in het negatieve RPE-signaal dat werd opgewekt door de niet-belonende voorspellende signalen. Dit kan worden veroorzaakt door een vloereffect: de spontane activiteit van het dopamine-neuron is laag (rond 5 Hz); en bijgevolg is er mogelijk niet voldoende dynamisch bereik om een dergelijk verschil in kosten voor de negatieve RPE-respons adequaat te coderen (Fig. 4d, e).

We onderzochten ook het effect van de betaalde kosten op de beloningscues voor de waarde- en salience-type dopamine-neuronen afzonderlijk, maar beide soorten dopamine-neuronen vertoonden een vergelijkbaar responspatroon (aanvullende Fig. 6a-h). Daarom vertonen de betaalde kosten een soortgelijk effect op de respons op beloningssignalen in dopamine-neuronen van het waarde- en salience-type.

De werkelijke fixatieduur van de apen was niet constant, maar varieerde per proef (Fig. 1b). Daarom was het mogelijk dat dopamine-reacties op de beloningscues worden gemoduleerd door de werkelijke fixatieduur per proef. We konden echter geen significante correlatie tussen hen vinden voor elke kosten- en beloningsconditie (aanvullende Fig. 7advertentie). Bovendien werden de RT's voor de beloningskeuze ook gemoduleerd door de kosten en beloningsvoorwaarden (Fig. 1f). Een mogelijkheid is dat de reacties van de dopamine-neuronen proefondervindelijk door de RT's op de beloningscues kunnen worden verklaard. We konden echter geen significante correlatie vinden tussen RT's en de genormaliseerde dopamine-responsen op de beloningscues (aanvullende Fig. 7e-h). Deze resultaten suggereren dat dopamine-responsen onafhankelijk zijn van zowel RT's als fixatieduur bij elke proef, maar gemoduleerd door de hoeveelheid vereiste kosten en verwachte beloning die voor elk type proef zijn vastgesteld.

Verder is het ook mogelijk dat de geforceerde abortus in de LC-conditie zowel de voorkeuren van de apen genereerde als de verbeterde activering van de dopamine-neuronen op de beloningskeuze in de HC-conditie. Als dit het geval is, moet het aantal geforceerde abortussen worden gerelateerd aan zowel de voorkeur als de mate van verbeterde activering. Het aantal geforceerde abortussen had echter geen effect op de voorkeur van de apen of de activering van de dopamine-neuronen op de beloningscues (aanvullende Fig. 8). Daarom snellere RT's en hogere DA-reacties op de RHC+ cue dan de RLC+ cue zijn niet te wijten aan de ingevoerde geforceerde afbrekingen in de LC-toestand.

Hoge kosten verhogen dopamine-reacties om beloning af te leveren

De reactie van dopamine-neuronen op de R + signalen moet afkomstig zijn van de reactie op de beloning zelf, omdat dopamine-neuronen hun reactie op beloning-voorspellende signalen ten opzichte van de stimulus-beloning-associatie veranderen8,30. Daarom verwachtten we dat dopamine-neuronen een betaalde kostenafhankelijke responsverbetering zouden vertonen om de levering te belonen. Om dopamine-neuronactiviteit te meten voor de beloningsafgifte, voerden de apen de HLC-onzekere taak uit met twee nieuwe beloningscues (Fig. 5a). Omdat de beloningen werden geleverd in slechts de helft van de beloningscue-presentaties, voorspelden de beloningscues niet betrouwbaar noch differentieel voorspellende beloning. Dit werd gedaan om de responsiviteit van dopamine-neuronen op de ontvangst van een (onvoorspelde) beloning te maximaliseren, om onze gevoeligheid te vergroten om een modulatie in de responsiviteit van de neuronen te detecteren als functie van de bestede kosten.

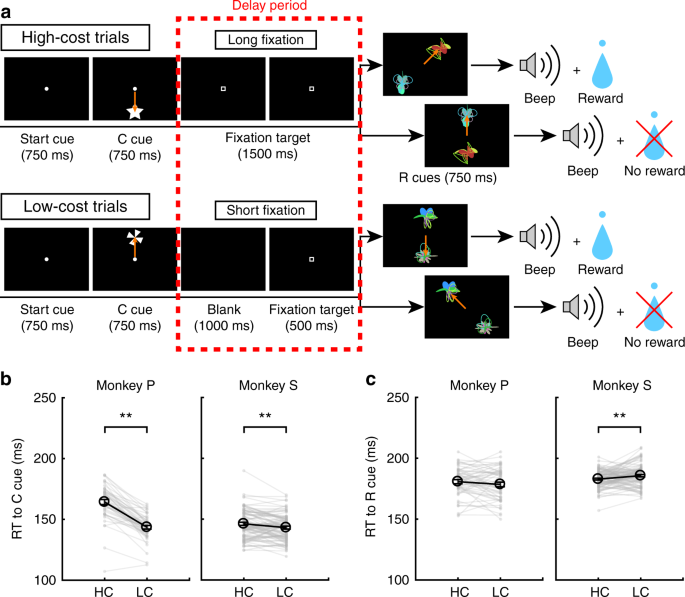

HLC onzekere taak. a De HLC onzekere taak. In deze taak werden onzekere beloningscues gebruikt, waarin beloningen 50% van de tijd werden afgeleverd, ongeacht welke cue werd gepresenteerd. b RT's naar de cues in de dure en goedkope proeven. Alleen aap P vertoonde een snellere RT naar de LC-keu dan de HC-keu (**P <0.01; tweezijdige paren t test; t4 = 9.0, P = 8.5 x 10-4, n = 5 voor aap P; t18 = 1.4, P = 0.19, n = 19 voor aap S). Zwarte cirkels en foutbalken geven gemiddelde en SEM aan. c RT's naar de beloningscues in de dure en goedkope proeven. Er was geen verschil tussen de RT's en de beloningscues tussen de hoge kosten en de lage kosten (tweezijdig gepaarde t test; t4 = 0.97, P = 0.39, n = 5 voor aap P; t18 = 0.99, P = 0.39, n = 19 voor aap S)

Toen de RT's werden vergeleken tussen de kosten, toonde aap P een snellere RT naar de LC-keu dan de HC-keu (Fig. 5b). Er was geen verschil in RT's voor de beloningscues tussen de HC- en LC-toestand bij beide apen (Fig. 5c).

In de HLC-onzekere taak vertoonden dopamine-neuronen een bescheiden activering van de LC-keu, maar reageerden niet op de beloningscues omdat ze niet beloningsvoorspellend waren (Fig. 6a). Over de hele populatie waren opgeroepen reacties kleiner voor de HC dan LC cue (Fig. 6b; tweestaartige test met Wilcoxon-rang; P = 2.7 x 10-3, n = 19), en ROC-analyses lieten kleinere reacties op de HC-cue zien (Fig. 6c; tweestaartige test met Wilcoxon-rang; P = 5.5 x 10-3, n = 19). De neuronale respons op beloningsafgifte in de HC-toestand was groter dan de LC (Fig. 6d; tweestaartige test met Wilcoxon-rang; P = 0.036, n = 19). De verdeling van auROC's was> 0.5, XNUMX, wat wijst op een grotere respons op de beloningsafgifte in de HC in vergelijking met LC-onderzoeken (Fig. 6e; tweestaartige test met Wilcoxon-rang; P = 0.049, n = 19). Deze resultaten geven aan dat de respons van de beloningsaflevering verbeterd is in de HC-proef en dat betaalde kosten het positieve RPE-signaal verhogen bij beloning.

Dopamine neuron reactie op de beloning levering. a Representatieve dopamine neuron activiteit in de HLC onzekere taak. Elke kleur vertegenwoordigt de voorwaarden (geel: HC +, groen: HC−, roze: LC +, cyaan: LC−). De timing van het begin van de saccade wordt aangegeven door grijze kruisjes. De reacties van dit dopamine-neuron op de onvoorspelbare beloning en luchtwolk worden ook weergegeven in het rechterpaneel (rood: onvoorspelbare beloning, blauw: onvoorspelbaar luchtwolk). b Populatie-gemiddelde activiteit van de dopamine-neuronen geregistreerd van aap S tot de conditiesignalen. Groene en paarse kleuren duiden op activiteit in respectievelijk de dure en goedkope proeven. De ononderbroken lijnen en de onderbroken lijnen vertegenwoordigen respectievelijk gemiddelde en SEM. Een grijs gekleurd gebied geeft het tijdvenster aan om de vuursnelheid te berekenen als reactie op de condities. c De verdeling van de auROC's om het effect van de voorspelde kosten op de neuronale respons op de kostencues te kwantificeren. Gevulde vierkantjes geven de gegevens van de aap P aan (n = 3) en open cirkels geven de gegevens van de aap S (n = 16). De pijlpunt geeft de mediaan van de auROC (0.44) aan. d Populatiegemiddelde activiteit van de dopamine-neuronen geregistreerd van de aap S tot de beloning. Gele en roze kleuren duiden op activiteit in respectievelijk de dure en goedkope proeven. Grijs gekleurd gebied geeft het tijdvenster aan om de vuursnelheid te berekenen als reactie op de beloning. e De verdeling van de auROC's om het effect van de betaalde kosten op de neuronale respons op de beloning te kwantificeren. De pijlpunt geeft de mediaan van de auROC aan (0.55)

Bovendien vergeleken we dopamine-reacties na het ontbreken van een beloning. De auROC's vertoonden geen bevooroordeelde verdeling, wat aangeeft dat betaalde kosten geen effect hadden op negatieve RPE's op het moment van uitkomst (aanvullend Fig. 9a). De dopamine-neuronen vertoonden geen verschil tussen reacties op de RHC en RLC signalen (aanvullende Fig. 9b).

Hoge kosten verhogen leersnelheid

Gezien het feit dat RPE's om levering te belonen worden verhoogd met de betaalde kosten, onder de hypothese dat RPE's direct betrokken zijn bij het bemiddelen van stimulus-beloningsleren, verwachtten we dat verbeterde RPE's zouden worden weerspiegeld in leergedrag via een verhoogde leersnelheid.24. Om te testen op een effect van betaalde kosten op het leren, voerden de apen de HLC-exploratietaak uit (Fig. 7a; zie methoden). In deze taak werden twee beloningscues (R + en R−) tegelijkertijd gepresenteerd en moesten de apen er een kiezen. We hebben de slagingspercentages en de waarschijnlijkheid van beloning gelijkgesteld tussen proeftypen (tweezijdig gekoppeld) t test; t48 = 0.15, P = 0.89, n = 49 voor aap P; t85 = 1.2, P = 0.25, n = 86 voor aap S). Toen RT's werden vergeleken voor de kostencues, vertoonden beide apen snellere RT's voor de LC-cue dan de HC-cue (Fig. 7b; tweezijdig gekoppeld t test; t48 = 12.9, P ≈ 0, n = 49 voor aap P; t85 = 3.4, P = 9.4 x 10-4, n = 86 voor aap S). Bij het vergelijken van RT's met de beloningsaanwijzingen, vertoonde aap S snellere RT's in de HC dan LC-toestand (Fig. 7c; tweezijdig gekoppeld t test; t48 = 1.3, P = 0.19, n = 49 voor aap P; t85 = 2.8, P = 6.8 x 10-3, n = 86 voor aap S). Bij het afzonderlijk vergelijken van RT's tijdens de eerste en tweede helft van de leersessie, waren RT's naar de LC-cue sneller dan naar de HC-cue tijdens de eerste (aanvullende Fig. 10) en de tweede helft van de sessie (aanvullende Fig. 10c). Integendeel, de RT's van aap S voor de beloning in de HC-conditie waren sneller dan in de LC-conditie tijdens alleen de tweede helft van de sessie (aanvullende Fig. 10d) maar niet de eerste helft (aanvullende Fig. 10b).

HLC-exploratietaak. a De HLC-exploratietaak. In deze taak moesten apen kiezen tussen R + en R-signalen, die willekeurig werden gegenereerd in elke leersessie. Als ze voor de R + cue kozen, konden ze een beloning krijgen en als ze voor R-cue zouden kiezen, zouden ze geen beloning krijgen. b RT's naar de cues in de dure en goedkope proeven. De apen vertoonden snellere RT's tot de goedkope keu (**P < 0.01; tweezijdige paren t test). Zwarte cirkels en foutbalken geven het gemiddelde en SEM aan. c RT's naar de beloningscues in de dure en goedkope proeven. Monkey S toonde snellere RT's naar de beloningssignalen in de dure toestand

In de HLC-exploratietaak werden willekeurig willekeurige beloningscijfers gegenereerd in elke leersessie. Daarom moesten de apen in elke sessie de relatie leren tussen beloningscodes en beloningen. Naarmate de proeven vorderden binnen een sessie, kozen de apen vaker R + signalen in elke kostenconditie (Fig. 8a). Om de leersnelheid te kwantificeren, passen we een cumulatieve exponentiële functie aan de gegevens toe, met twee gratis parameters, a en b, die respectievelijk de steilheid van de curve en het plateau aangeven (aanvullende Fig. 11a, b). De logverhouding tussen steilheidsparameters (log aHC/aLC) was significant groter dan nul, hetgeen duidt op een grotere steilheidsparameter in HC dan LC-proeven (Fig. 8b; tweezijdig t test; t48 = 2.1, P = 0.042, gemiddelde = 0.58, n = 49 voor aap P; t85 = 2.5, P = 0.013, gemiddelde = 0.19, n = 86 voor aap S). De logverhouding tussen plateauparameters (log bHC/bLC), verschilde niet van nul, hetgeen geen verschil aangeeft tussen de kostenvoorwaarden (Fig. 8c; tweezijdig t test; t48 = 0.76, P = 0.45, gemiddelde = −0.0024, n = 49 voor aap P; t85 = 0.56, P = 0.58, gemiddelde = 0.010, n = 86 voor aap S). Deze resultaten geven aan dat de leersnelheid hoger is in de HC-onderzoeken. Vervolgens hebben we leercurven gemodelleerd met behulp van een reinforcement-learning (RL) -model (zie Methoden). Dit model bevat leerfrequentieparameters (αHC en αLC) en exploratiepercentages (βHC en βLC) voor beide kostenvoorwaarden (aanvullende Fig. 11c, d). Bij aanpassing aan gedrag hebben we vastgesteld dat de logverhouding tussen de parameters van het leersnelheid (log αHC/αLC) was groter dan nul, hetgeen duidt op een aanzienlijk grotere leersnelheidsparameter in HC dan LC-proeven (Fig. 8d; tweezijdig t test; t48 = 2.3, P = 0.026, gemiddelde = 0.50, n = 49 voor aap P; t85 = 2.2, P = 0.034, gemiddelde = 0.25, n = 86 voor aap S) terwijl de parameter β vertoonde geen verschil (Fig. 8e; tweezijdig t test; t48 = 0.77, P = 0.44, gemiddelde = 0.0097, n = 49 voor aap P; t85 = 0.64, P = 0.52, gemiddelde = 0.038, n = 86 voor aap S). Hier hebben we de leerfrequentieparameters geschat voor elke kostenconditie (αHC en αLC) afzonderlijk om hogere leersnelheden in de HC-toestand te verklaren. Als de leerpercentages echter identiek zijn tussen de kostencondities, is de verhouding tussen de geschatte leersnelheidparameters (αHC/αLC) kan worden beschouwd als een versterkingswaarde voor RPE's in de HC-toestand. Daarom suggereren deze resultaten dat een versterking van RPE's hogere leersnelheden in de HC-toestand kan verklaren.

Leer snelheidstest. a Gemiddeld leerproces van apen P en S. Het aandeel van R + -keuzes wordt uitgezet als functie van de proef. De groene en paarse punten geven respectievelijk gegevens aan uit een dure en goedkope proef. De stippellijnen staan voor een vloeiend leerproces. De cumulatieve exponentiële functies werden aangepast aan de gegevenspunten en weergegeven als de ononderbroken lijnen. b De logverhouding tussen de aanpasparameters a in de hoge en goedkope omstandigheden waarin de gegevens geschikt waren voor een cumulatieve exponentiële functie (*P <0.05; tweezijdige Wilcoxon-ondertekende rangtest). Zwarte cirkels en foutbalken geven gemiddelde en SEM aan. c De logverhouding tussen de aanpasparameters b in de hoge en goedkope omstandigheden waarin de gegevens geschikt waren voor een cumulatieve exponentiële functie. d De logboekverhouding tussen de parameter leersnelheid α in de hoge en goedkope omstandigheden waarin de gegevens geschikt waren voor een versterkend leermodel. e De logverhouding tussen de aanpassingsparameter β in de hoge en goedkope omstandigheden waarin de gegevens geschikt waren voor een versterkend leermodel

We hebben ook geprobeerd het leerproces uit te leggen met alternatieve RL-modellen die rekening houden met een mogelijkheid dat de apen de anticorrelatie tussen stimuli en beloning bij elke proef kennen. In die modellen wordt de waarde van de niet-gekozen optie bijgewerkt naast de gekozen optie (aanvullende afbeelding. 12). Zelfs bij het toepassen van dergelijke alternatieve modellen op de gegevens, was de leersnelheidsparameter aanzienlijk groter in de HC in vergelijking met de LC-conditie (aanvullende Fig. 12b, f) terwijl de parameter β vertoonde geen verschil (aanvullende Fig. 12d, h). Onze bevinding over een versterking van het RPE-signaal in de HC-toestand is dus robuust voor de vorm van het RL-model dat past bij de gegevens.

Discussie

We onderzochten het effect van betaalde kosten op de waarde van beloningsvoorspellende signalen en op de fasische reacties van dopamine-neuronen in de middenhersenen. Apen vertoonden een verhoogde waardering voor beloningsvoorspellende signalen na het uitvoeren van een actie die hogere kosten met zich meebracht. Dopamine-neuronen vertoonden verhoogde responsen op zowel de beloningsvoorspelling als de beloning, nadat hogere kosten waren gemaakt. Bovendien vertoonden de apen hogere leersnelheden wanneer hogere kosten nodig waren om een beloning te krijgen.

Verschillende onderzoeken hebben aangetoond dat betaalde kosten de voorkeuren voor een beloningsvoorspellende keu verhogen1,2,3. In de huidige studie vertoonden de apen snellere RT's naar de beloningsvoorspellende signalen in de HC-toestand vergeleken met die in de LC-toestand, consistent met de mogelijkheid dat de beloningswaarde wordt verhoogd door de betaalde kosten27. Een alternatieve mogelijkheid is dat de langere fixatietijd gepaard gaat met verbeterde aandacht voor het saccadedoel in de HC-toestand, waardoor de RT's worden verlaagd na een langere fixatie in de HC-proef. We hebben echter geen verschil gevonden tussen RT's en de R-signalen in de HC- en LC-onderzoeken in de onzekere HLC-taak. Verder in de eerste helft van de HLC-verkenningssessie. RT's tot de R-signalen waren niet significant verschillend tussen de HC- en LC-proeven. Deze bevindingen geven dus aan dat een langere fixatie geen waarschijnlijke verklaring is voor de kortere RT's waargenomen voor de beloningsvoorspellende signalen. Naast het effect van betaalde kosten op beloning cue RT's, hadden de kosten ook invloed op RT's voor de niet-voorspellende signalen, ondanks het feit dat er geen beloning werd gegeven na de cue-presentaties. Een eerdere studie rapporteerde een soortgelijk fenomeen, omdat apen proefpersonen kortere RT's vertoonden in niet-beloonde proeven wanneer beloningen met meer voorkeur werden gebruikt in de alternatieve proeven binnen elk blok30. Een mogelijke interpretatie van het effect in die studie is dat een algehele hogere motivatie om in het blok te reageren met een beloning met meer voorkeur RT's ook beïnvloedde naar de geen beloning in het blok. Evenzo zou in de huidige studie de verwachting van een waardevollere beloning in de HC-proeven de RT's kunnen hebben gemoduleerd naar het geen beloning-signaal in de HC-proeven in onze taak. Bovendien was het effect van de betaalde kosten op RT's op de beloningscues kleiner dan dat op de niet-beloningsvoorspellende signalen. Dit is waarschijnlijk een artefact van het feit dat omdat de apen sneller een saccade naar de R maaktenLC+ cue in de eerste plaats, is er minder ruimte om een verkorting van RT's naar de R te detecterenHC+ cue. Daarom zou het verschil in RT's tussen de R + -signalen klein zijn.

De apen voerden ook keuzeproeven uit tussen de RHC en RLC aanwijzingen in de HLC-taak. Hoewel aap S een voorkeur voor de R toondeHC+ cue naar de RLC+ cue, aap P vertoonde zo'n voorkeur niet. Deze discrepantie kan worden verklaard door een contextueel verschil tussen de HLC-saccade en keuzeproeven. In de keuzeproeven werden twee beloningsvoorspellende signalen gepresenteerd in plaats van één beloningsvoorspelling. Bovendien kregen de apen geen beloning na hun keuze, zelfs als ze de beloningsvoorspellende keu kozen, dus de keuzetest werd met uitsterven gedaan. De uitstervingsprocedure werd geïmplementeerd om ervoor te zorgen dat de keuze van de aap werd gedreven door wat was geleerd in de inspanningsproeven, in tegenstelling tot verwarring met nieuw leren over de keuzeproeven. Deze procedure kan echter het neveneffect hebben dat de aap snel de uitstervingsprocedure zou kunnen herkennen in de keuzecontext en dat er geen reden is om de stimuli die de voorkeur hebben te kiezen. Desondanks had een van de apen inderdaad een voorkeur voor de beloning in de HC-toestand.

Op het moment van presentatie van een cue die een daaropvolgende vereiste voorspelde om kosten te betalen, was de activiteit van dopamine-neuronen verminderd, consistent met eerdere studies22,23. In onze studie hebben we geen algehele afname waargenomen van dopamine-neuronen die reageren op zowel HC- als LC-signalen ten opzichte van de uitgangswaarde. Dit suggereert dat er op dat tijdstip geen negatief RPE-signaal optreedt ondanks de volgende kosten. De afwezigheid van negatieve RPE weerspiegelt vermoedelijk de integratie van een voorspelling van toekomstige beloningen die later in het proces wordt verwacht. De dopamine-neuronen vertoonden significante activering in de LC-studie en de activiteit was hoger in vergelijking met de HC-studie. Dit suggereert dat kosteninformatie is opgenomen in het RPE-signaal dat wordt gedragen door dopamine-neuronen. Aldus coderen dopamine-neuronen zowel belonings- als kosteninformatie en geeft de RPE-reactie de som van kosten en beloning weer.

We hebben aangetoond dat het RPE-signaal dat wordt weergegeven door dopamine-neuronen wordt verbeterd door de betaalde kosten op het punt van beloning cue presentatie (in de HLC saccade-taak) en beloning levering (in de HLC onzekere taak). De objectieve hoeveelheid beloning in de HC- en LC-proeven was gelijk; daarom moet aanpassing van de RPE-signalen worden veroorzaakt door een niet-sensorisch proces. Deze mogelijkheid wordt ondersteund door verschillende onderzoeken die wijzen op een contextueel effect op dopamine RPE-signalen consistent met de verwerking van de subjectieve waarde en / of bruikbaarheid in dopamine-neuronen11,19,20,21,31,32,33,34. Als het RPE-signaal groter is, zou dit een snellere update van de cue-waarde moeten produceren, wat bijgevolg invloed zou hebben op de leersnelheid van stimulus-beloningsverenigingen. Eerdere studies hebben een wijziging van leersnelheid aangetoond door niet-sensorische factoren24,35. In overeenstemming hiermee vertoonden de apen hogere leersnelheden in de HC ten opzichte van de LC-toestand. We vonden dat een verbeterde leersnelheid door de betaalde kosten kan worden verklaard door een RL-model met een versterkte RPE. Het was moeilijk om de effecten van de versterkte RPE en verhoogde leersnelheid in onze experimenten te scheiden; we vonden echter een versterkt dopaminerge RPE-signaal in de HC-toestand. Bovendien heeft een eerdere fMRI-studie aangetoond dat de leersnelheidsparameter wordt weergegeven in de voorste cingulaire cortex en dat de activiteit van de VTA niet gerelateerd is aan de leersnelheidsparameter in vluchtige omgevingen36. Daarom beweren we dat het RPE-signaal gecodeerd door dopamine-neuronen wordt versterkt door de betaalde kosten, en dat het verhoogde RPE-signaal de leersnelheid verbetert.

Toen het RPE-signaal werd gegenereerd ten tijde van de presentatie van de beloningskeuze en de beloningslevering, hadden de apen de kosten al betaald. Daarom is een mogelijk mechanisme voor het verbeterde RPE-signaal dat een beloning verkregen na een HC mogelijk meer belonend is. Een verhoogde verwachting van een waardevollere beloning na de HC kan de motivatie om de proef af te ronden vergroten, waardoor de RT wordt verkort tot de beloningscijfers in de HC-proeven.

Een andere mogelijke interpretatie van onze resultaten is dat verlichting ervaren van de beëindiging van de kostbare actie kan werken als een beloning voor de apen. Onderzoek naar functionele magnetische resonantie (fMRI) heeft aangetoond dat pijnverlichting een beloning kan zijn voor menselijke deelnemers37,38; daarom kunnen kosten een vergelijkbare rol spelen als een aversieve prikkel voor pijn. Als de verlichting van kosten lonend is en dit wordt weerspiegeld in dopaminerge activiteit, zouden we verwachten dat de dopamine-neuronen zouden reageren aan het einde van de lange fixatie, wat de timing is van de presentatie van de beloningskeuze. We hebben echter geen verschil waargenomen in dopaminerge activiteit op het moment van beloning cue-presentaties noch enig verschil in RT's ten opzichte van de R-signalen tussen de HC- en LC-onderzoeken in de onzekere HLC-taak. Daarom suggereren we dat kostenreductie geen voldoende verklaring biedt voor het effect dat we hebben waargenomen in de dopamine-neuronen.

Bovendien vertoonden de dopamine-neuronen kwalitatief verschillende responsen op de aversieve stimulus in vergelijking met de kostenvoorspelling. Een mogelijke verklaring hiervoor is dat de inspanningskosten minder opvallend waren dan de luchtwolk of beloning, omdat de inspanningskosten tijdelijk over meerdere seconden werden uitgebreid terwijl de apen de fixatie uitvoerden en niet punctueel. Daarom zijn dopamine-neuronen mogelijk niet geactiveerd voor de minder opvallende kosten. Een andere mogelijkheid is dat het type dopamine-neuronen reageren op gebeurtenissen waarna enkele bewegingen werden geïnduceerd. Toen de beloning of de luchtwolk aan de apen werd afgegeven, maken ze enkele bewegingen, zoals het likken of het oog knipperen. In de HLC-saccadetaak moesten de apen hun blik echter gericht houden op het fixatiedoel zonder enige beweging als de kosten. Eigenlijk heeft een recente studie aangetoond dat de afgifte van dopamine in de kern accumbens na een beloningsvoorspellende keu wordt verzwakt, tenzij beweging correct wordt geïnitieerd39. Omdat de kosten in onze experimenten geen initiatie van beweging inhielden, zou dit mogelijk kunnen leiden tot een inconsistente reactie van dopamine-neuronen van het salience-type. Hoe dan ook, we kunnen concluderen dat kosteninformatie anders wordt verwerkt dan aversieve informatie.

Concluderend suggereren we dat betaalde kosten de waarde van beloningsvoorspellende signalen verhogen en dat dit op zijn beurt het RPE-signaal verhoogt dat wordt gecodeerd in de dopamine-neuronen in de middenhersenen. Dit effect leidde tot een gedragsvoorspelling dat het leerpercentage van dieren zou worden verbeterd voor beloningsvoorspellende signalen na de ervaring van een HC. Dit is inderdaad wat we hebben waargenomen. Onze observaties over de activiteit van dopamine-neuronen hebben ons dus geleid tot de hypothese van het bestaan van een gedragseffect, evenals een vermoedelijk computationeel mechanisme dat aan dit effect ten grondslag ligt, dat we vervolgens hebben bevestigd. Onze bevindingen zijn daarom een voorbeeld van hoe triangulatie kan plaatsvinden tussen metingen van neurale gegevens, computationele theorie en gedrag: het ontwikkelen van een dieper begrip van neuronale verwerking in de hersenen kan inzichten opleveren over gedrag en de onderliggende berekeningsbasis.

Methoden

Dieren

We gebruikten twee mannelijke Japanse apen (Macaca fuscata; lichaamsgewicht, 6.5 kg = Monkey P; lichaamsgewicht, 9.0 kg = Monkey S). We implanteerden een hoofdpaal bovenop de schedel van de aap, zodat deze op een later tijdstip aan een stoel kon worden bevestigd. Een opnamekamer werd ook geïmplanteerd om de montage van een elektrodemicromanipulator mogelijk te maken. De opnamekamer werd 45 ° zijdelings gekanteld in het coronale vlak en gepositioneerd op de stereotaxische coördinaten: 15 mm anterieur aan het externe kanaal. Na een herstelperiode werden de apen getraind om de saccadetaak uit te voeren. Na het voltooien van de training hebben we een gat geboord door de schedel in de opnamekamer voor het inbrengen van de elektrode. Alle protocollen voor dierenverzorging zijn goedgekeurd door de Animal Experiment Committee van Tamagawa University en conform de National Institutes of Health Guide voor de verzorging en het gebruik van laboratoriumdieren.

Gedragstaak

Apen werden getraind om de HLC saccade-taak uit te voeren (Fig. 1a), HLC onzekere taak (Fig. 5a) en HLC-exploratietaak (Fig. 7a Alle taken werden uitgevoerd in een donkere kamer. De apen zaten in een stoel voor een 22-inch. LCD-monitor (S2232W, Eizo) met hun geïmplanteerde hoofdstijlen bevestigd aan de stoel. De afstand tussen hun ogen en het beeldscherm was 70 cm. Wanneer een startkeu (witte cirkel, 0.3 ° diameter) in het midden van het scherm werd gepresenteerd, moest de aap zijn blik op de keu houden. De start-cue verdween na 750 ms en vervolgens werd een kosten-cue gepresenteerd (ster en windmolen voor respectievelijk de HC- en LC-proeven). Apen moesten tijdens de 750 ms cue-presentatie saccaden naar de cost cue. Als ze niet aan de keu deden, werd de proef afgebroken en begon dezelfde proef opnieuw. Tijdens HC-onderzoeken werd het fixatiedoel (0.3 ° x 0.3 ° wit vierkant) gepresenteerd net na het verdwijnen van de kostenaanwijzing voor 2000 ms (HLC saccade en HLC onzekere taken) of 1500 ms (HLC-verkenningstaak) en de apen waren vereist om ernaar te saccaden en hun blik erop te houden. Als de apen hun blik voorbij een fixatievenster van 4 ° × 4 ° bewogen, werd de taak afgebroken. Het fixatievenster werd 400 ms na de presentatie van het fixatiepunt geactiveerd omdat de apen tijd nodig hadden om zich voor te bereiden op de saccade en om hun fixatie aan te passen. Daarom moesten de apen gedurende ten minste 1600 ms (HLC-saccade en HLC onzekere taken) of 1100 ms (HLC-exploratietaak) fixeren in de HC-proeven. In de LC-onderzoeken werd een leeg scherm weergegeven gedurende 1500 ms (HLC-saccade en HLC onzekere taken) of 1000 ms (HLC-verkenningstaak), en daarna verscheen het fixatiedoel gedurende 500 ms. Omdat het fixatievenster 400 ms na de presentatie van het fixatiepunt werd geactiveerd, moesten de apen tijdens de LC-proeven gedurende ten minste 100 ms op het doelwit fixeren. De apen vertoonden meer fouten in de HC-proef; daarom werd een geforceerde abort 100 ms willekeurig ingevoegd voor de presentatie van de beloningskeu (400 ms na de presentatie van het fixatiedoel, wat de timing is van het begin van het fixatievenster) in de LC-trial om het succespercentage gelijk te trekken. Nadat ze zich op het doelwit hadden gefixeerd, werden een of twee beloningskenmerken gepresenteerd en moesten de apen naar de keu saccaden. Als ze met succes een saccade maakten voor de beloningskeu, werd er een pieptoon afgegeven 750 ms na de presentatie van de beloningskeu. Toen de apen een saccade maakten voor de R + cue, werd 0.3 ml water tegelijk met de piep afgegeven. Er werd geen beloning gegeven toen ze een saccade maakten voor de R-cue.

In de HLC-saccadetaak werden vier gekleurde cirkels gebruikt als beloningscues (RHC+: geel; RHC-: groen; RLC+: roze; RLC-: blauw; Fig. 1a Een experimentele sessie bestond uit 80 saccadeproeven, 20 onvoorspelbare beloningsproeven, 20 onvoorspelbare luchtpuff-proeven en 5 keuzeproeven. De saccade-onderzoeken omvatten 40 HC-onderzoeken en 40 LC-onderzoeken, die beide 20 beloningsonderzoeken en 20 geen beloningsonderzoeken omvatten. In de onvoorspelbare beloning of luchtpufproeven werd 0.3 ml waterbeloning of 0.2 MPa luchtpuf (150 ms voor aap P; 200 ms voor aap S) aan het gezicht van de apen afgegeven zonder te worden gecued. De keuzeonderzoeken omvatten een proef waarbij apen een keuze maakten tussen R + cues (RHC+ versus RLC+) in de HC-proef, tussen R-signalen (RHC- versus RLC-) in de HC-proef, tussen R + (RHC+ versus RLC+) signalen in LC-proef, tussen R− (RHC- versus RLC-) signalen in LC-proef, en tussen de kostensignalen (aanvullend Fig. 1). In proeven met een keuze tussen beloningscues was de taakstructuur identiek aan de saccadetaak vóór beloningscues. Vervolgens werden in plaats van een beloning cue twee beloningscues gepresenteerd in de keuzeproeven en er werd geen beloning gegeven na beloning cue presentatie, zelfs als de apen de keuze maakten tussen R + cues.

Om de respons van dopamine-neuronen op afgifte te testen, voerden apen de onzekere HLC-taak uit (Fig. 5a). Deze taak was vergelijkbaar met de HLC-saccadetaak behalve de beloningscues. In deze taak hebben we twee beloningssignalen gebruikt (in plaats van de vier beloningssignalen die in de HLC-saccadetaak zijn gebruikt), één voor de HC-proef en de andere voor de LC-proef. De beloning werd na de presentatie van de beloningskeuze in de helft van de proeven geleverd. Een experimentele sessie bestond uit 80 saccade-proeven, 20 onvoorspelbare beloningsproeven en 20 onvoorspelbare air-puff-proeven. De saccade-proeven omvatten 40 HC-proeven en 40 LC-proeven, die beide 20 beloningsproeven en 20 geen beloningsproeven omvatten. In de onvoorspelbare proeven werd een beloning of luchtwolk geleverd zonder enig teken.

In de HLC-exploratietaak, twee beloningscues (RHC+, RHC- of RLC+, RLC-) werden tegelijkertijd gepresenteerd en de apen moesten zich saccaden naar een van de beloningscues (Fig. 7a). Als ze voor de R + cue kozen, kregen ze een waterbeloning. Vier beloningssignalen (RHC +, RHC-, RLC +, RLC-) werden gegenereerd voor elke verkenningssessie en de apen moesten proefondervindelijk de associatie tussen de signalen leren en belonen. Een experimentele sessie bestond uit 100 HC-proeven en 100 LC-proeven. We ontdekten dat voor de exploratietaak, als we de fixatieduur 2000 ms instellen in de HC-toestand zodat deze overeenkwam met de duur van de HC-toestand in de andere taken, de apen de taak met een zeer laag succespercentage hadden uitgevoerd, misschien vanwege de moeilijkheidsgraad van de taak en / of het daaruit voortvloeiende lage beloningspercentage. Daarom hebben we, om de moeilijkheden van de taak te verminderen en het succespercentage te verhogen, een 1500 ms fixatieduur gebruikt als kosten voor de HLC-exploratietaak.

De taken werden gecontroleerd met behulp van een commercieel verkrijgbaar softwarepakket (TEMPO, Reflective Computing, St. Louis, MO, VS). Een op maat gemaakt programma met een applicatie-programmeerinterface (OpenGL) werd gebruikt voor visuele stimuluspresentatie. De visuele prikkels voor de kosten en de beloningscues werden gecreëerd door de auteurs.

Opname en data-acquisitie

De locatie van de substantia nigra werd geschat met behulp van MR-afbeeldingen. Een met epoxy gecoate wolfraamelektrode (schachtdiameter, 0.25 mm, 0.5 – 1.5 MΩ gemeten bij 1000 Hz, FHC) werd in de substantia nigra ingebracht met behulp van een micromanipulator (MO-972, Narishige, Tokyo, Japan) gemonteerd op de opnamekamer met een roestvrijstalen geleidebuis. Spanningssignalen werden versterkt (× 10,000) en gefilterd (0.5 – 2 kHz). Actiepotentialen van een enkel neuron werden geïsoleerd met een template-matching algoritme (OmniPlex, Plexon, Dallas, TX, VS). Oogbewegingen werden gevolgd door een infraroodcamerasysteem met een bemonsteringssnelheid van 500 Hz (iView X Hi-Speed Primate, SMI, Teltow, Duitsland). De timing van actiepotentialen en gedragsgebeurtenissen werd opgenomen met een tijdresolutie van 1 kHz.

Data-analyse

Om het gedrag van de apen te analyseren, werden RT's bepaald als het tijdsinterval tussen het begin van de stimulus en het tijdstip waarop apen de saccade initieerden. De saccade-initiatie werd bepaald door de timing te berekenen wanneer de blikpositie 5 standaardafwijkingen van de gemiddelde blikpositie overschreed voorafgaand aan cue-presentatie.

In de HLC-exploratietaak werd het keuzegedrag van de apen gekwantificeerd door een cumulatieve exponentiële functie te passen. De functie (P) beschrijft het aandeel van de juiste keuze als volgt:

WAAR t betekent proces, a en b geef respectievelijk de helling en het plateau van de curve aan. Deze functie was onafhankelijk van de gegevens voor de twee kostenvoorwaarden aangepast. De parameters van de functie werden doorzocht om de waarschijnlijkheid van het observeren van de gegevens van een enkele sessie en de gemiddelde gegevens te maximaliseren. Een bootstrap-methode werd toegepast om de betrouwbaarheidsintervallen te schatten bij aanpassing aan de gemiddelde gegevens. Een standaard RL-model werd ook gebruikt om de gedragsgegevens te kwantificeren. De stimuluswaarden Vj(t) voor de geselecteerde keuze j (j = 1 voor HC-conditie; j = 2 voor LC-conditie) werden als volgt bijgewerkt:

WAAR αj geeft de leerpercentages aan, die werden beperkt tot waarden tussen 0 en 1. R(t) geeft het beloningsbedrag (1: beloond, 0: geen beloning) aan tijdens de proefperiode t.

De kans Pj(t) van het kiezen van stimulus j uit de twee stimuli tijdens het proces t wordt gegeven door de softmax-regel

WAAR βj geeft de omvang van de verkenning aan.

We hebben neuronale activiteit geregistreerd tijdens de HLC-saccade en de onzekere HLC-taak, maar niet de HLC-exploratietaak. De HLC-verkenningstaak werd uitgevoerd als een puur gedragsonderzoek. Dopamine-neuronen werden geïdentificeerd als ze elk van de volgende eigenschappen vertoonden: een lage tonische vuursnelheid (<6 Hz), een lange duur van de piekgolfvorm (> 300 μs) en een fasische reactie op de onvoorspelbare beloning (aanvullend Fig. 2a). We hebben proeven geanalyseerd waarin de apen de proef zonder fouten konden voltooien (remming, geen saccade of kunstmatige abortus). De gemiddelde snelheid van neuronen afvuren werd berekend met 1 ms bins en afgevlakt met een Gauss-kern (σ = 30 ms, breedte = 4σ) om spijkerdichtheidsfuncties te produceren. Reacties van de dopamine-neuronen op elke taakgebeurtenis werden berekend als de genormaliseerde vuursnelheid ten opzichte van de spontane activiteit (gemiddelde vuursnelheid tijdens de 500 ms vóór het begin van het startpunt). De vuursnelheid werd berekend binnen tijdvensters bepaald voor elke taakgebeurtenis en onderwerp. Deze tijdvensters werden bepaald op basis van de populatiegemiddelde activiteit. We definieerden de begin- en eindpunten van tijdvensters die waren bepaald op basis van de opkomst- en herfsttijd van de populatiegemiddelde respons met behulp van eerdere dopamine-onderzoeken met apen als referentie (aanvullende Fig. 3). Het tijdvenster voor de start-cue werd gedefinieerd als 200 – 400 ms na het begin van de cue voor neuronen opgenomen van apen P en S. Het tijdvenster voor de conditie-cue werd gedefinieerd als 150 – 300 ms na het begin van de cue voor aap P en 200 – 400 ms voor aap S. Het tijdvenster voor de beloningskeuze werd gedefinieerd als 140 – 350 ms na het begin van de beloningskeuze voor aap P en 220 – 420 ms voor aap S. Het tijdvenster voor de beloningslevering werd gedefinieerd als 225– 475 ms na het begin van de piep voor aap P en 200 – 450 ms voor aap S. Het tijdvenster voor de onvoorspelbare beloningslevering werd gedefinieerd als 100 – 300 ms na de beloningslevering voor aap P en 150 – 300 ms voor aap S. De tijdvenster voor de onvoorspelbare air-puff werd gedefinieerd als 30 – 230 ms na de afgifte van air-puff voor aap P en 50 – 200 ms voor aap S.

We hebben alle geregistreerde dopamine-neuronen ingedeeld in twee verschillende categorieën, motiverende waarde en saillantie-typen. Als de respons van een neuron op de luchtstootstimuli kleiner was dan de spontane activiteit, werd het neuron geclassificeerd als zijnde van het motivationele waardetype (Fig. 3d, e). Als daarentegen de respons van een neuron op de luchtwolkprikkels groter was dan de spontane activiteit, werd het neuron geclassificeerd als zijnde van het salience-type (Fig. 3g, h).

Om de differentiële neuronale activiteit tussen taakomstandigheden te kwantificeren, werd een ROC-analyse uitgevoerd. We hebben de auROC voor elk neuron berekend. De auROC kleiner of groter dan 0.5 duidt respectievelijk op een kleinere of grotere respons in de HC-studie. Omdat het aantal neuronen in sommige neuronale gegevenssets klein was, gebruikten we Wilcoxons gesigneerde rangorde-test om het effect van de uitschieters voor het kwantificeren van de vertekende verdeling van de auROC's te verminderen.

Commercieel beschikbare software, MATLAB (MathWorks, Natick, MA, VS), werd gebruikt om alle gegevensanalyses uit te voeren.

Histologisch onderzoek

Na het opname-experiment werden beide apen geëuthanaseerd en werd histologische analyse uitgevoerd om de opname-positie te verifiëren (aanvullende Fig. 2b). Apen werden geëuthanaseerd door toediening van een dodelijke dosis pentobarbital natrium (70 mg kg-1) en geperfuseerd met 4% formaldehyde in fosfaatbuffer. Seriële coronale secties (dikte, 10 μm) werden gesneden en immunologisch gekleurd met anti-tyrosine hydroxylase (TH) antilichaam (elke 25 secties; anti-TH antilichaam, 1: 500; Merck, Darmstadt, Duitsland) of Nissl kleuring (elke 25 secties) .

Rapportage samenvatting

Nadere informatie over onderzoeksontwerp is beschikbaar in de Nature Research Reporting Summary gekoppeld aan dit artikel.

Beschikbaarheid van data

De gegevens die bij de analyse van dit onderzoek zijn gebruikt, zijn op redelijk verzoek verkrijgbaar bij de desbetreffende auteur. Een rapportageoverzicht voor dit artikel is beschikbaar als een aanvullend informatiebestand. De brongegevens die ten grondslag liggen aan Fig. 1, 3-8 en aanvullende fign. 1, 4-12 worden geleverd als brongegevensbestand.

Code beschikbaarheid

Matlab-codes die bij de analyse van dit onderzoek zijn gebruikt, zijn op redelijk verzoek verkrijgbaar bij de overeenkomstige auteur.

Referenties

- 1.

Clement, TS, Feltus, JR, Kaiser, DH & Zentall, TR "Werkethiek" bij duiven: de beloningswaarde is direct gerelateerd aan de inspanning of tijd die nodig is om de beloning te verkrijgen. Psychon. Bull. Rev. 7, 100â € "106 (2000).

- 2.

Klein, ED, Bhatt, RS & Zentall, TR Contrast en de rechtvaardiging van inspanning. Psychon. Bull. Rev. 12, 335â € "339 (2005).

- 3.

Zentall, TR & Singer, RA Contrast binnen de proef: duiven geven de voorkeur aan geconditioneerde bekrachtigers die een relatief meer dan een minder aversieve gebeurtenis volgen. J. Exp. Anaal. Behav. 88, 131â € "149 (2007).

- 4.

Aronson, E. & Mills, J. Het effect van de ernst van de initiatie op de voorliefde voor een groep. J. Abnorm. Soc. Psychol. 59, 177â € "181 (1959).

- 5.

Festinger, L. Een theorie van cognitieve dissonantie. (Stanford University Press, Californië, 1957).

- 6.

Alessandri, J., Darcheville, JC, Delevoye-Turrell, Y. & Zentall, TR Voorkeur voor beloningen die volgen op meer inspanning en meer vertraging. Leer gedrag. 36, 352â € "358 (2008).

- 7.

Schultz, W., Carelli, RM & Wightman, RM Fasische dopaminesignalen: van subjectieve beloningswaarde tot formeel economisch nut. Curr. Opin. Behav. Sci. 5, 147â € "154 (2015).

- 8.

Schultz, W., Dayan, P. & Montague, PR Een neuraal substraat van voorspelling en beloning. Wetenschap 275, 1593â € "1599 (1997).

- 9.

Bromberg-Martin, ES, Matsumoto, M. & Hikosaka, O. Dopamine in motiverende controle: belonend, aversief en alert. Neuron 68, 815â € "834 (2010).

- 10.

Bayer, HM & Glimcher, PW Midbrain dopamine-neuronen coderen voor een kwantitatief foutsignaal voor het voorspellen van de beloning. Neuron 47, 129â € "141 (2005).

- 11.

Nakahara, H., Itoh, H., Kawagoe, R., Takikawa, Y. & Hikosaka, O.Dopamine-neuronen kunnen een contextafhankelijke voorspellingsfout vertegenwoordigen. Neuron 41, 269â € "280 (2004).

- 12.

Tobler, PN, Fiorillo, CD & Schultz, W. Adaptieve codering van beloningswaarde door dopamine-neuronen. Wetenschap 307, 1642â € "1645 (2005).

- 13.

Nomoto, K., Schultz, W., Watanabe, T. & Sakagami, M.Tijdelijk verlengde dopamine-reacties op perceptueel veeleisende beloningsvoorspellende stimuli. J. Neurosci. 30, 10692â € "10702 (2010).

- 14.

Watabe-Uchida, M., Zhu, L., Ogawa, SK, Vamanrao, A. & Uchida, N. In kaart brengen van het hele brein van directe inputs naar dopamine-neuronen in de middenhersenen. Neuron 74, 858â € "873 (2012).

- 15.

Tanaka, SC et al. Voorspelling van onmiddellijke en toekomstige beloningen werpt differentieel cortico-basale ganglia-lussen op. Nat. Neurosci. 7, 887â € "893 (2004).

- 16.

Haber, SN, Kim, KS, Mailly, P. & Calzavara, R.Beloningsgerelateerde corticale inputs definiëren een groot striataal gebied bij primaten dat een interface vormt met associatieve corticale verbindingen, en biedt een substraat voor op stimulansen gebaseerd leren. J. Neurosci. 26, 8368â € "8376 (2006).

- 17.

Doya, K. Modulatoren van besluitvorming. Nat. Neurosci. 11, 410â € "416 (2008).

- 18.

Roesch, MR, Calu, DJ & Schoenbaum, G. Dopamine-neuronen coderen voor de betere optie bij ratten die beslissen tussen beloningen met een verschillende vertraging of een beloning. Nat. Neurosci. 10, 1615â € "1624 (2007).

- 19.

Lak, A., Stauffer, WR & Schultz, W. Dopamine-voorspellingsfoutresponsen integreren subjectieve waarde uit verschillende beloningsdimensies. Proc. Natl Acad. Sci. Verenigde Staten van Amerika 111, 2343â € "2348 (2014).

- 20.

Stauffer, WR, Lak, A. & Schultz, W. Dopamine-beloningsvoorspellingsfouten weerspiegelen marginaal nut. Curr. Biol. 24, 2491â € "2500 (2014).

- 21.

Noritake, A., Ninomiya, T. & Isoda, M. Monitoring en waardering van sociale beloningen in het brein van makaken. Nat. Neurosci. 21, 1452â € "1462 (2018).

- 22.

Pasquereau, B. & Turner, RS Beperkte codering van inspanning door dopamine-neuronen in een afweging tussen kosten en baten. J. Neurosci. 33, 8288â € "8300 (2013).

- 23.

Varazzani, C., San-Galli, A., Gilardeau, S. & Bouret, S. Noradrenaline en dopamine-neuronen in de afweging tussen beloning en inspanning: een directe elektrofysiologische vergelijking bij zich gedragen apen. J. Neurosci. 20, 7866â € "7877 (2015).

- 24.

Watanabe, N., Sakagami, M. & Haruno, M.Beloningsvoorspellingsfoutsignaal versterkt door striatum-amygdala-interactie verklaart de versnelling van het leren van probabilistische beloningen door emotie. J. Neurosci. 33, 4487â € "4493 (2013).

- 25.

Di Ciano, P., Cardinal, RN, Cowell, RA, Little, SJ & Everitt, B.Differentiële betrokkenheid van NMDA-, AMPA / kainaat- en dopaminereceptoren in de nucleus accumbens-kern bij het verwerven en uitvoeren van Pavloviaans naderingsgedrag. J. Neurosci. 21, 9471â € "9477 (2001).

- 26.

Flagel, SB et al. Een selectieve rol voor dopamine bij het leren van stimulusbeloningen. NATUUR 469, 53â € "57 (2011).

- 27.

Blough, DS Effecten van priming, onderscheidbaarheid en versterking op reactietijdcomponenten van visueel zoeken van duiven. J. Exp. Psychol. Anim. Behav. Werkwijze. 26, 50â € "63 (2000).

- 28.

Matsumoto, M. & Hikosaka, O. Twee soorten dopamine-neuronen brengen duidelijk positieve en negatieve motivatiesignalen over. NATUUR 459, 837â € "841 (2009).

- 29.

Matsumoto, M. & Takada, M.Duidelijke representaties van cognitieve en motiverende signalen in dopamine-neuronen van de middenhersenen. Neuron 79, 1011â € "1024 (2013).

- 30.

Watanabe, M. et al. Gedragsreacties als gevolg van verschillende beloningsverwachtingen bij apen. Exp. Brain Res. 140, 511â € "518 (2001).

- 31.

Takikawa, Y., Kawagoe, R. & Hikosaka, O.Een mogelijke rol van dopamine-neuronen in de middenhersenen bij de korte en lange termijn aanpassing van saccades aan het in kaart brengen van positie-beloningen. J. Neurophysiol. 92, 2520â € "2529 (2004).

- 32.

Kobayashi, S. & Schultz, W. Invloed van beloningsvertragingen op reacties van dopamine-neuronen. J. Neurosci. 28, 7837â € "7846 (2008).

- 33.

Enomoto, K. et al. Dopamine-neuronen leren de langetermijnwaarde van meerdere toekomstige beloningen te coderen. Proc. Natl Acad. Sci. Verenigde Staten van Amerika 108, 15462â € "15467 (2011).

- 34.

Lak, A., Nomoto, K., Keramati, M., Sakagami, M. & Kepecs, A.Midbrain Dopamine-neuronen signaleren geloof in de nauwkeurigheid van keuzes tijdens een perceptuele beslissing. Curr. Biol. 27, 821â € "832 (2017).

- 35.

Williams, BA & McDevitt, MA Remming en superconditionering. Psychol. Sci. 13, 454â € "459 (2002).

- 36.

Behrens, TE, Woolrich, MW, Walton, ME & Rushworth, MF De waarde van informatie leren kennen in een onzekere wereld. Nat. Neurosci. 10, 1214â € "1221 (2007).

- 37.

Seymour, B. et al. Tegenstander smakelijk-aversieve neurale processen liggen ten grondslag aan voorspellend leren van pijnverlichting. Nat. Neurosci. 8, 1234â € "1240 (2005).

- 38.

Kim, H., Shimojo, S. & O'Doherty, JP Is het vermijden van een aversieve uitkomst lonend? Neurale substraten van vermijdingsleren in het menselijk brein. PLoS Biol. 4, e233 (2006).

- 39.

Syed, EC et al. Actie-initiatie vormt mesolimbische dopamine-codering van toekomstige beloningen. Nat. Neurosci. 19, 34â € "36 (2016).

Danksagung

Dit werk werd ondersteund door MEXT / JSPS Subsidies voor wetenschappelijk onderzoek (Kakenhi) Grant-nummers JP16H06571 en JP18H03662 voor MS Dit onderzoek werd gedeeltelijk ondersteund door het Strategisch onderzoeksprogramma voor hersenwetenschappen ondersteund door Japan Agency for Medical Research and Development (AMED ) en het Japan-US Brain Research Cooperation Program. Dit onderzoek werd ondersteund door het National Bio-Resource Project van het National Institute of Physiological Science (NBRP bij NIPS) van Japan Agency for Medical Research and Development, AMED. We danken Bernard W. Balleine en Andrew R. Delamater voor hun hulp bij het schrijven van de paper.