Nature Communications

Tom 10, Numer artykułu: 3674 (2019)

Abstrakcyjny

Wiadomo, że neurony dopaminy śródmózgowia kodują błędy przewidywania nagrody (RPE) wykorzystywane do aktualizacji prognoz wartości. Tutaj badamy, czy sygnały RPE kodowane przez neurony dopaminy śródmózgowia są modulowane kosztem zapłaconym za uzyskanie nagród, poprzez rejestrację z neuronów dopaminy u obudzonych zachowujących się małp podczas wykonywania trudnego zadania sakkady. Odpowiedzi neuronu dopaminowego na wskazówki przewidujące nagrodę i na dostarczenie nagrody wzrosły po wykonaniu kosztownego działania w porównaniu do mniej kosztownego działania, co sugeruje, że RPE są zwiększone po wykonaniu kosztownego działania. Na poziomie behawioralnym skojarzenia bodźców i nagród są uczone szybciej po wykonaniu kosztownego działania w porównaniu do mniej kosztownego działania. Zatem informacje o koszcie działania są przetwarzane w systemie nagrody dopaminy w sposób, który wzmacnia następujący sygnał dopaminy RPE, co z kolei sprzyja szybszemu uczeniu się w sytuacjach wysokiego kosztu.

Wprowadzenie

Ludzie i zwierzęta wolą nagrodę otrzymaną po wysiłku, aby ją zdobyć, w porównaniu z tą samą nagrodą po mniejszym wysiłku1,2,3. Przedstawiono wiele wyjaśnień tego efektu, takich jak uzasadnienie wysiłku4,5 i efekt kontrastu6, w którym większą wartość przypisuje się wynikowi uzyskanemu po opłaconym wysiłku. Pozostaje jednak niejasne, czy i jak przetwarzanie informacji o nagrodzie w mózgu jest modulowane przez wysiłek włożony w uzyskanie nagrody.

Skoncentrowaliśmy się szczególnie na układzie dopaminy śródmózgowia, biorąc pod uwagę rolę tego systemu w promowaniu adaptacji behawioralnej do nagród7,8,9. Wiadomo, że neurony dopaminy reprezentują sygnały błędu przewidywania nagrody (RPE), które mogą ułatwić naukę przewidywania nagrody przez zwoje podstawy mózgu10,11,12,13,14,15,16,17. Siła RPE zależy od ilości, jakości oraz subiektywnej wartości lub użyteczności nagrody7,18,19,20,21. Ponadto aktywność dopaminergiczna jest modulowana przez koszty i / lub wysiłek22,23. Na tej podstawie postulowaliśmy, że dopaminergiczny sygnał RPE będzie bezpośrednio modulowany przez koszt zapłacony za uzyskanie nagrody. Ponadto, ponieważ sygnał RPE jest przyczynowo zaangażowany w pośredniczenie w nauce związków bodźców i nagród24,25,26, wysunęliśmy hipotezę, że koszt zapłacony za uzyskanie nagrody bezpośrednio zwiększyłby szybkość uczenia się skojarzeń bodziec-nagroda.

Aby przetestować nasze hipotezy, zmierzyliśmy zarówno zachowanie, jak i aktywność dopaminergiczną u dwóch japońskich małp podczas wykonywania zadania wysiłkowego opartego na sakadzie. Małpy reagują szybciej na wskazówkę dotyczącą nagrody, która jest prezentowana po akcji o wysokim koszcie (HC) w porównaniu z tą po akcji o niskim koszcie (LC). Aktywność neuronów dopaminergicznych w stosunku do wskazówek przewidujących nagrody jest zwiększana o opłacony koszt. Dodatkowo, szybkość uczenia się do powiązania bodziec-nagroda jest również zwiększona przez opłacony koszt. Dlatego sugerujemy, że koszt zapłacony za uzyskanie nagród zwiększa sygnał RPE w neuronach dopaminy, a tym samym wzmacnia skojarzenia bodziec-nagroda.

Efekt

Zadanie sakralne o wysokim i niskim koszcie (HLC)

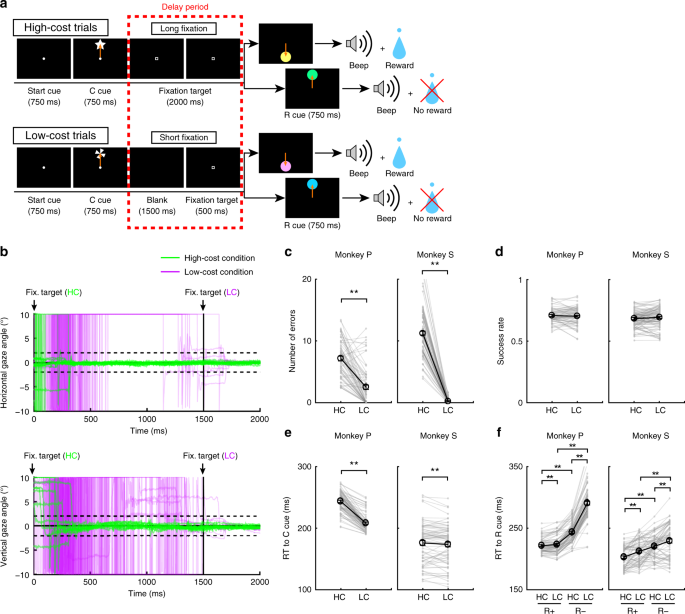

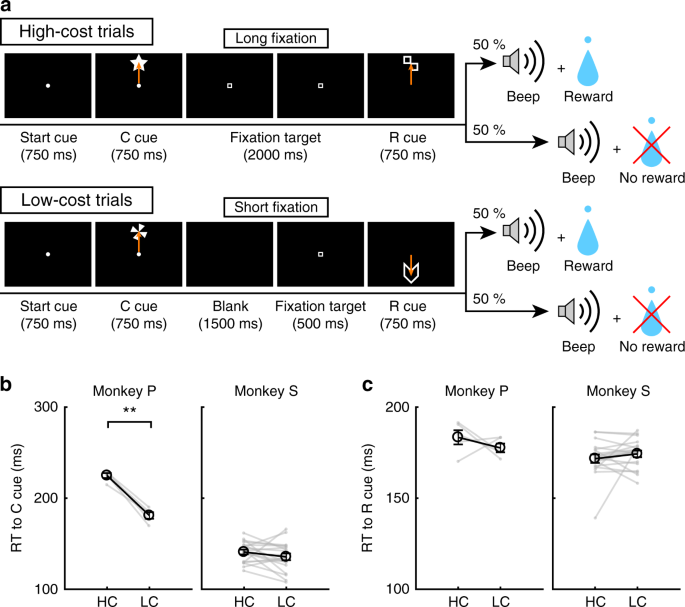

Aby zbadać wpływ opłaconego kosztu na zachowanie i aktywność neuronu dopaminowego, małpy wykonały zadanie sakkadowe z dwoma warunkami kosztowymi (ryc. 1a, patrz Metody). W próbach HC małpy szybko wykonały sakadę do celu i patrzyły na nią bez mrugnięcia przez dłuższy czas (ryc. 1b; zielone linie). Natomiast w próbach LC małpy najpierw rozglądały się swobodnie przed fiksacją przez krótszy okres (ryc. 1b, fioletowe linie). Ponieważ utrzymywanie długiej fiksacji jest trudne dla małp, popełniły one więcej błędów podczas opóźnień na próbach HC (ryc. 1c). Aby kontrolować wynikającą z tego różnicę w prawdopodobieństwie nagrody między próbami HC i próbami LC, umieściliśmy wymuszone przerwanie w części prób LC, aby wyrównać szanse powodzenia i prawdopodobieństwo nagradzania między typami prób (ryc. 1d).

Zadanie HLC Saccade. a Zadanie sakkadowe HLC. Wskazówki dotyczące kosztu (cue) sygnalizowały ilość wysiłku, jaki był wymagany do osiągnięcia potencjalnej nagrody. W kosztownych próbach wymagane było długie utrwalanie w okresie opóźnienia. Wskazówka dotycząca nagrody (r cue) wskazuje, czy małpy mogą otrzymać nagrodę, czy nie. b Przebieg czasu kąta spojrzenia w okresie opóźnienia. Górny i dolny panel pokazują odpowiednio poziomy i pionowy kąt patrzenia. Zielone i fioletowe linie wskazują odpowiednio kąt patrzenia w kosztownych próbach (próby 50 na każdym panelu) i odpowiednio w próbach tanich (próby 50 na każdym panelu). c Liczba błędów w okresie opóźnienia w badaniach o wysokich i niskich kosztach (**P < 0.01; dwustronny sparowany t test; t67 = 8.8, P = 4.8 × 10-15, n = 68 dla Monkey P; t83 = 26.6, P ≈ 0, n = 84 dla Monkey S). Czarne kółka i słupki błędów wskazują średnią i SEM. d Wskaźniki sukcesu w testach o wysokich i niskich kosztach (w parach dwustronnych) t test; t67 = 0.51, P = 0.61, n = 68 dla Monkey P; t83 = 0.79, P = 0.43, n = 84 dla Monkey S). e RT do wskaźników kosztów (**P <0.01; dwustronny sparowany t test; t67 = 20.4, P ≈ 0, n = 68 dla Monkey P; t69 = 2.0, P = 1.2 × 10-3, n = 70 dla Monkey S). f RT do wskazówek dotyczących nagrody (**P <0.01; dwustronny sparowany t test; Monkey P (n = 68): HC + kontra LC +, t67 = 3.5, P = 9.2 × 10-4; HC− vs. LC−, t67 = 24.5, P ≈ 0; HC + kontra HC−, t67 = 21.6, P ≈ 0; LC + kontra LC−, t67 = 28.5, P ≈ 0; Małpa S (n = 70): HC + kontra LC +, t69 = 5.6, P = 4.4 × 10-7; HC− vs. LC−, t69 = 4.8, P = 8.4 × 10-5; HC + vs. HC−, t69 = 18.0, P ≈ 0; LC + kontra LC−, t69 = 5.9, P = 1.1 × 10-7)

Płatny koszt zwiększa wartość wskazówek przewidujących nagrody

Aby uzyskać dorozumiany dowód na różnicę w subiektywnej ocenie sygnałów przez małpę, przetestowaliśmy czasy reakcji małp (RT). W szczególności spodziewaliśmy się, że jeśli małpy przypiszą wyższą wartość subiektywną jednej opcji niż drugiej, powinny pokazać szybsze RT dla opcji o większej wartości.27. Kiedy RT porównano między wskaźnikami kosztu, obie małpy wykazały szybsze RT do LC w porównaniu do wskaźnika HC (ryc. 1e), wykazując domyślną preferencję dla warunku LC. Kiedy RT porównywane były między wskazówkami nagrody, obie małpy wykazywały szybsze RT, aby nagradzać wskazówki (R +) niż brak wskazówek (R−) 1f), co wskazuje, że woleli sygnały R + niż R-cues. Ponadto obie małpy wykazywały szybsze RT do R.HC+ cue w porównaniu z R.LC+ cue i do R.HC- cue w porównaniu z R.LC- wskazówka (ryc. 1f), co wskazuje, że bardziej cenili wskazówki przewidujące nagrody w HC niż w warunku LC.

Ponadto włączyliśmy próby wyboru do zadania sakramentu HLC w celu przetestowania jawnych preferencji małp między wskazówkami (rysunek uzupełniający. 1a). Małpy preferencyjnie wybrały wskaźnik LC, wybierając między wskaźnikami kosztów (rysunek uzupełniający. 1b). Monkey S preferencyjnie wybrał R.HC+ cue podczas wykonywania zadania wyboru między R.HC+ i RLC+ wskazówka, ale brak preferencji między R.HC- i R.LC- wskazówki (rys. Uzupełniający 1c, d). Natomiast małpa P nie wykazywała jawnej preferencji między R.HC+ i RLC+ wskazówki, ale mimo to wolał RHC- cue przy wyborze pomiędzy R.HC- i R.LC- wskazówki (rys. Uzupełniający 1c, d).

Wyniki elektrofizjologiczne w zadaniu sakramentalnym HLC

Rejestrowaliśmy aktywność pojedynczej jednostki z neuronów znajdujących się w obrębie istoty czarnej pars compacta (SNc) i brzusznej okolicy nakrywkowej (VTA) podczas zadania sakkady HLC. Zidentyfikowaliśmy neurony dopaminowe 70 u dwóch małp (rysunek uzupełniający. 2a; 18 i neurony 52 odpowiednio z Monkey P i S.). Badanie histologiczne potwierdziło, że neurony były zlokalizowane w SNc / VTA lub wokół niego (rysunek uzupełniający. 2b).

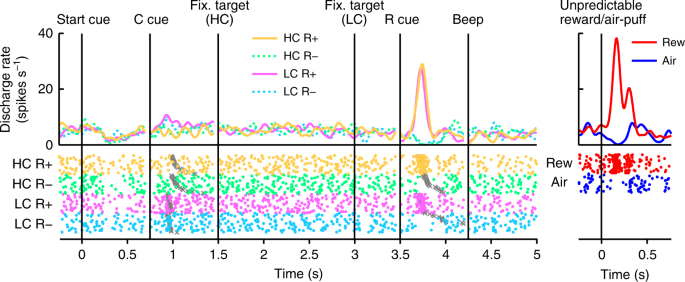

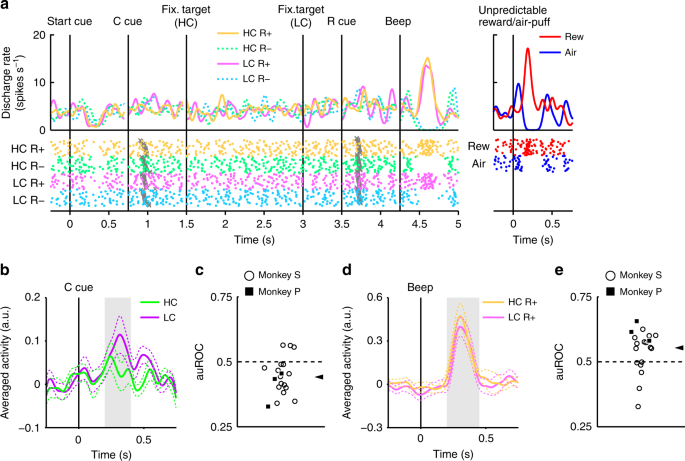

Na ryc. 2, pokazujemy aktywność reprezentatywnego neuronu dopaminy. Neuron ten wykazywał niewielką aktywację do wskaźnika LC oraz fazową aktywację lub supresję do nagrody (RHC+ i RLC+) lub brak wskazówek dotyczących nagrody (RHC- i R.LC-) odpowiednio (ryc. 2, Rysunek uzupełniający 3). Neuron wykazywał także fazową aktywację nieprzewidywalnej nagrody, a także fazową supresję w odpowiedzi na bodziec awersyjny, nieprzewidywalny wdech (ryc. 2, prawy panel). Ponadto neuron wykazywał niewielką supresję do sygnału początkowego, ale nie reagował na dostarczenie nagrody. Cała populacja zarejestrowanych przez nas neuronów dopaminowych wykazywała podobne odpowiedzi na początkową wskazówkę i dostarczenie nagrody (uzupełniające ryc. 4a, b). W zadaniu Saccade HLC zapłacono koszt wysiłku przed uzyskaniem nagrody. Ponieważ przewidywany koszt obniżył aktywność neuronu dopaminowego22,23, odpowiedzi neuronu dopaminowego byłyby tłumione w momencie rozpoczęcia prezentacji wskazówki16.

Aktywność reprezentatywnego neuronu dopaminy w zadaniu parady HLC. Funkcje gęstości skoków (złożone z funkcją Gaussa) i wykresy rastrowe są wyrównane z początkowym czasem początkowej wskazówki, wskazówką kosztu (wskazówką C), celem fiksacji, wskazówką nagrody (wskazówką R) i sygnałem dźwiękowym. Każdy kolor reprezentuje warunek (odpowiednio żółty: HC +, zielony: HC−, różowy: LC +, cyjan: LC−). Czasy rozpoczęcia sakkady są oznaczone szarymi krzyżami. Odpowiedzi neuronów dopaminowych na nieprzewidywalną nagrodę lub wdech są również reprezentowane na prawym panelu (czerwony: nieprzewidywalna nagroda, niebieski: nieprzewidywalne zaciągnięcie)

Neurony dopaminy kodują informacje dotyczące zarówno nagrody, jak i kosztu

Neurony reagowały fazowo na sygnał LC, ale mniej niezawodnie na sygnał HC (ryc. 3a, b). Wywołane odpowiedzi na sygnały warunku kosztu wykazywały mniejszą odpowiedź na sygnał HC niż wskaźnik LC (dwustronny test rang Wilcoxona, P <3.2 × 10-4, n = 70). Oceniliśmy ilościowo wpływ przewidywanego kosztu na odpowiedzi neuronalne za pomocą analizy charakterystyki operacyjnej odbiornika (ROC). Rozkład powierzchni pod krzywą ROC (auROC) był istotnie <0.5 (ryc. 3c; dwustronny test Wilcoxona z podpisaną rangą; P = 5.4 × 10-4, n = 70), co wskazuje, że odpowiedzi wskazówki HC były mniejsze niż odpowiedzi LC. Wcześniej stwierdzono, że przewidywany koszt zmniejsza aktywność neuronów dopaminowych, co jest zgodne z naszymi wynikami22,23. Ponadto populacja neuronów dopaminowych wykazywała znaczącą aktywację do wskaźnika LC, nie wykazując przy tym znaczącej supresji do sygnałów HC (Uzupełnienie ryc. 4c, d). Wyniki te sugerują, że neurony dopaminy kodują i integrują informacje dotyczące zarówno nagrody, jak i kosztu w momencie prezentacji wskaźnika kosztu.

Reakcje neuronów dopaminowych na wskaźniki kosztów. a Reprezentatywna odpowiedź neuronu dopaminowego na wskazówki dotyczące kosztów. Funkcje gęstości kolców obliczono ze znormalizowanej aktywności neuronu dopaminy zarejestrowanej u małpy P. Kolorowe linie wskazują funkcje gęstości impulsów, a kolorowe kropki wskazują czas spajania. Kolory zielony i fioletowy wskazują na aktywność odpowiednio w kosztownych i niedrogich próbach. Linia pionowa wskazuje czas prezentacji wskazówek dotyczących kosztów. Obszar w kolorze szarym wskazuje okres, w którym należy obliczyć szybkość wypalania, jako odpowiedź na wskazówki dotyczące warunków. b Uśredniona dla populacji aktywność neuronów dopaminowych zarejestrowana od małpy P do sygnałów warunkujących. Linie ciągłe linie przerywane reprezentują odpowiednio średnią i SEM. c Rozkład obszarów pod ROCs w celu oszacowania wpływu przewidywanego kosztu na odpowiedź neuronalną na wskaźnik kosztów. Wypełnione kwadraty i puste kółka wskazują odpowiednio dane z małpy P i S. Grot strzałki wskazuje medianę auROC (0.47). d, g Reprezentatywne odpowiedzi typu neuronu dopaminowego o wartości motywacyjnej (d) lub neuron dopaminy typu salience (g) na nieprzewidywalną nagrodę lub dmuchanie powietrza. Czerwone i niebieskie krzywe wskazują odpowiednio reakcję na nieprzewidywalną nagrodę i nieprzewidywalny wdech. Linia pionowa wskazuje czas nieprzewidzianej nagrody lub dostawy powietrza. Bladoczerwone i niebieskie kwadraty wskazują okres, w którym należy obliczyć szybkostrzelność jako odpowiedź na nieprzewidzianą nagrodę lub dmuchanie powietrza. e, h Uśredniona dla populacji aktywność neuronów dopaminowych typu motywacyjnego (e) lub neuronów dopaminy typu salience (h) na nieprzewidywalną nagrodę lub dmuchanie powietrza. f, i Rozkład auROC obliczony na podstawie neuronów dopaminy typu wartości motywacyjnej (f) lub neuronów dopaminy typu salience (i). Groty strzałek wskazują mediany auROC (f 0.48; i 0.46)

Wcześniej opisano dwa różne podtypy neuronów dopaminowych: wartość motywacyjną i neurony istotności28,29. Znaleźliśmy dowody w naszej populacji neuronów dopaminowych na wzorce odpowiedzi zgodne z oboma podtypami. Neurony typu wartości wykazywały fazowe tłumienie awersyjnych bodźców powietrznych (ryc. 3d, e). Natomiast neurony salience wykazywały fazową aktywację bodźców awersyjnych (ryc. 3g, godz). Długie utrwalenie w próbie HC jest również nieprzyjemne i awersyjne; dlatego możliwe jest, że dwa podtypy neuronu dopaminowego wykażą różne wzorce odpowiedzi na sygnały warunku kosztu. Jeśli neurony dopaminy reprezentują bodźce awersyjne i kosztują w podobny sposób, to neurony wartości powinny wykazywać zmniejszoną aktywność w stosunku do wskazówki HC z powodu swojej awersji. Z drugiej strony neurony salience powinny zwiększać aktywność w stosunku do wskazówki HC, ponieważ zwiększają się również do nieprzyjemnych bodźców. Jednak wywołane odpowiedzi obu typów neuronów były mniejsze niż wskaźnik HC w porównaniu z sygnałem LC (dwustronny test rang Wilcoxona; P = 0.021, n = 41 i P = 0.0044, n = 29 odpowiednio dla wartości i typów istotności), a analiza ROC wykazała mniejsze odpowiedzi na HC w porównaniu z wskaźnikiem LC w obu podtypach (ryc. 3f, i; dwustronny test Wilcoxona z podpisaną rangą; P = 0.030, n = 41 i P = 0.0058, n = 29 odpowiednio dla typów wartości i istotności). W związku z tym przewidziano zmniejszenie kosztów aktywności obu podtypów neuronów dopaminowych. Wyniki te wskazują, że informacje o kosztach są przetwarzane przez neurony dopaminowe w jakościowo inny sposób niż bodźce awersyjne.

W zadaniu sakkadowym HLC wstawiliśmy wymuszone przerwanie w części prób LC, aby wyrównać wskaźniki sukcesu i prawdopodobieństwo nagrody między typami prób. Ta manipulacja zwiększyła niepewność uzyskania nagrody lub ryzyko braku nagrody w warunku LC. Dlatego wyższa aktywność neuronów dopaminowych i zwiększona wycena małp dla LC w stosunku do HC może wynikać z różnicy w ryzyku lub niepewności między warunkami kosztowymi. Jednak nie znaleźliśmy związku między liczbą wymuszonych poronień a różnicą w RT (uzupełniający ryc. 5a, b) i znaleźliśmy pozytywną korelację między liczbą przymusowych przerw a auROC (rys. uzupełniający. 5c). Porównaliśmy również odpowiedzi dopaminy na wskaźniki kosztów po przerwaniu leczenia po prawidłowych próbach, ale nie znaleźliśmy żadnej różnicy w obu warunkach kosztów (rysunek uzupełniający. 5d). Wyniki te wskazują, że liczba wymuszonych przerw w stanie LC nie tłumaczy ani wzrostu wyceny, ani zwiększonej aktywacji dopaminergicznej do wskaźnika LC.

Zwiększona odpowiedź dopaminy na nagradzanie za pomocą opłaconego kosztu

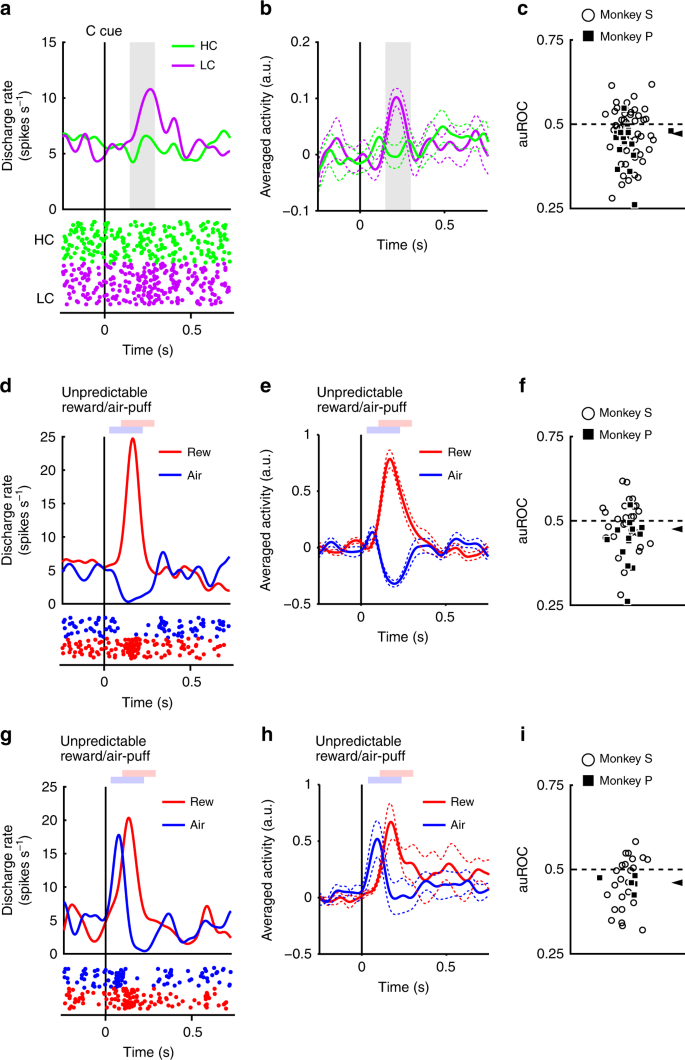

Stwierdzono, że zarejestrowane neurony dopaminy wykazują fazową aktywację i supresję w celu nagradzania i bez wskazówek przewidujących nagrody (ryc. 2). Następnie oceniliśmy, czy odpowiedzi te były modulowane przez wcześniej poniesione koszty. Przykład reprezentatywnego neuronu i neuronów uśrednionych w populacji wykazujących większą aktywację do R.HC+ cue niż R.LC+ cue pokazano na rysunku Odpowiednio 4a i b. (dwustronny test rang ze znakiem Wilcoxona; P = 7.4 × 10-5, n = 70). Rozkład auROC był> 0.5, co wskazuje, że odpowiedź na R.HC+ wskazówka była większa niż w R.LC+ wskazówka (ryc. 4c; dwustronny test Wilcoxona z podpisaną rangą; P = 1.4 × 10-4, n = 70). Wyniki te wskazują, że odpowiedź na wskazówkę przewidującą nagrodę w stanie HC jest znacznie większa niż w warunku LC. Dlatego nasze odkrycia sugerują, że dodatni sygnał RPE reprezentowany przez neurony dopaminowe jest zwiększony o wcześniej poniesiony koszt.

Reakcje neuronów dopaminowych na wskazówki nagradzające. a Przykładowa odpowiedź neuronu na sygnały R +. Funkcje gęstości skoków obliczono na podstawie aktywności neuronu dopaminowego zarejestrowanej od małpy P. Kolorowe linie i kropki wskazują odpowiednio gęstość impulsów i czas impulsowania. Żółte i różowe kolory wskazują odpowiednio aktywność w kosztownych i niskich kosztach prób. Linia pionowa wskazuje czas prezentacji R + cue. Szary obszar wskazuje okres do obliczenia szybkości strzału jako odpowiedź na wskazówki nagrody. b Uśredniona w populacji aktywność neuronów dopaminy zarejestrowana od małpy P do sygnałów R +. Linie ciągłe i linie przerywane przedstawiają odpowiednio średnią i SEM. c Rozkład auROC w celu oszacowania wpływu opłaconego kosztu na odpowiedź neuronalną na sygnały R +. Wypełnione kwadraty i puste kółka wskazują odpowiednio dane z małpy P i S. Grot strzałki wskazuje medianę auROC (0.53). d Reprezentatywna odpowiedź na R-cue. Kolory zielony i cyjan wskazują odpowiednio na kosztowne i tanie testy. Linia pionowa wskazuje czas prezentacji R-cue. e Uśredniona dla populacji aktywność neuronów dopaminowych zarejestrowana od małpy P do R-cue. f Rozkład auROC w celu oszacowania wpływu opłaconego kosztu na odpowiedź neuronów na R-cue. Grot strzałki wskazuje medianę auROC (0.50)

Neurony dopaminy wykazywały również fazową supresję do R-cue (ryc. 4d, e). Jednak odpowiedzi neuronów dopaminowych na R-cue nie wykazały znaczącej różnicy w funkcji poniesionych kosztów (dwustronny test rang Wilcoxona; P = 0.25, n = 70), a analiza ROC nie ujawniła żadnych dowodów na błąd w rozkładzie odpowiedzi (ryc. 4f; Test rang Wilcoxona, P = 0.35; n = 70). Zatem zapłacony koszt nie został odzwierciedlony w sygnale ujemnym RPE wywołanym przez sygnały nie przewidujące nagrody. Może to być spowodowane efektem podłogowym: spontaniczna aktywność neuronu dopaminy jest niska (około 5 Hz); iw konsekwencji może nie być wystarczającego zakresu dynamiki, aby odpowiednio zakodować każdą taką różnicę w kosztach wydatkowanych na ujemną odpowiedź RPE (ryc. 4d, e).

Zbadaliśmy również oddzielnie wpływ zapłaconego kosztu na wskaźniki nagrody dla neuronów dopaminy typu wartość i salience, ale oba typy neuronów dopaminy wykazywały podobny wzorzec odpowiedzi (rysunek uzupełniający. 6a – h). Dlatego opłacony koszt przejawia podobny wpływ na odpowiedź na sygnały nagrody zarówno w neuronach dopaminy typu wartościowego, jak i salience.

Rzeczywisty czas trwania fiksacji małp nie był stały, ale zmieniał się w zależności od próby (ryc. 1b). Dlatego możliwe było, że odpowiedzi dopaminy na sygnały nagrody są modulowane przez rzeczywisty czas trwania fiksacji na zasadzie prób po próbie. Nie mogliśmy jednak znaleźć żadnej istotnej korelacji między nimi dla każdego warunku kosztu i nagrody (rysunek uzupełniający. 7ogłoszenie). Ponadto RT do wskazówek dotyczących nagrody były również modulowane przez warunki kosztów i nagrody (ryc. 1f). Jedną z możliwości jest to, że reakcje neuronów dopaminowych mogą być wyjaśnione przez RT na wskazówki nagradzające na zasadzie prób po próbie. Jednak nie mogliśmy znaleźć żadnej istotnej korelacji między RT i znormalizowanymi odpowiedziami dopaminy na wskazówki nagradzające (Uzupełniający ryc. 7e – h). Wyniki te sugerują, że odpowiedzi dopaminy są niezależne zarówno od czasu RT, jak i od czasu trwania fiksacji w każdej próbie, ale modulowane przez wysokość wymaganego kosztu i oczekiwanej nagrody, które są ustalone dla każdego rodzaju prób.

Ponadto jest również możliwe, że wymuszone przerwanie w stanie LC generowało zarówno preferencje małp, jak i zwiększoną aktywację neuronów dopaminowych do wskazówki nagrody w stanie HC. Jeśli tak, liczba wymuszonych przerw powinna być związana zarówno z preferencjami, jak i stopniem wzmocnionej aktywacji. Jednak liczba przymusowych przerywań nie miała wpływu ani na preferencje małp, ani na aktywację neuronów dopaminowych do wskazówek nagrody (Uzupełnienie ryc. 8). Dlatego szybsze RT i wyższe odpowiedzi DA na RHC+ cue niż R.LC+ cue nie wynika z wprowadzonych wymuszonych przerw w stanie LC.

Ponoszone koszty zwiększają reakcje dopaminy na dostarczanie nagrody

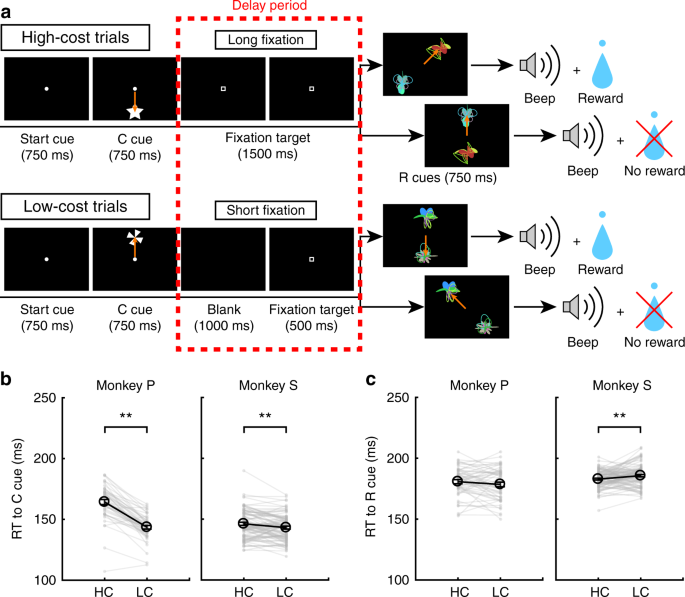

Odpowiedź neuronów dopaminowych na sygnały R + powinna wynikać z odpowiedzi na samą nagrodę, ponieważ neurony dopaminowe zmieniają swoją odpowiedź na wskazówki przewidujące nagrodę w odniesieniu do powiązania bodziec-nagroda8,30. Dlatego spodziewaliśmy się, że neurony dopaminy wykażą płatne ulepszenie odpowiedzi zależne od kosztów w celu dostarczenia nagrody. Aby zmierzyć aktywność neuronu dopaminowego do dostarczenia nagrody, małpy wykonały niepewne zadanie HLC z dwoma nowymi wskazówkami nagrody (ryc. 5a). Ponieważ nagrody zostały dostarczone tylko w połowie prezentacji wskazówek o nagrodach, wskazówki o nagrodach nie przewidywały w sposób wiarygodny ani w różny sposób dostarczenia nagrody. Dokonano tego, aby zmaksymalizować reaktywność neuronu dopaminowego na otrzymanie (nieprzewidzianej) nagrody, aby zwiększyć naszą wrażliwość na wykrywanie modulacji reaktywności neuronów w zależności od poniesionych kosztów.

Niepewne zadanie HLC. a Niepewne zadanie HLC. W tym zadaniu zastosowano niepewne wskazówki dotyczące nagród, w których dostarczono nagrody 50% czasu, niezależnie od tego, która wskazówka została przedstawiona. b RT do wskaźników kosztów w kosztownych i tanich próbach. Tylko małpa P wykazywała szybszą RT do wskaźnika LC niż wskaźnik HC (**P <0.01; dwustronny sparowany t test; t4 = 9.0, P = 8.5 × 10-4, n = 5 dla małpy P; t18 = 1.4, P = 0.19, n = 19 dla małpy S). Czarne kółka i słupki błędów wskazują średnią i SEM. c RT do wskazówek nagradzających w kosztownych i tanich próbach. Nie było różnicy w RT do wskazówek dotyczących nagrody między stanem kosztownym a niskim kosztem (sparowany dwustronny t test; t4 = 0.97, P = 0.39, n = 5 dla małpy P; t18 = 0.99, P = 0.39, n = 19 dla małpy S)

Kiedy RT porównano między wskaźnikami kosztów, małpa P wykazała szybszą RT do wskaźnika LC niż wskaźnik HC (ryc. 5b). U żadnej małpy nie było żadnej różnicy w RT do wskaźników nagrody między warunkami HC i LC (ryc. 5c).

W niepewnym zadaniu HLC neurony dopaminy wykazywały niewielką aktywację do wskaźnika LC, ale nie reagowały na sygnały nagrody, ponieważ nie były predykcyjne dla nagrody (ryc. 6a). W całej populacji wywołane odpowiedzi były mniejsze od wskazań HC niż LC (ryc. 6b; dwustronny test Wilcoxona z podpisaną rangą; P = 2.7 × 10-3, n = 19), a analizy ROC wykazały mniejsze odpowiedzi na wskazówkę HC (ryc. 6c; dwustronny test Wilcoxona z podpisaną rangą; P = 5.5 × 10-3, n = 19). Odpowiedź neuronalna na dostarczenie nagrody w stanie HC była większa niż LC (ryc. 6d; dwustronny test Wilcoxona z podpisaną rangą; P = 0.036, n = 19). Rozkład auROC wynosił> 0.5, co wskazuje na większą odpowiedź w postaci nagrody w HC w porównaniu z próbami LC (ryc. 6e; dwustronny test Wilcoxona z podpisaną rangą; P = 0.049, n = 19). Wyniki te wskazują, że reakcja dostarczania nagrody jest wzmocniona w badaniu HC i że zapłacony koszt zwiększa sygnał dodatniego RPE przy dostarczaniu nagrody.

Odpowiedź neuronu dopaminowego na dostarczenie nagrody. a Reprezentatywna aktywność neuronu dopaminowego w niepewnym zadaniu HLC. Każdy kolor reprezentuje warunki (żółty: HC +, zielony: HC−, różowy: LC +, cyjan: LC−). Czasy rozpoczęcia sakkady są oznaczone szarymi krzyżami. Odpowiedzi tego neuronu dopaminy na nieprzewidywalną nagrodę i wdech są również przedstawione na prawym panelu (czerwony: nieprzewidywalna nagroda, niebieski: nieprzewidywalne zaciągnięcie). b Uśredniona w populacji aktywność neuronów dopaminowych zarejestrowana od małpy S do wskazówek dotyczących stanu. Kolory zielony i fioletowy wskazują na aktywność odpowiednio w kosztownych i niedrogich próbach. Linie ciągłe i linie przerywane przedstawiają odpowiednio średnią i SEM. Obszar w kolorze szarym wskazuje okno czasowe do obliczenia szybkości wypalania jako odpowiedź na wskazówki dotyczące warunków. c Rozkład auROC w celu oszacowania wpływu przewidywanego kosztu na odpowiedź neuronalną na sygnały kosztu. Wypełnione kwadraty wskazują dane od małpy P (n = 3), a otwarte kółka wskazują dane od małpy S (n = 16). Grot strzałki wskazuje medianę auROC (0.44). d Uśredniona dla populacji aktywność neuronów dopaminowych zarejestrowana od małpy S do dostarczenia nagrody. Żółte i różowe kolory wskazują odpowiednio aktywność w kosztownych i niskich kosztach prób. Szare pole wskazuje okno czasowe do obliczenia szybkości strzału jako odpowiedzi na dostarczenie nagrody. e Rozkład auROC w celu oszacowania wpływu opłaconego kosztu na odpowiedź neuronalną na dostarczenie nagrody. Grot strzałki wskazuje medianę auROC (0.55)

Ponadto porównaliśmy odpowiedzi dopaminy po braku nagrody. AuROC nie wykazywały tendencyjnego rozkładu, co wskazuje, że opłacone koszty nie miały wpływu na ujemne RPE w momencie wyniku (rysunek uzupełniający. 9a). Neurony dopaminy nie wykazały różnicy między odpowiedziami na RHC i RLC wskazówki (rys. uzupełniający 9b).

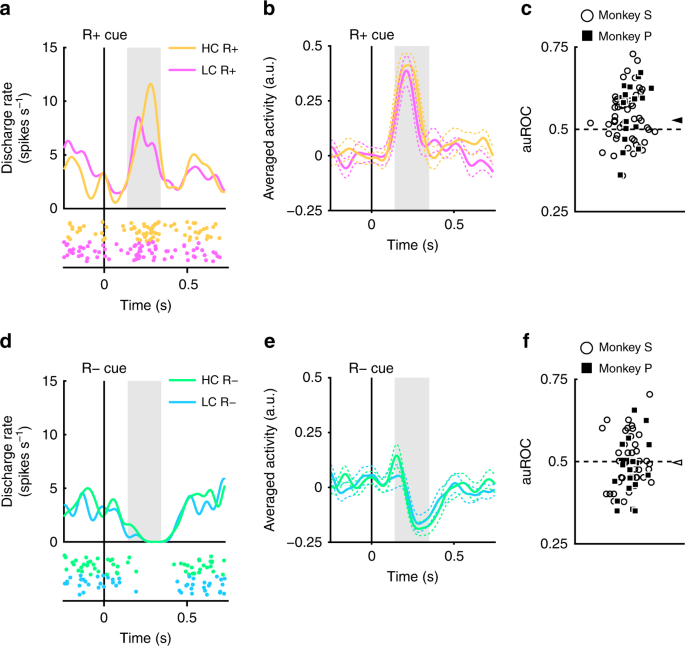

Poniesione koszty zwiększają szybkość uczenia się

Biorąc pod uwagę, że koszty RPE do nagradzania są zwiększane przez zapłacony koszt, przy założeniu, że RPE są bezpośrednio zaangażowane w pośredniczenie w uczeniu się bodziec-nagroda, spodziewaliśmy się, że ulepszone RPE znajdą odzwierciedlenie w zachowaniach związanych z uczeniem się poprzez zwiększoną szybkość uczenia24. Aby sprawdzić wpływ opłaconego kosztu na naukę, małpy wykonały zadanie eksploracji HLC (ryc. 7a; patrz Metody). W tym zadaniu dwa symbole nagrody (R + i R−) zostały przedstawione jednocześnie i małpy musiały wybrać jeden. Wyrównaliśmy wskaźniki powodzenia i prawdopodobieństwo nagrody w zależności od rodzaju próby (sparowanie dwustronne) t test; t48 = 0.15, P = 0.89, n = 49 dla małpy P; t85 = 1.2, P = 0.25, n = 86 dla małpy S). Kiedy porównano RT pod kątem wskazówek dotyczących kosztów, obie małpy wykazały szybsze RT względem wskazówki LC niż wskazówka HC (ryc. 7b; dwustronny sparowany t test; t48 = 12.9, P ≈ 0, n = 49 dla małpy P; t85 = 3.4, P = 9.4 × 10-4, n = 86 dla małpy S). Porównując RT z sygnałami nagrody, małpa S wykazywała szybsze RT w stanie HC niż LC (ryc. 7c; dwustronny sparowany t test; t48 = 1.3, P = 0.19, n = 49 dla małpy P; t85 = 2.8, P = 6.8 × 10-3, n = 86 dla małpy S). Porównując oddzielnie RT podczas pierwszej i drugiej połowy sesji uczenia, RT do cue LC były szybsze niż do cue HC w pierwszej (Dodatkowy ryc. 10) i druga połowa sesji (rys. uzupełniający. 10c). Przeciwnie, RT małpy S do wskazówki nagrody w stanie HC były szybsze niż w stanie LC podczas tylko drugiej połowy sesji (ryc. Uzupełniająca. 10d), ale nie pierwsza połowa (rys. uzupełniający. 10b).

Zadanie eksploracji HLC. a Zadanie eksploracji HLC. W tym zadaniu małpy musiały wybierać między R + i R-cue, które były losowo generowane podczas każdej sesji uczenia się. Jeśli wybiorą wskazówkę R +, będą mogli otrzymać nagrodę, a jeśli wybiorą wskazówkę R-, nie otrzymają nagrody. b RT do wskaźników kosztów w kosztownych i tanich próbach. Małpy wykazały szybsze czasy RT do taniego wskaźnika (**P < 0.01; dwustronny sparowany t test). Czarne kółka i słupki błędów wskazują średnią i SEM. c RT do wskazówek nagradzających w kosztownych i tanich próbach. Monkey S pokazał szybsze czasy RT dla wskazówek dotyczących nagrody w warunkach wysokiego kosztu

W zadaniu eksploracji HLC wskazówki dotyczące nagrody były generowane losowo w każdej sesji uczenia się. Dlatego małpy musiały nauczyć się związku między wskazówkami nagrody a nagrodami w każdej sesji. W miarę postępu prób w trakcie sesji małpy częściej wybierały sygnały R + w każdym warunku kosztu (ryc. 8a). Aby obliczyć prędkość uczenia się, dopasowujemy do danych skumulowaną funkcję wykładniczą, zawierającą dwa wolne parametry, a i b, wskazując odpowiednio stromość krzywej i plateau (rys. uzupełniający 11a, b). Stosunek logu między parametrami stromości (log aHC/aLC) był znacznie większy od zera, co wskazuje na większy parametr stromości w HC niż w próbach LC (ryc. 8b; dwustronny t test; t48 = 2.1, P = 0.042, średnia = 0.58, n = 49 dla małpy P; t85 = 2.5, P = 0.013, średnia = 0.19, n = 86 dla małpy S). Stosunek logarytmów między parametrami plateau (log bHC/bLC), nie różnił się od zera, co wskazuje na brak różnicy między warunkami kosztów (ryc. 8c; dwustronny t test; t48 = 0.76, P = 0.45, średnia = -0.0024, n = 49 dla małpy P; t85 = 0.56, P = 0.58, średnia = 0.010, n = 86 dla małpy S). Wyniki te wskazują, że prędkość uczenia się jest szybsza w próbach HC. Następnie zamodelowaliśmy krzywe uczenia się za pomocą modelu uczenia się ze wzmocnieniem (RL) (zobacz Metody). Ten model obejmuje parametry szybkości uczenia się (αHC i αLC) i wskaźniki poszukiwań (βHC i βLC) dla obu warunków kosztowych (rysunek uzupełniający 11c, d). Dopasowując się do zachowania, stwierdziliśmy, że stosunek logu między parametrami szybkości uczenia się (log αHC/αLC) był większy od zera, co wskazuje na znacznie wyższy parametr szybkości uczenia się w HC niż w próbach LC (ryc. 8d; dwustronny t test; t48 = 2.3, P = 0.026, średnia = 0.50, n = 49 dla małpy P; t85 = 2.2, P = 0.034, średnia = 0.25, n = 86 dla małpy S), podczas gdy parametr β nie wykazał różnicy (ryc. 8e; dwustronny t test; t48 = 0.77, P = 0.44, średnia = 0.0097, n = 49 dla małpy P; t85 = 0.64, P = 0.52, średnia = 0.038, n = 86 dla małpy S). Tutaj oszacowaliśmy parametry współczynnika uczenia się dla każdego warunku kosztu (αHC i αLC) osobno w celu wyjaśnienia szybszych prędkości uczenia się w warunkach HC. Jeżeli jednak współczynniki uczenia się są identyczne między warunkami kosztów, stosunek między parametrami szacowanego współczynnika uczenia się (αHC/αLC) można uznać za wartość wzmocnienia dla RPE w warunkach HC. Dlatego wyniki te sugerują, że wzmocnienie RPE może wyjaśnić szybsze prędkości uczenia się w warunkach HC.

Test szybkości uczenia się. a Średni proces uczenia się małp P i S. Odsetek wyborów R + jest wykreślany jako funkcja próby. Zielone i fioletowe punkty wskazują odpowiednio dane z kosztownej i taniej próby. Kropkowane linie oznaczają płynny proces uczenia się. Skumulowane funkcje wykładnicze zostały dopasowane do punktów danych i przedstawione jako linie ciągłe. b Stosunek logu między parametrami dopasowania a w warunkach o wysokim i niskim koszcie, gdy dane były dopasowane za pomocą skumulowanej funkcji wykładniczej (*P <0.05; dwustronny test rangowanych znaków Wilcoxona). Czarne kółka i słupki błędów wskazują średnią i SEM. c Stosunek logu między parametrami dopasowania b w warunkach o wysokim i niskim koszcie, gdy dane były dopasowane do skumulowanej funkcji wykładniczej. d Współczynnik logarytmiczny między parametrem szybkości uczenia się α w warunkach wysokich i niskich kosztów, kiedy dane były dopasowane do modelu uczenia się zbrojenia. e Stosunek logu między parametrem dopasowania β w warunkach wysokich i niskich kosztów, kiedy dane były dopasowane do modelu uczenia się zbrojenia

Próbowaliśmy także wyjaśnić proces uczenia się za pomocą alternatywnych modeli RL, które uwzględniają możliwość, że małpy znają antykorelację między bodźcami i nagrodą w każdej próbie. W tych modelach wartość niezaznaczonej opcji jest aktualizowana wraz z wybraną (rys. Uzupełniający. 12). Nawet przy zastosowaniu takich alternatywnych modeli do danych parametr szybkości uczenia się był znacznie większy w HC w porównaniu do warunku LC (rysunek uzupełniający. 12b, f) podczas gdy parametr β nie wykazał żadnej różnicy (rysunek uzupełniający 12d, h). Zatem nasze stwierdzenie dotyczące wzmocnienia sygnału RPE w warunkach HC jest solidne w formie modelu RL dopasowanego do danych.

Dyskusja

Zbadaliśmy wpływ opłaconego kosztu na wartość wskazówek przewidujących nagrody oraz na reakcje fazowe neuronów dopaminy śródmózgowia. Małpy wykazały zwiększoną wycenę pod kątem przewidywania nagród po wykonaniu akcji, która poniosła większy koszt. Neurony dopaminy wykazywały zwiększoną odpowiedź zarówno na wskazówkę, jak i na dostarczenie nagrody, po poniesieniu wyższego kosztu. Co więcej, małpy wykazywały większe prędkości uczenia się, gdy do uzyskania nagrody wymagany był wyższy koszt.

Kilka badań wykazało, że opłacony koszt zwiększa preferencje dotyczące wskazówek przewidujących nagrody1,2,3. W niniejszym badaniu małpy wykazywały szybsze RT do wskazówek przewidywania nagrody w stanie HC w porównaniu do tych w stanie LC, zgodnie z możliwością, że wartość wskazówki nagrody zostanie zwiększona o opłacony koszt27. Alternatywną możliwością jest to, że dłuższy czas fiksacji związany ze zwiększoną uwagą na cel saccade w stanie HC, a zatem zmniejszenie RT po dłuższym fiksacji w próbie HC. Jednak nie znaleźliśmy żadnej różnicy między RT do sygnałów R w próbach HC i LC w niepewnym zadaniu HLC. Ponadto w pierwszej połowie sesji eksploracyjnej HLC. RT dla sygnałów R nie różniły się istotnie między próbami HC i LC. Odkrycia te wskazują zatem, że dłuższe utrwalenie nie jest prawdopodobnym wyjaśnieniem krótszych RT obserwowanych dla wskazówek przewidujących nagrody. Oprócz wpływu opłaconego kosztu na RT z nagrodą, koszt wpłynął również na RT na wskazówki nie przewidujące niespodzianki, pomimo faktu, że po prezentacji wskazówek nie dostarczono żadnej nagrody. Poprzednie badanie zgłosiło podobne zjawisko, polegające na tym, że osobniki małp wykazywały krótsze czasy RT w nieuzbrojonych próbach, gdy w alternatywnych próbach w każdym bloku zastosowano bardziej korzystne nagrody30. Jedną z możliwych interpretacji efektu w tym badaniu jest to, że ogólnie wyższa motywacja do odpowiedzi w bloku z bardziej preferowanymi nagrodami wpływała na RT również na wskazówkę braku nagrody w bloku. Podobnie w niniejszym badaniu oczekiwanie na bardziej wartościową nagrodę w próbach HC mogło zmodulować RT do wskazania braku nagrody w próbach HC w naszym zadaniu. Co więcej, wpływ zapłaconego kosztu na RT na wskazówki nagradzające był mniejszy niż wpływ na wskazówki nieprzewidywające nagrody. Jest to najprawdopodobniej artefakt tego, że ponieważ małpy wykonały sakkadę szybciej do R.LC+ cue w pierwszej kolejności, istnieje ograniczony zakres wykrywania skracania RT do RHC+ wskazówka Dlatego różnica w RT między sygnałami R + byłaby w konsekwencji niewielka.

Małpy przeprowadziły również próby wyboru między R.HC i RLC wskazówki w zadaniu HLC. Jednak podczas gdy małpa S wykazywała preferencję dla R.HC+ wskazówka do R.LC+ wskazówka, małpa P nie wykazywała takich preferencji. Ta rozbieżność może być wyjaśniona kontekstową różnicą między sakkadą HLC a próbami wyboru. W próbach wyboru przedstawiono dwie wskazówki przewidujące nagrody zamiast jednej wskazówki przewidywania nagrody. Co więcej, małpy nie otrzymały żadnej nagrody po swoim wyborze, nawet jeśli wybrały wskazówkę przewidującą nagrodę, dlatego test wyboru przeprowadzono na wyginięciu. Wdrożono procedurę wyginięcia, aby upewnić się, że wybór małpy był uzależniony od tego, czego nauczył się podczas prób wysiłkowych, w przeciwieństwie do bycia mylonym z nową wiedzą na temat prób wyboru. Jednak ta procedura może mieć taki efekt uboczny, że małpa może szybko nauczyć się rozpoznawać procedurę wyginięcia w kontekście wyboru i że nie ma powodu, aby wybierać bardziej preferowane bodźce. Niemniej jednak jedna z małp w rzeczywistości preferowała wskazówkę dotyczącą nagrody w stanie HC.

W momencie przedstawienia wskazówki, która przewidywała kolejne wymaganie zapłaty kosztu, aktywność neuronów dopaminowych została zmniejszona, zgodnie z wcześniejszymi badaniami22,23. W naszym badaniu nie zaobserwowaliśmy ogólnego spadku neuronu dopaminy odpowiadającego na sygnały zarówno HC, jak i LC w stosunku do wartości wyjściowej. Sugeruje to, że sygnał ujemnego RPE nie występuje w tym momencie czasowym, pomimo następujących kosztów. Brak ujemnego RPE prawdopodobnie odzwierciedla integrację prognozy przyszłej nagrody oczekiwanej w dalszej części procesu. Neurony dopaminy wykazały znaczną aktywację w próbie LC, a aktywność była wyższa w porównaniu z próbą HC. Sugeruje to, że informacja o kosztach jest włączona do sygnału RPE przenoszonego przez neurony dopaminy. Zatem neurony dopaminy kodują zarówno informacje o nagrodach, jak i kosztach, a odpowiedź RPE odzwierciedla sumę kosztów i korzyści.

Wykazaliśmy, że sygnał RPE reprezentowany przez neurony dopaminowe jest wzmocniony przez opłacony koszt w punkcie prezentacji wskazówki nagrody (w zadaniu sakramentalnym HLC) i dostarczeniu nagrody (w niepewnym zadaniu HLC). Obiektywna kwota nagrody dostarczonej w badaniach HC i LC była równa; dlatego modyfikacja sygnałów RPE powinna być spowodowana niesensownym procesem. Możliwość tę potwierdzają liczne badania wskazujące kontekstowy wpływ na sygnały RPE dopaminy spójne z przetwarzaniem subiektywnej wartości i / lub użyteczności w neuronach dopaminy11,19,20,21,31,32,33,34. Jeżeli sygnał RPE jest większy, powinno to spowodować szybszą aktualizację wartości cue, co w konsekwencji wpłynęłoby na szybkość uczenia się skojarzeń bodziec-nagroda. Poprzednie badania wykazały modyfikację szybkości uczenia się przez czynniki nieczułe24,35. Zgodnie z tym, małpy wykazywały wyższe prędkości uczenia się w HC w stosunku do warunków LC. Odkryliśmy, że zwiększoną szybkość uczenia się przez opłacony koszt można wyjaśnić modelem RL ze wzmocnionym RPE. Trudno było oddzielić efekty wzmocnionego RPE i zwiększonej szybkości uczenia się w naszych eksperymentach; jednak znaleźliśmy wzmocniony dopaminergiczny sygnał RPE w stanie HC. Ponadto wcześniejsze badanie fMRI wykazało, że parametr szybkości uczenia się jest reprezentowany w przedniej korze obręczy i że aktywność VTA nie jest związana z parametrem szybkości uczenia się w niestabilnych środowiskach36. Dlatego argumentujemy, że sygnał RPE kodowany przez neurony dopaminowe jest wzmacniany przez opłacony koszt, a zwiększony sygnał RPE zwiększa prędkość uczenia się.

Kiedy sygnał RPE został wygenerowany w momencie prezentacji wskazówki nagrody i dostarczenia nagrody, małpy już pokryły koszty. Dlatego jednym z możliwych mechanizmów ulepszonego sygnału RPE jest to, że nagroda uzyskana po HC może być bardziej satysfakcjonująca. Zwiększone oczekiwanie na bardziej wartościową nagrodę po HC może zwiększyć motywację do ukończenia próby, tym samym skracając RT do wskazówek dotyczących nagrody w próbach HC.

Inną możliwą interpretacją naszych wyników jest to, że ulga związana z zakończeniem kosztownego działania może działać jako nagroda dla małp. Badania funkcjonalnego rezonansu magnetycznego (fMRI) wykazały, że uśmierzenie bólu może być nagrodą dla uczestników37,38; dlatego koszt może odgrywać podobną rolę jako awersyjny bodziec do bólu. Jeśli zwolnienie z kosztów jest satysfakcjonujące i jeśli znajduje to odzwierciedlenie w aktywności dopaminergicznej, spodziewalibyśmy się, że neurony dopaminy zareagują pod koniec długiej fiksacji, która jest momentem prezentacji wskazówki nagrody. Jednak nie zaobserwowaliśmy żadnej różnicy w aktywności dopaminergicznej w czasie prezentacji wskazówek nagradzających ani żadnej różnicy w RT do sygnałów R między próbami HC i LC w niepewnym zadaniu HLC. Dlatego sugerujemy, że zwolnienie z kosztów nie zapewnia odpowiedniego wyjaśnienia efektu, jaki zaobserwowaliśmy w neuronach dopaminy.

Ponadto neurony dopaminy wykazywały jakościowo różne odpowiedzi na bodziec awersyjny w porównaniu z sygnałem przewidywania kosztów. Jednym z możliwych wyjaśnień tego jest to, że koszt wysiłku był mniejszy niż dmuchanie powietrza lub nagroda, ponieważ koszt wysiłku został tymczasowo wydłużony o kilka sekund, ponieważ małpy wykonały fiksację, a nie nakłuły. Dlatego neurony dopaminy mogły nie zostać aktywowane w celu uzyskania niższych wskaźników kosztów. Inną możliwością jest to, że neurony dopaminy typu salience reagują na zdarzenia, po których wywołane zostały pewne ruchy. Kiedy nagroda lub wdech został dostarczony małpom, wykonują one pewne ruchy, takie jak lizanie lub mruganie okiem. Jednak w zadaniu HLC saccade małpy musiały patrzeć na cel fiksacji bez żadnego ruchu jako kosztu. W rzeczywistości ostatnie badanie wykazało, że uwalnianie dopaminy w jądrze półleżącym po podpowiedzi przewidującej nagrodę jest osłabione, chyba że ruch zostanie poprawnie zainicjowany39. Ponieważ koszt w naszych eksperymentach nie obejmował inicjacji ruchu, może to potencjalnie spowodować niespójną reakcję neuronów dopaminowych typu salience. Tak czy inaczej możemy stwierdzić, że informacje o kosztach są przetwarzane inaczej niż informacje awersyjne.

Podsumowując, sugerujemy, że opłacony koszt zwiększa wartość wskazówek przewidujących nagrody, a to z kolei zwiększa sygnał RPE kodowany w neuronach dopaminy śródmózgowia. Efekt ten doprowadził do prognozy behawioralnej, że tempo uczenia się zwierząt zostanie zwiększone w celu przewidywania nagród po doświadczeniu HC. Rzeczywiście to zaobserwowaliśmy. Zatem nasze obserwacje dotyczące aktywności neuronów dopaminowych doprowadziły nas do postawienia hipotezy o istnieniu efektu behawioralnego, a także przypuszczalnego mechanizmu obliczeniowego leżącego u podstaw tego efektu, który następnie potwierdziliśmy. Nasze odkrycia stanowią zatem przykład tego, jak może dojść do triangulacji między pomiarami danych neuronowych, teorią obliczeniową i zachowaniem: pogłębione zrozumienie przetwarzania neuronalnego w mózgu może dać wgląd w zachowanie i leżące u jego podstaw podstawy obliczeniowe.

Metody

Zwierzęta

Użyliśmy dwóch samców japońskich małp (Macaca fuscata; masa ciała, 6.5 kg = małpa P; masa ciała, 9.0 kg = Monkey S). Wszczepiliśmy sztycę na czubku czaszki małpy, aby można ją było później przymocować do krzesła. Wszczepiono także komorę rejestrującą, aby umożliwić montaż mikromanipulatora elektrodowego. Komorę rejestracyjną przechylono 45 ° poprzecznie w płaszczyźnie wieńcowej i ustawiono na współrzędnych stereotaktycznych: 15 mm przed kanałem zewnętrznym. Po okresie rekonwalescencji małpy przeszkolono do wykonywania zadania sakkady. Po zakończeniu treningu wywierciliśmy otwór przez czaszkę w komorze rejestrującej w celu wprowadzenia elektrody. Wszystkie protokoły opieki nad zwierzętami zostały zatwierdzone przez Komitet Eksperymentów Zwierząt na Uniwersytecie Tamagawa i zgodne z Narodowym Instytutem Zdrowia Przewodnik po opiece i wykorzystaniu zwierząt laboratoryjnych.

Zadanie behawioralne

Małpy były szkolone do wykonywania zadania sakralnego HLC (ryc. 1a), Niepewne zadanie HLC (ryc. 5a) oraz zadanie eksploracji HLC (ryc. 7a). Wszystkie zadania wykonywano w ciemnym pomieszczeniu. Małpy siedziały na krześle przed 22-calowym. Monitor LCD (S2232W, Eizo) z wszczepionymi głowicami przymocowanymi do krzesła. Odległość między oczami a wyświetlaczem wynosiła 70 cm. Kiedy wskazówka startowa (białe kółko, średnica 0.3 °) została przedstawiona na środku wyświetlacza, małpa musiała wpatrywać się w wskazówkę. Wskazówka startowa zniknęła po 750 ms, a następnie została zaprezentowana wskazówka dotycząca kosztu (odpowiednio gwiazda i wiatrak dla prób HC i LC). Małpy musiały przejść do kosztu w czasie 750 ms prezentacji wskazówki. Jeśli nie wykonali sakkady na sygnał, rozprawa została przerwana i ta sama próba rozpoczęła się od nowa. Podczas prób HC cel fiksacji (biały kwadrat 0.3 ° × 0.3 °) był prezentowany tuż po zniknięciu wskaźnika kosztu przez 2000 ms (sakkada HLC i niepewne zadania HLC) lub 1500 ms (zadanie eksploracyjne HLC) i wymagane były małpy sakkadować do niego i wpatrywać się w niego. Jeśli małpy przeniosły swój wzrok poza okno fiksacji 4 ° × 4 °, zadanie było przerywane. Okno fiksacji zostało aktywowane 400 ms po prezentacji punktu fiksacyjnego, ponieważ małpy potrzebowały czasu na przygotowanie się do sakkady i dostosowanie ich fiksacji. Dlatego małpy musiały wykonywać fiksację przez co najmniej 1600 ms (zadania sakadowe HLC i niepewne zadania HLC) lub 1100 ms (zadanie eksploracyjne HLC) w próbach HC. W próbach LC pusty ekran był wyświetlany przez 1500 ms (sakkada HLC i niepewne zadania HLC) lub 1000 ms (zadanie eksploracji HLC), a następnie cel fiksacji pojawiał się na 500 ms. Ponieważ okno fiksacji było aktywowane 400 ms po prezentacji punktu fiksacji, małpy musiały utrwalać się na celu przez co najmniej 100 ms w próbach LC. Małpy wykazały więcej błędów w próbie HC; dlatego wymuszone przerwanie było losowo wstawiane 100 ms przed prezentacją wskazówki nagrody (400 ms po prezentacji celu fiksacji, która jest momentem początku okna fiksacji) w próbie LC, aby wyrównać wskaźnik powodzenia. Po utrwaleniu celu, jedna lub dwie wskazówki dotyczące nagrody były prezentowane i małpy były zmuszane do sakkadowania do wskazówki. Jeśli pomyślnie wykonali sakkadę do wskazówki nagrody, po 750 ms po prezentacji wskazówki dotyczącej nagrody rozlegał się sygnał dźwiękowy. Kiedy małpy wykonały sakadę na sygnał R +, w tym samym czasie, co sygnał dźwiękowy, podano 0.3 ml wody. Żadna nagroda nie została dostarczona, gdy wykonali sakkadę na cue R− cue.

W zadaniu HLC saccade, cztery kolorowe koła zostały użyte jako wskazówki nagrody (RHC+: żółty; RHC-: zielony; RLC+: różowy; RLC-: niebieski; Figa. 1a). Jedna sesja eksperymentalna składała się z 80 prób sakkadowych, 20 prób z nieprzewidywalną nagrodą, 20 prób z nieprzewidywalnym zaciągiem powietrza i 5 prób wyboru. Próby sakkadowe obejmowały 40 prób HC i 40 prób LC, z których obie obejmowały 20 prób z nagrodą i 20 prób bez nagrody. W nieprzewidywalnych próbach z nagrodą lub zaciągnięciami powietrza 0.3 ml nagrody w postaci wody lub 0.2 MPa podmuchu powietrza (150 ms dla małpy P; 200 ms dla małpy S) podano na twarz małpy bez poprowadzenia. Próby wyboru obejmowały próbę, w której małpy dokonywały wyboru między wskazówkami R + (R.HC+ vs. R.LC+) w próbie HC między R-cues (RHC- vs. R.LC-) w próbie HC, pomiędzy R + (RHC+ vs. R.LC+) sygnały w próbie LC, pomiędzy R− (RHC- vs. R.LC-) wskazówki w próbie LC i między wskaźnikami kosztów (rysunek uzupełniający. 1). W próbach z wyborem między wskazówkami nagrody struktura zadań była identyczna jak zadanie saccade przed przedstawieniem wskazówek nagrody. Następnie, zamiast przedstawiać nagrodę, w próbach wyboru zostały przedstawione dwie wskazówki nagrody, a po prezentacji wskazówek nagrody nie dostarczono żadnej nagrody, nawet jeśli małpy dokonały wyboru między wskazówkami R +.

Aby przetestować odpowiedź neuronów dopaminowych na dostarczenie nagrody, małpy wykonały niepewne zadanie HLC (ryc. 5a). To zadanie było podobne do zadania sakramentu HLC, z wyjątkiem wskazówek dotyczących nagrody. W tym zadaniu wykorzystaliśmy dwa wskaźniki nagrody (zamiast czterech wskaźników nagrody używanych w zadaniu HLC do sakkady), jeden dla próby HC, a drugi dla próby LC. Nagroda została dostarczona w połowie prób po prezentacji wskazówek dotyczących nagrody. Jedna sesja eksperymentalna składała się z prób sakkadowych 80, nieprzewidywalnych prób nagradzania 20 i nieprzewidywalnych prób nawiewu powietrza 20. Próby saccade obejmowały próby 40 HC i próby 40 LC, przy czym obie obejmowały próby premiowe 20 i próby próbne 20 bez nagrody. W nieprzewidywalnych próbach nagroda lub wdech został dostarczony bez żadnej wskazówki.

W zadaniu eksploracji HLC dwa sygnały nagrody (RHC+, RHC- lub R.LC+, RLC-) były prezentowane jednocześnie, a małpy były zobowiązane do sakkady do jednego z sygnałów nagrody (ryc. 7a). Jeśli wybiorą wskazówkę R +, otrzymają nagrodę za wodę. Cztery wskazówki nagrody (RHC +, RHC-, RLC +, RLC-) generowano dla każdej sesji eksploracyjnej, a małpy musiały poznać związek między wskazówkami a nagrodą za próbę. Jedna sesja eksperymentalna składała się z prób 100 HC i prób 100 LC. Stwierdziliśmy, że w przypadku zadania eksploracji, jeśli ustawimy czas trwania naprawy na 2000 ms w stanie HC, tak aby pasował on do czasu trwania warunku HC w innych zadaniach, małpy wykonały zadanie z bardzo niskim wskaźnikiem powodzenia, prawdopodobnie trudność zadania i / lub wynikająca z tego niska stopa nagród. Dlatego, aby zmniejszyć trudności zadania i zwiększyć wskaźnik powodzenia, zastosowaliśmy czas trwania naprawy ms 1500 jako koszt zadania eksploracji HLC.

Zadania kontrolowano za pomocą dostępnego w handlu pakietu oprogramowania (TEMPO, Reflective Computing, St. Louis, MO, USA). Do prezentacji bodźców wizualnych wykorzystano niestandardowy program wykorzystujący interfejs programowania aplikacji (OpenGL). Autorzy stworzyli bodźce wizualne do wskaźników kosztów i nagród.

Rejestracja i akwizycja danych

Lokalizację istoty czarnej oszacowano na podstawie zdjęć MR. Epoksydową elektrodę wolframową (średnica trzonu, 0.25 mm, 0.5 – 1.5 MΩ mierzone przy 1000 Hz, FHC) włożono do istoty czarnej za pomocą mikromanipulatora (MO-972, Narishige, Tokio, Japonia) zamontowanego na komorze rejestracyjnej rura prowadząca ze stali nierdzewnej. Sygnały napięciowe zostały wzmocnione (× 10,000) i przefiltrowane (0.5 – 2 kHz). Potencjały czynnościowe z pojedynczego neuronu izolowano za pomocą algorytmu dopasowującego szablon (OmniPlex, Plexon, Dallas, TX, USA). Ruch oczu monitorowano za pomocą systemu kamery na podczerwień z częstotliwością próbkowania 500 Hz (iView X Hi-Speed Primate, SMI, Teltow, Niemcy). Czas potencjałów czynnościowych i zdarzeń behawioralnych rejestrowano z rozdzielczością czasową 1 kHz.

Analiza danych

Aby przeanalizować zachowanie małp, RT określono jako odstęp czasu między początkiem bodźca a czasem, w którym małpy zainicjowały sakadę. Inicjację sakkady określono przez obliczenie czasu, w którym pozycja spojrzenia przekroczyła odchylenia standardowe 5 od średniej pozycji spojrzenia przed prezentacją wskazówki.

W zadaniu eksploracji HLC zachowanie małp w zakresie wyboru zostało określone ilościowo poprzez dopasowanie skumulowanej funkcji wykładniczej. Funkcja (P) opisuje proporcje prawidłowego wyboru w następujący sposób:

gdzie t oznacza próbę, a i b wskazują odpowiednio nachylenie i plateau krzywej. Ta funkcja została dopasowana niezależnie do danych dla dwóch warunków kosztowych. Parametry funkcji zostały przeszukane, aby zmaksymalizować prawdopodobieństwo obserwacji danych z pojedynczej sesji i danych uśrednionych. Zastosowano metodę ładowania początkowego, aby oszacować przedziały ufności przy dopasowywaniu do uśrednionych danych. Do kwantyfikacji danych behawioralnych zastosowano również standardowy model RL. Wartości bodźców Vj(t) dla wybranego wyboru j (j = 1 dla warunku HC; j = 2 dla warunku LC) zostały zaktualizowane w następujący sposób:

gdzie αj wskazują wskaźniki uczenia się, które były ograniczone do wartości między 0 a 1. R(t) wskazuje kwotę nagrody (1: nagrodzony, 0: brak nagrody) na okres próbny t.

Prawdopodobieństwo Pj(t) wyboru bodźca j z dwóch bodźców podczas próby t jest podany przez regułę softmax

gdzie βj wskazuje zakres eksploracji.

Zarejestrowaliśmy aktywność neuronalną podczas sakkady HLC i niepewnego zadania HLC, ale nie podczas zadania eksploracyjnego HLC. Zadanie eksploracyjne KŁS zostało zrealizowane jako badanie czysto behawioralne. Neurony dopaminy zostały zidentyfikowane, jeśli wykazywały każdą z następujących właściwości: niską częstotliwość wyładowań tonicznych (<6 Hz), długi czas trwania fali szczytowej (> 300 μs) i fazową odpowiedź na nieprzewidywalną nagrodę (ryc. 2a). Przeanalizowaliśmy próby, w których małpy mogły ukończyć próbę bez żadnych błędów (utrwalenie hamowania, brak sakady lub sztucznego przerwania). Średnią szybkość wyzwalania neuronu obliczono za pomocą przedziałów ms 1 i wygładzono za pomocą jądra Gaussa (σ = 30 ms, szerokość = 4σ) w celu uzyskania funkcji gęstości skoków. Odpowiedzi neuronów dopaminowych na każde zdarzenie zadania obliczono jako znormalizowaną szybkość wyzwalania w stosunku do spontanicznej aktywności (średnia szybkość wyzwalania podczas 500 ms przed rozpoczęciem początku sygnalizacji). Szybkości strzelania zostały obliczone w ramach czasowych określonych dla każdego zdarzenia zadania i przedmiotu. Te przedziały czasowe zostały określone na podstawie aktywności uśrednionej dla populacji. Zdefiniowaliśmy punkt początkowy i końcowy przedziałów czasowych określonych na podstawie czasu wzrostu i spadku odpowiedzi uśrednionej w populacji, korzystając z wcześniejszych badań nad dopaminą u małp jako odniesień (rys. Uzupełniający. 3). Okno czasowe dla początku cue zostało zdefiniowane jako 200 – 400 ms po rozpoczęciu cue startu dla neuronów zarejestrowanych od małp P i S. Okno czasowe dla cue warunku zostało zdefiniowane jako 150 – 300 ms po początku cue warunku dla małpy P i 200 – 400 ms dla małpy S. Okno czasowe dla wskazówki nagrody zostało zdefiniowane jako 140 – 350 ms po rozpoczęciu wskazówki dla małpy P i 220 – 420 ms dla małpy S. Okno czasu dla dostawy nagrody zdefiniowano jako 225– 475 ms po nadejściu sygnału dźwiękowego dla małpy P i 200 – 450 ms dla małpy S. Okno czasowe nieprzewidywalnego dostarczenia nagrody zdefiniowano jako 100 – 300 ms po dostarczeniu nagrody dla małpy P i 150 – 300 ms dla małpy S. okno czasowe dla nieprzewidywalnego wdechu zdefiniowano jako 30 – 230 ms po dostarczeniu wdechu u małpy P i 50 – 200 ms dla małpy S.

Sklasyfikowaliśmy wszystkie zarejestrowane neurony dopaminy na dwie odrębne kategorie, wartości motywacyjne i typy istotności. Jeśli odpowiedź neuronu na bodźce z podmuchu powietrza była mniejsza niż aktywność spontaniczna, neuron klasyfikowano jako należący do typu motywacyjnego (ryc. 3d, e). W przeciwieństwie do tego, jeśli odpowiedź neuronu na bodźce pneumatyczne była większa niż aktywność spontaniczna, neuron został sklasyfikowany jako typu salience (ryc. 3g, godz).

Aby określić ilościowo zróżnicowaną aktywność neuronalną między warunkami zadaniowymi, przeprowadzono analizę ROC. Obliczyliśmy auROC dla każdego neuronu. Wartość auROC mniejsza lub większa niż 0.5 wskazuje odpowiednio na mniejszą lub większą odpowiedź w badaniu HC. Ponieważ liczba neuronów w niektórych zestawach danych neuronalnych była niewielka, zastosowaliśmy test rangowanych znaków Wilcoxona, aby zmniejszyć wpływ wartości odstających na ilościowe określenie tendencyjnego rozkładu auROC.

Do przeprowadzenia wszystkich analiz danych wykorzystano dostępne w handlu oprogramowanie MATLAB (MathWorks, Natick, MA, USA).

Badanie histologiczne

Po eksperymencie z rejestracją obie małpy uśmiercono i przeprowadzono analizę histologiczną w celu zweryfikowania pozycji zapisu (ryc. 2b). Małpy uśmiercano przez podanie śmiertelnej dawki pentobarbitalu sodu (70 mg kg-1) i perfundowane 4% formaldehydem w buforze fosforanowym. Szeregowe skrawki wieńcowe (grubość, 10 μm) wycięto i wybarwiono immunologicznie przeciwciałem przeciw hydroksylazie anty-tyrozynowej (TH) (co każde skrawki 25; przeciwciało anty-TH, 1: 500; Merck, Darmstadt, Niemcy) lub barwienie Nissl (każde przekroje 25) .

Podsumowanie raportowania

Dalsze informacje na temat projektu badań są dostępne w Podsumowanie raportowania badań przyrodniczych powiązane z tym artykułem.

Dostępność danych

Dane wykorzystane w analizie tego badania są dostępne od odpowiedniego autora na uzasadnione żądanie. Podsumowanie raportu dla tego artykułu jest dostępne jako plik informacji uzupełniających. Dane źródłowe leżące u podstaw Ryc. 1, 3-8 i dodatkowe rysunki. 1, 4-12 są dostarczane jako plik danych źródłowych.

Dostępność kodu

Kody Matlab użyte w analizie tego badania są dostępne od odpowiedniego autora na uzasadnione żądanie.

Referencje

- 1.

Clement, TS, Feltus, JR, Kaiser, DH & Zentall, TR „Etyka pracy” u gołębi: wartość nagrody jest bezpośrednio związana z wysiłkiem lub czasem wymaganym do uzyskania nagrody. Psychon. Byk. Obrót silnika. 7, 100 – 106 (2000).

- 2.

Klein, ED, Bhatt, RS & Zentall, TR Kontrast i uzasadnienie wysiłku. Psychon. Byk. Obrót silnika. 12, 335 – 339 (2005).

- 3.

Zentall, TR & Singer, RA Kontrast wewnątrzpróbkowy: gołębie preferują kondycjonowane wzmocnienia, które następują po relatywnie bardziej niż mniej awersyjnym wydarzeniu. J. Exp. Analny. Behav. 88, 131 – 149 (2007).

- 4.

Aronson, E. & Mills, J. Wpływ nasilenia inicjacji na sympatię do grupy. J. Abnorm. Soc. Psychol. 59, 177 – 181 (1959).

- 5.

Festinger, L. Teoria dysonansu poznawczego. (Stanford University Press, Kalifornia, 1957).

- 6.

Alessandri, J., Darcheville, JC, Delevoye-Turrell, Y. & Zentall, TR Preferowane nagrody za większy wysiłek i większe opóźnienie. Learn Behav. 36, 352 – 358 (2008).

- 7.

Schultz, W., Carelli, RM i Wightman, RM Fazowe sygnały dopaminy: od subiektywnej wartości nagrody do formalnej użyteczności ekonomicznej. Curr. Opin. Behav. Sci. 5, 147 – 154 (2015).

- 8.

Schultz, W., Dayan, P. i Montague, PR Neuronowy substrat przewidywania i nagrody. nauka 275, 1593 – 1599 (1997).

- 9.

Bromberg-Martin, ES, Matsumoto, M. & Hikosaka, O. Dopamine w kontroli motywacyjnej: nagradzająca, awersyjna i alarmująca. Neuron 68, 815 – 834 (2010).

- 10.

Bayer, HM & Glimcher, PW Midbrain neurony dopaminowe kodują ilościowy sygnał błędu przewidywania nagrody. Neuron 47, 129 – 141 (2005).

- 11.

Nakahara, H., Itoh, H., Kawagoe, R., Takikawa, Y. & Hikosaka, O. Neurony dopaminowe mogą reprezentować zależny od kontekstu błąd przewidywania. Neuron 41, 269 – 280 (2004).

- 12.

Tobler, PN, Fiorillo, CD & Schultz, W. Adaptacyjne kodowanie wartości nagrody przez neurony dopaminowe. nauka 307, 1642 – 1645 (2005).

- 13.

Nomoto, K., Schultz, W., Watanabe, T. & Sakagami, M. Czasowo rozszerzone odpowiedzi dopaminy na wymagające percepcyjnie bodźce przewidujące nagrodę. J. Neurosci. 30, 10692 – 10702 (2010).

- 14.

Watabe-Uchida, M., Zhu, L., Ogawa, SK, Vamanrao, A. & Uchida, N. Całomózgowe mapowanie bezpośrednich wejść do neuronów dopaminowych śródmózgowia. Neuron 74, 858 – 873 (2012).

- 15.

Tanaka, SC i in. Przewidywanie nagród bezpośrednich i przyszłych w różny sposób rekrutuje pętle zwojów korowo-podstawnych. Nat. Neurosci. 7, 887 – 893 (2004).

- 16.

Haber, SN, Kim, KS, Mailly, P. & Calzavara, R. Rekordowe dane wejściowe związane z nagrodami definiują duży obszar prążkowia u naczelnych, który styka się z asocjacyjnymi połączeniami korowymi, zapewniając podłoże do uczenia się opartego na zachętach. J. Neurosci. 26, 8368 – 8376 (2006).

- 17.

Doya, K. Modulatory podejmowania decyzji. Nat. Neurosci. 11, 410 – 416 (2008).

- 18.

Roesch, MR, Calu, DJ & Schoenbaum, G. Neurony dopaminowe kodują lepszą opcję u szczurów decydujących o różnie opóźnionej lub wielkości nagrody. Nat. Neurosci. 10, 1615 – 1624 (2007).

- 19.

Lak, A., Stauffer, WR i Schultz, W. Odpowiedzi na błąd przewidywania dopaminy integrują subiektywne wartości z różnych wymiarów nagrody. Proc. Natl Acad. Sci. USA 111, 2343 – 2348 (2014).

- 20.

Stauffer, WR, Lak, A. & Schultz, W. Odpowiedzi na błąd przewidywania nagrody dopaminy odzwierciedlają marginalną użyteczność. Curr. Biol. 24, 2491 – 2500 (2014).

- 21.

Noritake, A., Ninomiya, T. & Isoda, M. Monitorowanie i wycena nagród społecznych w mózgu makaków. Nat. Neurosci. 21, 1452 – 1462 (2018).

- 22.

Pasquereau, B. & Turner, RS Ograniczone kodowanie wysiłku neuronów dopaminowych w zadaniu koszt-korzyść. J. Neurosci. 33, 8288 – 8300 (2013).

- 23.

Varazzani, C., San-Galli, A., Gilardeau, S. & Bouret, S. Noradrenaline and dopamine neurons in the wynagrodzenie / wysiłek: bezpośrednie porównanie elektrofizjologiczne zachowań małp. J. Neurosci. 20, 7866 – 7877 (2015).

- 24.

Watanabe, N., Sakagami, M. & Haruno, M. Sygnał błędu przewidywania nagrody wzmocniony przez interakcję prążkowia-ciało migdałowate wyjaśnia przyspieszenie probabilistycznego uczenia się nagrody przez emocje. J. Neurosci. 33, 4487 – 4493 (2013).

- 25.

Di Ciano, P., Cardinal, RN, Cowell, RA, Little, SJ & Everitt, B.Różne zaangażowanie receptorów NMDA, AMPA / kainianu i dopaminy w rdzeniu jądra półleżącego w nabywaniu i wykonywaniu zachowania podejścia Pawłowa. J. Neurosci. 21, 9471 – 9477 (2001).

- 26.

Flagel, SB i in. Selektywna rola dopaminy w uczeniu się nagrody-bodźca. Natura 469, 53 – 57 (2011).

- 27.

Blough, DS Wpływ gruntowania, dyskryminacji i wzmocnienia na składniki czasu poszukiwań gołębi w czasie reakcji. J. Exp. Psychol. Anim. Behav. Proces. 26, 50 – 63 (2000).

- 28.

Matsumoto, M. i Hikosaka, O. Dwa typy neuronów dopaminowych wyraźnie przekazują pozytywne i negatywne sygnały motywacyjne. Natura 459, 837 – 841 (2009).

- 29.

Matsumoto, M. & Takada, M. Wyraźne reprezentacje sygnałów poznawczych i motywacyjnych w neuronach dopaminowych śródmózgowia. Neuron 79, 1011 – 1024 (2013).

- 30.

Watanabe, M. i in. Reakcje behawioralne odzwierciedlające zróżnicowane oczekiwania dotyczące nagrody u małp. Exp. Brain Res. 140, 511 – 518 (2001).

- 31.

Takikawa, Y., Kawagoe, R. & Hikosaka, O. Możliwa rola śródmózgowia neuronów dopaminowych w krótko- i długoterminowej adaptacji sakkad do mapowania pozycji i nagrody. J. Neurophysiol. 92, 2520 – 2529 (2004).

- 32.

Kobayashi, S. & Schultz, W. Wpływ opóźnienia nagrody na odpowiedzi neuronów dopaminowych. J. Neurosci. 28, 7837 – 7846 (2008).

- 33.

Enomoto, K. i in. Neurony dopaminy uczą się kodować długoterminową wartość wielu przyszłych nagród. Proc. Natl Acad. Sci. USA 108, 15462 – 15467 (2011).

- 34.

Lak, A., Nomoto, K., Keramati, M., Sakagami, M. & Kepecs, A. Midbrain Neurony dopaminowe sygnalizują wiarę w trafność wyboru podczas podejmowania decyzji percepcyjnej. Curr. Biol. 27, 821 – 832 (2017).

- 35.

Williams, BA i McDevitt, MA Hamowanie i nadwarunkowanie. Psychol. Sci. 13, 454 – 459 (2002).

- 36.

Behrens, TE, Woolrich, MW, Walton, ME & Rushworth, MF Poznanie wartości informacji w niepewnym świecie. Nat. Neurosci. 10, 1214 – 1221 (2007).

- 37.

Seymour, B. i in. Procesy neuronalne przeciwdziałające apetycji i niechęci są podstawą predykcyjnego uczenia się łagodzenia bólu. Nat. Neurosci. 8, 1234 – 1240 (2005).

- 38.

Kim, H., Shimojo, S. & O'Doherty, JP Czy unikanie awersyjnego wyniku jest satysfakcjonujące? Neuronalne substraty uczenia się unikania w ludzkim mózgu. PLoS Biol. 4, e233 (2006).

- 39.

Syed, EC i in. Inicjacja akcji kształtuje mezolimbiczne kodowanie dopaminy przyszłych nagród. Nat. Neurosci. 19, 34 – 36 (2016).

Podziękowania

Ta praca była wspierana przez MEXT / JSPS Grants-in-Aid for Research Research (Kakenhi) Numery grantów JP16H06571 i JP18H03662 dla MS Te badania były częściowo wspierane przez Strategiczny Program Badań Nauk o Mózgu wspierany przez Japońską Agencję Badań Medycznych i Rozwoju (AMED ) oraz japońsko-amerykański program współpracy w zakresie badań mózgu. Badania te zostały wsparte przez National Bio-Resource Project w National Institute of Physiological Science (NBRP at NIPS) z Japan Agency for Medical Research and Development, AMED. Dziękujemy Bernardowi W. Balleine i Andrew R. Delamaterowi za pomoc w napisaniu pracy.