自然通讯

体积 10, 文章编号: 3674 (2019)

抽象

已知中脑多巴胺神经元编码用于更新值预测的奖励预测误差(RPE)。 在这里,我们检查由中脑多巴胺神经元编码的RPE信号是否通过在执行努力的扫视任务期间从清醒行为猴子中的多巴胺神经元记录获得奖励所花费的成本来调节。 与低成本行动相比,在执行代价高昂的行动之后,多巴胺神经元对预测奖励和奖励递送的线索的反应增加,表明RPE在执行昂贵的行动后得到增强。 在行为层面,与执行成本较低的行动相比,在执行代价高昂的行动后,刺激 - 奖励关联的学习速度更快。 因此,在多巴胺奖励系统中以放大下面的多巴胺RPE信号的方式处理关于动作成本的信息,这反过来促进了在高成本情况下的更快速学习。

介绍

与经过较少努力后的相同奖励相比,人类和动物在花费大量精力获得奖励后更喜欢获得奖励1,2,3。 已经为这种效果提出了许多解释,例如努力证明4,5 和对比效果6,其中更大的价值归因于付出努力后获得的结果。 然而,仍然不清楚是否以及如何通过获得奖励所花费的努力来调节大脑中的奖励信息的处理。

考虑到该系统在促进行为适应奖励方面的作用,我们专注于中脑多巴胺系统7,8,9。 已知多巴胺神经元代表奖励预测误差(RPE)信号,其可促进基底神经节的奖赏预测的学习10,11,12,13,14,15,16,17。 RPE的强度取决于奖励的数量,质量和主观价值或效用7,18,19,20,21。 此外,多巴胺能活性受成本和/或努力的调节22,23。 在此基础上,我们假设多巴胺能RPE信号将直接调整为获得奖励所支付的费用。 此外,因为RPE信号与中介学习刺激 - 奖励关联有因果关系24,25,26,我们假设获得奖励所支付的费用将直接提高刺激 - 奖励关联的学习速度。

为了检验我们的假设,我们测量了两只日本猴子的行为和多巴胺能活性,同时他们进行了基于扫视的努力任务。 与低成本(LC)动作之后的动作相比,猴子对高成本(HC)动作后呈现的奖励预测提示反应更快。 通过付费成本增加多巴胺能神经元对奖赏预测线索的活动。 此外,通过支付成本也增强了对刺激 - 奖励关联的学习速度。 因此,我们建议获得奖励所花费的成本会增加多巴胺神经元中的RPE信号,从而增强刺激 - 奖励关联。

成果

高低成本(HLC)扫视任务

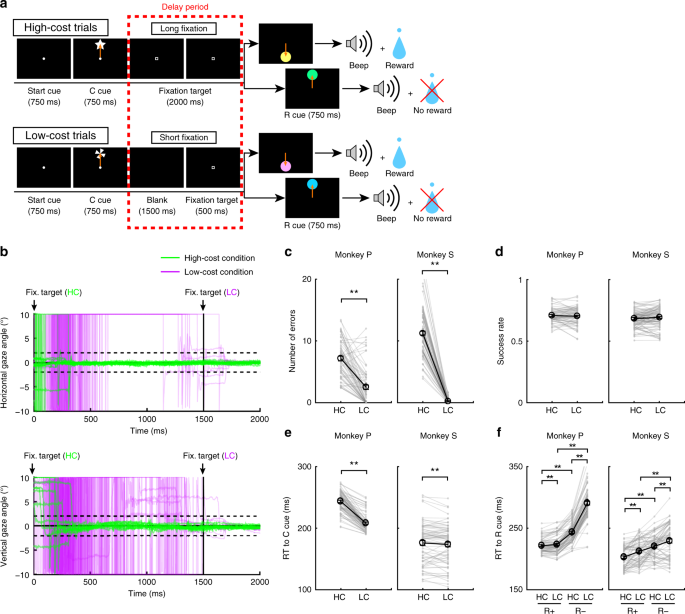

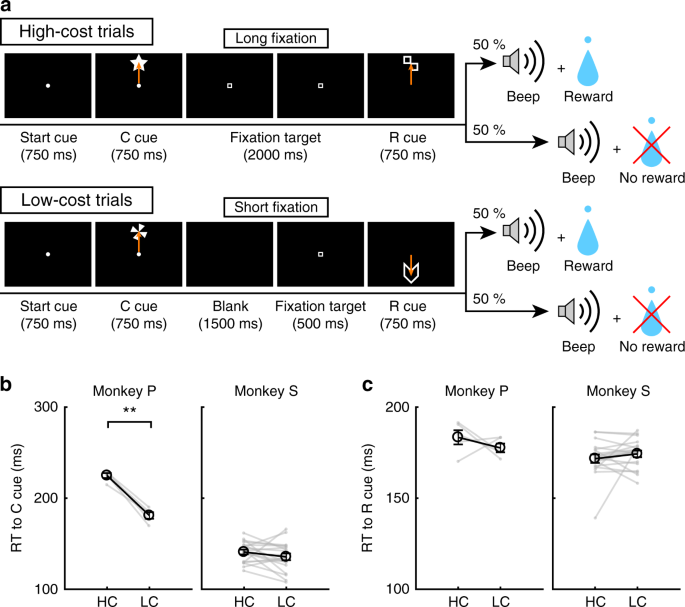

为了研究付费用对行为和多巴胺神经元活动的影响,猴子在两个成本条件下进行了扫视任务(图。 1a,见方法)。 在HC试验中,猴子迅速对目标进行了扫视,并将目光停留在目标上而不会眨眼更长时间(图。 1b; 绿线)。 相比之下,在LC试验中,猴子在固定较短时间之前首先自由地环顾四周(图。 1b,紫色线条)。 由于猴子难以长时间固定,因此在HC试验延迟期间会出现更多错误(图。 1c)。 为了控制HC试验和LC试验之间奖励概率的相应差异,我们在一部分LC试验中插入了强制中止,以平衡试验类型之间的成功率和奖励概率(图2)。 1d).

HLC扫视任务。 a HLC扫视任务。 成本提示(C提示)表示获得潜在奖励所需的工作量。 在高成本试验的延迟期内,需要长时间固定。 奖励线索(R线索)指示猴子是否可以获得奖励。 b 延迟期间凝视角的时间过程。 上面板和下面板分别显示水平和垂直注视角度。 绿色和紫色线分别表示高成本试验(每个小组中的50试验)和低成本试验(每个小组中的50试验)中的凝视角度。 c 高成本和低成本试验中延迟期间的错误数量(**P < 0.01; 两尾成对 t 测试; t67 = 8.8, P = 4.8×10 - 15, n 猴子P = 68; t83 = 26.6, P ≈0, n =对于猴子S是84)。 黑色圆圈和误差线表示平均值和SEM。 d 高成本和低成本试验的成功率(双尾配对 t 测试; t67 = 0.51, P = 0.61, n 猴子P = 68; t83 = 0.79, P = 0.43, n =对于猴子S是84)。 e RT到成本线索(**P <0.01; 两尾成对 t 测试; t67 = 20.4, P ≈0, n 猴子P = 68; t69 = 2.0, P = 1.2×10 - 3, n =对于猴子S是70)。 f 转发奖励线索(**P <0.01; 两尾成对 t 测试; 猴P(n = 68):HC + vs. LC +, t67 = 3.5, P = 9.2×10 - 4; HC-与LC-, t67 = 24.5, P ≈0; HC +与HC-, t67 = 21.6, P ≈0; LC +与LC- t67 = 28.5, P ≈0; 猴子S(n = 70):HC + vs. LC +, t69 = 5.6, P = 4.4×10 - 7; HC-与LC-, t69 = 4.8, P = 8.4×10 - 5; HC +与HC-, t69 = 18.0, P ≈0; LC +与LC- t69 = 5.9, P = 1.1×10 - 7)

付费成本增加了奖励预测线索的价值

为了获得猴子对线索的主观评价差异的隐含证据,我们测试了猴子的反应时间(RTs)。 特别是,我们预计如果猴子为一个选项分配比另一个选项更高的主观价值,他们应该为更有价值的选项显示更快的RT27。 当在成本提示之间比较RT时,与HC提示相比,两只猴子显示出更快的RT到LC(图2)。 1e),证明了对LC条件的隐含偏好。 当在奖励提示之间比较RT时,两只猴子表现出更快的RT来奖励(R +)线索而不是没有奖励(R-)线索(图。 1f),表明他们更喜欢R +提示R-cues。 此外,两只猴子都向R显示出更快的RTHC+提示与R相比LC+提示和RHC- 提示与R相比LC- 提示(图。 1f),表明他们更重视HC中与LC条件相比的奖励预测线索。

此外,我们在HLC扫视任务中纳入了选择试验,以测试猴子在线索之间的明显偏好(补充图。 1a)。 当猴子选择成本线索时,他们优先选择LC线索(补充图。 1b)。 Monkey S优先选择RHC在执行R之间的选择任务时提示+HC+和R.LC+提示,但R之间没有偏好HC- 和R.LC- 提示(补充图。 1c,d)。 相反,猴子P在R之间没有明显的偏好HC+和R.LC+提示,但仍然喜欢RHC- 在R之间选择时提示HC- 和R.LC- 提示(补充图。 1c,d).

电生理学结果在HLC扫视任务中

我们记录了在HLC扫视任务期间位于黑质致密部(SNc)和腹侧被盖区(VTA)内的神经元的单个单位活动。 我们在两只猴子身上发现了70多巴胺神经元(补充图。 2a; 分别来自Monkey P和S的18和52神经元。 组织学检查证实神经元位于SNc / VTA内或周围(补充图。 2b).

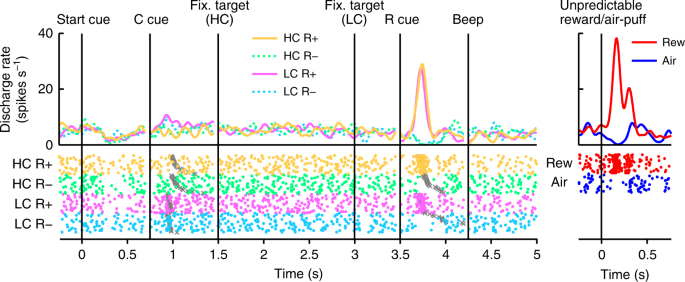

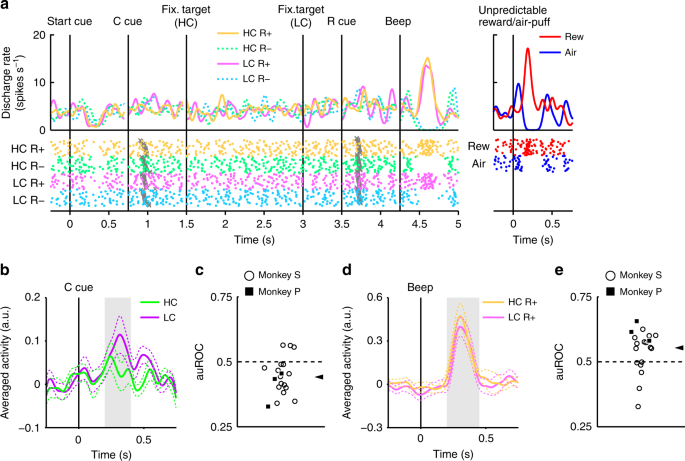

在图。 2,我们显示代表性多巴胺神经元的活动。 这种神经元显示出对LC提示的适度激活,以及阶段性激活或对奖励的抑制(RHC+和R.LC+)或没有奖励提示(RHC- 和R.LC- ),分别(图。 2,补充图。 3)。 神经元也显示出不可预测的奖励的相位激活以及响应于厌恶刺激的相位抑制,这是一种不可预测的气泡(图2)。 2,右图)。 此外,神经元对起始线索表现出适度抑制,但对奖励传递没有反应。 我们记录的所有多巴胺神经元群体都显示出对起始线索和奖励传递的相似反应(补充图。 4a,b)。 在HLC扫视任务中,在获得奖励之前支付了努力成本。 因为预测的成本降低了多巴胺神经元的活性22,23在开始提示时,多巴胺神经元反应会被抑制16.

多巴胺神经元编码有关奖励和成本的信息

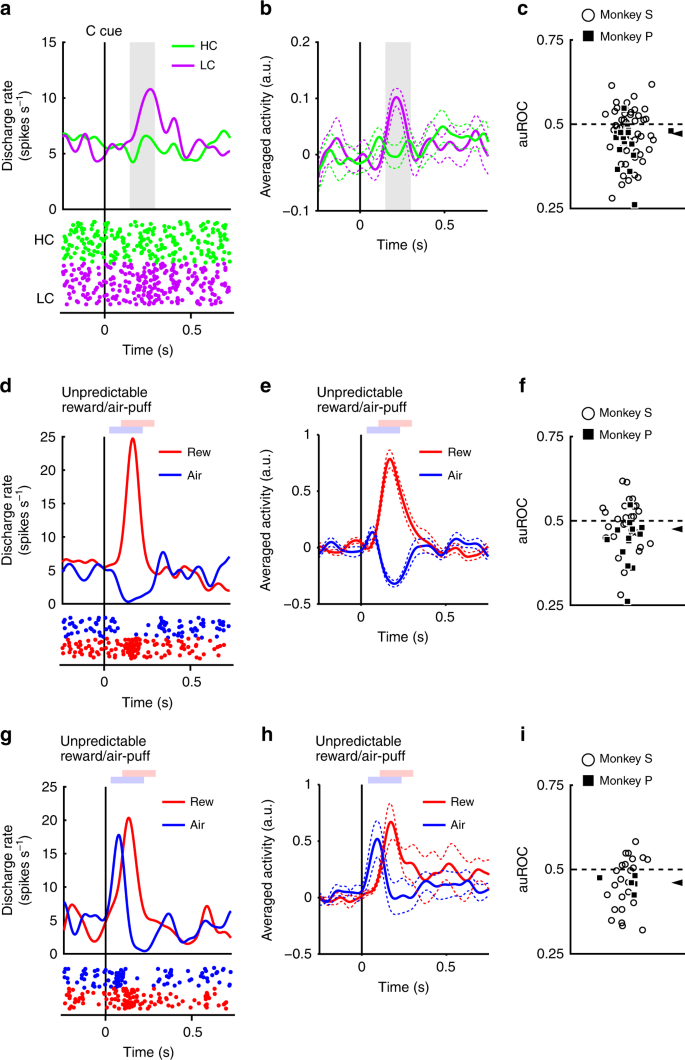

神经元对LC提示进行了相位反应,但对HC提示的反应较弱(图2)。 3a,b)。 对成本条件提示的诱发反应表现出对HC提示的反应小于LC提示(双尾威尔科克森的符号秩检验, P <3.2×10 - 4, n = 70)。 我们使用接收器操作特征(ROC)分析量化了预测成本对神经元反应的影响。 ROC曲线下面积(auROC)的分布显着小于0.5(图XNUMX)。 3c; 双尾威尔科克森的签名等级测试; P = 5.4×10 - 4, n = 70),表示HC提示响应比LC提示小。 先前已发现预测成本会降低多巴胺神经元活性,这与我们的结果一致22,23。 此外,多巴胺神经元群体对LC线索表现出显着的激活,而对HC线索没有显着的抑制作用(补充图。 4c,d)。 这些结果表明多巴胺神经元在成本提示呈现时编码并整合关于奖励和成本的信息。

多巴胺神经元对成本线索的反应。 a 代表性的多巴胺神经元对费用提示的反应。 由从猴子P记录的多巴胺神经元的归一化活性计算出峰浓度函数。彩色线表示峰浓度函数,而彩色点表示峰时间。 绿色和紫色分别表示高价试验和低成本试验中的活性。 垂直线表示成本提示显示的时间。 灰色区域表示计算触发率作为对条件提示的响应的时间段。 b 从猴P到条件线索记录的多巴胺神经元的群体平均活动。 虚线的实线分别代表平均值和SEM。 c ROC下的区域分布,以量化预测成本对神经元对成本线索的响应的影响。 填充方块和空心圆圈分别表示来自猴子P和S的数据。 箭头表示auROC(0.47)的中位数。 d, g 动机值型多巴胺神经元的代表性反应(d)或突出型多巴胺神经元(g)对不可预测的奖励或空气扑通。 红色和蓝色曲线分别表示对不可预测的奖励和不可预测的空气抽吸的响应。 垂直线表示不可预测的奖励或吹气输送的时间。 淡红色和蓝色方块表示计算射击率的时间段,作为对不可预测的奖励或空气抽吸的响应。 e, h 动机值类型多巴胺神经元的人口平均活动(e)或突出型多巴胺神经元(h)对不可预测的奖励或空气扑通。 f, i 从动机值类型多巴胺神经元计算的auROCs的分布(f)或突出型多巴胺神经元(i)。 箭头表示auROC的中位数(f 0.48; i 0.46)

先前已经描述了两种不同的多巴胺神经元亚型:动机值和显着性神经元28,29。 我们在多巴胺神经元群体中发现了与两种亚型一致的反应模式的证据。 值型神经元显示出对厌恶空气刺激刺激的相位抑制(图2)。 3d,e)。 相反,显着神经元显示出对厌恶刺激的阶段性激活(图2)。 3g,h)。 HC试验中的长期固定也令人不快和厌恶; 因此,两种多巴胺神经元亚型可能对成本条件线索显示出不同的响应模式。 如果多巴胺神经元以类似方式表示厌恶刺激和成本,那么由于其厌恶性,值神经元应显示对HC提示的活性降低。 另一方面,显着神经元应该增加对HC提示的活性,因为它们也会增加到令人不愉快的刺激。 然而,与LC线索相比,两种类型神经元的诱发反应均小于HC线索(双尾Wilcoxon的符号秩检验; P = 0.021, n = 41并且 P = 0.0044, n 值和显着性类型分别为= 29),并且在两种亚型中,ROC分析均显示出与HC相比,对HC的响应较小 3f,i; 双尾威尔科克森的签名等级测试; P = 0.030, n = 41并且 P = 0.0058, n = 29(分别代表值和显着性类型)。 因此,预测成本降低了多巴胺神经元的两种亚型的活性。 这些结果表明,多巴胺神经元以与厌恶刺激质性不同的方式处理成本信息。

在HLC扫视任务中,我们在一部分LC试验中插入了强制中止操作,以使试验类型之间的成功率和奖励概率相等。 这种操作增加了在LC条件下获得奖励的不确定性或无奖励的风险。 因此,多巴胺神经元的较高活性以及猴子相对于HC线索对LC的估价增加,可能是由于成本条件之间风险或不确定性的差异所致。 但是,我们发现强迫中止的次数与RT的差异之间没有关系(补充图。 5a,b),我们发现强迫中止的数量与auROC之间存在正相关关系(补充图。 5c)。 我们还比较了中止后的多巴胺反应与正确试验后的成本线索,但发现两种成本条件没有差异(补充图。 5d)。 这些结果表明,LC条件下的强制中止的数量并不能解释估值的增加或对LC线索的增强的多巴胺能激活。

增加多巴胺反应以奖励提示付费

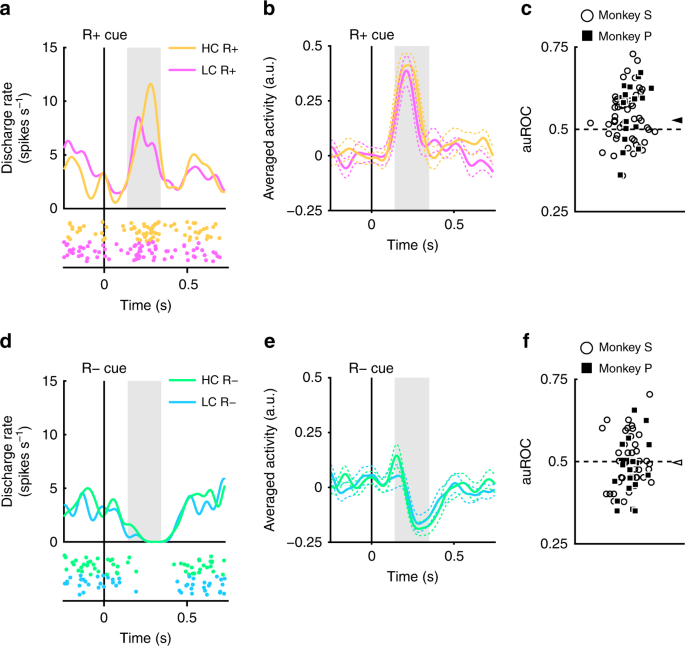

发现记录的多巴胺神经元分别显示阶段激活和抑制以奖励而没有奖励预测线索(图2)。 2)。 接下来,我们评估了这些响应是否由先前产生的成本调节。 代表性神经元和群体平均神经元的实例显示出对R的更大激活HC+提示比RLC+提示如图所示 分别为4a和b。 (两尾Wilcoxon的秩检验; P = 7.4×10 - 5, n = 70)。 auROC的分布> 0.5,表明对R的响应HC+ cue大于RLC+提示(图。 4c; 双尾威尔科克森的签名等级测试; P = 1.4×10 - 4, n = 70)。 这些结果表明,在HC条件下,对奖励预测提示的响应明显大于LC条件下的响应。 因此,我们的发现表明,多巴胺神经元代表的RPE阳性信号因先前的花费而增加。

多巴胺神经元对奖赏线索的反应。 a 神经元对R +线索的反应示例。 根据从猴P记录的多巴胺神经元的活性计算穗密度函数。有色线和点分别表示穗密度和穗定时。 黄色和粉红色分别表示高成本和低成本试验中的活动。 垂直线表示R +提示表示的时间。 灰色区域表示计算点火率的时段作为对奖励提示的响应。 b 从猴子P到R +线索记录的多巴胺神经元的群体平均活动。 实线和虚线分别代表平均值和SEM。 c auROCs的分布,以量化支付成本对神经元对R +线索的反应的影响。 填充方块和空心圆圈分别表示来自猴子P和S的数据。 箭头表示auROC的中位数(0.53)。 d 对R-cues的代表性回应。 绿色和青色分别表示高成本和低成本试验。 垂直线表示R-cue表示的时间。 e 从猴P到R-提示记录的多巴胺神经元的群体平均活动。 f auROCs的分布,以量化支付成本对神经元对R-cues的反应的影响。 箭头表示auROC的中位数(0.50)

多巴胺神经元也显示出对R-提示的相位抑制(图2)。 4d,e)。 然而,多巴胺神经元对R-线索的反应并未显示出与成本相关的显着差异(双尾Wilcoxon的符号秩检验; P = 0.25, n = 70),而ROC分析并未发现任何证据表明反应分布有偏差(图。 4f; Wilcoxon的签名等级测试, P = 0.35; n = 70)。 因此,支付费用没有反映在非奖励预测线索引起的负RPE信号中。 这可能是由场效应引起的:多巴胺神经元的自发活动较低(约5 Hz); 因此,可能没有足够的动态范围来充分编码负RPE响应所花费的任何此类费用差异(图XNUMX。 4d,e).

我们还分别检验了付费成本对价值和显着类型多巴胺神经元的奖励线索的影响,但两种类型的多巴胺神经元都显示出相似的反应模式(补充图。 6a小时)。 因此,付费成本对价值和显着类型多巴胺神经元中的奖励线索的响应表现出类似的效果。

猴子的实际固定持续时间不是恒定的,而是逐个试验的(图2)。 1b)。 因此,有可能通过逐个试验的实际固定持续时间调节多巴胺对奖赏提示的反应。 但是,对于每种成本和奖励条件,我们都找不到它们之间的任何显着相关性(补充图。 7广告)。 此外,奖励提示的RT也受成本和奖励条件的调节(图。 1f)。 一种可能性是多巴胺神经元的反应可以通过逐个试验的奖励线索的RT来解释。 然而,我们发现RT与归一化的多巴胺对奖赏线索的反应之间没有任何显着的相关性(补充图。 7E-H)。 这些结果表明,多巴胺反应与每次试验的RT和固定持续时间无关,而是由每种试验所固定的所需成本和预期奖励的数量调节。

此外,LC条件下的强制中止也可能产生猴子的偏好和多巴胺神经元在HC条件下对奖赏提示的增强激活。 如果是这样,强制中止的数量应该与偏好和增强激活的程度相关。 然而,强迫中止的数量对猴子的偏好或多巴胺神经元激活至奖赏线索没有影响(补充图。 8)。 因此,更快的RT和更高的DA响应HC+提示比RLC+ cue不是由于在LC条件下插入的强制中止。

发生的成本会增加多巴胺对奖励传递的反应

多巴胺神经元对R +线索的反应应该来自对奖励本身的反应,因为多巴胺神经元相对于刺激 - 奖励关联改变了对奖赏预测线索的反应。8,30。 因此,我们预计多巴胺神经元将显示付费成本依赖性响应增强以奖励递送。 为了测量多巴胺神经元对奖励传递的活动,猴子用两个新的奖励线索进行了HLC不确定任务(图。 5a)。 由于奖励仅在奖励提示演示中的一半中提供,因此奖励提示不能可靠地或差别地预测奖励交付。 这样做是为了使多巴胺神经元对接收(不可预测的)奖励的响应最大化,从而增加我们对检测神经元响应性的调节的灵敏度,作为所花费的成本的函数。

HLC不确定的任务。 a HLC不确定的任务。 在这项任务中,使用了不确定的奖励线索,其中奖励是在50%的时间内传递的,而不管呈现的是哪种线索。 b 在高成本和低成本试验中转换成本线索。 只有猴子P对LC提示的RT转速比HC提示更快(**P <0.01; 两尾成对 t 测试; t4 = 9.0, P = 8.5×10 - 4, n 对于猴子P = 5; t18 = 1.4, P = 0.19, n = 19(猴子S)。 黑色圆圈和误差线表示平均值和SEM。 c 在高成本和低成本试验中转发奖励线索。 RT与高成本和低成本条件之间的奖励线索没有差异(双尾配对) t 测试; t4 = 0.97, P = 0.39, n 对于猴子P = 5; t18 = 0.99, P = 0.39, n = 19(猴S)

当在成本线索之间比较RT时,猴子P对LC提示的RT比HC提示更快(图2)。 5b)。 在任何猴子的HC和LC条件之间,RT与奖赏线索没有差异(图。 5c).

在HLC不确定任务中,多巴胺神经元对LC线索表现出适度的激活,但对奖励线索没有反应,因为它们不是奖励预测(图2)。 6a)。 在整个人群中,诱发反应对HC的影响小于LC提示(图2)。 6b; 双尾威尔科克森的签名等级测试; P = 2.7×10 - 3, n = 19),而ROC分析显示对HC提示的响应较小(图。 6c; 双尾威尔科克森的签名等级测试; P = 5.5×10 - 3, n = 19)。 在HC状态下,对奖励传递的神经元反应比LC更大(图。 6d; 双尾威尔科克森的签名等级测试; P = 0.036, n = 19)。 auROC的分布> 0.5,表明相对于LC试验,HC中的奖励交付反应更大(图XNUMXb)。 6e; 双尾威尔科克森的签名等级测试; P = 0.049, n = 19)。 这些结果表明,在HC试验中,奖励交付反应得到了增强,而付费成本增加了奖励交付时的RPE阳性信号。

多巴胺神经元对奖励传递的反应。 a 代表性的多巴胺神经元活动在HLC不确定的任务中。 每种颜色代表条件(黄色:HC +,绿色:HC-,粉红色:LC +,青色:LC-)。 扫视发作的时间由灰色十字表示。 这个多巴胺神经元对不可预测的奖励和空气抽吸的反应也在右侧面板中描述(红色:不可预测的奖励,蓝色:不可预测的空气抽吸)。 b 从猴子S到条件提示所记录的多巴胺神经元的群体平均活动。 绿色和紫色分别表示高价试验和低成本试验中的活性。 实线和虚线分别代表平均值和SEM。 灰色区域表示时间窗口,用于计算触发率作为对条件提示的响应。 c auROCs的分布用于量化预测成本对神经元对成本线索的响应的影响。 填充方块表示来自猴子P的数据(n = 3),空心圆表示来自猴子S(n = 16)。 箭头指示auROC的中位数(0.44)。 d 从猴S到奖励递送记录的多巴胺神经元的群体平均活动。 黄色和粉红色分别表示高成本和低成本试验中的活动。 灰色区域表示计算点火率的时间窗口,作为对奖励交付的响应。 e auROCs的分布,以量化支付成本对神经元对奖励传递的反应的影响。 箭头表示auROC的中位数(0.55)

此外,我们比较了没有奖励后的多巴胺反应。 auROCs没有显示偏差分布,表明付费成本对结果时的负RPE没有影响(补充图。 9a)。 多巴胺神经元显示对R的反应之间没有差异HC 和RLC 提示(补充图。 9b).

发生的成本提高了学习速度

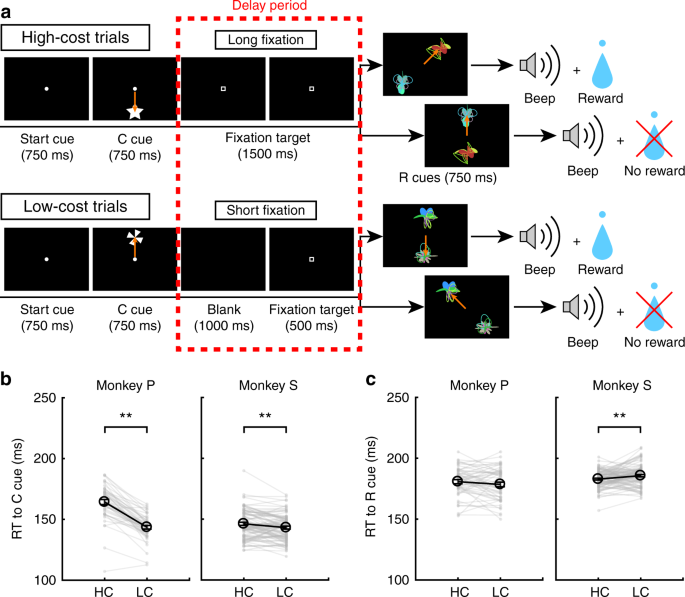

鉴于奖励提供的RPE增加了支付的费用,在RPE直接参与中介激励奖励学习的假设下,我们期望增强的RPE通过提高学习速度反映在学习行为中24。 为了测试付费成本对学习的影响,猴子进行了HLC探索任务(图。 7a; 见方法)。 在这项任务中,两个奖励线索(R +和R-)同时呈现,猴子必须选择一个。 我们平衡了试验类型之间的成功率和奖励概率(双尾配对 t 测试; t48 = 0.15, P = 0.89, n 对于猴子P = 49; t85 = 1.2, P = 0.25, n = 86(猴子S)。 当比较成本提示的RT时,两只猴子对LC提示的RT均比对HC提示的响应快(图XNUMX)。 7b; 双尾配对 t 测试; t48 = 12.9, P ≈0, n 对于猴子P = 49; t85 = 3.4, P = 9.4×10 - 4, n = 86(猴子S)。 当将RT与奖励提示进行比较时,猴子S在HC中的RT比在LC条件下要快(图XNUMX。 7c; 双尾配对 t 测试; t48 = 1.3, P = 0.19, n 对于猴子P = 49; t85 = 2.8, P = 6.8×10 - 3, n = 86(猴子S)。 当分别比较学习会话的前半部分和后半部分的RT时,LC提示的RT快于HC提示的RT(补充图。 10a)和后半段(补充图。 10c)。 相反,仅在会话的后半段,猴子S对HC条件下的奖励提示的RT比在LC条件下更快(补充图。 10d)但不是上半年(补充图。 10b).

在HLC探索任务中,在每个学习会话中随机生成奖励提示。 因此,猴子必须在每次训练中学习奖励线索和奖励之间的关系。 随着试验在一次会议中的进展,猴子在每种成本条件下更频繁地选择R +线索(图。 8a)。 为了量化学习速度,我们将累积指数函数拟合到数据中,包含两个自由参数, a 和 b,分别表示曲线和高原的陡度(补充图。 11a,b)。 陡度参数之间的对数比(log aHC/aLC)显着大于零,表明HC中的陡度参数大于LC试验(图2)。 8b; 双尾 t 测试; t48 = 2.1, P = 0.042,平均值= 0.58, n 对于猴子P = 49; t85 = 2.5, P = 0.013,平均值= 0.19, n = 86(猴子S)。 平稳参数之间的对数比(log bHC/bLC),与零无差异,表明成本条件之间没有差异(图 8c; 双尾 t 测试; t48 = 0.76, P = 0.45,平均值= −0.0024, n 对于猴子P = 49; t85 = 0.56, P = 0.58,平均值= 0.010, n = 86(猴子S)。 这些结果表明,在HC试验中学习速度更快。 接下来,我们使用强化学习(RL)模型对学习曲线进行建模(请参见方法)。 该模型包括学习率参数(αHC 和 αLC)和勘探率(βHC 和 βLC)两种成本条件(补充图。 11c,d)。 当拟合行为时,我们发现学习速率参数之间的对数比(log αHC/αLC)大于零表明HC中的学习速率参数明显大于LC试验(图2)。 8d; 双尾 t 测试; t48 = 2.3, P = 0.026,平均值= 0.50, n 对于猴子P = 49; t85 = 2.2, P = 0.034,平均值= 0.25, n = 86(对于猴子S),而参数 β 没有显示出差异(图 8e; 双尾 t 测试; t48 = 0.77, P = 0.44,平均值= 0.0097, n 对于猴子P = 49; t85 = 0.64, P = 0.52,平均值= 0.038, n = 86(猴子S)。 在这里,我们估算了每种成本条件的学习率参数(αHC 和 αLC)分别解释HC条件下更快的学习速度。 但是,如果学习成本条件之间的学习率相同,则估计学习率参数之间的比率(αHC/αLC)可以被认为是HC条件下RPE的放大值。 因此,这些结果表明RPE的扩增可以解释HC条件下更快的学习速度。

学习速度测试。 a 猴子P和S的平均学习过程.R +选择的比例作为试验的函数作图。 绿色和紫色点分别表示来自高成本和低成本试验的数据。 虚线表示平滑的学习过程。 累积指数函数拟合到数据点并表示为实线。 b 拟合参数之间的对数比 a 在数据符合累积指数函数的高成本和低成本条件下(*P <0.05; 两尾Wilcoxon的秩检验)。 黑色圆圈和误差线表示平均值和SEM。 c 拟合参数之间的对数比 b 在数据符合累积指数函数的高成本和低成本条件下。 d 学习率参数之间的对数比 α 在数据符合强化学习模型的高成本和低成本条件下。 e 拟合参数之间的对数比 β 在数据符合强化学习模型的高成本和低成本条件下

我们还尝试用替代RL模型解释学习过程,其中考虑到猴子知道每次试验中刺激和奖励之间的反相关的可能性。 在这些模型中,未选择的选项的值将与所选择的一起更新(补充图。 12)。 即使将这样的替代模型应用于数据,与LC条件相比,HC中的学习速率参数显着更大(补充图。 12b,f)同时参数 β 显示无差异(补充图。 12d,h)。 因此,我们关于在HC条件下放大RPE信号的发现对于适合于数据的RL模型的形式是稳健的。

讨论

我们研究了付费成本对奖励预测线索的价值以及中脑多巴胺神经元的阶段性反应的影响。 猴子在表现出较大成本的行动后,对奖励预测线索的估值有所提高。 在产生更高的成本后,多巴胺神经元对奖励预测线索和奖励传递的响应增加。 此外,当需要更高的成本来获得奖励时,猴子表现出更快的学习速度。

一些研究表明,付费成本增加了对奖励预测线索的偏好1,2,3。 在本研究中,与LC条件下的猴子相比,猴子对HC条件下的奖励预测线索显示更快的RT,与奖励线索值通过付费成本增强的可能性一致27。 另一种可能性是,与HC条件下对扫视目标的关注增加相关的固定时间更长,因此,在HC试验中更长时间固定后减少了RT。 然而,在HLC不确定任务的HC和LC试验中,我们没有发现RT与R cues之间的任何差异。 此外,在HLC勘探会议的前半部分。 在HC和LC试验之间,R提示的RT没有显着差异。 因此,这些发现表明,对于奖励预测线索观察到的较短RT,较长的固定不是可能的解释。 除了付费成本对奖励线索RT的影响之外,尽管在线索演示之后没有提供奖励,但成本也影响了对非预测线索的RT。 先前的一项研究报告了类似的现象,因为在每个区块内的替代试验中使用更优选的奖励时,猴子受试者在无奖励试验中显示较短的RT30。 对该研究中的效果的一种可能的解释是,在具有更优选奖励的块中响应的整体更高的动机也影响了RT,也阻止了该块内的无奖励线索。 同样,在本研究中,对HC试验中更有价值的奖励的期望可能已经将RTs调整为我们任务中HC试验中的无奖励线索。 此外,付费成本对奖励线索的RT的影响小于无奖励预测线索的影响。 这很可能是因为猴子对R的扫视速度更快LC首先是+提示,减少了检测R到RT的缩短的范围HC+提示。 因此,R +提示之间的RT差异将因此而变小。

猴子还在R之间进行了选择试验HC 和RLC 在HLC任务中提示。 然而,虽然猴子S表现出对R的偏爱HC+提示到R.LC+提示,猴子P没有表现出这种偏好。 这种差异可以通过HLC扫视和选择试验之间的背景差异来解释。 在选择试验中,提出了两个奖励预测线索而不是一个奖励预测线索。 此外,即使他们选择了奖励预测线索,猴子在选择后也没有获得奖励,因此选择测试是在灭绝时完成的。 实施灭绝程序是为了确保猴子的选择是由努力试验中学到的东西驱动的,而不是与选择试验的新学习相混淆。 然而,这个过程可能具有副作用,即猴子可以快速学会识别选择背景中的消退程序,并且没有理由选择更优选的刺激。 然而,其中一只猴子确实表现出对HC条件下的奖励提示的偏好。

在提出预测后续支付费用要求的提示时,多巴胺神经元的活动减少,与先前的研究一致22,23。 在我们的研究中,我们没有观察到相对于基线响应HC和LC线索的多巴胺神经元的总体减少。 这表明尽管存在以下成本,但在该时间点不会发生负RPE信号。 消极RPE的缺失可能反映了对试验后期预期的未来奖励的预测的整合。 多肽神经元在LC试验中显示出显着的活化,并且与HC试验相比活性更高。 这表明成本信息被并入多巴胺神经元携带的RPE信号中。 因此,多巴胺神经元编码奖励和成本信息,RPE响应反映成本和奖励的总和。

我们证明了由多巴胺神经元代表的RPE信号通过奖励线索呈现点(在HLC扫视任务中)和奖励传递(在HLC不确定任务中)的付费成本来增强。 HC和LC试验中提供的客观奖励数额相等; 因此,RPE信号的修改应该由非感觉过程引起。 一些研究支持这种可能性,表明多巴胺RPE信号的背景效应与多巴胺神经元的主观价值和/或效用的处理一致11,19,20,21,31,32,33,34。 如果RPE信号较大,则应该更快速地更新提示值,这将因此影响刺激 - 奖励关联的学习速度。 以前的研究表明,非感觉因素可以改变学习速度24,35。 与此一致,猴子相对于LC条件表现出更快的HC学习速度。 我们发现通过具有放大RPE的RL模型可以解释通过付费成本提高学习速度。 在我们的实验中很难区分放大的RPE的效果和提高的学习率; 然而,我们在HC条件下发现了扩增的多巴胺能RPE信号。 此外,先前的fMRI研究表明,学习率参数在前扣带皮层中表示,并且VTA的活动与易变环境中的学习率参数无关。36。 因此,我们认为由多巴胺神经元编码的RPE信号通过付费成本放大,并且增加的RPE信号提高了学习速度。

当在奖励提示呈现和奖励递送时生成RPE信号时,猴子已经支付了费用。 因此,增强RPE信号的一种可能机制是在HC之后获得的奖励可能更有益。 HC之后对更有价值的奖励的期望越来越高,可能会提高完成试验的动力,从而缩短HC试验中的奖励线索的RT。

对我们的结果的另一种可能的解释是,终止昂贵的行动所带来的救济可以作为对猴子的奖励。 功能磁共振成像(fMRI)研究表明,缓解疼痛可能是对人类参与者的一种奖励37,38; 因此,成本可能会起到与痛苦的厌恶刺激相似的作用。 如果减轻成本是有益的,并且如果这反映在多巴胺能活动中,我们会期望多巴胺神经元在长期固定结束时作出反应,这是奖励提示呈现的时间。 然而,我们没有观察到奖赏提示呈现时多巴胺能活性的任何差异,也没有观察到在HLC不确定任务中HC和LC试验之间的R值与RT值的任何差异。 因此,我们建议减少成本并不能为我们在多巴胺神经元中观察到的效果提供充分的解释。

此外,与成本预测线索相比,多巴胺神经元对厌恶刺激显示出定性不同的反应。 对此的一个可能的解释是,努力成本不如吹气或奖励那么显着,因为当猴子进行固定而不是点状时,努力成本在几秒钟内暂时延长。 因此,多巴胺神经元可能尚未被激活到较不显着的成本线索。 另一种可能性是突出型多巴胺神经元对事件作出反应,之后诱导一些运动。 当奖励或吹气被传递给猴子时,它们会做出一些动作,如舔或眨眼。 然而,在HLC扫视任务中,猴子必须将目光保持在固定目标上,而不需要任何移动作为成本。 实际上,最近的一项研究表明,除非正确启动运动,否则在奖励预测线索后伏核中的多巴胺释放会减弱39。 因为我们的实验中的成本不涉及运动开始,这可能潜在地导致显着型多巴胺神经元的不一致反应。 无论哪种方式,我们都可以得出结论,成本信息的处理方式与厌恶信息的处理方式不同。

总之,我们建议付费用会增加奖励预测线索的价值,这反过来会增加中脑多巴胺神经元中编码的RPE信号。 这种效应导致行为预测,即根据HC的经验,动物的学习速度将被提高以用于奖励预测线索。 这确实是我们观察到的。 因此,我们对多巴胺神经元活动的观察使我们假设行为效应的存在,以及这种效应背后的推定计算机制,我们随后证实了这一点。 因此,我们的研究结果代表了在神经数据,计算理论和行为的测量之间如何发生三角测量的一个例子:开发对大脑中神经元处理的更深入理解可以产生关于行为及其潜在计算基础的见解。

方法

动物

我们用了两只雄性日本猴子(猕猴(Macaca fuscata); 体重,6.5 kg =猴子P; 体重,9.0 kg =猴子S)。 我们在猴子头骨的顶部植入了一个头柱,以便以后可以固定在椅子上。 还植入记录室以便能够安装电极微操纵器。 记录室在冠状平面中横向倾斜45°并定位在立体定位坐标:外耳道前方15 mm处。 恢复期后,训练猴子进行扫视任务。 完成训练后,我们在记录室内的头骨上钻了一个孔,用于插入电极。 所有动物护理方案均由多摩川大学动物实验委员会批准,并符合美国国立卫生研究院实验动物护理和使用指南。

行为任务

训练猴子进行HLC扫视任务(图。 1a),HLC不确定任务(图。 5a)和HLC勘探任务(图。 7a)。 所有任务均在暗室中执行。 猴子坐在22英寸前面的椅子上。 LCD显示器(S2232W,Eizo),其植入的头枕固定在椅子上。 他们的眼睛和显示器之间的距离为70厘米。 当显示器的中心出现起始提示(白色圆圈,直径0.3°)时,要求猴子保持其对提示的凝视。 750 ms之后,开始提示消失了,然后显示了成本提示(分别用于HC和LC试验的星型和风车)。 在提示提示的750毫秒内,要求猴子跟踪提示提示的费用。 如果他们不了解提示,那么该试验将被中止并再次开始相同的试验。 在HC试验期间,在0.3毫秒(HLC扫视和HLC不确定任务)或0.3毫秒(HLC探索任务)的成本提示消失之后,提出了固定目标(2000°×1500°白色正方形),并且需要了猴子扫视它并保持凝视。 如果猴子将视线移到4°×4°的固定窗口之外,则任务将中止。 固定点出现后400毫秒激活了固定窗口,因为猴子需要时间来准备扫视和调整其固定。 因此,在HC试验中,猴子必须固定至少1600 ms(HLC扫视和HLC不确定任务)或1100 ms(HLC探索任务)。 在LC试验中,空白屏幕显示1500 ms(HLC扫视和HLC不确定任务)或1000 ms(HLC探索任务),然后出现固定目标500 ms。 由于在展示固定点后400毫秒内激活了固定窗口,因此在LC试验中要求猴子将其固定在目标上至少100毫秒。 在HC试验中,猴子表现出更多错误; 因此,在LC试验中,在奖励提示提示之前100毫秒(在注视目标提示之后400毫秒,这是注视窗口开始的时间)随机插入强制终止,以使成功率相等。 固定在目标上后,提出一两个奖励提示,并要求猴子扫视提示。 如果他们成功完成了对奖励提示的扫视,则在奖励提示提示后750毫秒会发出哔声。 当猴子对R +提示进行扫视时,在发出哔哔声的同时会递送0.3毫升水。 当他们对R-提示进行扫视时,没有得到任何回报。

在HLC扫视任务中,使用四个彩色圆圈作为奖励提示(RHC+:黄色; [RHC - :绿色; [RLC+:粉红色; [RLC - :蓝色; 图。 1a)。 一个实验会议包括80个扫视试验,20个不可预测的奖励试验,20个不可预测的吹气试验和5个选择试验。 扫视试验包括40项HC试验和40项LC试验,两者均包括20项奖励试验和20项无奖励试验。 在无法预测的奖励或吹气试验中,将0.3 ml的水奖励或0.2 MPa的吹气(猴子P为150毫秒;猴子S为200毫秒)传递到猴子的脸上而没有提示。 选择试验包括一项试验,其中猴子在R +提示(RHC+与R.LC+)在HC试验中,在R-提示之间(RHC- 对阵R.LC- )在HC试验中,在R +之间(RHC+与R.LC+)LC试验中的提示,R-(RHC- 对阵R.LC- )LC试验中的提示,以及成本提示之间的补充(补充图。 1)。 在奖励提示之间进行选择的试验中,任务结构与奖励提示呈现之前的扫视任务相同。 接下来,代替呈现奖励提示,在选择试验中呈现两个奖励提示,并且在奖励提示呈现之后没有奖励,即使猴子在R +提示之间做出选择。

为了测试多巴胺神经元对奖励传递的反应,猴子进行了HLC不确定任务(图。 5a)。 除了奖励提示之外,此任务类似于HLC扫视任务。 在这项任务中,我们使用了两个奖励线索(而不是HLC扫视任务中使用的四个奖励线索),一个用于HC试验,另一个用于LC试验。 在奖励线索演示之后,奖励是在一半的试验中提供的。 一个实验课程包括80扫视试验,20不可预测的奖励试验和20不可预测的空气抽吸试验。 扫视试验包括40 HC试验和40 LC试验,这两项试验均包括20奖励试验和20无奖励试验。 在不可预测的试验中,没有任何提示就可以获得奖励或吹气。

在HLC探索任务中,有两个奖励线索(RHC+,RHC- 或者R.LC+,RLC- )同时呈现,猴子被要求扫射到其中一个奖励线索(图。 7a)。 如果他们选择了R +提示,他们会获得水奖励。 四个奖励线索(RHC +,HC- ,RLC +,LC - )为每次探索会话生成,并且要求猴子学习提示之间的关联并且逐个试验奖励。 一个实验阶段包括100 HC试验和100 LC试验。 我们发现,对于探索任务,如果我们在HC条件下将固定持续时间设置为2000 ms以使其与其他任务中的HC条件的持续时间匹配,那么猴子以非常低的成功率执行任务可能是因为任务的难度和/或随之而来的低回报率。 因此,为了减少任务的难度并提高成功率,我们使用1500 ms固定持续时间作为HLC探索任务的成本。

使用市售软件包(TEMPO,Reflective Computing,St.Louis,MO,USA)控制任务。 使用应用程序编程接口(OpenGL)的定制程序用于视觉刺激呈现。 成本和奖励线索的视觉刺激是由作者创造的。

记录和数据采集

使用MR图像估计黑质的位置。 使用安装在记录室上的显微操纵器(MO-0.25,Narishige,Tokyo,Japan)将环氧树脂涂覆的钨电极(柄直径,0.5 mm,1.5-1000MΩ,以972 Hz,FHC测量)插入黑质中。不锈钢导管。 电压信号被放大(×10,000)并被滤波(0.5-2 kHz)。 使用模板匹配算法(OmniPlex,Plexon,Dallas,TX,USA)分离来自单个神经元的动作电位。 通过红外摄像机系统以500 Hz(iView X Hi-Speed Primate,SMI,Teltow,Germany)的采样率监测眼睛运动。 以1 kHz的时间分辨率记录动作电位和行为事件的时间。

数据分析

为了分析猴子的行为,将RT确定为刺激开始与猴子开始扫视之间的时间间隔。 通过计算凝视位置在提示呈现之前超过与平均凝视位置的5标准偏差的时间来确定扫视起始。

在HLC探索任务中,通过拟合累积指数函数来量化猴子的选择行为。 功能 (P)描述正确选择的比例如下:

哪里 t 意味着试验, a 和 b 分别表示曲线的斜率和平台。 该功能独立于两种成本条件的数据。 搜索函数的参数以最大化观察来自单个会话的数据和平均数据的可能性。 应用自举方法来估计拟合平均数据时的置信区间。 标准RL模型也用于量化行为数据。 刺激价值 Vj(t)为选择的选择 j (j HC条件= 1; j = LC条件为2)更新如下:

哪里 αj 表示学习率,它们被限制在0和1之间的值。 R(t)表示审判时的奖励金额(1:奖励,0:无奖励) t.

概率 Pj(t)选择刺激 j 试验中的两个刺激 t 由softmax规则给出

哪里 βj 表示探索的范围。

我们记录了HLC扫视和HLC不确定任务期间的神经元活动,但未记录HLC探索任务。 HLC探索任务是作为纯粹的行为研究实施的。 如果多巴胺神经元表现出以下每种特性,则可以识别它们:低强音发射率(<6 Hz),尖峰波形的持续时间长(> 300μs)以及对不可预测奖励的相位响应(补充图。 2a)。 我们分析了猴子可以完成试验而没有任何错误的试验(制动固定,没有扫视或人工中止)。 平均神经元放电率用1 ms箱计算并用高斯核平滑(σ = 30毫秒,宽度= 4σ)产生尖峰密度函数。 将多巴胺神经元对每个任务事件的响应计算为相对于自发活动的标准化放电率(在开始提示开始之前的500 ms期间的平均放电率)。 在针对每个任务事件和主题确定的时间窗口内计算发射率。 这些时间窗口是根据人口平均活动确定的。 我们使用先前的猴多巴胺研究作为参考,定义了基于群体平均响应的上升和下降时间确定的时间窗的起点和终点(补充图。 3)。 从猴子P和S记录的神经元开始提示开始后,开始提示的时间窗口定义为200-400 ms。条件提示的时间窗口被定义为猴子P的病情提示开始后的150-300 ms和猴子S的200-400 ms。奖励提示的时间窗口被定义为猴子P的奖励提示开始后的140-350 ms和猴子S的220-420 ms.奖励提供的时间窗口被定义为225-猴子P的哔哔声开始后的475 ms和猴子S的200-450 ms的时间窗口。不可预测的奖励交付的时间窗口被定义为猴子P的奖励递送后的100-300 ms和猴子S的150-300 ms。不可预测的空气抽吸的时间窗口被定义为猴子P的空气抽吸传递后的30-230 ms和猴子S的50-200 ms。

我们将所有记录的多巴胺神经元分为两类,即动机价值和显着性类型。 如果神经元对吹气刺激的反应小于自发活动,则将神经元归类为动机价值类型(图XNUMX)。 3d,e)。 相反,如果神经元对气喘刺激的反应大于自发活动,神经元被归类为显着类型(图2)。 3g,h).

为了量化任务条件之间的差异神经元活动,进行了ROC分析。 我们计算了每个神经元的auROC。 auROC小于或大于0.5分别表示HC试验中的响应较小或较大。 由于某些神经元数据集中的神经元数量很少,因此我们使用Wilcoxon的符号秩检验来减少异常值对auROC的有偏分布进行量化的影响。

使用市售软件MATLAB(MathWorks,Natick,MA,USA)进行所有数据分析。

组织学检查

在记录实验后,对两只猴子实施安乐死并进行组织学分析以验证记录位置(补充图。 2b)。 通过施用致死剂量的戊巴比妥钠(70 mg kg)使猴子安乐死 - 1)并用磷酸盐缓冲液中的4%甲醛灌注。 切割连续冠状切片(厚度,10μm)并用抗酪氨酸羟化酶(TH)抗体(每个25切片;抗TH抗体,1:500; Merck,Darmstadt,德国)或Nissl染色(每个25切片)进行免疫染色。 。

报告摘要

有关研究设计的更多信息,请参阅 自然研究报告摘要 链接到这篇文章。

代码可用性

用于本研究分析的Matlab代码可在合理要求下从相应作者处获得。

参考资料

- 1.

克莱门特(Clement),TS,费特斯(Feltus),JR,凯撒(Kaiser),DH和Zentall,TR在鸽子中的“职业道德”:奖励价值直接与获得奖励所需的努力或时间有关。 Psychon。 公牛。 启示录 7,100-106(2000)。

- 2.

Klein,ED,Bhatt,RS和Zentall,TR对比和努力的理由。 Psychon。 公牛。 启示录 12,335-339(2005)。

- 3.

Zentall,TR&Singer,RA审判内对比:鸽子更喜欢适应性强的强化剂,这些强化剂遵循相对多而不是较少厌恶的事件。 J. Exp。 肛门。 Behav。 88,131-149(2007)。

- 4.

Aronson,E.&Mills,J.起始严重程度对一组人的喜好影响。 J. Abnorm。 SOC。 心理学。 59,177-181(1959)。

- 5.

费斯廷格 认知不协调理论。 (斯坦福大学出版社,加利福尼亚州,1957)。

- 6.

J. Alessandri,JC,Darcheville,Y。&Zentall,TR的Delevoye-Turrell偏好获得更大努力和更大延迟的奖励。 学习行为。 36,352-358(2008)。

- 7.

舒尔茨(W. Schultz),卡里里(RM)和怀特曼(Wightman),RM阶段性多巴胺信号:从主观奖励价值到正式的经济效用。 CURR。 奥平。 Behav。 科学。 5,147-154(2015)。

- 8.

舒尔茨(W. Schultz),达扬(Dayan)和蒙塔古(Montague),预测和奖励的神经基础。 科学 275,1593-1599(1997)。

- 9.

Bromberg-Martin,ES,Matsumoto,M。和Hikosaka,O。多巴胺在动机控制方面:奖励,厌恶和警觉。 神经元 68,815-834(2010)。

- 10.

拜耳,HM&Glimcher,PW中脑多巴胺神经元编码定量奖励预测误差信号。 神经元 47,129-141(2005)。

- 11.

Nakahara,H.,Itoh,H.,Kawagoe,R.,Takikawa,Y.&Hikosaka,O.多巴胺神经元可以代表上下文相关的预测误差。 神经元 41,269-280(2004)。

- 12.

Tobler,PN,Fiorillo,CD&Schultz,W.多巴胺神经元对奖励价值的自适应编码。 科学 307,1642-1645(2005)。

- 13.

Nomoto,K.,Schultz,W.,Watanabe,T.和Sakagami,M.暂时将多巴胺反应扩展到感知上要求奖励预测性刺激。 J.Neurosci。 30,10692-10702(2010)。

- 14.

Watabe-Uchida,M.,Zhu,L.,Ogawa,SK,Vamanrao,A.&Uchida,N.直接输入中脑多巴胺神经元的全脑图谱。 神经元 74,858-873(2012)。

- 15.

田中,SC等人。 预测即时和未来奖励差异性地招募皮质 - 基底神经节环。 纳特。 神经科学。 7,887-893(2004)。

- 16.

奖赏相关的皮层输入在灵长类中与关联的皮层连接对接的灵长类动物中较大的纹状体区域,为基于激励的学习提供了基础。 J.Neurosci。 26,8368-8376(2006)。

- 17.

Doya,K。决策调节器。 纳特。 神经科学。 11,410-416(2008)。

- 18.

Roesch,MR,Calu,DJ&Schoenbaum,G.多巴胺神经元在大鼠中编码更好的选择,以决定不同的延迟或大小的奖励。 纳特。 神经科学。 10,1615-1624(2007)。

- 19.

Lak,A.,Stauffer,WR&Schultz,W.多巴胺预测误差反应整合了来自不同奖励维度的主观价值。 PROC。 Natl Acad。 科学。 美国 111,2343-2348(2014)。

- 20.

Stauffer,WR,Lak,A.&Schultz,W.多巴胺奖励预测误差反应反映了边际效用。 CURR。 生物学。 24,2491-2500(2014)。

- 21.

Noritake,A.,Ninomiya,T.&Isoda,M.猕猴大脑中的社会奖励监控和评估。 纳特。 神经科学。 21,1452-1462(2018)。

- 22.

Pasquereau,B.&Turner,RS在成本效益权衡任务中对多巴胺神经元的努力进行有限编码。 J.Neurosci。 33,8288-8300(2013)。

- 23.

Varazzani,C.,San-Galli,A.,Gilardeau,S.&Bouret,S.去甲肾上腺素和多巴胺神经元在奖赏/努力之间的取舍:行为猴子的直接电生理比较。 J.Neurosci。 20,7866-7877(2015)。

- 24.

纹状体-扁桃体相互作用增强了奖励预测误差信号,这说明情绪可以促进概率性奖励学习。 J.Neurosci。 33,4487-4493(2013)。

- 25.

Di Ciano,P.,Cardinal,RN,Cowell,RA,Little,SJ&Everitt,B.NMDA,AMPA /红藻氨酸盐和多巴胺受体在伏伏核核心中的差异参与,涉及巴甫洛夫进路行为的获取和表现。 J.Neurosci。 21,9471-9477(2001)。

- 26.

Flagel,SB等。 多巴胺在刺激 - 奖励学习中的选择性作用。 自然 469,53-57(2011)。

- 27.

Blough,DS启动,可辨别性和强化对鸽子视觉搜索的反应时间成分的影响。 J. Exp。 心理学。 动画。 Behav。 处理。 26,50-63(2000)。

- 28.

Matsumoto,M.和Hikosaka,O。两种类型的多巴胺神经元分别传达积极和消极的激励信号。 自然 459,837-841(2009)。

- 29.

Matsumoto,M.&Takada,M.中脑多巴胺神经元中认知和动机信号的不同表示。 神经元 79,1011-1024(2013)。

- 30.

Watanabe,M。等。 行为反应反映了猴子的不同奖励期望。 进出口。 Brain Res。 140,511-518(2001)。

- 31.

Takikawa,Y.,Kawagoe,R.&Hikosaka,O.中脑多巴胺神经元在扫视与位置-奖励映射的短期和长期适应中的可能作用。 J.神经生理学。 92,2520-2529(2004)。

- 32.

Kobayashi,S.&Schultz,W.奖励延迟对多巴胺神经元反应的影响。 J.Neurosci。 28,7837-7846(2008)。

- 33.

Enomoto,K。等。 多巴胺神经元学会编码多个未来奖励的长期价值。 PROC。 Natl Acad。 科学。 美国 108,15462-15467(2011)。

- 34.

Lak,A.,Nomoto,K.,Keramati,M.,Sakagami,M.&Kepecs,A.中脑多巴胺神经元表示在感知决策过程中对选择准确性的信念。 CURR。 生物学。 27,821-832(2017)。

- 35.

威廉姆斯,文学士和麦克德维特,文学硕士抑制和超条件。 心理学。 科学。 13,454-459(2002)。

- 36.

伯伦斯(Tehr),TE,伍尔里奇(Woolrich),MW,沃尔顿(Walton),缅因州(ME)和拉什沃思(MF) 纳特。 神经科学。 10,1214-1221(2007)。

- 37.

Seymour,B。等。 对手的食欲 - 厌恶神经过程构成了对疼痛缓解的预测性学习的基础。 纳特。 神经科学。 8,1234-1240(2005)。

- 38.

Kim,H.,Shimojo,S。和O'Doherty,JP避免厌恶性结果会有所收获吗? 人脑中避免学习的神经基础。 PLoS Biol。 4,e233(2006)。

- 39.

Syed,EC等人。 动作启动形成中脑边缘多巴胺编码的未来奖励。 纳特。 神经科学。 19,34-36(2016)。

致谢

MEXT / JSPS科学研究助剂(Kakenhi)资助JP16H06571和JP18H03662给MS这项研究得到了日本医学研究与发展局(AMED)支持的脑科学战略研究计划的部分支持。 )和日美脑研究合作计划。 该研究得到了日本医学研究与开发机构AMED国家生理科学研究所(NIPS)的国家生物资源项目的支持。 我们感谢Bernard W. Balleine和Andrew R. Delamater在撰写论文时提供的帮助。