자연 통신

음량 10, 문서 번호: 3674 (2019)

추상

중뇌 도파민 뉴런은 가치 예측을 업데이트하는데 사용되는 보상 예측 오차 (RPE)를 인코딩하는 것으로 알려져있다. 여기, 우리는 midbrain 도파민 뉴런에 의해 코딩 된 RPE 신호는 노력하는 단속적인 작업 수행하는 동안 깨어있는 행동 원숭이에서 도파민 뉴런에서 기록 하여 보상을 얻기 위해 지불하는 비용에 의해 변조 여부를 검사합니다. 보상을 예측하는 단서 및 보상 전달에 대한 도파민 뉴런 반응은 비용이 덜 드는 행동과 비교하여 비용이 많이 드는 행동을 수행 한 후에 증가했으며, 이는 RPE가 비용이 많이 드는 행동의 수행에 따라 향상됨을 시사합니다. 행동 수준에서, 자극 보상 보상 협회는 덜 비싼 행동에 비해 비싼 행동을 수행 한 후에 더 빨리 학습됩니다. 따라서, 행동 비용에 관한 정보는 다음의 도파민 RPE 신호를 증폭시키는 방식으로 도파민 보상 시스템에서 처리되며, 이는 높은 비용의 상황에서보다 신속한 학습을 촉진한다.

개요

인간과 동물은 적은 노력으로 동일한 보상에 비해 많은 노력을 기울인 후에받은 보상을 선호합니다.1,2,3. 노력 정당화와 같은이 효과에 대한 많은 설명이 제시되었다4,5 그리고 대비 효과6더 큰 가치는 노력을 기울인 후에 얻은 결과에 기인합니다. 그러나, 뇌에서 보상 정보의 처리가 보상을 얻기 위해 소비 된 노력에 의해 조절되는지 여부와 방법이 불분명하다.

보상에 대한 행동 적응을 촉진하는 데이 시스템의 역할을 고려할 때 특히 중뇌 도파민 시스템에 중점을 두었습니다.7,8,9. 도파민 뉴런은 기저핵에 의한 보상 예측의 학습을 촉진 할 수있는 보상 예측 오차 (RPE) 신호를 나타내는 것으로 알려져있다10,11,12,13,14,15,16,17. RPE의 강점은 보상의 수량, 품질 및 주관적인 가치 또는 유용성에 달려 있습니다7,18,19,20,21. 또한, 도파민 작용은 비용 및 / 또는 노력에 의해 조절된다22,23. 이를 바탕으로, 우리는 도파민 성 RPE 신호가 보상을 얻기 위해 지불 된 비용에 의해 직접적으로 조절 될 것이라고 가정했다. 또한, RPE 신호가 자극 보상 협회의 학습을 중재하는 데 인과 적으로 관련되어 있기 때문에24,25,26우리는 보상을 받기 위해 지불 한 비용이 경기 부양 보상 협회의 학습 속도를 직접적으로 증가시킬 것이라는 가설을 세웠다.

우리의 가설을 테스트하기 위해, 우리는 두 개의 일본 원숭이가 도약 기반의 노력 작업을 수행하는 동안 행동과 도파민 활동을 측정했습니다. 원숭이는 저비용 (LC) 행동 이후와 비교하여 고비용 (HC) 행동 후에 제시되는 보상 예측 단서에 더 빠르게 반응합니다. 보상 예측 단서에 대한 도파민 신경 세포의 활동은 유료 비용에 의해 증가합니다. 또한, 보상 보상 협회에 대한 학습 속도도 유료 비용에 의해 향상됩니다. 따라서, 보상을 얻기 위해 지불 한 비용은 도파민 뉴런에서 RPE 신호를 증가 시켜서 자극 보상 협회를 강화할 것을 제안한다.

결과

고비용 (HLC) 단속 작업

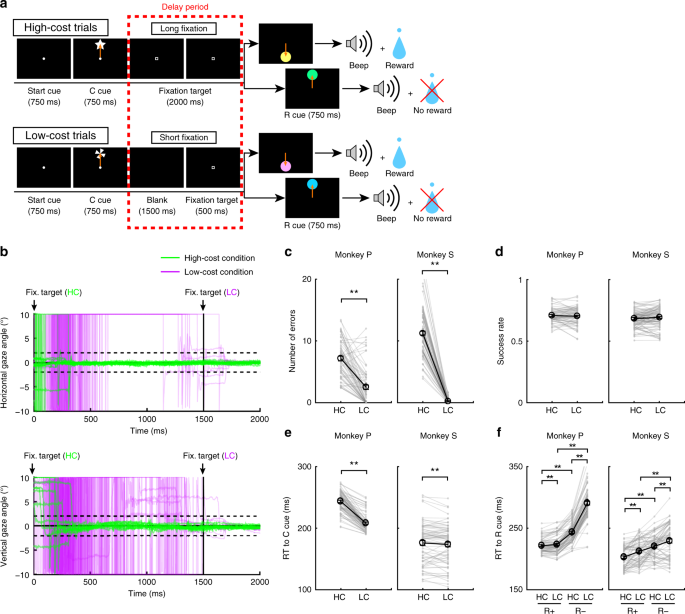

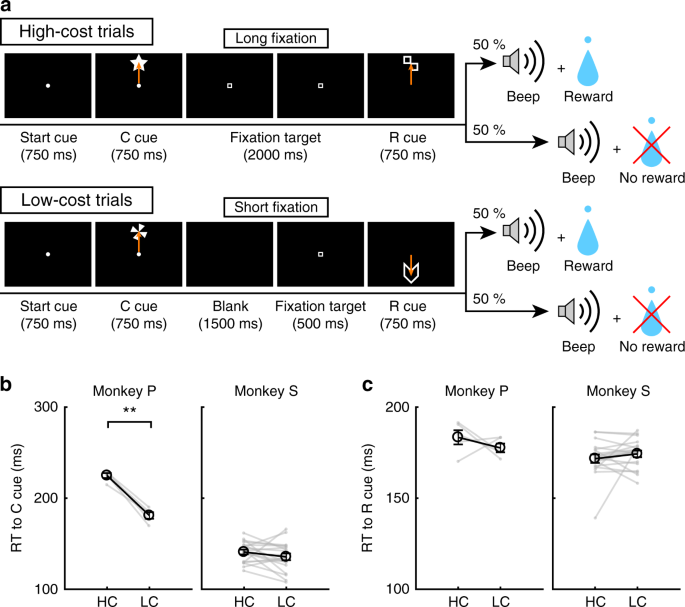

행동과 도파민 뉴런 활동에 대한 유료 비용의 영향을 조사하기 위해 원숭이는 두 가지 비용 조건으로 단속 운동을 수행했습니다 (그림. 1a방법을 참조하십시오). HC 시험에서 원숭이들은 대상을 빠르게 재빨리 쳐다 보면서 더 오랜 시간 동안 눈을 깜빡이지 않고 계속 응시했다 (그림. 1b; 녹색 선). 대조적으로, LC 시험에서 원숭이는 더 짧은 기간 동안 고정하기 전에 처음에 자유롭게 둘러 보았다 (그림. 1b, 자주색 선). 원숭이의 경우 긴 고정을 유지하기가 어렵 기 때문에 HC 시험이 지연되는 동안 더 많은 오류가 발생했습니다 (그림. 1c). HC 시험과 LC 시험 사이의 보상 확률 차이를 제어하기 위해 LC 시험의 일부에 강제 중단을 삽입하여 시험 유형 간 성공률과 보상 확률을 동일하게 만들었습니다 (그림. 1d).

HLC 단속 작업. a HLC 단속 작업. 비용 신호 (C cue)는 잠재적 인 보상을 달성하는 데 필요한 노력의 양을 나타냅니다. 고비용 시험에서 지연 기간 동안 긴 고정이 필요했습니다. 보상 신호 (R cue)는 원숭이가 보상을받을 수 있는지 여부를 나타냅니다. b 지연 기간 동안 시선 각도의 시간 경과. 상단 및 하단 패널에는 각각 수평 및 수직 시선 각도가 표시됩니다. 녹색 및 자주색 선은 각각 고비용 시험 (각 패널의 50 시험) 및 저비용 시험 (각 패널의 50 시험)에서 시선 각도를 나타냅니다. c 고비용 및 저비용 평가판에서 지연 기간 동안 발생한 오류 수 (**P < 0.01; 양 꼬리 쌍 t 시험; t67 = 8.8, P = 4.8 × 10- 15, n = Monkey P의 경우 68; t83 = 26.6, P ≈ 0, n = Monkey S의 경우 84). 검은 색 원과 오차 막대는 평균과 SEM을 나타냅니다. d 고비용 및 저비용 시험에서의 성공률 (양 꼬리 쌍) t 시험; t67 = 0.51, P = 0.61, n = Monkey P의 경우 68; t83 = 0.79, P = 0.43, n = Monkey S의 경우 84). e 비용 신호에 대한 RT (**P <0.01; 양 꼬리 쌍 t 시험; t67 = 20.4, P ≈ 0, n = Monkey P의 경우 68; t69 = 2.0, P = 1.2 × 10- 3, n = Monkey S의 경우 70). f 보상 신호에 대한 RT (**P <0.01; 양 꼬리 쌍 t 테스트; 원숭이 P (n = 68) : HC + 대 LC +, t67 = 3.5, P = 9.2 × 10- 4; HC- 대 LC-, t67 = 24.5, P ≈ 0; HC + 대 HC-, t67 = 21.6, P ≈ 0; LC + 대 LC-, t67 = 28.5, P ≈ 0; Monkey S (n = 70) : HC + 대 LC +, t69 = 5.6, P = 4.4 × 10- 7; HC- 대 LC-, t69 = 4.8, P = 8.4 × 10- 5; HC + 대 HC-, t69 = 18.0, P ≈ 0; LC + 대 LC-, t69 = 5.9, P = 1.1 × 10- 7)

유료 비용은 보상 예측 단서의 가치를 증가시킵니다

원숭이의 주관적인 단서 평가 차이에 대한 암시 적 증거를 얻기 위해 원숭이의 반응 시간 (RT)을 테스트했습니다. 특히, 원숭이가 다른 옵션보다 더 높은 주관적인 값을 다른 옵션에 할당하면 더 중요한 옵션에 대해 더 빠른 RT를 표시해야합니다.27. 비용 큐 사이에서 RT를 비교할 때, 두 원숭이는 HC 큐와 비교하여 LC에 대해 더 빠른 RT를 보였다 (도. 1e)에서 LC 조건에 대한 암시 적 선호를 보여줍니다. RT가 보상 큐 사이에서 비교 될 때, 두 원숭이는 보상이없는 (R-) 큐보다 더 빠른 RT를 보여 주었다 (R +) 큐. 1f), R + 큐가 R- 큐보다 선호됨을 나타냅니다. 또한 두 원숭이 모두 R보다 빠른 RT를 보여주었습니다.HC+ R에 비해 큐LC+ 큐와 RHC-R과 비교 한 큐LC-큐 (그림. 1f), LC 조건에 비해 HC에서 보상 예측 신호를 더 중요하게 평가했음을 나타냅니다.

또한, 우리는 큐 사이에서 원숭이의 명백한 선호도를 테스트하기 위해 HLC 단속 작업에 선택 시험을 포함시켰다 (보조 그림. 1a). 원숭이는 비용 신호 중에서 선택할 때 우선적으로 LC 신호를 선택했습니다 (보조 그림. 1b). Monkey S는 우선적으로 R을 선택했습니다HCR 사이에서 선택 작업을 수행 할 때 + 큐HC+와 RLC+ 큐, 그러나 R 사이의 선호도HC-와 RLC-신호 (보조 그림. 1c, d). 대조적으로, 원숭이 P는 R 사이에 명백한 선호를 보이지 않았다HC+와 RLC+ 단서이지만 R을 선호HC-R 중에서 선택할 때 큐HC-와 RLC-신호 (보조 그림. 1c, d).

HLC 단속 작업의 전기 생리 학적 결과

HLC 단속 작업 동안 실질 nigra pars compacta (SNc) 및 복부 Tegmental 영역 (VTA) 내에 위치한 뉴런에서 단일 단위 활동을 기록했습니다. 우리는 두 원숭이에서 70 도파민 뉴런을 확인했다 (보충 그림. 2a; Monkey P 및 S의 18 및 52 뉴런). 조직 학적 검사는 뉴런이 SNc / VTA 또는 그 주변에 위치 함을 확인했다 (보완 그림 2b).

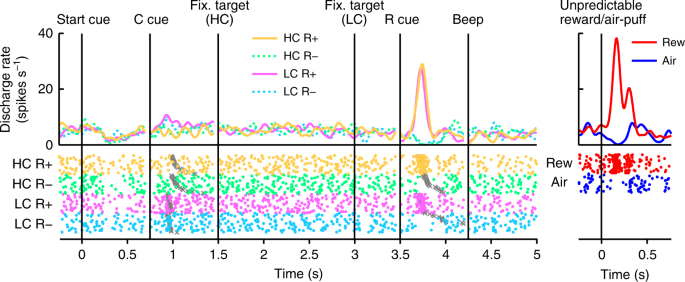

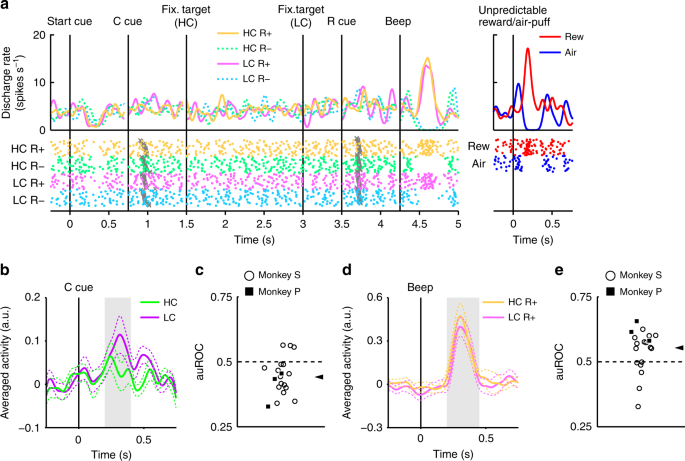

그림. 2, 우리는 대표적인 도파민 뉴런의 활동을 보여줍니다. 이 뉴런은 LC 큐에 적당한 활성화를 보였고 보상에 대한 위상 활성화 또는 억제를 보여 주었다 (RHC+와 RLC+) 또는 보상 신호 없음 (RHC-와 RLC-), 각각 (그림. 2보충 그림. 3). 뉴런은 또한 예측할 수없는 보상, 예측할 수없는 에어 퍼프에 대한 반응으로 위상 억제뿐만 아니라 예측 가능한 보상에 대한 위상 활성화를 보여 주었다 (그림. 2오른쪽 패널). 또한, 뉴런은 시작 큐에 대해 약간의 억제를 보였지만 보상 전달에 대한 반응은 없었다. 우리가 기록한 도파민 뉴런의 전체 인구는 시작 신호와 보상 전달에 대해 비슷한 반응을 보였다 (보충 그림. 4a, b). HLC 단속 업무에서는 보상을 받기 전에 인건비가 지불되었습니다. 예상 비용이 도파민 뉴런 활동을 감소 시켰기22,23, 시작 큐 발표시 도파민 뉴런 반응이 억제 될 것이다16.

HLC 단속 작업에서 대표적인 도파민 뉴런의 활성. 스파이크 밀도 함수 (가우시안 함수와 관련됨) 및 래스터 플롯은 시작 큐, 비용 큐 (C 큐), 고정 대상, 보상 큐 (R 큐) 및 경고음의 시작 타이밍에 맞춰 정렬됩니다. 각 색상은 각각 조건 (노란색 : HC +, 녹색 : HC-, 분홍색 : LC +, 시안 : LC-)을 나타냅니다. 단속 운동 시작 시간은 회색 십자로 표시됩니다. 예측 불가능한 보상 또는 에어 퍼프에 대한 도파민 뉴런의 반응도 오른쪽 패널에 표시됩니다 (빨간색 : 예측 불가능한 보상, 청색 : 예측 불가능한 에어 퍼프)

보상과 비용에 관한 도파민 뉴런 코드 정보

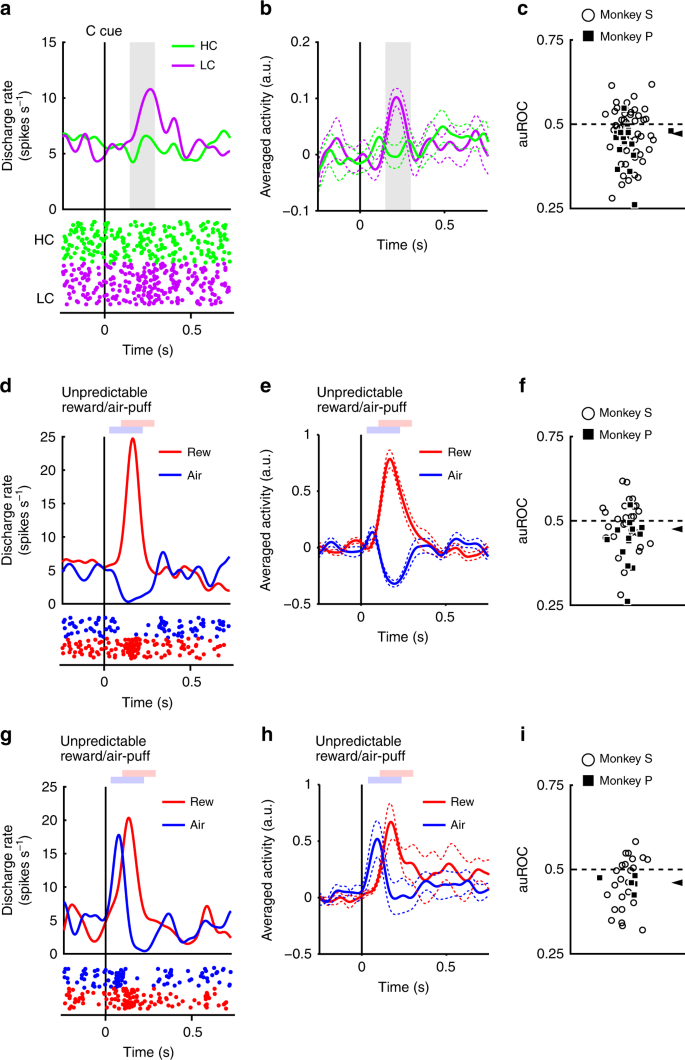

뉴런은 LC 큐에 위상 적으로 반응하지만 HC 큐에는 덜 견고합니다 (그림. 3a, b). 비용 조건 단서에 대한 유발 된 반응은 LC 단서 (양측 Wilcoxon의 부호있는 순위 검정, P 3.2 × 10 미만- 4, n = 70). 수신기 작동 특성 (ROC) 분석을 사용하여 신경 반응에 대한 예측 비용의 효과를 정량화했습니다. ROC 곡선 (auROC) 아래 영역의 분포는 유의하게 0.5 미만이었습니다 (그림. 3c; 양측 Wilcoxon의 부호있는 순위 테스트; P = 5.4 × 10- 4, n = 70), 이는 HC 큐 응답이 LC 큐보다 작음을 나타냅니다. 예상 비용은 이전에 우리의 결과와 일치하는 도파민 뉴런 활동을 감소시키는 것으로 밝혀졌습니다.22,23. 또한, 도파민 뉴런의 집단은 LC 큐에 대해 현저한 활성화를 나타내면서 HC 큐에 대한 유의 한 억제를 나타내지 않았다 (보충 그림. 4c, d). 이러한 결과는 도파민 뉴런이 비용 큐 제시시 보상 및 비용에 관한 정보를 코딩하고 통합한다는 것을 시사한다.

비용 신호에 대한 도파민 뉴런 반응. a 비용 신호에 대한 대표적인 도파민 뉴런 반응. 스파이크 밀도 함수는 원숭이 P에서 기록 된 도파민 뉴런의 정규화 된 활동으로부터 계산되었습니다. 컬러 라인은 스파이크 밀도 함수를 나타내고 색상 점은 스파이크 타이밍을 나타냅니다. 녹색과 보라색은 각각 고비용 및 저비용 시험에서의 활동을 나타냅니다. 수직선은 비용 단서 표시시기를 나타냅니다. 회색 영역은 상태 신호에 대한 응답으로 발사 속도를 계산하는 기간을 나타냅니다. b 원숭이 P에서 상태 신호까지 기록 된 도파민 뉴런의 집단 평균 활동. 실선은 각각 평균 및 SEM을 나타낸다. c ROC 아래 영역의 분포는 비용 신호에 대한 신경 반응에 대한 예측 비용의 영향을 정량화합니다. 채워진 사각형과 열린 원은 각각 원숭이 P와 S의 데이터를 나타냅니다. 화살촉은 auROC의 중앙값을 나타냅니다 (0.47). d, g 동기 부여 가치 유형 도파민 뉴런의 대표적인 반응 (d) 또는 염분 형 도파민 뉴런 (g)를 예측할 수없는 보상 또는 에어 퍼프 빨간색과 파란색 곡선은 각각 예측할 수없는 보상과 예측할 수없는 에어 퍼프에 대한 반응을 나타냅니다. 수직선은 예측할 수없는 보상 또는 에어 퍼프 전달시기를 나타냅니다. 옅은 빨간색과 파란색 사각형은 예측할 수없는 보상 또는 에어 퍼프에 대한 반응으로 발사 속도를 계산하는 기간을 나타냅니다. e, h 동기 부여 가치 유형 도파민 뉴런의 인구 평균 활동 (e) 또는 염분 형 도파민 뉴런 (h)를 예측할 수없는 보상 또는 에어 퍼프 f, i 동기 부여 값 유형 도파민 뉴런으로부터 계산 된 auROC의 분포 (f) 또는 염분 형 도파민 뉴런 (i). 화살촉은 auROC의 중앙값을 나타냅니다 (f 0.48; i 0.46)

도파민 뉴런의 두 가지 별개의 하위 유형이 이미 설명되어있다 : 동기 부여 가치 및 경감 뉴런28,29. 우리는 응답 패턴의 도파민 뉴런 인구에서 두 하위 유형과 일치하는 증거를 발견. 밸류 타입 뉴런은 혐오스러운 에어 퍼프 자극에 대한 위상 억제를 보여 주었다 (그림. 3d, e). 반대로, salience neuron은 혐오 자극에 대해 phasic activation을 보여 주었다 (Fig. 3g, h). HC 시험에서의 긴 고정은 또한 불쾌하고 혐오 스럽다. 따라서, 두 도파민 뉴런 아형은 비용 조건 단서에 대해 다른 반응 패턴을 보일 수있다. 도파민 뉴런이 유사한 방식으로 혐오 자극 및 비용을 나타내는 경우, 값 뉴런은 혐오 성으로 인해 HC 큐에 대한 감소 된 활성을 나타내야한다. 반면에, salience 뉴런은 HC 큐에 대한 활동이 증가해야합니다. 왜냐하면 그들은 또한 불쾌한 자극으로 증가하기 때문입니다. 그러나, 두 유형의 뉴런의 유발 된 반응은 LC 큐 (양측 Wilcoxon의 부호있는 순위 테스트; P = 0.021, n = 41 및 P = 0.0044, n = 각각 값 및 salience 유형에 대해 29), ROC 분석은 두 하위 유형에서 LC 큐에 비해 HC에 대한 더 작은 반응을 보여주었습니다 (그림. 3f, i; 양측 Wilcoxon의 부호있는 순위 테스트; P = 0.030, n = 41 및 P = 0.0058, n = 값 및 salience 유형에 대해 각각 29). 따라서 예측 된 비용은 도파민 뉴런의 두 하위 유형에서 활동을 감소시킵니다. 이러한 결과는 비용 정보가 혐오 자극에 대해 질적으로 다른 방식으로 도파민 뉴런에 의해 처리됨을 나타냅니다.

HLC 단속 작업에서 우리는 성공률과 시도 유형 간의 보상 확률을 균등화하기 위해 LC 시도의 일부에 강제 중단을 삽입했습니다. 이 조작은 보상 획득의 불확실성 또는 LC 상태에서 보상이 없을 위험을 증가 시켰습니다. 따라서, 도파민 뉴런의 더 높은 활성과 HC 큐에 대한 원숭이의 LC에 대한 증가 된 평가는 비용 조건 간의 위험 또는 불확실성의 차이 때문일 수 있습니다. 그러나 강제 중단 횟수와 RT의 차이 사이에는 관계가 없습니다 (보조 그림. 5a, b), 강제 중단 횟수와 auROC 사이에 양의 상관 관계가 있음을 발견했습니다 (보조 그림. 5c). 우리는 또한 도파민 반응을 중단 후와 올바른 시험 후 비용 단서에 비교했지만 두 비용 조건에서 차이를 발견하지 못했습니다 (보충 그림. 5d). 이 결과는 LC 조건에서 강제 중단의 수가 LC 큐에 대한 평가 증가 또는 도파민 활성화의 증가를 설명하지 않음을 나타냅니다.

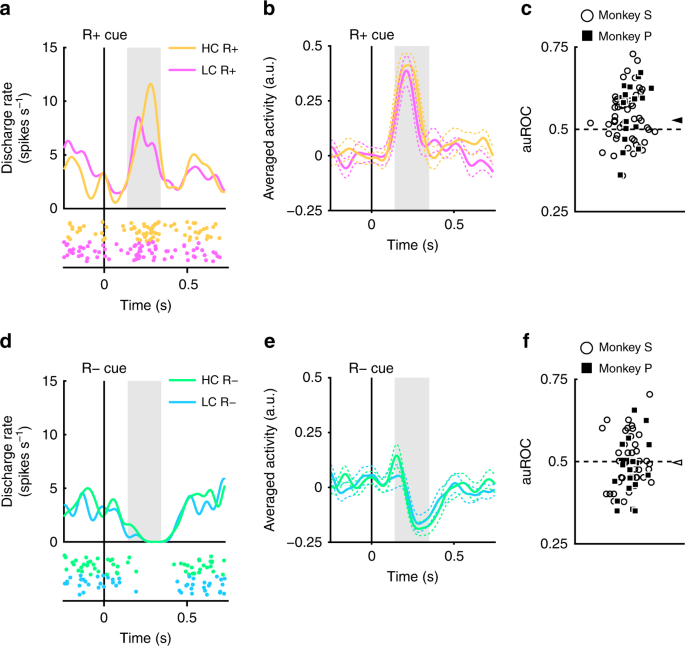

유료 비용으로 큐를 보상하기위한 도파민 반응 증가

기록 된 도파민 뉴런은 각각 보상 보상 단서를 보상하기 위해 위상 활성화 및 억제를 나타내는 것으로 밝혀졌다 (도. 2). 다음으로, 우리는 이러한 응답이 이전에 발생한 비용에 의해 조정되었는지 여부를 평가했습니다. R에 대한 더 큰 활성화를 나타내는 대표적인 뉴런 및 집단 평균 뉴런의 예HC+ R보다 큐LC+ 큐는 그림에 표시됩니다. 각각 4a 및 b. (양측 Wilcoxon의 부호있는 순위 테스트; P = 7.4 × 10- 5, n = 70). auROC의 분포는> 0.5로 R에 대한 반응이HC+ 큐는 R보다 컸다LC+ 큐 (그림. 4c; 양측 Wilcoxon의 부호있는 순위 테스트; P = 1.4 × 10- 4, n = 70). 이 결과는 HC 조건에서 보상 예측 단서에 대한 응답이 LC 조건에서보다 훨씬 더 크다는 것을 나타냅니다. 따라서, 우리의 연구 결과는 도파민 뉴런이 나타내는 양성 RPE 신호가 이전에 발생한 비용에 의해 증가한다는 것을 시사합니다.

신호를 보상하기위한 도파민 뉴런 반응. a R + 신호에 대한 예제 뉴런 반응. 원숭이 P로부터 기록 된 도파민 뉴런의 활성으로부터 스파이크 밀도 함수를 계산 하였다. 컬러 라인 및 도트는 각각 스파이크 밀도 및 스파이크 타이밍을 나타낸다. 노란색과 분홍색은 각각 고비용 및 저비용 시험에서의 활동을 나타냅니다. 수직선은 R + 큐 프레젠테이션의 타이밍을 나타냅니다. 회색 영역은 보상 큐에 대한 응답으로 발사 속도를 계산하는 기간을 나타냅니다. b 원숭이 P에서 R + 신호까지 기록 된 도파민 뉴런의 집단 평균 활동. 실선과 파선은 각각 평균과 SEM을 나타냅니다. c auROC의 분포는 R + 신호에 대한 신경 반응에 대한 유료 비용의 영향을 정량화합니다. 채워진 사각형과 열린 원은 각각 원숭이 P와 S의 데이터를 나타냅니다. 화살촉은 auROC의 중앙값을 나타냅니다 (0.53). d R 큐에 대한 대표적인 응답. 녹색과 청록색은 각각 고비용 및 저비용 시험을 나타냅니다. 수직선은 R- 큐 프리젠 테이션의 타이밍을 나타냅니다. e 원숭이 P에서 R 큐까지 기록 된 도파민 뉴런의 집단 평균 활동. f auROC의 분포는 R- 큐에 대한 신경 반응에 대한 유료 비용의 영향을 정량화합니다. 화살촉은 auROC의 중앙값을 나타냅니다 (0.50)

도파민 뉴런은 또한 R- 큐에 대한 위상 억제를 나타냈다 (도. 4d, e). 그러나, R- 큐에 대한 도파민 뉴런의 반응은 발생하는 비용의 함수로서 유의 한 차이를 나타내지 않았다 (양측 Wilcoxon의 부호있는 순위 테스트; P = 0.25, n = 70), ROC 분석은 반응 분포의 편향에 대한 증거를 나타내지 않았습니다 (그림. 4f; 윌 콕슨의 사인 테스트 P = 0.35; n = 70). 따라서 지불 된 비용은 비 보상 예측 단서에 의해 유도 된 부정적인 RPE 신호에 반영되지 않았습니다. 이것은 바닥 효과로 인해 발생할 수 있습니다. 도파민 뉴런의 자발적인 활동이 낮습니다 (약 5Hz). 결과적으로 부정적인 RPE 응답에 소비되는 비용의 차이를 적절하게 인코딩하기에 충분한 동적 범위가 없을 수 있습니다 (그림. 4d, e).

우리는 또한 값과 salience 유형 도파민 뉴런에 대한 보상 신호에 대한 유료 비용의 영향을 개별적으로 조사했지만 두 유형의 도파민 뉴런은 유사한 응답 패턴을 보였습니다 (보충 그림. 6a–h). 따라서, 지불 된 비용은 가치 및 샐리 언스 유형 도파민 뉴런 둘 다에서 신호에 대한 반응에 유사한 효과를 나타낸다.

원숭이의 실제 고정 지속 시간은 일정하지 않았지만 시험 시도에 따라 다양했다 (그림. 1b). 따라서, 보상 신호에 대한 도파민 반응은 시험마다 실제 고정 기간에 의해 조절 될 수있다. 그러나 각 비용과 보상 조건에 대해 이들 사이에 유의 한 상관 관계를 찾을 수 없었습니다 (보조 그림. 7기원 후). 또한 보상 신호에 대한 RT도 비용 및 보상 조건에 따라 조정되었습니다 (그림. 1f). 하나의 가능성은 도파민 뉴런의 반응이 시험에 의해 보상 신호에 대한 RT에 의해 설명 될 수 있다는 것이다. 그러나 RT와 보상 신호에 대한 표준화 된 도파민 반응간에 유의 한 상관 관계를 찾을 수 없었습니다 (보조 그림. 7뭐라고). 이러한 결과는 도파민 반응이 각각의 시험에서 RT 및 고정 기간 둘 다와 무관하지만, 각 유형의 시험에 대해 고정되는 요구 비용 및 예상 보상의 양에 의해 조절됨을 시사한다.

또한, LC 조건에서 강제 중단은 원숭이 조건을 개선하고 HC 조건에서 보상 신호에 대한 도파민 뉴런의 강화 된 활성화를 생성 할 수있다. 그렇다면 강제 중단의 수는 선호도 및 활성화 활성화 정도와 관련이 있어야합니다. 그러나 강제 낙태의 수는 원숭이의 선호 또는 보상 신호에 대한 도파민 뉴런의 활성화에 영향을 미치지 않았다 (보충 그림. 8). 따라서 RT에 대한 빠른 RT 및 DA 응답HC+ R보다 큐LC+ 큐는 LC 조건에서 삽입 된 강제 중단으로 인한 것이 아닙니다.

발생 비용 증가 보상에 대한 도파민 반응 증가

R + 신호에 대한 도파민 뉴런의 반응은 보상 자체에 대한 반응에서 비롯되어야합니다. 도파민 뉴런은 자극 보상 관계와 관련하여 보상 예측 신호에 대한 반응을 변경하기 때문입니다8,30. 따라서, 우리는 도파민 뉴런이 보상을 제공하기 위해 유료 비용 의존적 반응 향상을 보일 것으로 예상했다. 보상 전달에 대한 도파민 뉴런 활동을 측정하기 위해, 원숭이는 두 가지 새로운 보상 신호로 HLC 불확실한 작업을 수행했습니다 (그림. 5a). 보상 큐 보상의 절반 만 보상이 전달 되었기 때문에 보상 큐는 보상 전달을 확실하게 또는 다르게 예측하지 않았다. 이것은 (예기치 않은) 보상을받는 것에 대한 도파민 뉴런 반응성을 최대화하기 위해 수행되었으며, 비용의 함수로서 뉴런의 반응성에 대한 변조를 검출하기 위해 감도를 증가시켰다.

HLC 불확실한 작업. a HLC 불확실한 작업. 이 작업에서는 어떤 큐가 제공되었는지에 관계없이 50 %의 보상이 제공되는 불확실한 보상 큐가 사용되었습니다. b 고비용 및 저비용 시험에서 비용 신호에 대한 RT. 원숭이 P만이 HC 큐보다 LC 큐에 더 빠른 RT를 보여 주었다 (**P <0.01; 양 꼬리 쌍 t 시험; t4 = 9.0, P = 8.5 × 10- 4, n = 원숭이 P의 경우 5; t18 = 1.4, P = 0.19, n = 원숭이 S의 경우 19). 검은 색 원과 오차 막대는 평균과 SEM을 나타냅니다. c 고비용 및 저비용 시험에서 RT에 대한 보상 신호. 고비용과 저비용 조건 (양 꼬리 쌍) 사이의 보상 신호와 RT의 차이는 없었다 t 시험; t4 = 0.97, P = 0.39, n = 원숭이 P의 경우 5; t18 = 0.99, P = 0.39, n = 원숭이 S의 경우 19)

비용 큐 사이에서 RT를 비교했을 때, 원숭이 P는 HC 큐보다 LC 큐에 대해 더 빠른 RT를 보여 주었다 (도. 5b). 원숭이의 HC와 LC 조건 사이의 보상 신호와 RT의 차이는 없었다 (그림. 5c).

HLC 불확실한 작업에서, 도파민 뉴런은 LC 신호에 대해 약간의 활성화를 보였으 나 보상 예측이 아니기 때문에 보상 신호에 반응하지 않았다 (그림. 6a). 인구 전체에 걸쳐, 유발 된 반응은 LC 큐보다 HC에 대해 더 작았 다 (도. 6b; 양측 Wilcoxon의 부호있는 순위 테스트; P = 2.7 × 10- 3, n = 19), ROC 분석은 HC 단서에 대한 더 작은 반응을 보였습니다 (그림. 6c; 양측 Wilcoxon의 부호있는 순위 테스트; P = 5.5 × 10- 3, n = 19). HC 상태에서 보상 전달에 대한 뉴런 반응은 LC보다 컸습니다 (그림. 6d; 양측 Wilcoxon의 부호있는 순위 테스트; P = 0.036, n = 19). auROC의 분포는> 0.5로 LC 시험에 비해 HC에서 더 큰 보상 전달 응답을 나타냅니다 (그림. 6e; 양측 Wilcoxon의 부호있는 순위 테스트; P = 0.049, n = 19). 이 결과는 HC 평가판에서 보상 전달 응답이 향상되었으며 지불 비용이 보상 전달시 긍정적 RPE 신호를 증가 시킨다는 것을 나타냅니다.

보상 전달에 대한 도파민 뉴런 반응. a HLC 불확실한 작업에서의 대표적인 도파민 뉴런 활성. 각 색상은 조건 (노란색 : HC +, 녹색 : HC-, 분홍색 : LC +, 시안 : LC-)을 나타냅니다. 단속 운동 시작 시간은 회색 십자로 표시됩니다. 예측 불가능한 보상 및 에어 퍼프에 대한이 도파민 뉴런의 반응은 오른쪽 패널에도 표시됩니다 (빨간색 : 예측 불가능한 보상, 청색 : 예측 불가능한 에어 퍼프). b 원숭이 S에서 상태 신호까지 기록 된 도파민 뉴런의 인구 평균 활동. 녹색과 보라색은 각각 고비용 및 저비용 시험에서의 활동을 나타냅니다. 실선과 파선은 각각 평균과 SEM을 나타냅니다. 회색 영역은 상태 신호에 대한 응답으로 발사 속도를 계산하는 시간 창을 나타냅니다. c 비용 신호에 대한 신경 반응에 대한 예측 비용의 효과를 정량화하기위한 auROC의 분포. 채워진 사각형은 원숭이 P의 데이터를 나타냅니다 (n = 3) 및 열린 원은 원숭이 S (n = 16). 화살촉은 auROC (0.44)의 중앙값을 나타냅니다. d 원숭이 S로부터 보상 전달까지 기록 된 도파민 뉴런의 집단 평균 활동. 노란색과 분홍색은 각각 고비용 및 저비용 시험에서의 활동을 나타냅니다. 회색 영역은 보상 배송에 대한 응답으로 발사 속도를 계산하는 시간 창을 나타냅니다. e 보상 비용에 대한 뉴런 반응에 대한 유료 비용의 영향을 정량화하기위한 auROC의 분포. 화살촉은 auROC의 중앙값을 나타냅니다 (0.55)

또한 보상이없는 상태에서 도파민 반응을 비교했습니다. auROC는 편향된 분포를 보여주지 않았으며, 결과적으로 유료 비용이 결과 RPE에 부정적인 영향을 미치지 않음을 나타냅니다 (보조 그림. 9a). 도파민 뉴런은 R에 대한 반응 사이에 차이를 보이지 않았다HC 및 RLC 신호 (보조 그림. 9b).

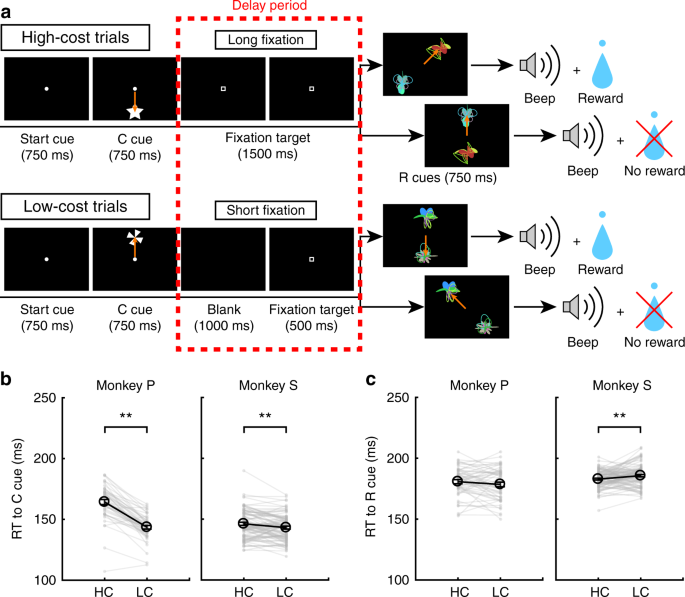

발생 비용은 학습 속도를 향상시킵니다

보상 전달에 대한 RPE가 유료 비용만큼 증가한다는 점을 감안할 때, RPE가 자극-보상 학습을 매개하는 데 직접 관여한다는 가설 하에서 향상된 학습 속도를 통해 향상된 RPE가 학습 행동에 반영 될 것으로 예상했습니다.24. 학습에 대한 유료 비용의 영향을 테스트하기 위해 원숭이는 HLC 탐사 작업을 수행했습니다 (그림. 7a; 방법 참조). 이 작업에서는 두 개의 보상 신호 (R + 및 R-)가 동시에 제공되었으며 원숭이는 하나를 선택해야했습니다. 시험 유형 (양 꼬리 쌍)간에 성공률과 보상 확률을 균등화했습니다. t 시험; t48 = 0.15, P = 0.89, n = 원숭이 P의 경우 49; t85 = 1.2, P = 0.25, n = 원숭이 S의 경우 86). 비용 단서에 대해 RT를 비교했을 때 두 원숭이 모두 HC 단서보다 LC 단서에 대해 더 빠른 RT를 보여주었습니다 (그림. 7b; 쌍 꼬리 쌍 t 시험; t48 = 12.9, P ≈ 0, n = 원숭이 P의 경우 49; t85 = 3.4, P = 9.4 × 10- 4, n = 원숭이 S의 경우 86). RT를 보상 신호와 비교할 때 원숭이 S는 LC 조건보다 HC에서 더 빠른 RT를 보여주었습니다 (그림. 7c; 쌍 꼬리 쌍 t 시험; t48 = 1.3, P = 0.19, n = 원숭이 P의 경우 49; t85 = 2.8, P = 6.8 × 10- 3, n = 원숭이 S의 경우 86). 학습 세션의 전반 및 후반 동안 RT를 개별적으로 비교할 때 LC 큐에 대한 RT는 첫 번째 동안 HC 큐보다 빠릅니다 (보충 그림. 10a) 및 세션 후반부 (보조 그림. 10c). 반대로, HC 조건에서 보상 큐에 대한 원숭이 S의 RT는 세션의 후반에만 LC 조건에서보다 빠르다 (보완 그림. 10d)이지만 상반기는 아닙니다 (보조 그림. 10b).

HLC 탐사 작업. a HLC 탐사 작업. 이 작업에서 원숭이는 각 학습 세션에서 무작위로 생성 된 R +와 R- 큐 중에서 선택해야했습니다. 만약 그들이 R + 큐를 선택했다면 보상을 얻을 수 있고, R 큐를 선택하면 보상을 얻지 못할 것입니다. b 고비용 및 저비용 시험에서 비용 신호에 대한 RT. 원숭이들은 저렴한 단서에 더 빠른 RT를 보여 주었다 (**P < 0.01; 양 꼬리 쌍 t 테스트). 검은 색 원과 오류 막대는 평균과 SEM을 나타냅니다. c 고비용 및 저비용 시험에서 RT에 대한 보상 신호. 원숭이 S는 고가의 조건에서 보상 신호에 대해 더 빠른 RT를 보여주었습니다.

HLC 탐사 과제에서, 보상 학습 신호는 각 학습 세션에서 무작위로 생성되었습니다. 따라서 원숭이들은 각 세션에서 보상 신호와 보상 사이의 관계를 배워야했습니다. 세션 내에서 시험이 진행됨에 따라 원숭이들은 각 비용 조건에서 R + 큐를 더 자주 선택했습니다 (그림. 8a). 학습 속도를 정량화하기 위해 두 개의 자유 매개 변수를 통합하여 누적 지수 함수를 데이터에 맞 춥니 다. a 및 b, 곡선의 기울기와 고원을 각각 나타냅니다 (보조 그림. 11a, b). 가파름 매개 변수 사이의 로그 비율 (log aHC/aLC)는 LC 시험보다 HC에서 더 큰 가파른 변수를 나타내는 0보다 현저히 컸다 (그림. 8b; 양 꼬리 t 시험; t48 = 2.1, P = 0.042, 평균 = 0.58, n = 원숭이 P의 경우 49; t85 = 2.5, P = 0.013, 평균 = 0.19, n = 원숭이 S의 경우 86). 고원 매개 변수 간의 로그 비율 (log bHC/bLC), 비용 조건간에 차이가 없음을 나타내는 0과 다르지 않았습니다 (그림. 8c; 양 꼬리 t 시험; t48 = 0.76, P = 0.45, 평균 = −0.0024, n = 원숭이 P의 경우 49; t85 = 0.56, P = 0.58, 평균 = 0.010, n = 원숭이 S의 경우 86). 이 결과는 HC 시험에서 학습 속도가 더 빠르다는 것을 나타냅니다. 다음으로 강화 학습 (RL) 모델을 사용하여 학습 곡선을 모델링했습니다 (방법 참조). 이 모델에는 학습률 매개 변수 (αHC 및 αLC) 및 탐사 속도 (βHC 및 βLC) 두 비용 조건 모두에 대해 (보조 그림. 11c, d). 행동에 적합 할 때 학습 속도 매개 변수 사이의 로그 비율 (log αHC/αLC)는 0보다 컸으며 LC 시험보다 HC에서 학습률 매개 변수가 상당히 더 컸음을 나타냅니다 (그림. 8d; 양 꼬리 t 시험; t48 = 2.3, P = 0.026, 평균 = 0.50, n = 원숭이 P의 경우 49; t85 = 2.2, P = 0.034, 평균 = 0.25, n = 원숭이 S의 경우 86) 동안 매개 변수 β 차이가 보이지 않았다 (그림. 8e; 양 꼬리 t 시험; t48 = 0.77, P = 0.44, 평균 = 0.0097, n = 원숭이 P의 경우 49; t85 = 0.64, P = 0.52, 평균 = 0.038, n = 원숭이 S의 경우 86). 여기서는 각 비용 조건에 대한 학습률 매개 변수를 추정했습니다 (αHC 및 αLC)는 HC 조건에서 더 빠른 학습 속도를 설명하기 위해 별도로 제공됩니다. 그러나 비용 조건간에 학습률이 동일한 경우 추정 학습률 매개 변수 (αHC/αLC)는 HC 조건에서 RPE에 대한 증폭 값으로 생각 될 수있다. 따라서, 이러한 결과는 RPE의 증폭이 HC 조건에서 더 빠른 학습 속도를 설명 할 수 있음을 시사한다.

학습 속도 테스트. a 원숭이 P 및 S의 평균 학습 과정. R + 선택의 비율은 시험의 함수로서 그려져있다. 녹색 점과 자주색 점은 각각 고비용 및 저비용 시험의 데이터를 나타냅니다. 점선은 평활 학습 과정을 나타냅니다. 누적 지수 함수를 데이터 포인트에 맞추고 실선으로 표시했습니다. b 피팅 매개 변수 간 로그 비율 a 데이터가 누적 지수 함수에 맞는 고비용 및 저비용 조건에서 (*P <0.05; 양측 Wilcoxon의 부호있는 순위 검정). 검은 색 원과 오차 막대는 평균과 SEM을 나타냅니다. c 피팅 매개 변수 간 로그 비율 b 데이터가 누적 지수 함수에 적합한 고비용 및 저비용 조건에서. d 학습률 매개 변수 사이의 로그 비율 α 데이터가 강화 학습 모델에 적합했을 때 고비용 및 저비용 조건에서. e 피팅 매개 변수 사이의 로그 비율 β 데이터가 강화 학습 모델에 적합했을 때의 고비용 및 저비용 조건

우리는 또한 원숭이들이 각 시험에서 자극과 보상의 반 상관을 알 가능성을 고려한 대안적인 RL 모델로 학습 과정을 설명하려고 노력했습니다. 이 모델에서 선택되지 않은 옵션의 값은 선택한 옵션과 함께 업데이트됩니다 (보조 그림. 12). 이러한 대체 모델을 데이터에 적용 할 때에도 학습 조건 매개 변수는 LC 조건에 비해 HC에서 훨씬 더 컸습니다 (보조 그림. 12b, f) 파라미터 동안 β 차이는 보이지 않았다 (보조 그림. 12d, h). 따라서, HC 조건에서 RPE 신호의 증폭에 대한 우리의 발견은 데이터에 맞는 RL 모델의 형태에 강하다.

토론

우리는 보상 예측 단서의 가치와 중뇌 도파민 뉴런의 위상 반응에 대한 유료 비용의 영향을 조사했습니다. 원숭이들은 더 큰 비용을 초래 한 행동의 성과에 따라 보상 예측 신호에 대한 평가가 증가한 것으로 나타났습니다. 도파민 뉴런은 더 높은 비용이 발생한 후 보상 예측 단서 및 보상 전달 모두에 대해 증가 된 반응을 보였다. 또한 원숭이들은 보상을 얻기 위해 더 높은 비용이 필요할 때 더 빠른 학습 속도를 보여주었습니다.

여러 연구에 따르면 유료 비용은 보상 예측 신호에 대한 선호도를 향상시킵니다.1,2,3. 본 연구에서 원숭이는 LC 조건과 비교하여 HC 조건에서 보상 예측 신호에 대해 RT가 더 빠른 RT를 보여 주었으며, 보상 큐 값이 유료 비용에 의해 향상 될 가능성과 일치27. 대안적인 가능성은 HC 조건에서 단속적 표적에 대한주의가 향상되어 고정 시간이 길수록 HC 시험에서 더 긴 고정 후 RT를 감소시킬 수있다. 그러나 HLC 불확실한 작업에서 HC와 LC 시험에서 RT와 R 큐 사이의 차이는 발견되지 않았다. 또한, HLC 탐사 세션 전반기. R 큐에 대한 RT는 HC 시험과 LC 시험에서 유의 한 차이가 없었다. 따라서 이러한 결과는 더 긴 고정이 보상 예측 단서에서 관찰되는 더 짧은 RT에 대한 설명이 아님을 나타냅니다. 보상 된 큐 RT에 대한 유료 비용의 영향 외에도, 비용은 큐 프리젠 테이션 후에 보상이 전달되지 않았음에도 불구하고 RT를 보상하지 않은 큐에 영향을 미쳤다. 이전의 연구는 비슷한 현상을보고했는데, 원숭이 피험자들은 보상이없는 실험에서 RT가 더 짧았으며, 각 블록 내에서 대체 실험에 더 선호되는 보상이 사용 된 경우30. 이 연구의 효과에 대한 한 가지 가능한 해석은 블록에서 더 선호되는 보상으로 RT에 영향을 미치는 전반적인 동기가 블록 내에서 보상 없음 큐에 영향을 미친다는 것입니다. 유사하게, 본 연구에서, HC 시험에서 더 가치있는 보상을 기대하는 것은 우리의 임무에서 HC 시험에서 보상이없는 신호로 RT를 조정했을 수있다. 더욱이, 보상 신호에 대한 RT에서의 지불 비용의 효과는 보상 예측 신호가없는 것보다 작았 다. 이것은 원숭이가 R에게 더 빨리 단속을했기 때문에LC+ 우선 큐, R에 RT의 단축을 감지하는 범위가 축소됩니다HC+ 큐. 따라서 R + 큐 간의 RT 차이는 결과적으로 작습니다.

원숭이는 또한 R 사이에서 선택 시험을 수행HC 및 RLC HLC 작업의 단서. 그러나 원숭이 S가 R을 선호하는 반면HC+ R에 큐LC+ 큐, 원숭이 P는 그러한 선호도를 보이지 않았다. 이러한 불일치는 HLC 단속과 선택 시험 사이의 상황 적 차이로 설명 할 수 있습니다. 선택 시험에서, 하나의 보상 예측 단서 대신에 두 개의 보상 예측 단서가 제시되었다. 더욱이, 원숭이는 보상 예측 큐를 선택하더라도 선택 후에 보상을 얻지 못했고, 따라서 선택 시험은 멸종되었다. 멸종 절차는 선택 시험에 대한 새로운 학습과 혼동되는 것이 아니라 노력 시험에서 배운 것에 의해 원숭이의 선택이 주도되도록 보장하기 위해 구현되었다. 그러나,이 절차는 원숭이가 선택 맥락에서 멸종 절차를 인식하는 것을 빨리 배울 수 있고보다 바람직한 자극을 선택할 이유가 없다는 부작용을 가질 수있다. 그럼에도 불구하고, 원숭이 중 하나는 실제로 HC 상태에서 보상 신호에 대한 선호를 보여 주었다.

비용을 지불해야 할 후속 요구 사항을 예측 한 단서를 제시 할 때, 도파민 뉴런의 활동이 이전 연구와 일치하게 감소했습니다.22,23. 우리의 연구에서 우리는 기준선에 비해 HC와 LC 신호에 반응하는 도파민 뉴런의 전체적인 감소를 관찰하지 못했습니다. 이는 다음의 비용에도 불구하고 그 시점에서 음의 RPE 신호가 발생하지 않음을 시사합니다. 부정적인 RPE의 부재는 아마도 시험 후반에 예상되는 미래 보상의 예측의 통합을 반영한 것으로 보인다. 도파민 뉴런은 LC 시험에서 유의 한 활성화를 보였으며 활성은 HC 시험에 비해 더 높았다. 이것은 비용 정보가 도파민 뉴런에 의해 운반되는 RPE 신호에 통합됨을 시사한다. 따라서, 도파민 뉴런은 보상 및 비용 정보를 코딩하고 RPE 응답은 비용 및 보상의 합을 반영한다.

우리는 도파민 뉴런으로 표현 된 RPE 신호가 보상 큐 프레젠테이션 (HLC 단속 작업)과 보상 전달 (HLC 불확실한 작업) 시점의 유료 비용에 의해 향상됨을 보여주었습니다. HC 및 LC 시험에서 제공되는 객관적인 보상 금액은 동일합니다. 따라서 RPE 신호의 수정은 비 감각 프로세스에 의해 발생해야합니다. 이 가능성은 도파민 뉴런에서의 주관적 가치 및 / 또는 유용성의 처리와 일치하는 도파민 RPE 신호에 대한 맥락 적 영향을 나타내는 여러 연구에 의해 뒷받침된다11,19,20,21,31,32,33,34. RPE 신호가 더 크면 큐 값이 더 빠르게 업데이트되어 자극 보상 협회의 학습 속도에 영향을 미칩니다. 이전 연구는 비 감각적 요인에 의한 학습 속도의 수정을 보여주었습니다24,35. 이에 따라, 원숭이는 LC 조건에 비해 HC에서 더 빠른 학습 속도를 나타냈다. 우리는 유료 비용에 의한 향상된 학습 속도가 증폭 된 RPE를 가진 RL 모델로 설명 될 수 있음을 발견했습니다. 우리 실험에서 증폭 된 RPE의 효과와 학습 속도 증가를 분리하는 것은 어려웠습니다. 그러나, HC 조건에서 증폭 된 도파민 성 RPE 신호를 발견 하였다. 또한, 이전의 fMRI 연구에 따르면 학습 속도 매개 변수가 앞쪽 피질 피질에 표시되고 VTA의 활동이 휘발성 환경의 학습 속도 매개 변수와 관련이 없음이 밝혀졌습니다36. 따라서, 우리는 도파민 뉴런에 의해 코딩 된 RPE 신호가 유료 비용에 의해 증폭되고, 증가 된 RPE 신호가 학습 속도를 향상 시킨다고 주장한다.

보상 신호 제시 및 보상 전달 시점에 RPE 신호가 생성되었을 때, 원숭이들은 이미 비용을 지불했다. 따라서, 강화 된 RPE 신호에 대한 하나의 가능한 메커니즘은 HC 후에 획득 된 보상이 더 보상적일 수 있다는 것이다. HC 이후에 더 가치있는 보상에 대한 기대가 높아지면 시험을 마치려는 동기가 향상되어 RT가 HC 시험의 보상 신호로 단축 될 수 있습니다.

우리의 결과에 대한 또 다른 가능한 해석은 값 비싼 행동의 종결로부터 경험 된 구호가 원숭이들에게 보상으로 작용할 수 있다는 것입니다. 기능적 자기 공명 영상 (fMRI) 연구에 따르면 통증 완화는 인간 참가자에게 보상이 될 수 있습니다.37,38; 따라서 비용은 고통에 대한 혐오 자극과 유사한 역할을 할 수 있습니다. 비용의 완화가 보람이고 이것이 도파민 작용에 반영된다면, 우리는 도파민 뉴런이 긴 고정의 끝에서 반응 할 것으로 예상 할 것입니다. 그러나, HLC 불확실한 작업에서 보상 큐 제시 시점에서의 도파민 작용의 차이나 HC와 LC 시험 사이의 R 큐와 RT의 차이는 관찰되지 않았다. 따라서 우리는 비용의 완화가 도파민 뉴런에서 관찰 된 효과에 대한 적절한 설명을 제공하지 않는 것이 좋습니다.

또한, 도파민 뉴런은 비용 예측 단서에 비해 혐오 자극에 대해 질적으로 다른 반응을 보였다. 이것에 대한 한 가지 가능한 설명은 원숭이가 고정을 수행하고 구멍을 뚫지 않기 때문에 노력 비용이 수초에 걸쳐 일시적으로 연장 되었기 때문에 노력 비용이 에어 퍼프 또는 보상보다 현저하지 않다는 것입니다. 따라서, 도파민 뉴런은 덜 현저한 비용 신호로 활성화되지 않았을 수있다. 또 다른 가능성은 돌출 형 도파민 뉴런이 일부 움직임이 유도 된 후에 이벤트에 반응 할 수 있다는 것이다. 원숭이에게 보상이나 에어 퍼프가 전달되면 핥거나 눈 깜박임과 같은 움직임을합니다. 그러나, HLC 단속 작업에서, 원숭이는 비용의 움직임없이 고정 목표물에 대한 시선을 유지해야했다. 실제로 최근의 연구에 따르면, 보상 예측 신호에 따라 핵 축적에서 도파민 방출이 움직임이 올바르게 시작되지 않으면 약화되는 것으로 나타났습니다39. 우리의 실험에서 비용은 운동 개시를 포함하지 않았기 때문에, 이것은 잠재적으로 샐리 언 타입 도파민 뉴런의 반응이 일관되지 않을 수있다. 어느 쪽이든, 비용 정보는 혐오적인 정보와 다르게 처리된다는 결론을 내릴 수 있습니다.

결론적으로, 우리는 유료 비용이 보상 예측 단서의 가치를 높이고 이것이 중뇌 도파민 뉴런에 코딩 된 RPE 신호를 증가 시킨다고 제안합니다. 이 효과는 HC의 경험에 따른 보상 예측 단서에 대해 동물의 학습 속도가 향상 될 것이라는 행동 예측으로 이어졌다. 이것은 실제로 우리가 관찰 한 것입니다. 따라서, 도파민 뉴런의 활성에 대한 우리의 관찰은 우리가 행동 효과의 존재와이 효과의 근본이되는 추정 적 계산 메커니즘을 가설으로 이끌어 냈다. 따라서 우리의 연구 결과는 신경 데이터, 계산 이론 및 행동의 측정 사이에서 삼각 측량이 발생할 수있는 방법의 예를 나타냅니다. 뇌의 신경 처리에 대한 더 깊은 이해를 개발하면 행동 및 기본 계산 기반에 대한 통찰력을 얻을 수 있습니다.

행동 양식

동물

우리는 두 마리의 일본 원숭이를 사용했습니다.마 카카 푸스 카타; 체중, 6.5 kg = 원숭이 P; 체중, 9.0 kg = 원숭이 S). 우리는 원숭이의 두개골 위에 머리 기둥을 이식하여 나중에 의자에 고정시킬 수있었습니다. 전극 마이크로 매니퓰레이터의 장착을 가능하게하기 위해 기록 챔버가 또한 주입되었다. 기록 챔버를 관상면에서 측면으로 45 ° 기울어졌고 외이도의 전방 15 mm에 정위 좌표에 위치시켰다. 회복 기간 후 원숭이들은 단속 운동을 수행하도록 훈련 받았다. 훈련을 마친 후, 우리는 전극을 삽입하기 위해 기록 챔버 내부의 두개골을 통해 구멍을 뚫었습니다. 모든 동물 관리 프로토콜은 타마가와 대학의 동물 실험위원회에 의해 승인되었으며, 실험실 동물의 관리 및 사용을위한 국립 보건원 가이드를 준수했습니다.

행동 과제

원숭이들은 HLC 단속 운동을 수행하도록 훈련 받았다 (그림. 1a), HLC 불확실한 작업 (그림. 5a) 및 HLC 탐색 작업 (그림. 7a). 모든 작업은 어두운 방에서 수행되었습니다. 원숭이들은 22 인치 앞 의자에 앉았다. 이식 된 헤드 포스트가 의자에 고정 된 LCD 모니터 (S2232W, Eizo). 눈과 디스플레이 사이의 거리는 70cm였습니다. 시작 큐 (흰색 원, 지름 0.3 °)가 디스플레이 중앙에 표시되었을 때 원숭이는 큐에 시선을 유지해야했습니다. 750ms 후에 시작 신호가 사라지고 비용 신호가 제시되었습니다 (각각 HC 및 LC 시험에 대한 별 및 풍차). 원숭이는 750ms의 큐 프레젠테이션 동안 비용 큐까지 단속해야했습니다. 단서까지 단속하지 않으면 재판이 중단되고 동일한 재판이 다시 시작됩니다. HC 시험 동안 고정 목표 (0.3 ° × 0.3 ° 흰색 사각형)는 2000ms (HLC 단속 및 HLC 불확실한 작업) 또는 1500ms (HLC 탐사 작업) 동안 비용 신호가 사라진 직후에 제시되었으며 원숭이가 필요했습니다. 그것에 단속하고 그들의 시선을 유지합니다. 원숭이가 4 ° × 4 °의 고정 창을 넘어 시선을 움직이면 작업이 중단되었습니다. 원숭이가 단속 운동을 준비하고 고정을 조정하는 데 시간이 필요했기 때문에 고정 지점이 제시된 후 400ms 후에 고정 창이 활성화되었습니다. 따라서 원숭이는 HC 시험에서 최소 1600ms (HLC 단속 및 HLC 불확실한 작업) 또는 1100ms (HLC 탐사 작업) 동안 고정해야했습니다. LC 시험에서는 1500ms (HLC 단속 및 HLC 불확실한 작업) 또는 1000ms (HLC 탐색 작업) 동안 빈 화면이 표시되고 500ms 동안 고정 대상이 나타났습니다. 고정 지점 제시 후 400ms 후에 고정 창이 활성화 되었기 때문에 원숭이는 LC 시험에서 최소 100ms 동안 표적에 고정해야했습니다. 원숭이는 HC 시험에서 더 많은 오류를 보였습니다. 따라서, 성공률을 균등화하기 위해 LC 시행에서 보상 큐 제시 (고정 대상 제시 후 100ms 후, 고정 창 시작 시점) 400ms 전에 강제 중단이 무작위로 삽입되었습니다. 목표물에 고정한 후, 하나 또는 두 개의 보상 신호가 제시되었고 원숭이는 신호에 단속해야했습니다. 보상 큐에 대한 단속 운동을 성공적으로 수행 한 경우 보상 큐 프레젠테이션 후 750ms 후에 경고음이 울 렸습니다. 원숭이가 R + 신호에 대해 단속 운동을했을 때, 경고음과 동시에 0.3ml의 물이 전달되었습니다. 그들이 R- 큐에 단속을 할 때 보상이 전달되지 않았습니다.

HLC 단속 작업에서 4 개의 컬러 서클이 보상 신호로 사용되었습니다 (RHC+ : 노랑; 아르 자형HC-: 녹색; 아르 자형LC+ : 분홍색; 아르 자형LC-: 청색; 무화과. 1a). 한 실험 세션은 80 개의 단속 시험, 20 개의 예측 불가능한 보상 시험, 20 개의 예측할 수없는 에어 퍼프 시험, 5 개의 선택 시험으로 구성되었습니다. 단속 시험에는 40 개의 HC 시험과 40 개의 LC 시험이 포함되었으며, 두 시험 모두 20 개의 보상 시험과 20 개의 보상 없음 시험을 포함했습니다. 예측할 수없는 보상 또는 에어 퍼프 시험에서 0.3ml의 물 보상 또는 0.2MPa의 에어 퍼프 (원숭이 P의 경우 150ms, 원숭이 S의 경우 200ms)가 신호없이 원숭이의 얼굴에 전달되었습니다. 선택 시험에는 원숭이가 R + 단서 (RHC+ 대 RLCHC 시험에서 R- 큐 (R) 사이HC− 대 RLC-) HC 시험에서 R + (R) 사이HC+ 대 RLC+) LC 시험에서 R- (R) 사이의 신호HC− 대 RLC-) LC 시험의 단서와 비용 단서 사이 (보조 그림. 1). 보상 신호 중에서 선택하는 시험에서, 작업 구조는 보상 신호 표시 이전의 단속적 과제와 동일했습니다. 다음으로, 보상 큐를 제시하는 대신, 선택 시험에서 2 개의 보상 큐가 제시되었고, 원숭이가 R + 큐 중에서 선택하더라도 보상 큐 제시 후에는 보상이 전달되지 않았다.

전달을 보상하기위한 도파민 뉴런의 반응을 시험하기 위해, 원숭이는 HLC 불확실한 작업을 수행 하였다 (도. 5a). 이 작업은 보상 신호를 제외하고 HLC 단속 작업과 유사했습니다. 이 작업에서는 HC 시험과 LC 시험에 각각 하나씩 HLC 단속 작업에 사용 된 4 개의 보상 신호 대신 2 개의 보상 신호를 사용했습니다. 리워드는 리워드 큐 프리젠 테이션 후 시험의 절반으로 전달되었습니다. 하나의 실험 세션은 80 단속 시험, 20 예측 불가능한 보상 시험 및 20 예측 불가능한 에어 퍼프 시험으로 구성되었습니다. 단 속성 시험에는 40 HC 시험 및 40 LC 시험이 포함되었으며, 둘 다 20 보상 시험과 20 무 보상 시험이 포함되었습니다. 예측할 수없는 시련에서 보상이나 에어 퍼프가 아무런 신호없이 전달되었습니다.

HLC 탐사 과제에서 두 가지 보상 신호 (RHC+, RHC-또는 RLC+, RLC-)는 동시에 제시되었고 원숭이는 보상 신호 중 하나에 희생해야했다 (그림. 7a). 그들이 R + 큐를 선택했다면, 그들은 물 보상을 받았습니다. 4 개의 보상 신호 (RHC +, RHC-, RLC +, RLC-) 각각의 탐사 세션에 대해 생성되었고 원숭이는 신호와의 연관성을 배우고 시험 시도에 대한 보상을 요구했다. 하나의 실험 세션은 100 HC 시험 및 100 LC 시험으로 구성되었다. 우리는 탐사 작업의 경우, 다른 작업의 HC 조건의 지속 시간과 일치하도록 HC 조건에서 고정 지속 시간을 2000 ms로 설정하면 원숭이가 아마도 과제의 어려움 및 / 또는 그에 따른 낮은 보상률. 따라서 작업의 어려움을 줄이고 성공률을 높이기 위해 1500 ms 고정 기간을 HLC 탐색 작업 비용으로 사용했습니다.

상용 소프트웨어 패키지 (TEMPO, Reflective Computing, 미국 미주리 주 세인트 루이스)를 사용하여 작업을 제어했습니다. 시각적 자극 제시에는 응용 프로그래밍 인터페이스 (OpenGL)를 사용하는 맞춤형 프로그램이 사용되었습니다. 비용과 보상 신호에 대한 시각적 자극은 저자에 의해 만들어졌습니다.

기록 및 데이터 수집

실질 nigra의 위치는 MR 이미지를 사용하여 추정되었습니다. 에폭시 코팅 텅스텐 전극 (생크 직경, 0.25 mm, 0.5 Hz, FHC에서 측정 된 1.5-1000 MΩ)을 기록 챔버에 장착 된 마이크로 매니퓰레이터 (MO-972, Narishige, Tokyo, Japan)를 사용하여 실질 nigra에 삽입했습니다. 스테인레스 가이드 튜브. 전압 신호를 증폭 (x10,000)하고 필터링 (0.5–2 kHz)했습니다. 단일 뉴런으로부터의 활동 전위는 주형 매칭 알고리즘 (OmniPlex, Plexon, Dallas, TX, USA)으로 분리되었다. 500 Hz (iView X Hi-Speed Primate, SMI, Teltow, Germany)의 샘플링 속도로 적외선 카메라 시스템으로 눈의 움직임을 모니터링했습니다. 활동 전위 및 행동 이벤트의 타이밍은 1 kHz의 시간 해상도로 기록되었다.

데이터 분석

원숭이의 행동을 분석하기 위해, RT는 자극 개시와 원숭이가 단속을 시작한 시간 사이의 시간 간격으로 결정되었다. 단속 개시는 큐 제시 전에 시선 위치가 평균 시선 위치로부터 5 표준 편차를 초과 할 때의 타이밍을 계산함으로써 결정되었다.

HLC 탐사 과제에서, 원숭이의 선택 행동은 누적 지수 함수를 피팅함으로써 정량화되었다. 함수 (P)는 올바른 선택 비율을 다음과 같이 설명합니다.

어디에 t 재판을 의미 a 및 b 곡선의 기울기와 고원을 각각 나타냅니다. 이 기능은 두 가지 비용 조건의 데이터에 독립적으로 적합했습니다. 함수의 매개 변수를 검색하여 단일 세션의 데이터와 평균 데이터를 관찰 할 가능성을 최대화했습니다. 평균 데이터에 적합 할 때 신뢰 구간을 추정하기 위해 부트 스트랩 방법이 적용되었습니다. 표준 RL 모델을 사용하여 행동 데이터를 정량화했습니다. 자극 가치 Vj(t) 선택한 선택 j (j = HC 조건의 경우 1; j = LC 조건의 경우 2) 다음과 같이 업데이트되었습니다.

어디에 αj 0와 1 사이의 값으로 제한되는 학습 속도를 나타냅니다. R(t)은 평가판의 보상 금액 (1 : 보상, 0 : 보상 없음)을 나타냅니다. t.

확률 Pj(t) 자극 선택의 j 재판에서 두 자극 중 t softmax 규칙에 의해 주어진다

어디에 βj 탐사 범위를 나타냅니다.

우리는 HLC 단속 운동 및 HLC 불확실한 작업 동안 신경 활동을 기록했지만 HLC 탐사 작업은 기록하지 않았습니다. HLC 탐색 작업은 순전히 행동 연구로 구현되었습니다. 도파민 뉴런은 낮은 토닉 발사 속도 (<6Hz), 스파이크 파형의 긴 지속 시간 (> 300μs), 예측할 수없는 보상에 대한 위상 적 반응 (보충 그림 XNUMX)을 각각 나타내는 경우 식별되었습니다. 2a). 우리는 원숭이가 오류없이 시험을 완료 할 수있는 시험 (브레이크 고정, 단속적 또는 인공적인 중단 없음)을 분석했습니다. 평균 뉴런 발사 속도는 1 ms 빈으로 계산되었고 가우스 커널로 매끄럽게되었습니다 (σ = 30ms, 폭 = 4σ)를 사용하여 스파이크 밀도 함수를 생성합니다. 각 작업 이벤트에 대한 도파민 뉴런의 응답은 자발적 활동 (시작 큐 시작 전 500 ms 동안의 평균 발사 속도)에 대한 정규화 된 발사 속도로 계산되었습니다. 발사 속도는 각 작업 이벤트 및 주제에 대해 결정된 시간 범위 내에서 계산되었습니다. 이 시간 창은 인구 평균 활동에서 결정되었습니다. 우리는 이전 원숭이 도파민 연구를 참고 자료로 사용하여 인구 평균 반응의 상승 및 하강 시간을 기반으로 결정된 시작 시간과 종료 시간을 정의했습니다 (보조 그림. 3). 시작 큐에 대한 시간 윈도우는 원숭이 P 및 S로부터 기록 된 뉴런에 대한 시작 큐 시작 후 200-400 ms로 정의되었다. 조건 큐에 대한 시간 윈도우는 원숭이 P에 대한 조건 큐가 시작된 후 150-300 ms로 정의되었다. 원숭이 S의 경우 200–400 ms. 보상 큐의 시간 창은 원숭이 P의 보상 큐 시작 후 원숭이 S의 140–350 ms 후 220–420 ms로 정의됩니다. 보상 전달의 시간 창은 225–로 정의되었습니다. 원숭이 P에 대한 경고음 발생 후 475 ms 및 원숭이 S에 대한 200–450 ms입니다. 예상치 못한 보상 전달의 시간 창은 원숭이 P의 보상 전달 후 원숭이 X의 100–300 ms로 정의됩니다. 원숭이 P의 경우 에어 퍼프 전달 후 원숭이 S의 경우 150 – 300 ms 후에 예측할 수없는 에어 퍼프의 시간 창이 30 – 230 ms로 정의되었습니다.

우리는 기록 된 모든 도파민 뉴런을 동기 부여 가치와 두드러진 유형의 두 가지 범주로 분류했습니다. 에어 퍼프 자극에 대한 뉴런의 반응이 자발적인 활동보다 작다면, 뉴런은 동기 부여 가치 유형으로 분류됩니다 (그림 XNUMXa). 3d, e). 반대로, 공기 퍼프 자극에 대한 뉴런의 반응이 자발적 활동보다 클 경우, 뉴런은 돌출 유형으로 분류됩니다 (그림. 3g, h).

작업 조건 간의 차등 신경 활동을 정량화하기 위해 ROC 분석이 수행되었습니다. 우리는 각 뉴런에 대한 auROC를 계산했습니다. 0.5보다 작거나 큰 auROC는 각각 HC 시험에서 더 작거나 더 큰 반응을 나타냅니다. 일부 뉴런 데이터 세트의 뉴런 수가 적기 때문에 Wilcoxon의 부호있는 순위 테스트를 사용하여 auROC의 편향된 분포를 정량화하기위한 이상 값의 영향을 줄였습니다.

시판되는 소프트웨어 인 MATLAB (미국 매사추세츠 주 Natick에 소재한 MathWorks)을 사용하여 모든 데이터 분석을 수행 하였다.

조직 검사

기록 실험 후, 두 원숭이를 안락사시키고, 기록 위치를 확인하기 위해 조직 학적 분석을 수행 하였다 (보충 그림. 2b). 치명적인 용량의 펜토 바르 비탈 나트륨 (70 mg kg)을 투여하여 원숭이를 안락사시켰다.- 1) 및 포스페이트 완충액 중 4 % 포름 알데히드로 관류되었다. 연속 코로 날 섹션 (두께, 10 μm)을 항 티로신 하이드 록 실라 제 (TH) 항체 (모든 25 섹션; 항 -TH 항체, 1 : 500; Merck, Darmstadt, Germany) 또는 Nissl 염색 (모든 25 섹션)으로 절단하고 면역 염색 .

보고 요약

연구 설계에 대한 추가 정보는 자연 연구보고 요약 이 기사에 링크되어 있습니다.

코드 가용성

이 연구의 분석에 사용 된 Matlab 코드는 합리적인 요청에 따라 해당 저자에게 제공됩니다.

참고자료

- 1.

Clement, TS, Feltus, JR, Kaiser, DH & Zentall, TR 비둘기의“작업 윤리”: 보상 가치는 보상을 획득하는 데 필요한 노력이나 시간과 직접적으로 관련됩니다. 사이코. 황소. 회전. 7, 100-106 (2000).

- 2.

Klein, ED, Bhatt, RS & Zentall, TR Contrast 및 노력의 정당성. 사이코. 황소. 회전. 12, 335-339 (2005).

- 3.

Zentall, TR & Singer, RA 시험 내 대비 : 비둘기는 덜 혐오적인 사건보다는 상대적으로 더 많이 따르는 조건 강화제를 선호합니다. J. Exp. Anal. 행동. 88, 131-149 (2007).

- 4.

Aronson, E. & Mills, J. 그룹에 대한 선호도에 대한 시작의 심각도의 영향. J. Abnorm. Soc. Psychol. 59, 177-181 (1959).

- 5.

Festinger, L. 인지 불협화음의 이론. (스탠포드 대학 출판부, 캘리포니아, 1957).

- 6.

Alessandri, J., Darcheville, JC, Delevoye-Turrell, Y. & Zentall, TR 더 큰 노력과 더 큰 지연에 따른 보상에 대한 선호. 행동을 배우십시오. 36, 352-358 (2008).

- 7.

Schultz, W., Carelli, RM & Wightman, RM Phasic 도파민 신호 : 주관적인 보상 가치에서 공식적인 경제적 유용성까지. Curr. Opin. 행동. Sci. 5, 147-154 (2015).

- 8.

Schultz, W., Dayan, P. & Montague, PR 예측과 보상의 신경 기질. 과학 275, 1593-1599 (1997).

- 9.

Bromberg-Martin, ES, Matsumoto, M. & Hikosaka, O. Dopamine in motivational control : 보람, 혐오, 경고. 신경 68, 815-834 (2010).

- 10.

Bayer, HM & Glimcher, PW Midbrain 도파민 뉴런은 정량적 보상 예측 오류 신호를 인코딩합니다. 신경 47, 129-141 (2005).

- 11.

Nakahara, H., Itoh, H., Kawagoe, R., Takikawa, Y. & Hikosaka, O. 도파민 뉴런은 상황에 따른 예측 오류를 나타낼 수 있습니다. 신경 41, 269-280 (2004).

- 12.

Tobler, PN, Fiorillo, CD & Schultz, W. 도파민 뉴런에 의한 보상 가치의 적응 코딩. 과학 307, 1642-1645 (2005).

- 13.

Nomoto, K., Schultz, W., Watanabe, T. & Sakagami, M. 지각 적으로 요구하는 보상 예측 자극에 대해 일시적으로 도파민 반응을 확장했습니다. J. Neurosci. 30, 10692-10702 (2010).

- 14.

Watabe-Uchida, M., Zhu, L., Ogawa, SK, Vamanrao, A. & Uchida, N. 중뇌 도파민 뉴런에 대한 직접 입력의 전체 뇌 매핑. 신경 74, 858-873 (2012).

- 15.

타나카, SC 등 즉각적이고 미래의 보상에 대한 예측은 코르티코-기저 신경절 루프를 차등 적으로 모집합니다. Nat. 신경 과학. 7, 887-893 (2004).

- 16.

Haber, SN, Kim, KS, Mailly, P. & Calzavara, R. 보상 관련 피질 입력은 연관 피질 연결과 인터페이스하는 영장류의 큰 선조 영역을 정의하여 인센티브 기반 학습을위한 기질을 제공합니다. J. Neurosci. 26, 8368-8376 (2006).

- 17.

Doya, K. 의사 결정자. Nat. 신경 과학. 11, 410-416 (2008).

- 18.

Roesch, MR, Calu, DJ & Schoenbaum, G. Dopamine 뉴런은 지연된 보상 또는 크기가 다른 보상을 결정하는 쥐에서 더 나은 옵션을 인코딩합니다. Nat. 신경 과학. 10, 1615-1624 (2007).

- 19.

Lak, A., Stauffer, WR & Schultz, W. Dopamine 예측 오류 응답은 다양한 보상 차원의 주관적인 가치를 통합합니다. Proc. Natl Acad. Sci. 미국 111, 2343-2348 (2014).

- 20.

Stauffer, WR, Lak, A. & Schultz, W. Dopamine 보상 예측 오류 응답은 한계 효용을 반영합니다. Curr. Biol. 24, 2491-2500 (2014).

- 21.

Noritake, A., Ninomiya, T. & Isoda, M. 원숭이 뇌의 사회적 보상 모니터링 및 평가. Nat. 신경 과학. 21, 1452-1462 (2018).

- 22.

Pasquereau, B. & Turner, RS 비용-편익 트레이드 오프 작업에서 도파민 뉴런에 의한 노력의 제한된 인코딩. J. Neurosci. 33, 8288-8300 (2013).

- 23.

Varazzani, C., San-Galli, A., Gilardeau, S. & Bouret, S. Noradrenaline 및 도파민 뉴런의 보상 / 노력 절충 : 행동하는 원숭이에서 직접적인 전기 생리 학적 비교. J. Neurosci. 20, 7866-7877 (2015).

- 24.

Watanabe, N., Sakagami, M. & Haruno, M. striatum-amygdala 상호 작용에 의해 강화 된 보상 예측 오류 신호는 감정에 의한 확률 적 보상 학습의 가속화를 설명합니다. J. Neurosci. 33, 4487-4493 (2013).

- 25.

Di Ciano, P., Cardinal, RN, Cowell, RA, Little, SJ & Everitt, B. 핵에서 NMDA, AMPA / kainate 및 도파민 수용체의 차별적 관여는 Pavlovian 접근 행동의 획득 및 수행에 핵심을 차지합니다. J. Neurosci. 21, 9471-9477 (2001).

- 26.

Flagel, SB et al. 자극 보상 학습에서 도파민에 대한 선택적 역할. 자연 469, 53-57 (2011).

- 27.

Blough, DS 프라이밍, 식별 및 강화가 비둘기 시각 검색의 반응 시간 구성 요소에 미치는 영향. J. Exp. Psychol. 애님. 행동. 방법. 26, 50-63 (2000).

- 28.

Matsumoto, M. & Hikosaka, O. 두 가지 유형의 도파민 뉴런은 긍정적이고 부정적인 동기 신호를 뚜렷하게 전달합니다. 자연 459, 837-841 (2009).

- 29.

Matsumoto, M. & Takada, M. 중뇌 도파민 뉴런에서인지 및 동기 부여 신호의 뚜렷한 표현. 신경 79, 1011-1024 (2013).

- 30.

Watanabe, M. et al. 원숭이의 차등 보상 기대를 반영하는 행동 반응. 특급. Brain Res. 140, 511-518 (2001).

- 31.

Takikawa, Y., Kawagoe, R. & Hikosaka, O. 위치 보상 매핑에 대한 단속 단의 단기 및 장기 적응에서 중뇌 도파민 뉴런의 가능한 역할. J. Neurophysiol. 92, 2520-2529 (2004).

- 32.

Kobayashi, S. & Schultz, W. 도파민 뉴런의 반응에 대한 보상 지연의 영향. J. Neurosci. 28, 7837-7846 (2008).

- 33.

Enomoto, K. et al. 도파민 뉴런은 여러 미래 보상의 장기적 가치를 인코딩하는 법을 배웁니다. Proc. Natl Acad. Sci. 미국 108, 15462-15467 (2011).

- 34.

Lak, A., Nomoto, K., Keramati, M., Sakagami, M. & Kepecs, A. Midbrain 도파민 뉴런은 지각 결정 동안 선택 정확도에 대한 믿음을 나타냅니다. Curr. Biol. 27, 821-832 (2017).

- 35.

Williams, BA & McDevitt, MA 억제 및 수퍼 컨디셔닝. Psychol. 공상 과학 13, 454-459 (2002).

- 36.

Behrens, TE, Woolrich, MW, Walton, ME & Rushworth, MF 불확실한 세상에서 정보의 가치를 배웁니다. Nat. 신경 과학. 10, 1214-1221 (2007).

- 37.

Seymour, B. et al. 상대적인 식욕을 자극하는 신경 과정은 통증 완화에 대한 예측 학습의 기초가됩니다. Nat. 신경 과학. 8, 1234-1240 (2005).

- 38.

Kim, H., Shimojo, S. & O'Doherty, JP 혐오스러운 결과를 피하는 것이 보람 있는가? 인간의 뇌에서 회피 학습의 신경 기질. PLoS Biol. 4, e233 (2006).

- 39.

Syed, EC et al. 행동의 시작은 미래 보상의 mesolimbic dopamine 인코딩을 형성합니다. Nat. 신경 과학. 19, 34-36 (2016).

감사의 글

이 연구는 MEXT / JSPS 과학 연구 보조금 보조금 (Kakenhi) 보조금 번호 JP16H06571 및 JP18H03662 to MS에 의해 지원되었습니다이 연구는 일본 의학 연구 개발 기관 (AMED)이 지원하는 뇌 과학 전략 연구 프로그램에 의해 부분적으로 지원되었습니다 ) 및 한미 뇌 연구 협력 프로그램. 이 연구는 AMED의 일본 의학 연구 개발 기관의 국립 생리 과학 연구소 (NIPS의 NBRP)의 국립 생물 자원 프로젝트에 의해 지원되었습니다. 논문 작성에 도움을 준 Bernard W. Balleine과 Andrew R. Delamater에게 감사드립니다.