การสื่อสารธรรมชาติ

ปริมาณ 10, หมายเลขบทความ: 3674 (2019)

นามธรรม

เซลล์โดปามีนในสมองส่วนกลางเป็นที่ทราบกันดีว่าเข้ารหัสข้อผิดพลาดการทำนายผลตอบแทน (RPE) ที่ใช้เพื่ออัปเดตการทำนายค่า ที่นี่เราตรวจสอบว่าสัญญาณ RPE ที่เข้ารหัสโดยเซลล์ประสาทโดปามีนในสมองส่วนกลางได้รับการปรับโดยต้นทุนที่จ่ายเพื่อรับรางวัลหรือไม่โดยการบันทึกจากเซลล์ประสาทโดปามีนในพฤติกรรมลิงที่ตื่นตัวในระหว่างการปฏิบัติภารกิจ saccade โดปามีนเซลล์ประสาทตอบสนองต่อการทำนายการชี้นำและการส่งมอบรางวัลเพิ่มขึ้นหลังจากการทำงานของการกระทำที่มีค่าใช้จ่ายสูงเมื่อเทียบกับการกระทำที่มีค่าใช้จ่ายน้อยกว่า ในระดับพฤติกรรมสมาคมกระตุ้นรางวัลจะได้รับการเรียนรู้เร็วขึ้นหลังจากทำการกระทำที่มีราคาแพงเมื่อเทียบกับการกระทำที่มีค่าใช้จ่ายน้อยลง ดังนั้นข้อมูลเกี่ยวกับค่าดำเนินการจะถูกประมวลผลในระบบรางวัลโดปามีนในลักษณะที่ขยายสัญญาณโดปามีน RPE ต่อไปนี้ซึ่งจะส่งเสริมการเรียนรู้อย่างรวดเร็วมากขึ้นภายใต้สถานการณ์ที่มีค่าใช้จ่ายสูง

บทนำ

มนุษย์และสัตว์ต้องการรางวัลที่ได้รับหลังจากพยายามอย่างมากที่จะได้รับมันเมื่อเปรียบเทียบกับรางวัลเดียวกันหลังจากความพยายามน้อยลง1,2,3. มีการอธิบายจำนวนมากสำหรับเอฟเฟกต์นี้เช่นการพิสูจน์ความพยายาม4,5 และผลกระทบความคมชัด6ซึ่งในมูลค่าที่มากขึ้นเป็นผลมาจากผลลัพธ์ที่ได้หลังจากความพยายามที่จ่าย อย่างไรก็ตามมันยังไม่ชัดเจนว่าการประมวลผลข้อมูลการให้รางวัลในสมองนั้นถูกปรับโดยความพยายามที่ใช้เพื่อรับรางวัลหรือไม่

เรามุ่งเน้นเฉพาะในระบบโดปามีนสมองส่วนกลางซึ่งได้รับบทบาทของระบบนี้ในการส่งเสริมการปรับพฤติกรรมเพื่อรับรางวัล7,8,9. เป็นที่รู้กันว่าโดปามีนเซลล์ประสาทเป็นตัวแทนของสัญญาณการทำนายความผิดพลาด (RPE) สัญญาณที่สามารถอำนวยความสะดวกในการเรียนรู้การทำนายผลตอบแทนจากฐานปมประสาท10,11,12,13,14,15,16,17. ความแข็งแกร่งของ RPE ขึ้นอยู่กับปริมาณคุณภาพและคุณค่าของอัตนัยหรืออรรถประโยชน์ของรางวัล7,18,19,20,21. นอกจากนี้กิจกรรมโดปามีนยังถูกปรับตามต้นทุนและ / หรือความพยายาม22,23. บนพื้นฐานนี้เราตั้งสมมติฐานว่าสัญญาณ RPE dopaminergic จะถูกปรับค่าใช้จ่ายโดยตรงเพื่อรับรางวัล นอกจากนี้เนื่องจากสัญญาณ RPE มีส่วนเกี่ยวข้องอย่างเป็นเหตุเป็นผลในการเป็นสื่อกลางในการเรียนรู้ของสมาคมการให้รางวัลสิ่งเร้า24,25,26เราตั้งสมมติฐานว่าค่าใช้จ่ายที่จ่ายเพื่อให้ได้รับรางวัลโดยตรงจะเพิ่มความเร็วการเรียนรู้ของสมาคมกระตุ้นรางวัล

เพื่อทดสอบสมมติฐานของเราเราวัดทั้งพฤติกรรมและกิจกรรมโดปามีนในลิงญี่ปุ่นสองตัวในขณะที่พวกเขาทำงานที่พยายามใช้ saccade Monkeys ตอบสนองได้เร็วขึ้นต่อคิวการทำนายผลตอบแทนที่นำเสนอหลังจากการกระทำที่มีราคาสูง (HC) เมื่อเปรียบเทียบกับการกระทำที่มีต้นทุนต่ำ (LC) กิจกรรมของเซลล์ประสาทโดปามีนไปยังตัวชี้นำการทำนายรางวัลจะเพิ่มขึ้นตามต้นทุนที่จ่ายไป นอกจากนี้ความเร็วในการเรียนรู้ของสมาคมกระตุ้นผลตอบแทนก็เพิ่มขึ้นด้วยค่าใช้จ่ายที่จ่ายไป ดังนั้นเราขอแนะนำว่าค่าใช้จ่ายที่จ่ายเพื่อให้ได้รับผลตอบแทนจะเพิ่มสัญญาณ RPE ในเซลล์ประสาทโดปามีนและช่วยเพิ่มความสัมพันธ์ของการกระตุ้นด้วยการให้รางวัล

ผลสอบ

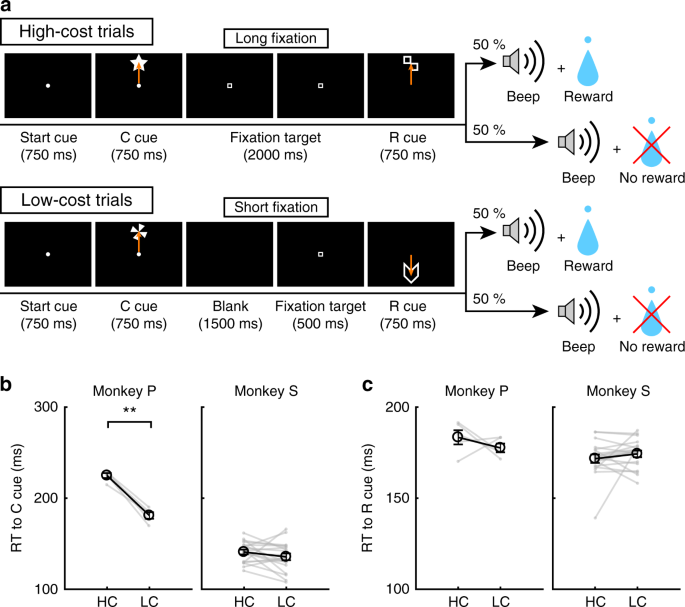

ภารกิจ saccade ต้นทุนต่ำ (High-Low)

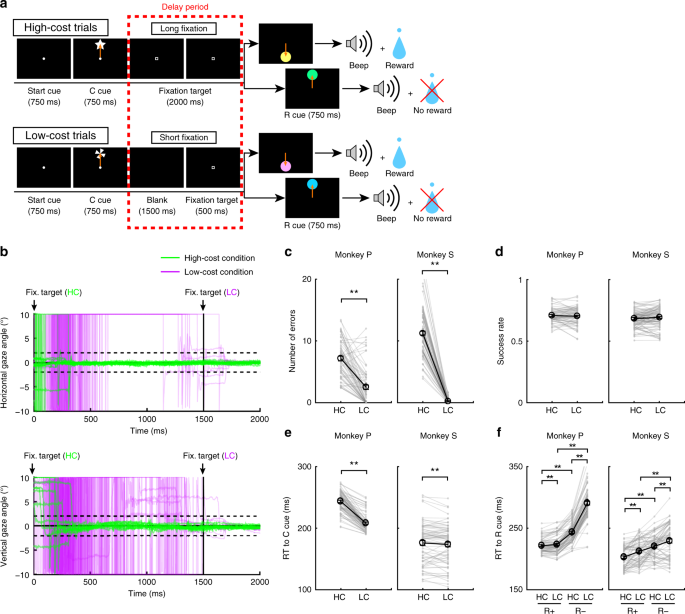

เพื่อตรวจสอบผลกระทบของค่าใช้จ่ายที่จ่ายต่อพฤติกรรมและกิจกรรมของโดปามีนเซลล์ประสาทลิงดำเนินการ saccade โดยมีเงื่อนไขสองประการ 1aดูวิธีการ) ในการทดลอง HC ลิงนั้นรีบจู่โจมเป้าหมายอย่างรวดเร็วและจ้องมองมันโดยไม่กระพริบเป็นระยะเวลานาน (รูปที่ XNUMX) 1b; เส้นสีเขียว) ในทางตรงกันข้ามเมื่อการทดลอง LC นั้นลิงมองไปรอบ ๆ อย่างอิสระในตอนแรกก่อนที่จะทำการแก้ไขในระยะเวลาที่สั้นกว่า (รูปที่ 1bเส้นสีม่วง) เนื่องจากการบำรุงรักษาการตรึงที่ยาวนานนั้นเป็นเรื่องยากสำหรับลิงพวกมันจึงทำผิดพลาดมากขึ้นในระหว่างการล่าช้าในการทดลอง HC (รูปที่ 1c) เพื่อควบคุมความแตกต่างที่เป็นผลมาจากความน่าจะเป็นรางวัลระหว่างการทดลอง HC และการทดลอง LC เราได้บังคับให้ยกเลิกการทดลองในส่วนของการทดลอง LC เพื่อให้อัตราความสำเร็จเท่ากันและความน่าจะเป็นรางวัลระหว่างประเภทการทดลอง 1d).

ภารกิจ saccade HLC a งาน HLC saccade ตัวชี้นำต้นทุน (C cue) ส่งสัญญาณถึงจำนวนความพยายามที่จำเป็นเพื่อให้ได้รางวัลที่เป็นไปได้ จำเป็นต้องมีการตรึงที่ยาวนานในช่วงเวลาล่าช้าในการทดลองที่มีต้นทุนสูง คิวรางวัล (คิว R) ระบุว่าลิงจะได้รับรางวัลหรือไม่ b ช่วงเวลาของมุมมองในช่วงระยะเวลาล่าช้า แผงด้านบนและด้านล่างแสดงมุมมองในแนวนอนและแนวตั้งตามลำดับ เส้นสีเขียวและสีม่วงระบุมุมมองในการทดลองที่มีราคาสูง (50 ครั้งในแต่ละแผง) และในการทดลองที่มีราคาต่ำ (50 ครั้งในแต่ละแผง) ตามลำดับ c จำนวนข้อผิดพลาดในช่วงเวลาล่าช้าในการทดลองที่มีต้นทุนสูงและต้นทุนต่ำ (**P < 0.01; จับคู่สองหาง t ทดสอบ; t67 = 8.8 P = 4.8 × 10-15, n = 68 สำหรับ Monkey P; t83 = 26.6 P ≈ 0, n = 84 สำหรับ Monkey S) วงกลมสีดำและแถบข้อผิดพลาดแสดงถึงค่าเฉลี่ยและ SEM d อัตราความสำเร็จในการทดลองที่มีราคาสูงและต้นทุนต่ำ (จับคู่แบบสองด้าน) t ทดสอบ; t67 = 0.51 P = 0.61 n = 68 สำหรับ Monkey P; t83 = 0.79 P = 0.43 n = 84 สำหรับ Monkey S) e RTs เป็นตัวชี้นำต้นทุน (**P <0.01; จับคู่สองหาง t ทดสอบ; t67 = 20.4 P ≈ 0, n = 68 สำหรับ Monkey P; t69 = 2.0 P = 1.2 × 10-3, n = 70 สำหรับ Monkey S) f RTs เป็นรางวัลตัวชี้นำ (**P <0.01; จับคู่สองหาง t ทดสอบ; Monkey P (n = 68): HC + กับ LC +, t67 = 3.5 P = 9.2 × 10-4; HC− เทียบกับ LC− t67 = 24.5 P ≈ 0; HC + กับ HC− t67 = 21.6 P ≈ 0; LC + กับ LC− t67 = 28.5 P ≈ 0; ลิง S (n = 70): HC + กับ LC +, t69 = 5.6 P = 4.4 × 10-7; HC− เทียบกับ LC− t69 = 4.8 P = 8.4 × 10-5; HC + กับ HC−, t69 = 18.0 P ≈ 0; LC + กับ LC− t69 = 5.9 P = 1.1 × 10-7)

ค่าใช้จ่ายที่จ่ายเพิ่มมูลค่าของตัวชี้นำการทำนายผลตอบแทน

เพื่อให้ได้หลักฐานโดยนัยสำหรับความแตกต่างในการประเมินความคิดเห็นเชิงอัตนัยของลิงเราได้ทดสอบเวลาปฏิกิริยาของลิง (RTs) โดยเฉพาะอย่างยิ่งเราคาดว่าหากลิงกำหนดค่าอัตนัยให้กับตัวเลือกหนึ่งมากกว่าตัวเลือกอื่นพวกเขาควรแสดง RTs ที่เร็วขึ้นสำหรับตัวเลือกที่มีค่ายิ่งขึ้น27. เมื่อ RTs ถูกเปรียบเทียบระหว่างตัวชี้นำต้นทุนลิงทั้งสองแสดง RTs ที่เร็วกว่าไปยัง LC เมื่อเทียบกับ HC คิว (รูปที่ 1e) แสดงให้เห็นถึงการตั้งค่าโดยนัยสำหรับสภาพ LC เมื่อ RTs ถูกเปรียบเทียบระหว่างตัวชี้นำรางวัลลิงทั้งสองแสดง RTs ที่เร็วกว่าในการให้รางวัล (R +) ตัวชี้นำมากกว่าตัวชี้นำไม่มีรางวัล (R−) 1f) ระบุว่าพวกเขาต้องการตัวชี้นำ R + กับตัวชี้นำ นอกจากนี้ลิงทั้งสองยังแสดง RTs ที่เร็วขึ้นHC+ คิวเมื่อเทียบกับ RLC+ คิวและถึง RHC- คิวเทียบกับ RLC- คิว (รูปที่ 1f) แสดงว่าพวกเขาให้ความสำคัญกับการทำนายรางวัลใน HC มากกว่าเมื่อเปรียบเทียบกับสภาพ LC

นอกจากนี้เรายังรวมการทดสอบทางเลือกในภารกิจ saccade HLC เพื่อทดสอบการตั้งค่าที่ชัดเจนของลิงระหว่างตัวชี้นำ (รูปที่เพิ่มเติม 1a) ลิงเลือก LC ชี้นำอย่างยิ่งเมื่อพวกเขาเลือกระหว่างตัวชี้นำต้นทุน (มะเดื่อเสริม 1b) Monkey S เลือกที่ดีกว่า RHC+ cue เมื่อทำภารกิจตัวเลือกระหว่าง RHC+ และ RLC+ cue แต่ไม่มีการกำหนดค่าระหว่าง RHC- และอาร์LC- ตัวชี้นำ (รูปที่เสริม 1c, d) ในทางตรงกันข้ามลิง P ไม่แสดงความพึงพอใจมากเกินไประหว่าง RHC+ และ RLC+ ตัวชี้นำ แต่ยังคงชอบ RHC- คิวเมื่อเลือกระหว่าง RHC- และอาร์LC- ตัวชี้นำ (รูปที่เสริม 1c, d).

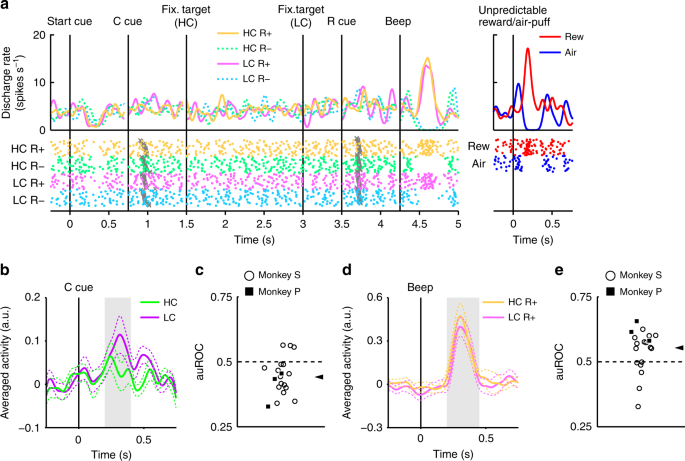

Electrophysiological ส่งผลให้ภารกิจ HLC saccade

เราบันทึกกิจกรรมเดี่ยวจากเซลล์ประสาทที่อยู่ใน substantia nigra pars compacta (SNc) และ ventral tegmental area (VTA) ในระหว่างภารกิจ saccade HLC เราค้นพบเซลล์ประสาทโดปามีน 70 เส้นในลิงสองตัว 2a; 18 และ 52 เซลล์ประสาทจาก Monkey P และ S ตามลำดับ) การตรวจทางเนื้อเยื่อวิทยายืนยันว่าเซลล์ประสาทตั้งอยู่ในหรือรอบ ๆ SNc / VTA (รูปที่เสริม 2b).

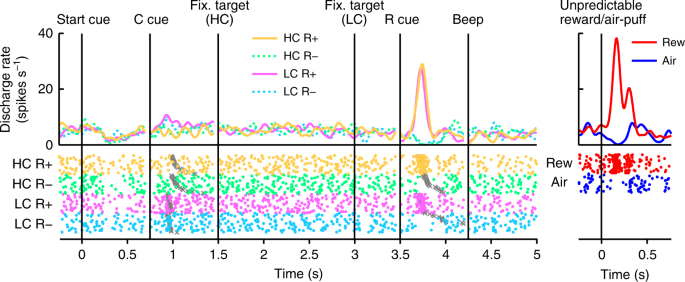

ในรูป 2เราแสดงกิจกรรมของเซลล์ประสาทโดปามีนที่เป็นตัวแทน เซลล์ประสาทนี้แสดงการกระตุ้น LC เล็กน้อยและการกระตุ้น phasic หรือการปราบปรามต่อรางวัล (RHC+ และ RLC+) หรือไม่มีตัวชี้นำการให้รางวัล (RHC- และอาร์LC-) ตามลำดับ (รูปที่ 2มะเดื่อเสริม 3) เซลล์ประสาทยังแสดงการกระตุ้น phasic ต่อการคาดเดาไม่ได้เช่นเดียวกับการปราบปราม Phasic ในการตอบสนองต่อการกระตุ้น aversive, พัฟอากาศที่ไม่แน่นอน (รูปที่. 2แผงควบคุมด้านขวา) นอกจากนี้เซลล์ประสาทยังแสดงให้เห็นว่าการปราบปรามเริ่มคิวเล็กน้อย แต่ไม่ตอบสนองต่อการส่งมอบรางวัล ประชากรทั้งหมดของเซลล์ประสาทโดปามีนที่เราบันทึกไว้ทั้งหมดแสดงให้เห็นการตอบสนองที่คล้ายกันกับคิวเริ่มต้นและการส่งมอบรางวัล (รูปที่เสริม) 4a, b) ในภารกิจ saccade HLC มีการจ่ายค่าแรงก่อนที่จะได้รับรางวัล เนื่องจากค่าใช้จ่ายที่คาดการณ์ไว้ลดกิจกรรมของเซลล์ประสาทโดปามีน22,23การตอบสนองของโดปามีนเซลล์ประสาทจะถูกระงับในเวลาที่เริ่มการนำเสนอคิว16.

กิจกรรมของ dopamine neuron ที่เป็นตัวแทนในภารกิจ HLC saccade ฟังก์ชั่นความหนาแน่น Spike (convolved ด้วยฟังก์ชั่น Gaussian) และแปลงแรสเตอร์จะสอดคล้องกับระยะเวลาเริ่มต้นของคิวเริ่มต้นคิวต้นทุน (C คิว) เป้าหมายการตรึงคิวรางวัล (R คิว) และเสียงบี๊บ แต่ละสีแสดงถึงเงื่อนไข (สีเหลือง: HC +, สีเขียว: HC−, สีชมพู: LC +, สีฟ้า: LC−) ตามลำดับ การกำหนดเวลาของการโจมตี saccade ถูกระบุด้วยกากบาทสีเทา การตอบสนองของเซลล์ประสาทโดปามีนต่อรางวัลที่คาดเดาไม่ได้หรือพัฟอากาศก็มีการนำเสนอในแผงด้านขวา (สีแดง: รางวัลที่คาดเดาไม่ได้, สีน้ำเงิน: พัฟอากาศคาดเดาไม่ได้)

โดปามีนข้อมูลรหัสเซลล์ประสาททั้งรางวัลและราคา

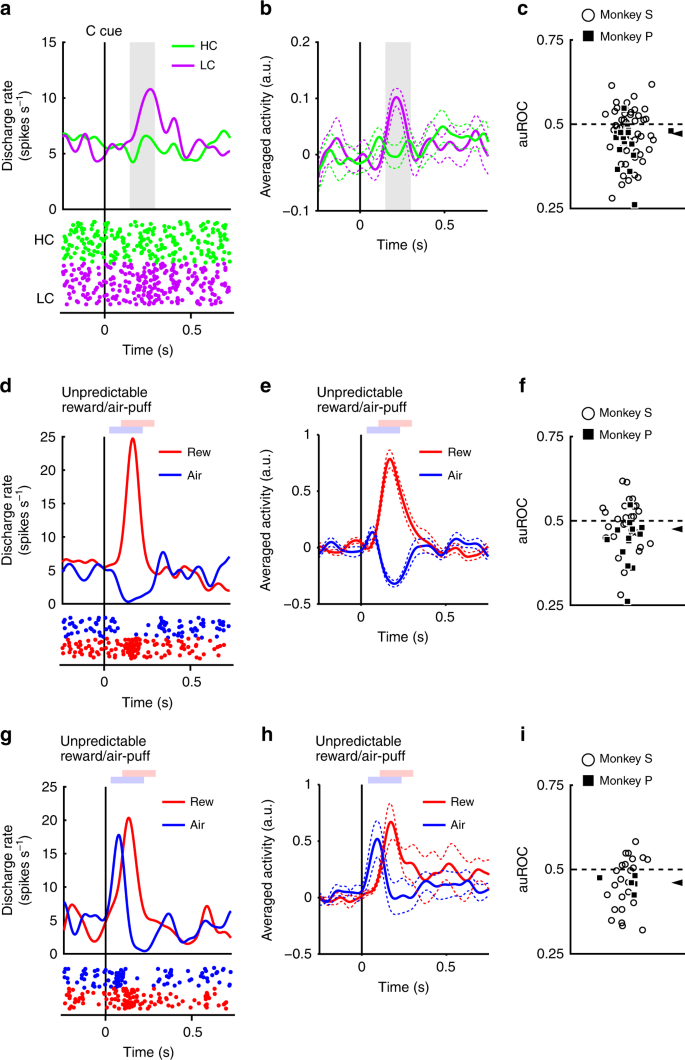

เซลล์ประสาทตอบสนองต่อ ph lasic phasically แต่ไม่ค่อยแข็งแกร่งกับคิวคิว (รูปที่ 3a, b) ทำให้เกิดการตอบสนองต่อเงื่อนไขของค่าใช้จ่ายแสดงการตอบสนองต่อคิว HC ที่เล็กกว่า LC cue (การทดสอบแบบลงนามสองระดับของวิลคอกซัน P <3.2 × 10-4, n = 70) เราประเมินผลของต้นทุนที่คาดการณ์ไว้ต่อการตอบสนองของเซลล์ประสาทโดยใช้การวิเคราะห์ลักษณะการทำงานของผู้รับ (ROC) การกระจายของพื้นที่ภายใต้เส้นโค้ง ROC (auROC) อย่างมีนัยสำคัญ <0.5 (รูปที่. 3c; การทดสอบแบบเซ็นชื่อสองแบบของวิลคอกซัน P = 5.4 × 10-4, n = 70) แสดงว่าการตอบสนองของคิว HC มีค่าน้อยกว่าคิว LC ก่อนหน้านี้พบค่าใช้จ่ายที่คาดการณ์ไว้เพื่อลดการทำงานของเซลล์ประสาทโดปามีนซึ่งสอดคล้องกับผลลัพธ์ของเรา22,23. นอกจากนี้ประชากรของโดปามีนเซลล์ประสาทแสดงการกระตุ้น LC to คิวอย่างมีนัยสำคัญในขณะที่ไม่มีการปราบปรามอย่างมีนัยสำคัญ HC ชี้นำ (รูปที่เสริม) 4c, d) ผลลัพธ์เหล่านี้ชี้ให้เห็นว่าโดปามีนรหัสเซลล์ประสาทและบูรณาการข้อมูลเกี่ยวกับรางวัลและค่าใช้จ่ายในช่วงเวลาของการนำเสนอคิวต้นทุน

โดปามีนเซลล์ประสาทตอบสนองต่อการชี้นำต้นทุน a ตัวแทนของเซลล์ประสาทโดปามีนตอบสนองต่อตัวชี้นำต้นทุน ฟังก์ชันความหนาแน่นของเข็มคำนวณจากกิจกรรมปกติของเซลล์ประสาทโดปามีนที่บันทึกจากลิงพีเส้นสีบ่งบอกถึงฟังก์ชันความหนาแน่นของเข็มและจุดสีบ่งบอกระยะเวลาที่เข็ม สีเขียวและสีม่วงบ่งบอกถึงกิจกรรมในการทดลองราคาสูงและต้นทุนต่ำตามลำดับ เส้นแนวตั้งระบุช่วงเวลาของการนำเสนอคิวต้นทุน พื้นที่สีเทาระบุระยะเวลาในการคำนวณอัตราการยิงตามการตอบสนองต่อเงื่อนไข b กิจกรรมเฉลี่ยประชากรของเซลล์ประสาทโดปามีนที่บันทึกจาก Monkey P ไปยังตัวชี้นำเงื่อนไข เส้นทึบที่เส้นประแสดงค่าเฉลี่ยและ SEM ตามลำดับ c การกระจายของพื้นที่ภายใต้ ROCs เพื่อหาปริมาณผลกระทบของต้นทุนที่คาดการณ์ไว้ในการตอบสนองของเส้นประสาทต่อคิวต้นทุน ช่องสี่เหลี่ยมที่เติมและวงกลมเปิดแสดงข้อมูลจาก Monkey P และ S ตามลำดับ หัวลูกศรแสดงค่ามัธยฐานของ auROC (0.47) d, g ตัวแทนการตอบสนองของเซลล์ประสาทชนิดค่า dopamine (d) หรือเซลล์ประสาทประเภทโดปามีน salience (g) เพื่อรางวัลที่คาดเดาไม่ได้หรือพัฟเครื่อง เส้นโค้งสีแดงและสีน้ำเงินบ่งบอกถึงการตอบสนองต่อรางวัลที่คาดเดาไม่ได้และพัฟอากาศที่คาดเดาไม่ได้ตามลำดับ เส้นแนวตั้งแสดงระยะเวลาในการส่งรางวัลที่คาดเดาไม่ได้หรือการส่งพัฟทางอากาศ สี่เหลี่ยมสีแดงและน้ำเงินอ่อนบ่งบอกระยะเวลาในการคำนวณอัตราการยิงเป็นการตอบสนองต่อรางวัลที่ไม่อาจคาดการณ์ได้หรือพัฟอากาศ e, h กิจกรรมเฉลี่ยประชากรของเซลล์ประสาทประเภทโดปามีนตามตัวอักษรe) หรือเซลล์ประสาทประเภท dopamine salience (h) เพื่อรางวัลที่คาดเดาไม่ได้หรือพัฟเครื่อง f, i การกระจายของ auROC ที่คำนวณจากเซลล์ประสาทประเภทโดปามีนตามตัวอักษรf) หรือเซลล์ประสาทประเภท dopamine salience (i) หัวลูกศรแสดงค่ามัธยฐานของ auROCs (f 0.48; i 0.46)

มีการอธิบายชนิดของเซลล์โดปามีนที่แตกต่างกันสองชนิดก่อนหน้านี้: ค่าของแรงบันดาลใจและเซลล์ประสาทที่มีความสำคัญ28,29. เราพบหลักฐานในประชากรโดปามีนเซลล์ประสาทของรูปแบบการตอบสนองที่สอดคล้องกับเชื้อทั้งสองชนิด เซลล์ประสาทประเภทค่าแสดงให้เห็นการปราบปราม phasic ต่อสิ่งเร้าอากาศพัฟ aversive (รูปที่ 3d, e) ในทางกลับกันเซลล์ประสาทนูนแสดงให้เห็นว่ามีการกระตุ้น phasic ต่อสิ่งเร้า aversive (รูปที่ 3g, ห่า) การตรึงที่ยาวนานในการทดลอง HC นั้นก็ไม่น่าพอใจ ดังนั้นจึงมีความเป็นไปได้ที่เซลล์โดปามีนทั้งสองชนิดย่อยจะแสดงรูปแบบการตอบสนองที่แตกต่างกันไปตามเงื่อนไขของต้นทุน ถ้าโดปามีนเซลล์ประสาทเป็นตัวแทนของสิ่งเร้าและค่าใช้จ่ายในลักษณะที่คล้ายกันจากนั้นเซลล์ประสาทตามตัวอักษรควรแสดงกิจกรรมลดลงไปคิว HC เนื่องจากการ aversiveness ในอีกทางหนึ่งเซลล์ประสาทที่ต้องรับความรู้สึกควรเพิ่มขึ้นในกิจกรรมไปยังจุด HC เพราะพวกเขายังเพิ่มสิ่งเร้าที่ไม่พึงประสงค์ อย่างไรก็ตามการตอบสนองที่ปรากฏของเซลล์ประสาททั้งสองชนิดนั้นมีขนาดเล็กกว่าคิวคิวเปรียบเทียบกับคิว LC (การทดสอบแบบลงนามอันดับสองของวิลคอกซัน P = 0.021 n = 41 และ P = 0.0044 n = 29 สำหรับค่าและประเภทความเค็มตามลำดับ) และการวิเคราะห์ ROC แสดงให้เห็นการตอบสนองต่อ HC น้อยกว่าเมื่อเทียบกับ LC คิวในทั้งสองชนิดย่อย (รูปที่. 3f ฉัน; การทดสอบแบบเซ็นชื่อสองแบบของวิลคอกซัน P = 0.030 n = 41 และ P = 0.0058 n = 29 สำหรับมูลค่าและประเภทความสง่างามตามลำดับ) ดังนั้นค่าใช้จ่ายที่คาดการณ์ไว้จะลดกิจกรรมในเซลล์ประสาทโดพามีนทั้งสองชนิด ผลลัพธ์เหล่านี้บ่งชี้ว่าข้อมูลค่าใช้จ่ายถูกประมวลผลโดยเซลล์ประสาทโดปามีนด้วยวิธีที่แตกต่างกันในเชิงคุณภาพกับสิ่งเร้าที่ไม่ชอบ

ในงาน HLC saccade เราได้ใส่การบังคับให้ยกเลิกในส่วนหนึ่งของการทดลอง LC เพื่อปรับอัตราความสำเร็จและความน่าจะเป็นของรางวัลระหว่างประเภทการทดลอง การจัดการนี้เพิ่มความไม่แน่นอนในการได้รับรางวัลหรือความเสี่ยงที่จะไม่มีรางวัลในเงื่อนไข LC ดังนั้นกิจกรรมที่สูงขึ้นของเซลล์ประสาทโดปามีนและการประเมินค่าที่เพิ่มขึ้นของลิงสำหรับ LC ในช่วงคิวซีของ HC อาจเกิดจากความแตกต่างของความเสี่ยงหรือความไม่แน่นอนระหว่างเงื่อนไขด้านต้นทุน อย่างไรก็ตามเราไม่พบความสัมพันธ์ระหว่างจำนวนการบังคับให้ยกเลิกและความแตกต่างใน RT (รูปเสริม 5a, b) และเราพบความสัมพันธ์เชิงบวกระหว่างจำนวนการทำแท้งที่ถูกบังคับและ auROC (รูปที่เพิ่มเติม) 5c) นอกจากนี้เรายังเปรียบเทียบการตอบสนองของโดปามีนกับตัวชี้นำต้นทุนหลังจากการยกเลิกและหลังจากการทดลองที่ถูกต้อง แต่ไม่พบความแตกต่างในเงื่อนไขต้นทุนทั้งสอง (รูปเพิ่มเติม 5d) ผลลัพธ์เหล่านี้บ่งชี้ว่าจำนวนการยกเลิกการบังคับใช้ในสภาพ LC ไม่ได้อธิบายการเพิ่มขึ้นของการประเมินค่าหรือการเปิดใช้งานการกระตุ้นโดปามีนต่อคิว LC

เพิ่มการตอบสนองโดปามีนเพื่อตอบแทนคิวด้วยต้นทุนที่จ่าย

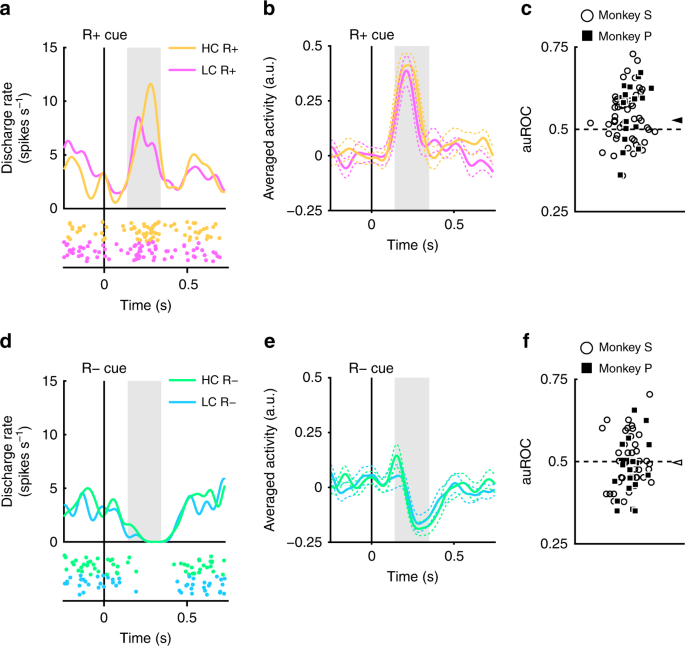

พบว่าเซลล์โดปามีนที่ถูกบันทึกนั้นแสดงให้เห็นว่ามีการกระตุ้นและการยับยั้ง phasic เพื่อให้รางวัลและไม่มีตัวชี้นำทำนายรางวัลตามลำดับ (รูปที่. 2) ต่อไปเราจะประเมินว่าคำตอบเหล่านี้ได้รับการปรับตามค่าใช้จ่ายที่เกิดขึ้นก่อนหน้านี้หรือไม่ ตัวอย่างของเซลล์ประสาทที่เป็นตัวแทนและเซลล์ประสาทที่มีค่าเฉลี่ยของประชากรHC+ คิวกว่า RLC+ cue แสดงในรูป 4a และ b ตามลำดับ. (การทดสอบอันดับที่มีลายเซ็นของ Wilcoxon สองด้าน; P = 7.4 × 10-5, n = 70) การแจกแจงของ auROCs เท่ากับ> 0.5 แสดงว่าการตอบสนองต่อ RHC+ คิวมีขนาดใหญ่กว่า RLC+ cue (รูปที่ 4c; การทดสอบแบบเซ็นชื่อสองแบบของวิลคอกซัน P = 1.4 × 10-4, n = 70) ผลลัพธ์เหล่านี้บ่งชี้ว่าการตอบสนองต่อคิวการทำนายผลตอบแทนในเงื่อนไข HC มีขนาดใหญ่กว่าเงื่อนไข LC อย่างมีนัยสำคัญ ดังนั้นการค้นพบของเราชี้ให้เห็นว่าสัญญาณบวก -RPE ที่แสดงโดยเซลล์ประสาทโดปามีนจะเพิ่มขึ้นตามต้นทุนที่เกิดขึ้นก่อนหน้านี้

โดปามีนเซลล์ประสาทตอบสนองให้รางวัลตัวชี้นำ a ตัวอย่างเซลล์ประสาทตอบสนองต่อตัวชี้นำ R + ฟังก์ชั่นความหนาแน่นสไปค์ถูกคำนวณจากกิจกรรมของโดปามีนเซลล์ประสาทที่บันทึกจากลิง P เส้นและจุดสีแสดงถึงความหนาแน่นของสไปค์และจังหวะเวลาตามลำดับ สีเหลืองและสีชมพูแสดงถึงกิจกรรมในการทดลองที่มีราคาสูงและต้นทุนต่ำตามลำดับ เส้นแนวตั้งแสดงเวลาของการนำเสนอ R + cue พื้นที่สีเทาแสดงระยะเวลาในการคำนวณอัตราการยิงเป็นการตอบสนองต่อตัวชี้นำรางวัล b กิจกรรมเฉลี่ยประชากรของเซลล์ประสาทโดปามีนที่บันทึกจากลิง P ถึงตัวชี้นำ R + เส้นทึบและเส้นประแทนค่าเฉลี่ยและ SEM ตามลำดับ c การกระจายของ auROCs เพื่อหาปริมาณผลกระทบของต้นทุนที่จ่ายไปในการตอบสนองของเส้นประสาทต่อตัวชี้นำ R + ช่องสี่เหลี่ยมที่เติมและวงกลมเปิดแสดงข้อมูลจาก Monkey P และ S ตามลำดับ หัวลูกศรแสดงค่ามัธยฐานของ auROCs (0.53) d ตัวแทนตอบสนองต่อตัวชี้นำ สีเขียวและสีฟ้าหมายถึงการทดลองที่มีราคาสูงและต้นทุนต่ำตามลำดับ เส้นแนวตั้งแสดงเวลาของงานนำเสนอ R− cue e กิจกรรมเฉลี่ยประชากรของเซลล์โดปามีนที่บันทึกจาก Monkey P ถึง Rues cues f การกระจายของ auROCs เพื่อหาปริมาณผลกระทบของต้นทุนที่จ่ายไปในการตอบสนองของเส้นประสาทต่อ Rues cues หัวลูกศรแสดงค่ามัธยฐานของ auROC (0.50)

เซลล์โดปามีนยังแสดงให้เห็นถึงการปราบปราม Phasic ต่อ R− cues (รูปที่ 4d, e) อย่างไรก็ตามการตอบสนองของโดปามีนเซลล์ประสาทต่อตัวชี้นำ R did ไม่ได้แสดงความแตกต่างอย่างมีนัยสำคัญในฐานะที่เป็นหน้าที่ของต้นทุนที่เกิดขึ้น (การทดสอบแบบลงนามสองระดับของวิลคอกซัน P = 0.25 n = 70) และการวิเคราะห์ ROC ไม่ได้เปิดเผยหลักฐานใด ๆ สำหรับความเอนเอียงในการกระจายการตอบสนอง (รูปที่. 4f; การทดสอบที่มีลายเซ็นของ Wilcoxon P = 0.35; n = 70) ดังนั้นค่าใช้จ่ายที่ต้องชำระจึงไม่สะท้อนให้เห็นในสัญญาณ RPE เชิงลบที่เกิดขึ้นจากสัญญาณที่ไม่คาดการณ์ล่วงหน้า สิ่งนี้อาจเกิดจากเอฟเฟกต์พื้น: กิจกรรมที่เกิดขึ้นเองของเซลล์ประสาทโดปามีนอยู่ในระดับต่ำ (ประมาณ 5 เฮิร์ตซ์); และด้วยเหตุนี้อาจไม่มีช่วงไดนามิกเพียงพอที่จะเข้ารหัสความแตกต่างของต้นทุนที่ใช้จ่ายสำหรับการตอบสนอง RPE เชิงลบ (รูปที่ 4d, e).

นอกจากนี้เรายังตรวจสอบผลกระทบของค่าใช้จ่ายที่จ่ายในการชี้นำรางวัลสำหรับเซลล์โดปามีนประเภทคุณค่าและความโดดเด่นที่แยกจากกัน แต่เซลล์โดปามีนทั้งสองชนิดมีรูปแบบการตอบสนองคล้ายกัน (รูปที่เสริม) 6a-H) ดังนั้นค่าใช้จ่ายที่จ่ายจึงมีผลคล้ายกันกับการตอบสนองเพื่อให้รางวัลสัญญาณทั้งในเซลล์ประสาทโดปามีนประเภทคุณค่าและความทนทาน

ระยะเวลาในการตรึงที่แท้จริงของลิงนั้นไม่คงที่ แต่จะแตกต่างกันไปในแต่ละช่วงทดลอง 1b) ดังนั้นจึงเป็นไปได้ที่การตอบสนองของโดปามีนต่อคิวการให้รางวัลนั้นจะถูกปรับโดยระยะเวลาการตรึงจริงบนพื้นฐานของการทดลองโดยการทดลอง อย่างไรก็ตามเราไม่สามารถพบความสัมพันธ์ที่สำคัญระหว่างพวกเขาสำหรับแต่ละค่าใช้จ่ายและเงื่อนไขรางวัล (รูปที่เสริม 7A-d) นอกจากนี้ RTs ไปยังคิวรางวัลยังได้รับการปรับตามเงื่อนไขค่าใช้จ่ายและรางวัล (รูปที่ 1f) ความเป็นไปได้อย่างหนึ่งคือการตอบสนองของโดปามีนเซลล์ประสาทสามารถอธิบายได้โดย RTs ต่อการชี้นำรางวัลบนพื้นฐานการทดลองโดยการทดลอง อย่างไรก็ตามเราไม่สามารถหาความสัมพันธ์อย่างมีนัยสำคัญระหว่าง RTs และการตอบสนองของโดปามีนแบบปกติกับตัวชี้นำรางวัล 7อีเอช) ผลลัพธ์เหล่านี้ชี้ให้เห็นว่าการตอบสนองของโดปามีนนั้นไม่ขึ้นอยู่กับทั้ง RTs และระยะเวลาการตรึงในแต่ละการทดลอง แต่ปรับด้วยจำนวนของต้นทุนที่ต้องการและรางวัลที่คาดว่าจะได้รับการแก้ไขสำหรับการทดลองแต่ละประเภท

นอกจากนี้ยังเป็นไปได้ว่าการบังคับให้ยกเลิกในสภาพ LC นั้นสร้างความพึงพอใจของลิงและกระตุ้นการทำงานของเซลล์โดปามีนที่เพิ่มขึ้นเพื่อรับรางวัลคิวในสภาพ HC ถ้าเป็นเช่นนั้นจำนวนการยกเลิกที่บังคับควรเกี่ยวข้องกับการตั้งค่าและระดับการเปิดใช้งานที่ปรับปรุงแล้ว อย่างไรก็ตามจำนวนผู้ที่ถูกบังคับให้ทำทารุณกรรมไม่มีผลกระทบต่อความพึงพอใจของลิงหรือการกระตุ้นของโดปามีนเซลล์ประสาทต่อคิวการให้รางวัล (รูปที่เพิ่มเติม) 8) ดังนั้น RT ที่เร็วขึ้นและการตอบสนอง DA ที่สูงขึ้นต่อ RHC+ คิวกว่า RLC+ คิวไม่ได้เกิดจากการบังคับยกเลิกการแทรกในสภาพ LC

ต้นทุนที่เกิดขึ้นจะเพิ่มการตอบสนองโดปามีนเพื่อให้ได้ของรางวัล

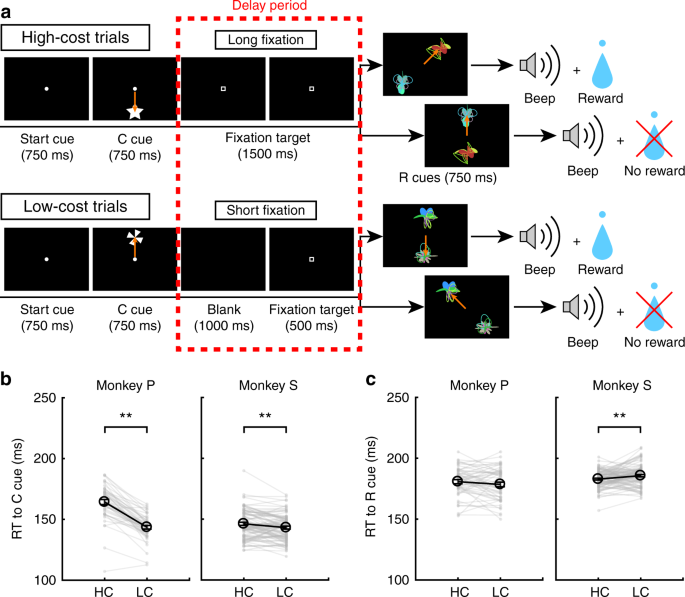

การตอบสนองของโดปามีนเซลล์ประสาทต่อตัวชี้นำ R + ควรมาจากการตอบสนองต่อรางวัลนั้นเองเพราะโดปามีนเซลล์ประสาทเปลี่ยนการตอบสนองของพวกเขาเพื่อชี้นำการทำนายรางวัลเทียบกับสมาคมกระตุ้นรางวัล8,30. ดังนั้นเราคาดว่าโดปามีนเซลล์ประสาทจะแสดงการปรับปรุงการตอบสนองที่ขึ้นอยู่กับต้นทุนที่จ่ายเพื่อการส่งมอบรางวัล ในการวัดกิจกรรมโดปามีนเซลล์ประสาทไปยังการส่งมอบรางวัลลิงดำเนินงานที่ไม่แน่นอน HLC ด้วยสองตัวชี้นำรางวัลใหม่ (รูปที่ 5a) เนื่องจากรางวัลถูกส่งมอบในครึ่งเดียวของการนำเสนอคิวรางวัลคิวการให้รางวัลจึงไม่น่าเชื่อถือหรือทำนายการส่งมอบรางวัลที่แตกต่างกัน สิ่งนี้ทำเพื่อเพิ่มการตอบสนองของเซลล์ประสาทโดปามีนให้มากที่สุดเพื่อรับรางวัล (ไม่ถูกคาดการณ์) เพื่อเพิ่มความไวของเราในการตรวจจับการปรับการตอบสนองของเซลล์ประสาทในฐานะที่เป็นค่าใช้จ่าย

งานที่ไม่แน่นอน HLC a งานที่ไม่แน่นอน HLC ในภารกิจนี้ใช้ตัวชี้นำการรับรางวัลที่ไม่แน่นอนซึ่งมีการส่งมอบรางวัล 50% ของเวลาโดยไม่คำนึงถึงการนำเสนอคิว b RTs เป็นตัวชี้นำต้นทุนในการทดลองที่มีราคาสูงและต้นทุนต่ำ มีเพียงลิง P เท่านั้นที่แสดงให้เห็นว่า RT ไปยัง LC LC เร็วกว่า HC คิว (**P <0.01; จับคู่สองหาง t ทดสอบ; t4 = 9.0 P = 8.5 × 10-4, n = 5 สำหรับลิง P; t18 = 1.4 P = 0.19 n = 19 สำหรับลิง S) วงกลมสีดำและแถบข้อผิดพลาดแสดงถึงค่าเฉลี่ยและ SEM c RTs ไปสู่สัญลักษณ์ของรางวัลในการทดลองที่มีราคาสูงและต้นทุนต่ำ RT ไม่ได้มีความแตกต่างในการชี้นำรางวัลระหว่างเงื่อนไขที่มีราคาสูงและต้นทุนต่ำ (จับคู่แบบสองด้าน t ทดสอบ; t4 = 0.97 P = 0.39 n = 5 สำหรับลิง P; t18 = 0.99 P = 0.39 n = 19 สำหรับลิง S)

เมื่อ RTs ถูกเปรียบเทียบระหว่างตัวชี้นำต้นทุน Monkey P แสดง RT เร็วกว่ากับ LC LC คิวกว่า HC คิว (รูปที่ 5b) RT ไม่มีความแตกต่างในตัวชี้นำการให้รางวัลระหว่างสภาพ HC และ LC ในลิงทั้งสอง (รูปที่ 5c).

ในงานที่ไม่แน่นอนของ HLC เซลล์ประสาทโดปามีนแสดงการกระตุ้น LC เล็กน้อย แต่ไม่ตอบสนองต่อตัวชี้นำรางวัลเพราะพวกมันไม่ได้เป็นรางวัลที่ทำนายได้ 6a) จากจำนวนประชากรการตอบสนองที่ปรากฏนั้นเล็กกว่าค่าฮีชอลของ LC (รูปที่ XNUMX) 6b; การทดสอบแบบเซ็นชื่อสองแบบของวิลคอกซัน P = 2.7 × 10-3, n = 19) และการวิเคราะห์ ROC แสดงให้เห็นการตอบสนองน้อยลงต่อคิว HC (รูปที่ 6c; การทดสอบแบบเซ็นชื่อสองแบบของวิลคอกซัน P = 5.5 × 10-3, n = 19). การตอบสนองของเซลล์ประสาทต่อการให้รางวัลในภาวะ HC มีขนาดใหญ่กว่า LC (รูปที่ 6d; การทดสอบแบบเซ็นชื่อสองแบบของวิลคอกซัน P = 0.036 n = 19). การแจกแจงของ auROCs เท่ากับ> 0.5 ซึ่งบ่งบอกถึงการตอบสนองการส่งมอบรางวัลที่มากขึ้นใน HC เมื่อเทียบกับการทดลอง LC (รูปที่ 6e; การทดสอบแบบเซ็นชื่อสองแบบของวิลคอกซัน P = 0.049 n = 19). ผลลัพธ์เหล่านี้บ่งชี้ว่าการตอบสนองการส่งมอบรางวัลได้รับการปรับปรุงในการทดลอง HC และต้นทุนที่จ่ายนั้นจะเพิ่มสัญญาณบวก -RPE ในการส่งมอบรางวัล

โดปามีนเซลล์ประสาทตอบสนองต่อการส่งมอบรางวัล a ตัวแทน dopamine neuron activity ในงานที่ไม่แน่นอนของ HLC แต่ละสีแสดงถึงเงื่อนไข (สีเหลือง: HC +, สีเขียว: HC−, สีชมพู: LC +, สีฟ้า: LC−) การกำหนดเวลาของการโจมตี saccade ถูกระบุด้วยกากบาทสีเทา การตอบสนองของโดปามีนเซลล์ประสาทนี้ต่อรางวัลที่คาดเดาไม่ได้และพัฟอากาศก็ถูกอธิบายในแผงด้านขวา (สีแดง: รางวัลที่คาดเดาไม่ได้, สีน้ำเงิน: พัฟอากาศคาดเดาไม่ได้) b กิจกรรมโดยเฉลี่ยของประชากรของเซลล์ประสาทโดปามีนที่บันทึกจากลิง S ถึงตัวชี้นำเงื่อนไข สีเขียวและสีม่วงบ่งบอกถึงกิจกรรมในการทดลองราคาสูงและต้นทุนต่ำตามลำดับ เส้นทึบและเส้นประแทนค่าเฉลี่ยและ SEM ตามลำดับ พื้นที่สีเทาแสดงหน้าต่างเวลาในการคำนวณอัตราการยิงตามการตอบสนองต่อเงื่อนไข c การกระจายของ auROCs เพื่อประเมินผลกระทบของต้นทุนที่คาดการณ์ไว้ในการตอบสนองของเส้นประสาทต่อค่าสัญญาณ ช่องสี่เหลี่ยมที่เติมเต็มจะระบุข้อมูลจากลิง P (n = 3) และวงกลมเปิดแสดงข้อมูลจากลิง S (n = 16) หัวลูกศรระบุค่ามัธยฐานของ auROC (0.44) d กิจกรรมเฉลี่ยประชากรของเซลล์ประสาทโดปามีนที่บันทึกจากลิง S ถึงการส่งมอบรางวัล สีเหลืองและสีชมพูแสดงถึงกิจกรรมในการทดลองที่มีราคาสูงและต้นทุนต่ำตามลำดับ พื้นที่สีเทาแสดงหน้าต่างเวลาเพื่อคำนวณอัตราการยิงเป็นการตอบสนองต่อการส่งมอบรางวัล e การกระจายของ auROCs เพื่อหาปริมาณผลกระทบของต้นทุนที่จ่ายต่อการตอบสนองของเซลล์ประสาทต่อการส่งมอบรางวัล หัวลูกศรแสดงค่ามัธยฐานของ auROC (0.55)

นอกจากนี้เราเปรียบเทียบการตอบสนองของโดปามีนหลังจากที่ไม่มีรางวัล auROCs ไม่ได้แสดงการแจกแจงแบบเอนเอียงแสดงว่าต้นทุนที่จ่ายไปไม่มีผลต่อ RPE เชิงลบในเวลาที่เกิดผลลัพธ์ (รูปที่เพิ่มเติม 9a) เซลล์โดปามีนไม่แสดงความแตกต่างระหว่างการตอบสนองต่อ RHC และ RLC ตัวชี้นำ (มะเดื่อเสริม) 9b).

ค่าใช้จ่ายที่เกิดขึ้นช่วยเพิ่มความเร็วในการเรียนรู้

เนื่องจาก RPE ที่จะให้รางวัลการส่งมอบจะเพิ่มขึ้นตามต้นทุนที่ต้องชำระภายใต้สมมติฐานที่ว่า RPE มีส่วนเกี่ยวข้องโดยตรงในการเป็นสื่อกลางในการเรียนรู้ที่ให้รางวัลกระตุ้นเราคาดว่า RPE ที่ปรับปรุงแล้วจะสะท้อนให้เห็นในพฤติกรรมการเรียนรู้ผ่านความเร็วในการเรียนรู้ที่เพิ่มขึ้น24. เพื่อทดสอบผลกระทบของค่าใช้จ่ายในการเรียนรู้ลิงดำเนินการสำรวจ HLC (รูปที่ 7a; ดูวิธีการ) ในภารกิจนี้มีการนำเสนอรางวัลสองรางวัล (R + และ R−) พร้อมกันและลิงต้องเลือกหนึ่งตัว เราให้อัตราความสำเร็จที่เท่ากันและความน่าจะเป็นรางวัลระหว่างประเภทการทดลอง (จับคู่แบบสองด้าน t ทดสอบ; t48 = 0.15 P = 0.89 n = 49 สำหรับลิง P; t85 = 1.2 P = 0.25 n = 86 สำหรับลิง S) เมื่อเปรียบเทียบ RTs สำหรับตัวชี้นำต้นทุนลิงทั้งสองจะแสดง RTs ไปยังคิว LC เร็วกว่าคิว HC (รูปที่ 7b; จับคู่สองด้าน t ทดสอบ; t48 = 12.9 P ≈ 0, n = 49 สำหรับลิง P; t85 = 3.4 P = 9.4 × 10-4, n = 86 สำหรับลิง S) เมื่อเปรียบเทียบ RT กับตัวชี้นำรางวัลลิง S แสดง RT ที่เร็วกว่าใน HC มากกว่าเงื่อนไข LC (รูปที่ 7c; จับคู่สองด้าน t ทดสอบ; t48 = 1.3 P = 0.19 n = 49 สำหรับลิง P; t85 = 2.8 P = 6.8 × 10-3, n = 86 สำหรับลิง S) เมื่อเปรียบเทียบ RT ในช่วงครึ่งแรกและครึ่งหลังของเซสชันการเรียนรู้แยกกัน RTs กับ LC cue นั้นเร็วกว่าคิว HC ในช่วงแรก (รูปเสริม 10a) และครึ่งหลังของเซสชัน (รูปที่เพิ่มเติม 10c) ในทางตรงกันข้าม RTs ของลิง S ต่อคิวรางวัลในสภาพ HC นั้นเร็วกว่าในสภาพ LC ในช่วงครึ่งหลังของเซสชั่นเท่านั้น 10d) แต่ไม่ใช่ครึ่งแรก (มะเดื่อเสริม) 10b).

ภารกิจสำรวจ HLC a ภารกิจสำรวจ HLC ในภารกิจนี้ลิงต้องเลือกระหว่าง R + และ R− cues ซึ่งสร้างแบบสุ่มในแต่ละเซสชันการเรียนรู้ หากพวกเขาเลือก R + คิวพวกเขาสามารถได้รับรางวัลและถ้าพวกเขาเลือกคิวพวกเขาจะไม่ได้รับรางวัล b RTs เป็นตัวชี้นำต้นทุนในการทดลองที่มีราคาสูงและต้นทุนต่ำ ลิงแสดง RT เร็วขึ้นไปยังคิวราคาถูก (**P < 0.01; จับคู่สองหาง t ทดสอบ). วงกลมสีดำและแถบข้อผิดพลาดหมายถึงค่าเฉลี่ยและ SEM c RTs ไปสู่สัญลักษณ์ของรางวัลในการทดลองที่มีราคาสูงและต้นทุนต่ำ Monkey S แสดง RTs ที่เร็วขึ้นเพื่อให้รางวัลตัวชี้นำในสภาพที่มีต้นทุนสูง

ในภารกิจการสำรวจ HLC จะมีการสร้างตัวชี้นำรางวัลขึ้นในแต่ละช่วงการเรียนรู้ ดังนั้นลิงจึงต้องเรียนรู้ความสัมพันธ์ระหว่างตัวชี้นำรางวัลและรางวัลในแต่ละเซสชั่น เมื่อการทดลองดำเนินไปภายในเซสชันลิงเลือก R + cues บ่อยขึ้นในแต่ละเงื่อนไขต้นทุน (รูปที่ 8a) ในการหาปริมาณความเร็วในการเรียนรู้เราพอดีกับฟังก์ชันเลขชี้กำลังสะสมกับข้อมูลซึ่งประกอบด้วยสองพารามิเตอร์อิสระ a และ bแสดงความชันของเส้นโค้งและที่ราบสูงตามลำดับ (มะเดื่อเสริม) 11a, b) อัตราส่วนการบันทึกระหว่างพารามิเตอร์ความชัน (บันทึก aHC/aLC) มีขนาดใหญ่กว่าศูนย์อย่างมีนัยสำคัญระบุพารามิเตอร์ความชันขนาดใหญ่ใน HC กว่าการทดลอง LC (รูปที่ 8b; สองด้าน t ทดสอบ; t48 = 2.1 P = 0.042, ค่าเฉลี่ย = 0.58, n = 49 สำหรับลิง P; t85 = 2.5 P = 0.013, ค่าเฉลี่ย = 0.19, n = 86 สำหรับลิง S) อัตราส่วนบันทึกระหว่างพารามิเตอร์ที่ราบสูง (log bHC/bLC) ไม่แตกต่างจากศูนย์ที่ระบุว่าไม่มีความแตกต่างระหว่างเงื่อนไขต้นทุน (รูปที่ 8c; สองด้าน t ทดสอบ; t48 = 0.76 P = 0.45, ค่าเฉลี่ย = −0.0024, n = 49 สำหรับลิง P; t85 = 0.56 P = 0.58, ค่าเฉลี่ย = 0.010, n = 86 สำหรับลิง S) ผลลัพธ์เหล่านี้บ่งชี้ว่าความเร็วในการเรียนรู้เร็วขึ้นในการทดลอง HC ต่อไปเราจะจำลองเส้นโค้งการเรียนรู้โดยใช้แบบจำลองการเรียนรู้แบบเสริมแรง (RL) (ดูวิธีการ) แบบจำลองนี้ประกอบด้วยพารามิเตอร์อัตราการเรียนรู้ (αHC และ αLC) และอัตราการสำรวจ (βHC และ βLC) สำหรับเงื่อนไขต้นทุนทั้งสอง (รูปเพิ่มเติม) 11c, d) เมื่อเหมาะสมกับพฤติกรรมเราพบว่าอัตราส่วนการบันทึกระหว่างพารามิเตอร์อัตราการเรียนรู้ (บันทึก αHC/αLC) มีขนาดใหญ่กว่าศูนย์ซึ่งแสดงว่าพารามิเตอร์อัตราการเรียนรู้มีขนาดใหญ่กว่าอย่างมีนัยสำคัญในการทดลอง HC มากกว่าการทดลอง LC 8d; สองด้าน t ทดสอบ; t48 = 2.3 P = 0.026, ค่าเฉลี่ย = 0.50, n = 49 สำหรับลิง P; t85 = 2.2 P = 0.034, ค่าเฉลี่ย = 0.25, n = 86 สำหรับลิง S) ในขณะที่พารามิเตอร์ β ไม่มีความแตกต่าง (รูปที่ 8e; สองด้าน t ทดสอบ; t48 = 0.77 P = 0.44, ค่าเฉลี่ย = 0.0097, n = 49 สำหรับลิง P; t85 = 0.64 P = 0.52, ค่าเฉลี่ย = 0.038, n = 86 สำหรับลิง S) ที่นี่เราประมาณพารามิเตอร์อัตราการเรียนรู้สำหรับแต่ละเงื่อนไขต้นทุนαHC และ αLC) แยกต่างหากเพื่ออธิบายความเร็วการเรียนรู้ที่เร็วขึ้นในสภาพ HC อย่างไรก็ตามหากอัตราการเรียนรู้เหมือนกันระหว่างเงื่อนไขต้นทุนอัตราส่วนระหว่างพารามิเตอร์อัตราการเรียนรู้โดยประมาณ (αHC/αLC) สามารถคิดได้ว่าเป็นค่าการขยายสำหรับ RPE ในสภาพ HC ดังนั้นผลลัพธ์เหล่านี้ชี้ให้เห็นว่าการขยาย RPE สามารถอธิบายความเร็วการเรียนรู้ได้เร็วขึ้นในสภาพ HC

ทดสอบความเร็วการเรียนรู้ a หมายถึงกระบวนการเรียนรู้ของลิง P และ S. สัดส่วนของตัวเลือก R + นั้นถูกพล็อตเป็นฟังก์ชันของการทดลอง จุดสีเขียวและสีม่วงหมายถึงข้อมูลจากการทดลองใช้ต้นทุนสูงและต้นทุนต่ำตามลำดับ เส้นประแสดงถึงกระบวนการเรียนรู้ที่ราบรื่น ฟังก์ชันเลขชี้กำลังแบบสะสมถูกติดตั้งกับจุดข้อมูลและแสดงเป็นเส้นทึบ b อัตราส่วนล็อกระหว่างพารามิเตอร์การปรับ a ในสภาวะที่มีต้นทุนสูงและต่ำเมื่อข้อมูลมีความสอดคล้องกับฟังก์ชันเลขชี้กำลังสะสม (*P <0.05; การทดสอบอันดับที่มีลายเซ็นของ Wilcoxon สองด้าน) วงกลมสีดำและแถบข้อผิดพลาดแสดงถึงค่าเฉลี่ยและ SEM c อัตราส่วนล็อกระหว่างพารามิเตอร์การปรับ b ในสภาวะที่มีต้นทุนสูงและต่ำเมื่อข้อมูลมีความสอดคล้องกับฟังก์ชันเลขชี้กำลังสะสม d อัตราส่วนการบันทึกระหว่างพารามิเตอร์อัตราการเรียนรู้ α ในสภาพที่มีต้นทุนสูงและต่ำเมื่อข้อมูลมีความสอดคล้องกับรูปแบบการเรียนรู้การเสริมแรง e อัตราส่วนล็อกระหว่างพารามิเตอร์การปรับ β ในสภาพที่มีต้นทุนสูงและต่ำเมื่อข้อมูลมีความสอดคล้องกับรูปแบบการเรียนรู้การเสริมแรง

นอกจากนี้เรายังพยายามอธิบายกระบวนการเรียนรู้ด้วยตัวเลือก RL แบบอื่นซึ่งคำนึงถึงความเป็นไปได้ที่ลิงรู้ว่าความสัมพันธ์ระหว่างสิ่งเร้าและสิ่งตอบแทนในการทดลองแต่ละครั้ง ในรุ่นเหล่านั้นค่าของตัวเลือกที่ไม่ได้เลือกจะอัปเดตพร้อมกับตัวเลือกที่เลือก (รูปเพิ่มเติม 12) แม้เมื่อนำแบบจำลองทางเลือกดังกล่าวไปใช้กับข้อมูลพารามิเตอร์อัตราการเรียนรู้มีขนาดใหญ่กว่าอย่างมีนัยสำคัญใน HC เมื่อเทียบกับสภาพ LC (รูปที่เสริม) 12b, f) ขณะที่พารามิเตอร์ β พบว่าไม่มีความแตกต่าง (รูปที่เสริม 12d, h) ดังนั้นการค้นพบของเราเกี่ยวกับการขยายสัญญาณ RPE ในสภาพ HC นั้นแข็งแกร่งในรูปแบบของ RL model ที่เหมาะสมกับข้อมูล

การสนทนา

เราตรวจสอบผลกระทบของค่าใช้จ่ายที่จ่ายต่อมูลค่าของตัวชี้นำการทำนายผลตอบแทนและการตอบสนองของ phasic ของเซลล์ประสาทโดปามีนในสมองส่วนกลาง Monkeys แสดงการประเมินมูลค่าที่เพิ่มขึ้นสำหรับการชี้นำการให้รางวัลตามการทำงานของการกระทำที่ทำให้เกิดค่าใช้จ่ายมากขึ้น เซลล์โดปามีนแสดงการตอบสนองที่เพิ่มขึ้นทั้งคิวการทำนายและการจัดส่งของรางวัลหลังจากมีค่าใช้จ่ายที่สูงขึ้น นอกจากนี้ลิงยังแสดงความเร็วในการเรียนรู้ที่เร็วขึ้นเมื่อต้องการค่าใช้จ่ายที่สูงขึ้นเพื่อรับรางวัล

มีงานวิจัยหลายชิ้นที่แสดงให้เห็นว่าค่าใช้จ่ายที่จ่ายไปนั้นเพิ่มความน่าสนใจสำหรับคิวที่ทำนายรางวัล1,2,3. ในการศึกษาปัจจุบันลิงแสดง RT ที่เร็วกว่าตัวชี้นำการทำนายรางวัลในสภาพ HC เมื่อเทียบกับในสภาพ LC สอดคล้องกับความเป็นไปได้ที่มูลค่าคิวรางวัลจะได้รับการปรับปรุงด้วยต้นทุนที่จ่าย27. ความเป็นไปได้ทางเลือกคือเวลาในการตรึงที่นานขึ้นที่เกี่ยวข้องกับการเพิ่มความสนใจไปยังเป้าหมาย saccade ในสภาพ HC ดังนั้นการลด RTs หลังจากการตรึงอีกต่อไปในการทดลอง HC อย่างไรก็ตามเราไม่พบความแตกต่างระหว่าง RTs กับ R cues ในการทดลอง HC และ LC ในงานที่ไม่แน่นอนของ HLC นอกจากนี้ในช่วงครึ่งแรกของเซสชั่นการสำรวจ HLC RTs to R cues ไม่แตกต่างกันอย่างมีนัยสำคัญระหว่างการทดลอง HC และ LC การค้นพบเหล่านี้บ่งชี้ว่าการตรึงที่ยาวนานขึ้นนั้นไม่ใช่คำอธิบายที่เป็นไปได้สำหรับ RTs ที่สั้นกว่าที่สังเกตได้จากตัวชี้นำการทำนายผลตอบแทน นอกเหนือจากผลกระทบของต้นทุนที่จ่ายต่อคิวรางวัล RT แล้วค่าใช้จ่ายยังส่งผลต่อ RT ไปยังคิวที่ไม่สามารถคาดการณ์ได้แม้ว่าจะไม่มีการส่งรางวัลหลังจากการนำเสนอคิวก็ตาม การศึกษาก่อนหน้านี้รายงานปรากฏการณ์ที่คล้ายกันในวิชาลิงนั้นแสดง RTs ที่สั้นกว่าในการทดลองที่ไม่ได้รับการรายงานเมื่อมีการใช้รางวัลที่ต้องการมากขึ้นในการทดลองทางเลือกภายในแต่ละบล็อค30. การตีความที่เป็นไปได้อย่างหนึ่งของผลกระทบในการศึกษานั้นคือแรงจูงใจโดยรวมที่สูงขึ้นเพื่อตอบสนองในบล็อกพร้อมกับรางวัลที่เป็นที่นิยมมากกว่าที่ส่งผลต่อ RTs ไปยังคิวที่ไม่มีรางวัลภายในบล็อก ในทำนองเดียวกันในการศึกษาปัจจุบันความคาดหวังของรางวัลที่มีค่ายิ่งกว่าในการทดลอง HC อาจทำให้ RT ไม่มีการให้รางวัลในการทดลอง HC ในงานของเรา นอกจากนี้ผลกระทบของค่าใช้จ่ายที่จ่ายให้กับตัวชี้นำ RTs นั้นมีขนาดเล็กกว่าที่ไม่มีต่อตัวชี้นำการทำนายผลตอบแทน นี่อาจเป็นสิ่งประดิษฐ์ของความจริงที่ว่าเพราะลิงทำ saccade ได้เร็วขึ้นไปยัง RLC+ cue ในตอนแรกมีขอบเขตที่ลดลงในการตรวจจับการย่อ RTs เป็น RHC+ คิว ดังนั้นความแตกต่างใน RTs ระหว่างตัวชี้นำ R + จะมีขนาดเล็กเป็นผล

ลิงยังทำการทดลองทางเลือกระหว่าง RHC และ RLC ตัวชี้นำในงาน HLC อย่างไรก็ตามในขณะที่ลิง S แสดงความชอบสำหรับ RHC+ คิวไปที่ RLC+ คิว, ลิง P แสดงให้เห็นว่าไม่มีการตั้งค่าดังกล่าว ความคลาดเคลื่อนนี้สามารถอธิบายได้โดยความแตกต่างเชิงบริบทระหว่าง HLC saccade และตัวเลือกทดลอง ในการทดลองที่เลือกจะมีการนำเสนอตัวทำนายผลสองรางวัลแทนคิวที่ทำนายผลหนึ่งรางวัล ยิ่งไปกว่านั้นลิงไม่ได้รับรางวัลใด ๆ หลังจากเลือกแม้ว่าจะเลือกคิวที่ทำนายรางวัลแล้วดังนั้นการทดสอบทางเลือกก็ถูกทำให้สูญพันธุ์ ขั้นตอนการสูญพันธุ์ถูกนำมาใช้เพื่อให้แน่ใจว่าการเลือกของลิงนั้นได้รับแรงผลักดันจากสิ่งที่ได้เรียนรู้จากการทดลองใช้ความพยายามเมื่อเทียบกับการเรียนรู้ใหม่เกี่ยวกับการทดลองทางเลือก อย่างไรก็ตามขั้นตอนนี้อาจมีผลข้างเคียงที่ลิงสามารถเรียนรู้ได้อย่างรวดเร็วเพื่อรับรู้การสูญพันธุ์ในบริบททางเลือกและไม่มีเหตุผลที่จะเลือกสิ่งเร้าที่ต้องการมากขึ้น อย่างไรก็ตามลิงตัวใดตัวหนึ่งในความเป็นจริงได้แสดงความพึงพอใจสำหรับรางวัลคิวในสภาพ HC

ในช่วงเวลาของการนำเสนอคิวที่ทำนายความต้องการที่ตามมาเพื่อจ่ายค่าใช้จ่ายกิจกรรมของเซลล์ประสาทต้องใจลดลงสอดคล้องกับการศึกษาก่อนหน้า22,23. ในการศึกษาของเราเราไม่ได้สังเกตเห็นการลดลงโดยรวมของเซลล์โดปามีนที่ตอบสนองต่อทั้งตัวชี้นำ HC และ LC เทียบกับพื้นฐาน สิ่งนี้ชี้ให้เห็นว่าสัญญาณลบ RPE ไม่เกิดขึ้น ณ เวลานั้นแม้จะมีค่าใช้จ่ายดังต่อไปนี้ การไม่มี RPE เชิงลบน่าจะสะท้อนให้เห็นถึงการบูรณาการการคาดการณ์ของรางวัลในอนาคตที่คาดว่าจะเกิดขึ้นภายหลังในการทดลอง เซลล์โดปามีนแสดงการกระตุ้นครั้งสำคัญในการทดลอง LC และกิจกรรมนั้นสูงขึ้นเมื่อเปรียบเทียบกับการทดลอง HC สิ่งนี้ชี้ให้เห็นว่าข้อมูลราคาถูกรวมเข้ากับสัญญาณ RPE ที่ดำเนินการโดยเซลล์ประสาทโดปามีน ดังนั้นโดปามีนรหัสเซลล์ประสาทรางวัลและข้อมูลค่าใช้จ่ายและการตอบสนอง RPE สะท้อนให้เห็นถึงผลรวมของค่าใช้จ่ายและผลตอบแทน

เราแสดงให้เห็นว่าสัญญาณ RPE ที่แสดงโดยเซลล์ประสาทโดปามีนนั้นได้รับการปรับปรุงโดยต้นทุนที่จ่าย ณ จุดการนำเสนอรางวัลคิว (ในภารกิจ saccade HLC) และการส่งมอบรางวัล (ในงานที่ไม่แน่นอนของ HLC) จำนวนของรางวัลที่มอบให้ในการทดลอง HC และ LC นั้นเท่ากัน ดังนั้นการปรับเปลี่ยนสัญญาณ RPE ควรเกิดจากกระบวนการไร้สาระ ความเป็นไปได้นี้ได้รับการสนับสนุนโดยการศึกษาหลายชิ้นที่ระบุถึงผลกระทบเชิงบริบทต่อสัญญาณโดปามีน RPE ที่สอดคล้องกับการประมวลผลค่าอัตนัยและ / หรือประโยชน์ในเซลล์ประสาทโดพามีน11,19,20,21,31,32,33,34. หากสัญญาณ RPE มีขนาดใหญ่ขึ้นสิ่งนี้ควรสร้างการปรับปรุงค่าคิวอย่างรวดเร็วมากขึ้นซึ่งจะส่งผลต่อความเร็วในการเรียนรู้ของการเชื่อมโยงกับสิ่งเร้า - รางวัล การศึกษาก่อนหน้าได้แสดงให้เห็นการปรับเปลี่ยนความเร็วในการเรียนรู้โดยปัจจัยไร้สาระ24,35. สอดคล้องกับสิ่งนี้ลิงแสดงความเร็วการเรียนรู้เร็วขึ้นใน HC เมื่อเทียบกับสภาพ LC เราพบว่าความเร็วในการเรียนรู้ที่เพิ่มขึ้นโดยค่าใช้จ่ายที่จ่ายสามารถอธิบายได้ด้วยแบบจำลอง RL พร้อมด้วย RPE แบบขยาย เป็นการยากที่จะแยกเอฟเฟกต์ของ RPE ที่ถูกขยายและเพิ่มอัตราการเรียนรู้ในการทดลองของเรา อย่างไรก็ตามเราพบสัญญาณ dopaminergic RPE แบบขยายในสภาพ HC นอกจากนี้การศึกษา fMRI ก่อนหน้านี้ได้แสดงให้เห็นว่าพารามิเตอร์อัตราการเรียนรู้แสดงอยู่ในเยื่อหุ้มสมองด้านหน้า cingulate และกิจกรรมของ VTA นั้นไม่เกี่ยวข้องกับพารามิเตอร์อัตราการเรียนรู้ในสภาพแวดล้อมที่เปลี่ยนแปลงได้36. ดังนั้นเรายืนยันว่าสัญญาณ RPE ที่เข้ารหัสโดยโดปามีนเซลล์ประสาทนั้นถูกขยายโดยค่าใช้จ่ายที่จ่ายไปและสัญญาณ RPE ที่เพิ่มขึ้นจะช่วยเพิ่มความเร็วในการเรียนรู้

เมื่อสัญญาณ RPE ถูกสร้างขึ้นในช่วงเวลาของการนำเสนอรางวัลคิวและการส่งมอบรางวัลลิงได้จ่ายเงินไปแล้ว ดังนั้นกลไกหนึ่งที่เป็นไปได้สำหรับสัญญาณ RPE ขั้นสูงคือรางวัลที่ได้รับหลังจาก HC อาจให้รางวัลมากกว่า ความคาดหวังที่เพิ่มขึ้นของรางวัลที่มีค่ายิ่งขึ้นหลังจาก HC อาจเพิ่มแรงจูงใจในการจบการทดลองดังนั้นจึงทำให้ RT สั้นลงไปสู่การให้รางวัลในการทดลอง HC

การตีความที่เป็นไปได้อีกประการของผลลัพธ์ของเราคือการผ่อนปรนจากการยุติการกระทำที่มีราคาแพงอาจทำหน้าที่เป็นรางวัลสำหรับลิง การศึกษาการถ่ายภาพด้วยคลื่นสนามแม่เหล็ก (fMRI) แสดงให้เห็นว่าการบรรเทาอาการปวดอาจเป็นรางวัลสำหรับผู้เข้าร่วมของมนุษย์37,38; ดังนั้นต้นทุนอาจมีบทบาทคล้ายกันกับมาตรการกระตุ้นความเจ็บปวด หากการผ่อนปรนจากค่าใช้จ่ายเป็นสิ่งตอบแทนและหากสิ่งนี้สะท้อนให้เห็นในกิจกรรมโดปามีนเราก็คาดหวังว่าเซลล์ประสาทโดปามีนจะตอบสนองเมื่อสิ้นสุดการตรึงที่ยาวนานซึ่งเป็นช่วงเวลาของการนำเสนอรางวัลคิว อย่างไรก็ตามเราไม่ได้สังเกตความแตกต่างของกิจกรรมโดปามีนในช่วงเวลาของการนำเสนอรางวัลคิวหรือความแตกต่างใด ๆ ใน RTs กับ Rues ระหว่างการทดสอบ HC และ LC ในงาน HLC ที่ไม่แน่นอน ดังนั้นเราขอแนะนำว่าการบรรเทาจากต้นทุนไม่ได้ให้คำอธิบายที่เพียงพอสำหรับผลกระทบที่เราสังเกตเห็นในเซลล์ประสาทโดปามีน

นอกจากนี้เซลล์โดปามีนยังแสดงการตอบสนองต่อการกระตุ้นด้วย aversive ที่แตกต่างกันในเชิงคุณภาพเมื่อเปรียบเทียบกับการทำนายค่าใช้จ่าย คำอธิบายหนึ่งที่เป็นไปได้สำหรับเรื่องนี้คือค่าใช้จ่ายในการพยายามน้อยกว่าอากาศพัฟหรือรางวัลเพราะค่าใช้จ่ายความพยายามขยายออกไปชั่วขณะในเวลาไม่กี่วินาทีเมื่อลิงทำการตรึงและไม่ตรงกับเครื่องหมาย ดังนั้นเซลล์ประสาทโดปามีนอาจไม่ได้ถูกกระตุ้นให้มีค่าใช้จ่ายที่ต่ำกว่า ความเป็นไปได้อีกอย่างก็คือเซลล์ประสาทประเภทโดปามีนที่ตอบสนองต่อเหตุการณ์ต่าง ๆ หลังจากที่มีการเคลื่อนไหวเกิดขึ้น เมื่อรางวัลหรือพัฟอากาศถูกส่งไปยังลิงพวกมันเคลื่อนไหวเช่นการเลียหรือการกะพริบตา อย่างไรก็ตามในภารกิจ saccade HLC ลิงต้องจ้องมองเป้าหมายการตรึงโดยไม่มีการเคลื่อนไหวใด ๆ เป็นค่าใช้จ่าย ที่จริงแล้วการศึกษาล่าสุดแสดงให้เห็นว่าการปล่อยโดปามีนในนิวเคลียส accumbens หลังจากคิวการทำนายผลตอบแทนจะลดทอนเว้นแต่การเคลื่อนไหวจะเริ่มอย่างถูกต้อง39. เนื่องจากค่าใช้จ่ายในการทดลองของเราไม่เกี่ยวข้องกับการเริ่มต้นการเคลื่อนไหวสิ่งนี้อาจส่งผลให้เกิดการตอบสนองที่ไม่สอดคล้องกันของเซลล์ประสาทโดปามีนประเภท salience ไม่ว่าจะด้วยวิธีใดเราสามารถสรุปได้ว่าข้อมูลต้นทุนถูกประมวลผลแตกต่างจากข้อมูล aversive

โดยสรุปเราขอแนะนำว่าค่าใช้จ่ายที่จ่ายเพิ่มมูลค่าของตัวชี้นำการทำนายผลตอบแทนและสิ่งนี้จะเพิ่มสัญญาณ RPE ที่เข้ารหัสในเซลล์ประสาทโดปามีนในสมองส่วนกลาง ผลกระทบนี้นำไปสู่การทำนายพฤติกรรมว่าอัตราการเรียนรู้ของสัตว์จะเพิ่มขึ้นสำหรับการชี้นำการทำนายผลตอบแทนหลังจากประสบการณ์ของ HC นี่คือสิ่งที่เราสังเกตเห็น ดังนั้นการสังเกตของเราเกี่ยวกับกิจกรรมของเซลล์ประสาทโดพามีนทำให้เราตั้งสมมติฐานการมีอยู่ของผลกระทบทางพฤติกรรมรวมถึงกลไกการคำนวณสมมุติที่มีผลกระทบนี้ซึ่งเรายืนยันในภายหลัง ดังนั้นการค้นพบของเราจึงเป็นตัวอย่างของการคำนวณสมการที่เกิดขึ้นระหว่างการวัดข้อมูลประสาททฤษฎีการคำนวณและพฤติกรรม: การพัฒนาความเข้าใจที่ลึกซึ้งยิ่งขึ้นเกี่ยวกับการประมวลผลของเซลล์ประสาทในสมองสามารถให้ข้อมูลเชิงลึกเกี่ยวกับพฤติกรรมและพื้นฐานการคำนวณ

วิธีการ

สัตว์

เราใช้ลิงญี่ปุ่นตัวผู้สองตัว (มาคาคา ฟุสคาตา; น้ำหนักตัว 6.5 กก. = Monkey P; น้ำหนักตัว 9.0 กก. = Monkey S) เราปลูกฝังเสาหัวที่ด้านบนของกะโหลกศีรษะลิงเพื่อที่จะสามารถติดกับเก้าอี้ได้ในภายหลัง นอกจากนี้ยังมีการฝังห้องบันทึกเสียงเพื่อเปิดใช้งานการติดตั้งหัววัดไมโครมิเตอร์แบบอิเล็กโทรด ห้องบันทึกเสียงเอียง 45 °ด้านข้างในระนาบโคโรนาและวางตำแหน่งที่พิกัด stereotaxic: 15 มม. ด้านหน้าไปยังคลองภายนอก หลังจากช่วงพักฟื้นลิงได้รับการฝึกฝนให้ทำงาน saccade หลังจากเสร็จสิ้นการฝึกอบรมเราเจาะรูผ่านหัวกะโหลกด้านในห้องบันทึกเสียงเพื่อใส่อิเล็กโทรด โปรโตคอลการดูแลสัตว์ทั้งหมดได้รับการอนุมัติจากคณะกรรมการการทดลองสัตว์ของมหาวิทยาลัยทามากาวะและสอดคล้องกับคู่มือสถาบันสุขภาพแห่งชาติเพื่อการดูแลและการใช้สัตว์ทดลอง

งานด้านพฤติกรรม

ลิงได้รับการฝึกฝนให้ทำงาน HLC saccade (รูปที่ 1a) งานที่ไม่แน่นอนของ HLC (รูปที่ 5a) และงานสำรวจ HLC (รูปที่ 7a). งานทั้งหมดดำเนินการในห้องมืด ลิงนั่งอยู่บนเก้าอี้หน้า 22 นิ้ว จอ LCD (S2232W, Eizo) พร้อมเสาฝังที่ยึดติดกับเก้าอี้ ระยะห่างระหว่างดวงตาและจอแสดงผลคือ 70 ซม. เมื่อมีการนำเสนอคิวเริ่มต้น (วงกลมสีขาวเส้นผ่านศูนย์กลาง 0.3 °) ที่ตรงกลางของจอแสดงผลลิงจะต้องจ้องมองไปที่คิว คิวเริ่มต้นหายไปหลังจาก 750 มิลลิวินาทีแล้วจึงมีการนำเสนอคิวต้นทุน (ดาวและกังหันลมสำหรับการทดลอง HC และ LC ตามลำดับ) ลิงถูกกำหนดให้ต้องสังเวยคิวต้นทุนในช่วง 750 มิลลิวินาทีของการนำเสนอคิว หากพวกเขาไม่ได้ทำการสังเวยคิวการพิจารณาคดีก็ถูกยกเลิกและการพิจารณาคดีเดียวกันจะเริ่มขึ้นอีก ในระหว่างการทดลอง HC เป้าหมายการตรึง (0.3 °× 0.3 °สี่เหลี่ยมสีขาว) ถูกนำเสนอหลังจากการหายไปของคิวต้นทุนเป็นเวลา 2000 มิลลิวินาที (ภารกิจที่ไม่แน่นอนของ HLC saccade และ HLC) หรือ 1500 มิลลิวินาที (งานสำรวจ HLC) และลิงเป็นสิ่งจำเป็น เพื่อล้างบาปและจ้องมองมัน หากลิงขยับสายตาเกินหน้าต่างตรึง 4 °× 4 °งานนั้นจะถูกยกเลิก หน้าต่างการตรึงถูกเปิดใช้งาน 400 มิลลิวินาทีหลังจากการนำเสนอจุดตรึงเนื่องจากลิงต้องใช้เวลาในการเตรียมการสำหรับ saccade และสำหรับการปรับการตรึง ดังนั้นลิงจึงต้องกำหนดเวลาอย่างน้อย 1600 ms (งานที่ไม่แน่นอนของ HLC saccade และ HLC) หรือ 1100 ms (งานสำรวจ HLC) ในการทดลอง HC ในการทดลอง LC หน้าจอว่างจะแสดงเป็นเวลา 1500 ms (งานที่ไม่แน่นอนของ HLC saccade และ HLC) หรือ 1000 ms (งานสำรวจ HLC) จากนั้นเป้าหมายการตรึงจะปรากฏเป็นเวลา 500 ms เนื่องจากหน้าต่างการตรึงถูกเปิดใช้งาน 400 มิลลิวินาทีหลังจากการนำเสนอจุดตรึงลิงจึงจำเป็นต้องตรึงบนเป้าหมายเป็นเวลาอย่างน้อย 100 มิลลิวินาทีในการทดลอง LC ลิงแสดงข้อผิดพลาดเพิ่มเติมในการทดลอง HC; ดังนั้นจึงมีการแทรกการยกเลิกแบบบังคับ 100 มิลลิวินาทีก่อนการนำเสนอคิวรางวัล (400 มิลลิวินาทีหลังจากการนำเสนอเป้าหมายการตรึงซึ่งเป็นช่วงเวลาของการเริ่มต้นหน้าต่างตรึง) ในการทดลอง LC เพื่อปรับอัตราความสำเร็จ หลังจากที่กำหนดเป้าหมายแล้วจะมีการนำเสนอรางวัลหนึ่งหรือสองรางวัลและลิงจะต้องทำการสังเวยคิว หากพวกเขาสร้าง Saccade ไปยังคิวรางวัลได้สำเร็จจะมีเสียงบี๊บดังขึ้น 750 มิลลิวินาทีหลังจากการนำเสนอคิวรางวัล เมื่อลิงทำ saccade ถึงคิว R + น้ำ 0.3 มล. จะถูกส่งไปพร้อม ๆ กับเสียงบี๊บ ไม่มีการมอบรางวัลใด ๆ ให้เมื่อพวกเขาทำพิธีไหว้ครูที่ R− cue

ในภารกิจ saccade HLC มีการใช้วงกลมสีสี่สีเป็นตัวชี้นำรางวัล (RHC+: สีเหลือง; RHC-: เขียว RLC+: สีชมพู; RLC-: สีน้ำเงิน รูปที่. 1a). เซสชันการทดลองหนึ่งครั้งประกอบด้วยการทดลอง Saccade 80 ครั้งการทดลองให้รางวัลที่คาดเดาไม่ได้ 20 ครั้งการทดลองใช้พัฟเป่าลมที่คาดเดาไม่ได้ 20 ครั้งและการทดลองทางเลือก 5 แบบ การทดลอง Saccade ประกอบด้วยการทดลอง HC 40 ครั้งและการทดลอง LC 40 ครั้งซึ่งทั้งสองอย่างนี้รวมการทดลองรางวัล 20 ครั้งและการทดลองไม่มีรางวัล 20 ครั้ง ในการให้รางวัลที่คาดเดาไม่ได้หรือการทดลองใช้เครื่องเป่าลมจะมีการส่งมอบรางวัลน้ำ 0.3 มิลลิลิตรหรือพัฟอากาศ 0.2 MPa (150 มิลลิวินาทีสำหรับลิง P; 200 มิลลิวินาทีสำหรับลิง S) ถูกส่งไปยังใบหน้าของลิงโดยไม่ได้รับการดูแล การทดลองทางเลือกรวมถึงการทดลองที่ลิงเลือกระหว่าง R + cues (RHC+ กับ RLC+) ในการทดลอง HC ระหว่าง R− cues (RHC- กับ RLC-) ในการทดลอง HC ระหว่าง R + (RHC+ กับ RLC+) ตัวชี้นำในการทดลอง LC ระหว่าง R− (RHC- กับ RLC-) ตัวชี้นำในการทดลอง LC และระหว่างตัวชี้นำต้นทุน (รูปที่เพิ่มเติม 1) ในการทดลองที่มีตัวเลือกระหว่างตัวชี้นำรางวัลโครงสร้างของงานนั้นเหมือนกับภารกิจ saccade ก่อนที่จะให้รางวัลการนำเสนอ ถัดไปแทนที่จะแสดงคิวรางวัลสองตัวชี้นำรางวัลถูกนำเสนอในการทดลองทางเลือกและไม่มีการมอบรางวัลใด ๆ หลังจากการนำเสนอรางวัลคิวแม้ว่าลิงจะทำการเลือกระหว่างตัวชี้นำ R +

เพื่อทดสอบการตอบสนองของโดปามีนเซลล์ประสาทเพื่อให้รางวัลการส่งลิงดำเนินงานที่ไม่แน่นอน HLC (รูปที่ 5a) งานนี้คล้ายกับภารกิจ saccade HLC ยกเว้นสำหรับตัวชี้นำรางวัล ในภารกิจนี้เราใช้ตัวชี้นำรางวัลสองอัน (แทนที่จะเป็นสี่ตัวชี้นำรางวัลที่ใช้ในภารกิจ saccade ของ HLC) อันหนึ่งสำหรับการทดลอง HC และอีกอันสำหรับการทดลอง LC รางวัลถูกส่งมอบในครึ่งหนึ่งของการทดลองหลังจากการนำเสนอรางวัลคิว การทดลองหนึ่งครั้งประกอบด้วยการทดลอง saccade 80 ครั้งการทดลองให้รางวัลแบบคาดเดาไม่ได้ 20 ครั้งและการทดลองพัฟอากาศแบบคาดเดาไม่ได้ 20 ครั้ง การทดลอง saccade รวมการทดลอง HC 40 ครั้งและการทดลอง LC 40 ครั้งโดยทั้งสองรวมการทดลองรางวัล 20 ครั้งและการทดลองไม่ให้รางวัล 20 ครั้ง ในการทดลองที่คาดเดาไม่ได้รางวัลหรือพัฟทางอากาศก็ถูกส่งมอบโดยไม่มีคิว

ในภารกิจการสำรวจ HLC สองรางวัลรางวัล (RHC+, รHC- หรือ RLC+, รLC-) ถูกนำเสนอไปพร้อม ๆ กันและลิงนั้นจะต้อง saccade กับหนึ่งในสัญลักษณ์ของรางวัล (รูปที่ 7a) หากพวกเขาเลือก R + cue พวกเขาจะได้รับรางวัลน้ำ รางวัลสี่รางวัล (RHC +, RHC-, อาร์LC +, RLC-) สร้างขึ้นสำหรับการสำรวจแต่ละครั้งและลิงจำเป็นต้องเรียนรู้การเชื่อมโยงระหว่างตัวชี้นำและรางวัลการทดลองโดยการทดลอง การทดลองหนึ่งครั้งประกอบด้วยการทดลอง HC 100 ครั้งและการทดลอง LC 100 ครั้ง เราพบว่าสำหรับภารกิจสำรวจหากเราตั้งระยะเวลาการตรึงไว้ที่ 2000 ms ในเงื่อนไข HC เพื่อให้ตรงกับระยะเวลาของเงื่อนไข HC ในงานอื่น ๆ ลิงทำหน้าที่ด้วยอัตราความสำเร็จที่ต่ำมากอาจเป็นเพราะ ความยากของงานและ / หรืออัตราผลตอบแทนที่ต่ำตามมา ดังนั้นเพื่อลดความยากลำบากของงานและเพิ่มอัตราความสำเร็จเราจึงใช้ระยะเวลาการตรึง 1500 มิลลิวินาทีเป็นค่าใช้จ่ายสำหรับงานสำรวจ HLC

งานถูกควบคุมโดยใช้ชุดซอฟต์แวร์ที่มีวางจำหน่ายทั่วไป (TEMPO, Reflective Computing, St. Louis, MO, USA) โปรแกรมที่กำหนดเองทำโดยใช้แอปพลิเคชันการเขียนโปรแกรมอินเทอร์เฟซ (OpenGL) ถูกใช้สำหรับงานนำเสนอการกระตุ้นด้วยภาพ สิ่งเร้าทางสายตาสำหรับราคาและตัวชี้นำรางวัลถูกสร้างขึ้นโดยผู้เขียน

การบันทึกและเก็บข้อมูล

ประมาณการตำแหน่งของ substantia nigra ใช้ภาพ MR อิเล็กโทรดทังสเตนเคลือบอิพ็อกซี (เส้นผ่าศูนย์กลางก้าน 0.25 มม. 0.5-1.5 MΩวัดที่ 1000 Hz, FHC) ถูกแทรกเข้าไปใน substantia nigra โดยใช้ไมโครโฟนิมิเตอร์ (MO-972, Narishige, โตเกียว, ญี่ปุ่น) ติดตั้งบนห้องบันทึกด้วย หลอดคู่มือสแตนเลส สัญญาณแรงดันถูกขยาย (× 10,000) และกรอง (0.5–2 kHz) ศักย์การกระทำจากเซลล์ประสาทเดี่ยวถูกแยกด้วยอัลกอริทึมการจับคู่แม่แบบ (OmniPlex, Plexon, Dallas, TX, USA) การเคลื่อนไหวของดวงตาได้รับการตรวจสอบด้วยระบบกล้องอินฟราเรดที่อัตราการสุ่มตัวอย่าง 500 Hz (iView X Hi-Speed Primate, SMI, Teltow, Germany) เวลาของเหตุการณ์ที่อาจเกิดขึ้นและเหตุการณ์พฤติกรรมถูกบันทึกด้วยความละเอียดเวลา 1 kHz

การวิเคราะห์ข้อมูล

ในการวิเคราะห์พฤติกรรมของลิงนั้น RTs ถูกกำหนดเป็นช่วงเวลาระหว่างการเริ่มต้นของการกระตุ้นและเวลาที่ลิงเริ่มต้น saccade เริ่มต้น saccade ถูกกำหนดโดยการคำนวณเวลาเมื่อตำแหน่งจ้องเกิน 5 เบี่ยงเบนมาตรฐานจากตำแหน่งจ้องเฉลี่ยก่อนที่จะนำเสนอคิว

ในภารกิจการสำรวจ HLC พฤติกรรมการเลือกของลิงนั้นถูกหาปริมาณด้วยการปรับฟังก์ชันเลขชี้กำลังแบบสะสม ฟังก์ชั่น (P) อธิบายสัดส่วนของตัวเลือกที่ถูกต้องดังนี้:

ที่ไหน t หมายถึงการทดลอง a และ b บ่งบอกถึงความลาดชันและที่ราบสูงของเส้นโค้งตามลำดับ ฟังก์ชั่นนี้สอดคล้องกับข้อมูลสำหรับเงื่อนไขต้นทุนทั้งสองอย่างอิสระ พารามิเตอร์ของฟังก์ชันถูกค้นหาเพื่อเพิ่มความเป็นไปได้สูงสุดในการสังเกตข้อมูลจากเซสชันเดียวและข้อมูลเฉลี่ย วิธีการ bootstrap ถูกนำมาใช้ในการประมาณช่วงความเชื่อมั่นเมื่อเหมาะสมกับข้อมูลเฉลี่ย รูปแบบ RL มาตรฐานยังใช้ในการหาปริมาณข้อมูลพฤติกรรม ค่าการกระตุ้น Vj(t) สำหรับตัวเลือกที่เลือก j (j = 1 สำหรับเงื่อนไข HC; j = 2 สำหรับเงื่อนไข LC) ได้รับการอัปเดตดังนี้:

ที่ไหน αj ระบุอัตราการเรียนรู้ซึ่ง จำกัด กับค่าระหว่าง 0 ถึง 1 R(t) ระบุจำนวนรางวัล (1: ได้รับรางวัล, 0: ไม่มีรางวัล) ในการทดลอง t.

ความน่าจะเป็น Pj(t) การเลือกตัวกระตุ้น j จากสิ่งเร้าทั้งสองในการพิจารณาคดี t ถูกกำหนดโดยกฎ softmax

ที่ไหน βj ระบุขอบเขตของการสำรวจ

เราบันทึกกิจกรรมของเซลล์ประสาทในระหว่างภารกิจที่ไม่แน่นอนของ HLC saccade และ HLC แต่ไม่ใช่ภารกิจการสำรวจ HLC ภารกิจการสำรวจ HLC ถูกนำไปใช้เป็นการศึกษาพฤติกรรมล้วนๆ เซลล์ประสาทโดปามีนถูกระบุว่ามีคุณสมบัติแต่ละอย่างดังต่อไปนี้: อัตราการยิงยาชูกำลังต่ำ (<6 เฮิรตซ์) ระยะเวลาที่ยาวนานของรูปคลื่นขัดขวาง (> 300 ss) และการตอบสนองเชิงเฟสต่อรางวัลที่คาดเดาไม่ได้ (รูปเสริม 2a) เราวิเคราะห์การทดลองที่ลิงสามารถทำการทดลองให้เสร็จสมบูรณ์โดยไม่มีข้อผิดพลาดใด ๆ (การตรึงเบรกไม่มี saccade หรือแท้งเทียม) อัตราการเผาไหม้ของเซลล์ประสาทเฉลี่ยคำนวณด้วย 1 ถังขยะและเรียบด้วยเคอร์เนล Gaussian (σ = 30 ms ความกว้าง = 4σ) เพื่อสร้างฟังก์ชั่นความหนาแน่นขัดขวาง การตอบสนองของเซลล์โดปามีนต่อเหตุการณ์แต่ละงานถูกคำนวณเป็นอัตราการยิงปกติที่สัมพันธ์กับกิจกรรมที่เกิดขึ้นเอง (หมายถึงอัตราการยิงในช่วง 500 มิลลิวินาทีก่อนที่จะเริ่มคิว) อัตราการยิงถูกคำนวณภายในระยะเวลาที่กำหนดสำหรับแต่ละภารกิจและหัวข้อ หน้าต่างเวลาเหล่านี้ถูกกำหนดจากกิจกรรมเฉลี่ยประชากร เรากำหนดจุดเริ่มต้นและจุดสิ้นสุดของช่วงเวลาที่กำหนดโดยพิจารณาจากการเพิ่มขึ้นและลดลงของการตอบกลับโดยเฉลี่ยของประชากรโดยใช้การศึกษาโดปามีนลิงก่อนหน้านี้เป็นข้อมูลอ้างอิง 3) หน้าต่างเวลาสำหรับคิวเริ่มถูกกำหนดให้เป็น 200–400 ms หลังจากเริ่มคิวเริ่มต้นสำหรับเซลล์ประสาทที่บันทึกจากลิง P และ S หน้าต่างเวลาสำหรับคิวเริ่มต้นถูกกำหนดเป็น 150–300 มิลลิวินาทีหลังจากเงื่อนไขคิวเริ่มสำหรับลิง P และ 200–400 มิลลิวินาทีสำหรับลิง S. หน้าต่างเวลาสำหรับคิวรางวัลถูกกำหนดไว้ที่ 140–350 มิลลิวินาทีหลังจากรางวัลคิวเริ่มขึ้นสำหรับลิง P และ 220–420 มิลลิวินาทีสำหรับลิง S. หน้าต่างเวลาสำหรับการส่งรางวัลถูกกำหนดเป็น 225– 475 มิลลิวินาทีหลังจากสัญญาณเตือนสำหรับลิง P และ 200–450 มิลลิวินาทีสำหรับลิง S หน้าต่างเวลาสำหรับการส่งมอบรางวัลที่คาดเดาไม่ได้ถูกกำหนดเป็น 100–300 มิลลิวินาทีหลังจากส่งรางวัลสำหรับลิง P และ 150–300 มิลลิวินาทีสำหรับลิงเอส หน้าต่างเวลาสำหรับพัฟอากาศที่ไม่สามารถคาดเดาได้ถูกกำหนดไว้ที่ 30–230 มิลลิวินาทีหลังจากการส่งมอบอากาศพัฟสำหรับลิง P และ 50–200 มิลลิวินาทีสำหรับลิงเอส

เราจำแนกเซลล์ประสาทโดปามีนที่บันทึกไว้ทั้งหมดออกเป็นสองประเภทที่แตกต่างกันคือคุณค่าที่สร้างแรงบันดาลใจและประเภทความรู้สึก ถ้าการตอบสนองของเซลล์ประสาทต่อสิ่งเร้าในอากาศมีขนาดเล็กกว่ากิจกรรมที่เกิดขึ้นเองเซลล์ประสาทถูกจัดประเภทให้อยู่ในประเภทค่าสร้างแรงบันดาลใจ (รูปที่ 3d, e) ในทางตรงกันข้ามถ้าการตอบสนองของเซลล์ประสาทต่อสิ่งเร้าอากาศพัฟนั้นมีขนาดใหญ่กว่ากิจกรรมที่เกิดขึ้นเองเซลล์ประสาทนั้นถูกจำแนกว่าเป็นประเภทนูน (รูปที่ XNUMX) 3g, ห่า).

เพื่อหาปริมาณกิจกรรมของเซลล์ประสาทที่แตกต่างกันระหว่างเงื่อนไขของงานการวิเคราะห์ ROC ได้ดำเนินการ เราคำนวณ auROC สำหรับเซลล์ประสาทแต่ละเซลล์ auROC ที่เล็กกว่าหรือมากกว่า 0.5 แสดงถึงการตอบสนองที่น้อยลงหรือมากขึ้นในการทดลอง HC ตามลำดับ เนื่องจากจำนวนเซลล์ประสาทในชุดข้อมูลเซลล์ประสาทบางชุดมีขนาดเล็กเราจึงใช้การทดสอบอันดับที่ลงนามของ Wilcoxon เพื่อลดผลกระทบของค่าผิดปกติในการหาปริมาณการแจกแจงแบบเอนเอียงของ auROC

MATLAB (MathWorks, Natick, MA, USA) ถูกนำมาใช้เพื่อทำการวิเคราะห์ข้อมูลทั้งหมด

การตรวจทางจุลพยาธิวิทยา

หลังจากการทดลองบันทึกเสียงลิงทั้งสองตัวถูกนำมาทำการวิเคราะห์ทางเนื้อเยื่อวิทยาเพื่อตรวจสอบตำแหน่งการบันทึก 2b) ลิงถูกกำจัดโดยการให้ยาเพนโทบาร์บาลิทัลขนาด 70 มิลลิกรัมต่อกิโลกรัม-1) และ perfused ด้วย 4% ดีไฮด์ในบัฟเฟอร์ฟอสเฟต ตัดส่วนต่อเนื่องแบบอนุกรม (ความหนา 10 ไมครอน) และ immunostained ด้วยแอนติบอดีต่อต้านไทโรซีนไฮดรอกซี (TH) (ทุก 25 ส่วน; แอนติบอดีต่อต้าน TH, 1: 500; เมอร์คดาร์มชตัดท์เยอรมนี) หรือการย้อมสี Nissl (ทุก 25 ส่วน) .

สรุปการรายงาน

ข้อมูลเพิ่มเติมเกี่ยวกับการออกแบบการวิจัยมีอยู่ใน สรุปรายงานการวิจัยธรรมชาติ เชื่อมโยงกับบทความนี้

รหัสห้องว่าง

รหัส Matlab ที่ใช้ในการวิเคราะห์การศึกษานี้มีให้จากผู้เขียนที่เกี่ยวข้องตามคำขอที่สมเหตุสมผล

อ้างอิง

- 1.

Clement, TS, Feltus, JR, Kaiser, DH & Zentall, TR“ จรรยาบรรณในการทำงาน” ในนกพิราบ: มูลค่ารางวัลเกี่ยวข้องโดยตรงกับความพยายามหรือเวลาที่ต้องใช้ในการได้รับรางวัล Psychon วัว. รายได้ 7, 100 – 106 (2000)

- 2.

Klein, ED, Bhatt, RS & Zentall, TR Contrast และเหตุผลของความพยายาม Psychon วัว. รายได้ 12, 335 – 339 (2005)

- 3.

Zentall, TR & Singer, RA ความแตกต่างภายในการทดลอง: นกพิราบชอบสารเสริมแรงที่มีเงื่อนไขซึ่งเป็นไปตามเหตุการณ์ที่ค่อนข้างเกลียดชังน้อยกว่า J. ประสบการณ์ ทางทวารหนัก Behav 88, 131 – 149 (2007)

- 4.

Aronson, E. & Mills, J. ผลของความรุนแรงของการเริ่มต้นต่อความชอบในกลุ่ม J. Abnorm Soc จิตวิทยา 59, 177 – 181 (1959)

- 5.

เฟสติงเกอร์, แอล. ทฤษฎีความรู้ความเข้าใจเกี่ยวกับความรู้ความเข้าใจ. (สำนักพิมพ์มหาวิทยาลัยสแตนฟอร์ด, แคลิฟอร์เนีย, 1957)

- 6.

Alessandri, J. , Darcheville, JC, Delevoye-Turrell, Y. & Zentall, TR การตั้งค่าสำหรับรางวัลที่เป็นไปตามความพยายามที่มากขึ้นและความล่าช้าที่มากขึ้น เรียนรู้ Behav 36, 352 – 358 (2008)

- 7.

Schultz, W. , Carelli, RM & Wightman, RM Phasic dopamine สัญญาณ: จากมูลค่ารางวัลอัตนัยไปจนถึงอรรถประโยชน์ทางเศรษฐกิจอย่างเป็นทางการ ฟี้ Opin Behav วิทย์ 5, 147 – 154 (2015)

- 8.

Schultz, W. , Dayan, P. & Montague, PR พื้นผิวประสาทของการทำนายและการให้รางวัล วิทยาศาสตร์ 275, 1593 – 1599 (1997)

- 9.

Bromberg-Martin, ES, Matsumoto, M. & Hikosaka, O. Dopamine ในการควบคุมแรงจูงใจ: การให้รางวัล, ไม่ชอบและการแจ้งเตือน เซลล์ประสาท 68, 815 – 834 (2010)

- 10.

Bayer, HM & Glimcher, PW Midbrain dopamine neurons เข้ารหัสสัญญาณข้อผิดพลาดในการทำนายผลตอบแทนเชิงปริมาณ เซลล์ประสาท 47, 129 – 141 (2005)

- 11.

Nakahara, H. , Itoh, H. , Kawagoe, R. , Takikawa, Y. & Hikosaka, O. เซลล์ประสาทโดปามีนสามารถแสดงถึงข้อผิดพลาดในการทำนายตามบริบท เซลล์ประสาท 41, 269 – 280 (2004)

- 12.

Tobler, PN, Fiorillo, CD & Schultz, W. การเข้ารหัสแบบปรับตัวของมูลค่ารางวัลโดยเซลล์ประสาทโดปามีน วิทยาศาสตร์ 307, 1642 – 1645 (2005)

- 13.

Nomoto, K. , Schultz, W. , Watanabe, T. & Sakagami, M. การตอบสนองของโดปามีนที่ขยายออกไปทางปากต่อการรับรู้ที่เรียกร้องสิ่งเร้าที่คาดเดาผลตอบแทน J. Neurosci 30, 10692 – 10702 (2010)

- 14.

Watabe-Uchida, M. , Zhu, L. , Ogawa, SK, Vamanrao, A. & Uchida, N. การทำแผนที่ทั้งสมองของข้อมูลโดยตรงไปยังเซลล์ประสาทโดพามีนส่วนกลางสมอง เซลล์ประสาท 74, 858 – 873 (2012)

- 15.

ทานากะ, เซาท์แคโรไลนาและคณะ การทำนายผลตอบแทนในทันทีและในอนาคตจะมีการคัดเลือกลูปคอร์ติโก้ - เบสต่างกัน ชัยนาท Neurosci 7, 887 – 893 (2004)

- 16.

Haber, SN, Kim, KS, Mailly, P. & Calzavara, R. อินพุตเยื่อหุ้มสมองที่เกี่ยวข้องกับรางวัลจะกำหนดบริเวณ striatal ขนาดใหญ่ในสัตว์เลี้ยงลูกด้วยนมที่เชื่อมต่อกับการเชื่อมต่อเยื่อหุ้มสมองที่เชื่อมโยงซึ่งเป็นพื้นผิวสำหรับการเรียนรู้ตามแรงจูงใจ J. Neurosci 26, 8368 – 8376 (2006)

- 17.

Doya, K. Modulators แห่งการตัดสินใจ ชัยนาท Neurosci 11, 410 – 416 (2008)

- 18.

Roesch, MR, Calu, DJ & Schoenbaum, G. เซลล์ประสาทโดปามีนเข้ารหัสตัวเลือกที่ดีกว่าในหนูที่ตัดสินใจเลือกระหว่างรางวัลที่ล่าช้าหรือขนาดต่างกัน ชัยนาท Neurosci 10, 1615 – 1624 (2007)

- 19.

Lak, A. , Stauffer, WR & Schultz, W. การตอบสนองข้อผิดพลาดจากการคาดคะเนของ Dopamine จะรวมมูลค่าส่วนตัวจากมิติรางวัลที่แตกต่างกัน พร Natl Acad วิทย์ สหรัฐอเมริกา 111, 2343 – 2348 (2014)

- 20.

Stauffer, WR, Lak, A. & Schultz, W. การตอบสนองข้อผิดพลาดในการทำนายรางวัลโดปามีนสะท้อนให้เห็นถึงอรรถประโยชน์เล็กน้อย ฟี้ Biol 24, 2491 – 2500 (2014)

- 21.

Noritake, A. , Ninomiya, T. & Isoda, M. การตรวจสอบและประเมินผลตอบแทนทางสังคมในสมองลิงกัง ชัยนาท Neurosci 21, 1452 – 1462 (2018)

- 22.

Pasquereau, B. & Turner, RS Limited การเข้ารหัสของความพยายามโดยเซลล์ประสาทโดปามีนในงานแลกเปลี่ยนผลประโยชน์ด้านต้นทุน J. Neurosci 33, 8288 – 8300 (2013)

- 23.

Varazzani, C. , San-Galli, A. , Gilardeau, S. & Bouret, S. Noradrenaline และเซลล์ประสาทโดปามีนในการให้รางวัล / ความพยายามในการแลกเปลี่ยน: การเปรียบเทียบทางอิเล็กโทรฟิสิกส์โดยตรงในพฤติกรรมของลิง J. Neurosci 20, 7866 – 7877 (2015)

- 24.

Watanabe, N. , Sakagami, M. และ Haruno, M. J. Neurosci 33, 4487 – 4493 (2013)

- 25.

Di Ciano, P. , Cardinal, RN, Cowell, RA, Little, SJ & Everitt, B. J. Neurosci 21, 9471 – 9477 (2001)

- 26.

Flagel, SB และคณะ บทบาทที่เลือกสรรสำหรับโดปามีนในการเรียนรู้สิ่งกระตุ้น ธรรมชาติ 469, 53 – 57 (2011)

- 27.

Blough, DS ผลของการเตรียมพื้นผิวการแยกแยะและการเสริมแรงต่อองค์ประกอบเวลาปฏิกิริยาของการค้นหาด้วยสายตาแบบนกพิราบ J. ประสบการณ์ จิตวิทยา Anim Behav กระบวนการ. 26, 50 – 63 (2000)

- 28.

Matsumoto, M. & Hikosaka, O. เซลล์ประสาทโดปามีนสองประเภทถ่ายทอดสัญญาณสร้างแรงบันดาลใจในเชิงบวกและเชิงลบอย่างชัดเจน ธรรมชาติ 459, 837 – 841 (2009)

- 29.

Matsumoto, M. & Takada, M. การแสดงสัญญาณความรู้ความเข้าใจและแรงจูงใจที่แตกต่างในเซลล์ประสาทโดปามีนสมองส่วนกลาง เซลล์ประสาท 79, 1011 – 1024 (2013)

- 30.

วาตานาเบะ, M. et al. ปฏิกิริยาทางพฤติกรรมที่สะท้อนถึงความคาดหวังที่แตกต่างของรางวัลในลิง ประสบการณ์ ความต้านทานของสมอง 140, 511 – 518 (2001)

- 31.

Takikawa, Y. , Kawagoe, R. & Hikosaka, O. บทบาทที่เป็นไปได้ของเซลล์ประสาทโดปามีนสมองส่วนกลางในการปรับตัวของ saccades ในระยะสั้นและระยะยาวเพื่อการทำแผนที่ตำแหน่ง - รางวัล J. Neurophysiol 92, 2520 – 2529 (2004)

- 32.

Kobayashi, S. & Schultz, W. อิทธิพลของความล่าช้าในการให้รางวัลต่อการตอบสนองของเซลล์ประสาทโดปามีน. J. Neurosci 28, 7837 – 7846 (2008)

- 33.

Enomoto, K. et al. เซลล์โดปามีนเรียนรู้ที่จะเข้ารหัสค่าระยะยาวของรางวัลหลาย ๆ อย่างในอนาคต พร Natl Acad วิทย์ สหรัฐอเมริกา 108, 15462 – 15467 (2011)

- 34.

Lak, A. , Nomoto, K. , Keramati, M. , Sakagami, M. & Kepecs, A. ฟี้ Biol 27, 821 – 832 (2017)

- 35.

Williams, BA & McDevitt, MA Inhibition และ superconditioning จิตวิทยา วิทย์ 13, 454 – 459 (2002)

- 36.

Behrens, TE, Woolrich, MW, Walton, ME & Rushworth, MF เรียนรู้คุณค่าของข้อมูลในโลกที่ไม่แน่นอน ชัยนาท Neurosci 10, 1214 – 1221 (2007)

- 37.

Seymour, B. et al. กระบวนการประสาทของผู้ต่อต้าน - aversive ตรงข้ามได้รับการเรียนรู้การทำนายของการบรรเทาอาการปวด ชัยนาท Neurosci 8, 1234 – 1240 (2005)

- 38.

Kim, H. , Shimojo, S. & O'Doherty, JP กำลังหลีกเลี่ยงผลลัพธ์ที่ไม่พึงประสงค์ที่ให้ผลตอบแทนหรือไม่? พื้นผิวประสาทของการหลีกเลี่ยงการเรียนรู้ในสมองของมนุษย์ PLOS Biol 4, e233 (2006)

- 39.

Syed, EC และคณะ การเริ่มต้นแอคชั่นมีรูปแบบการเข้ารหัสโดปามีน mesolimbic ของรางวัลในอนาคต ชัยนาท Neurosci 19, 34 – 36 (2016)

กิตติกรรมประกาศ

งานนี้ได้รับการสนับสนุนโดย MEXT / JSPS ทุนช่วยเหลือในการวิจัยทางวิทยาศาสตร์ (Kakenhi) Grant number JP16H06571 และ JP18H03662 ถึง MS งานวิจัยนี้ได้รับการสนับสนุนบางส่วนโดยโครงการวิจัยเชิงกลยุทธ์สำหรับวิทยาศาสตร์สมองที่สนับสนุนโดยหน่วยงานวิจัยและพัฒนาทางการแพทย์ของญี่ปุ่น (AMED) ) และโครงการความร่วมมือวิจัยสมองญี่ปุ่น - สหรัฐฯ การวิจัยนี้ได้รับการสนับสนุนโดยโครงการทรัพยากรชีวภาพแห่งชาติที่สถาบันวิทยาศาสตร์กายภาพแห่งชาติ (NBRP ที่ NIPS) จากหน่วยงานญี่ปุ่นเพื่อการวิจัยและพัฒนาทางการแพทย์ AMED เราขอขอบคุณ Bernard W. W. Balleine และ Andrew R. Delamater สำหรับความช่วยเหลือในการเขียนบทความ