Природа зв'язку

обсяг 10, Номер статті: 3674 (2019)

абстрактний

Відомо, що нейрони дофаміну середнього мозку кодують помилки прогнозування винагороди (RPE), які використовуються для оновлення прогнозів значення. Тут ми вивчаємо, чи сигнали RPE, кодовані дофаміновими нейронами середнього мозку, модулюються вартістю, сплаченою для отримання винагороди, шляхом запису з дофамінових нейронів у неспанні, що поводяться мавпами, під час виконання завзятої задачі саккади. Відповіді нейронів на дофамін, які передбачають нагороду та доставку винагород, були збільшені після виконання дорогої дії порівняно з менш затратною дією, що дозволяє припустити, що показники RPE посилюються після виконання дорогих дій. На поведінковому рівні асоціації, що заохочують заохочення, навчаються швидше після виконання дорогої дії порівняно з менш затратною дією. Таким чином, інформація про вартість дії обробляється в системі винагороди за дофамін таким чином, що підсилює наступний сигнал RPE дофаміну, що, в свою чергу, сприяє більш швидкому навчанню в ситуаціях з високою вартістю.

Вступ

Люди та тварини віддають перевагу нагороді, отриманій після докладання чималих зусиль для її отримання порівняно з тією ж нагородою після меншої кількості зусиль1,2,3. Для цього є ряд пояснень, таких як обґрунтування зусиль4,5 і ефект контрасту6, в якій більша цінність приписується результату, отриманому після оплачених зусиль. Однак залишається незрозумілим, чи модулюється обробка інформації про винагороду в мозку зусиллями, витраченими на отримання винагороди.

Ми спеціально зосередилися на дофаміновій системі середнього мозку, враховуючи роль цієї системи у просуванні поведінкової адаптації до нагород7,8,9. Як відомо, нейрони дофаміну представляють сигнали помилки прогнозування винагороди (RPE), які можуть полегшити вивчення прогнозів винагороди базальними гангліями10,11,12,13,14,15,16,17. Міцність RPE залежить від кількості, якості та суб'єктивної цінності або корисності винагороди7,18,19,20,21. Більше того, дофамінергічна активність модулюється витратами та / або зусиллями22,23. Виходячи з цього, ми постулювали, що дофамінергічний сигнал RPE буде безпосередньо модульований витратами, сплаченими для отримання винагороди. Крім того, через те, що сигнал RPE причинно бере участь в опосередкуванні навчання асоціацій стимулу-винагороди24,25,26Ми висунули гіпотезу, що витрати, виплачені за отримання винагороди, безпосередньо збільшуватимуть швидкість навчання асоціацій стимулювання і винагороди.

Щоб перевірити наші гіпотези, ми виміряли як поведінку, так і дофамінергічну активність у двох японських мавп, поки вони виконували завдання, засновані на сакаді. Мавпи швидше реагують на підказку, що прогнозує винагороду, яку подають після дії з високою вартістю (HC) в порівнянні з акцією після низької вартості (LC). Активність дофамінергічних нейронів до прогнозування винагороди збільшується на оплачувані витрати. Крім того, швидкість навчання асоціації стимулу-винагороди також збільшується за рахунок оплачуваних витрат. Тому ми пропонуємо, що вартість, яка виплачується за отримання винагороди, збільшує сигнал RPE у нейронах дофаміну і тим самим посилює асоціації, що стимулюють стимули.

результати

Завдання сакади з високою та низькою вартістю (FLC)

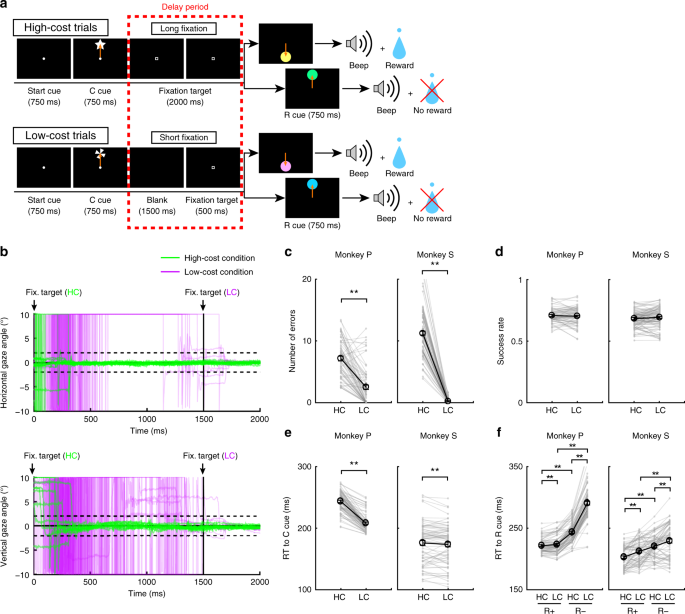

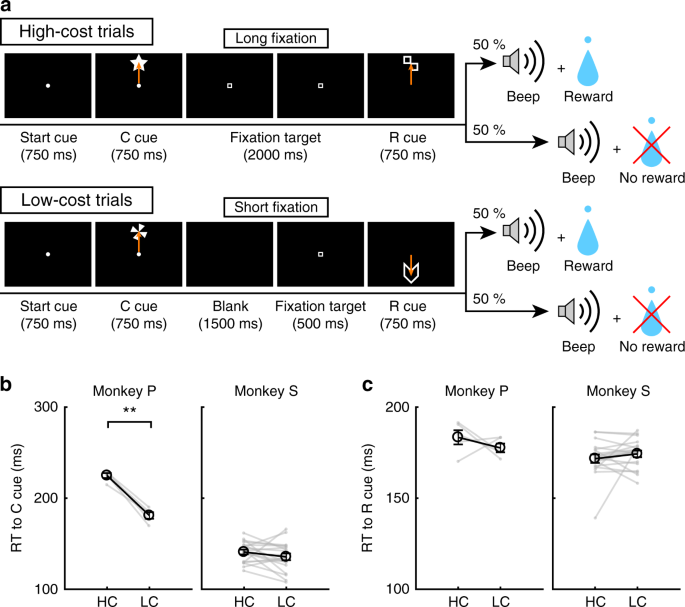

Щоб вивчити вплив оплачуваних витрат на поведінку та на активність дофамінових нейронів, мавпи виконували саккадне завдання з двома умовами витрат (рис. 1a, див. Методи). У випробуваннях на ХК мавпи швидко зробили саккаду до цілі і затримали погляд на ній, не моргаючи довший період (рис. 1b; зелені лінії). Навпаки, на випробуваннях на ЖК мавпи спочатку вільно оглядалися, перш ніж фіксуватись на коротший період (рис. 1b, фіолетові лінії). Оскільки мавпи підтримувати тривалу фіксацію складно, вони зробили більше помилок під час затримок на випробуваннях на ХК (рис. 1c). Для контролю за наслідком різниці у ймовірності винагороди між випробуваннями на ХК та випробуваннях на ЛК ми вставили примусові аборти в частину випробувань ЛК для вирівнювання рівня успішності та ймовірності винагороди між випробувальними видами (рис. 1d).

Завдання сакаде FLC. a Саккадне завдання HLC. Репліки витрат (репліка C) сигналізували про кількість зусиль, необхідних для досягнення потенційної винагороди. Протягом періоду затримки дорогих випробувань потрібно було тривале фіксування. Кий для винагороди (R кий) вказує, чи могли мавпи отримати винагороду чи ні. b Хід часу кута огляду в період затримки. На верхній та нижній панелях показані горизонтальний та вертикальний кути огляду відповідно. Зелені та фіолетові лінії вказують на кут погляду у випробуваннях з високими витратами (випробування 50 на кожній панелі) та у випробуваннях з низькими витратами (випробування 50 на кожній панелі) відповідно. c Кількість помилок під час періоду затримки у випробуваннях з високими та низькими витратами (**P < 0.01; двохвостий парний t тест; t67 = 8.8, P = 4.8 × 10-15, n = 68 для Мавпи P; t83 = 26.6, P ≈ 0, n = 84 для Мавпи S). Чорні кола та смужки помилок позначають середнє значення та SEM. d Коефіцієнти успішності у випробуваннях з високою вартістю та з низькими витратами (двохвостий пар t тест; t67 = 0.51, P = 0.61, n = 68 для Мавпи P; t83 = 0.79, P = 0.43, n = 84 для Мавпи S). e РТ до видатків (**P <0.01; двохвостий парний t тест; t67 = 20.4, P ≈ 0, n = 68 для Мавпи P; t69 = 2.0, P = 1.2 × 10-3, n = 70 для Мавпи S). f RT на нагороди (**P <0.01; двохвостий парний t тест; Мавпа П (n = 68): HC + проти LC +, t67 = 3.5, P = 9.2 × 10-4; HC – vs. LC−, t67 = 24.5, P ≈ 0; HC + проти HC−, t67 = 21.6, P ≈ 0; LC + проти LC−, t67 = 28.5, P ≈ 0; Мавпа S (n = 70): HC + проти LC +, t69 = 5.6, P = 4.4 × 10-7; HC – vs. LC−, t69 = 4.8, P = 8.4 × 10-5; HC + проти HC−, t69 = 18.0, P ≈ 0; LC + проти LC−, t69 = 5.9, P = 1.1 × 10-7)

Оплачена вартість збільшує значення київ прогнозування винагород

Щоб отримати неявні докази різниці в суб'єктивній оцінці мавп, ми перевірили час реакції мавп (RT). Зокрема, ми передбачали, що якщо мавпи присвоюють більшому суб'єктивному значенню один варіант, ніж іншому, вони повинні показувати швидші RT для більш цінного варіанту27. Коли РТ порівнювали між витратами, обидві мавпи показали більш швидкі РТ у ЖК порівняно з НК-сигналом (рис. 1e), демонструючи неявну перевагу умови ЖК. Коли RT-системи порівнювались між київськими нагородами, обидві мавпи показали швидші RT-сигнали для нагородження (R +) київ, ніж ніякі нагороди (R−) киї (рис. 1f), що вказує на те, що вони віддавали перевагу знакам R + перед R-сигналами. Крім того, обидві мавпи демонстрували більш швидкі RT на RHC+ кий порівняно з RLC+ кия і до РHC- кий порівняно з RLC- кия (рис. 1f), що вказує на те, що вони оцінювали більше сигналів, що прогнозують нагороду в HC, порівняно зі станом ЖК.

Крім того, ми включили випробування вибору у завдання сакади FLC для перевірки явних переваг мавп між сигналами (Додатковий рис. 1a). Мавпи переважним чином обрали LC-кия, коли вони вибирали між київськими витратами (Додатковий рис. 1b). Мавпа S переважно вибрала RHC+ кия при виконанні завдання вибору між RHC+ і RLC+ кия, але немає переваги між RHC- і RLC- киї (додаткові рис. 1c, буд). Навпаки, мавпа P не виявляла явних переваг між RHC+ і RLC+ киї, але все-таки віддали перевагу RHC- кия при виборі між RHC- і RLC- киї (додаткові рис. 1c, буд).

Електрофізіологічні результати у завданні сакади HLC

Ми зафіксували активність однієї одиниці від нейронів, розташованих в межах substantia nigra pars compacta (SNc) та вентральної тегментарної області (VTA) під час завдань сакади HLC. Ми ідентифікували допамінові нейрони 70 у двох мавп (Додатковий рис. 2a; 18 і 52 нейрони з Мавпи Р і S відповідно). Гістологічне дослідження підтвердило, що нейрони були розташовані в SNc / VTA або навколо нього (Додатковий рис. 2b).

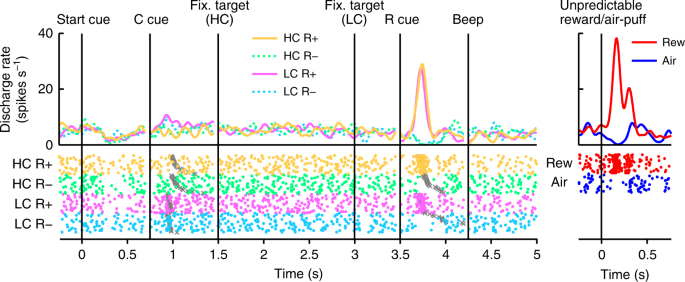

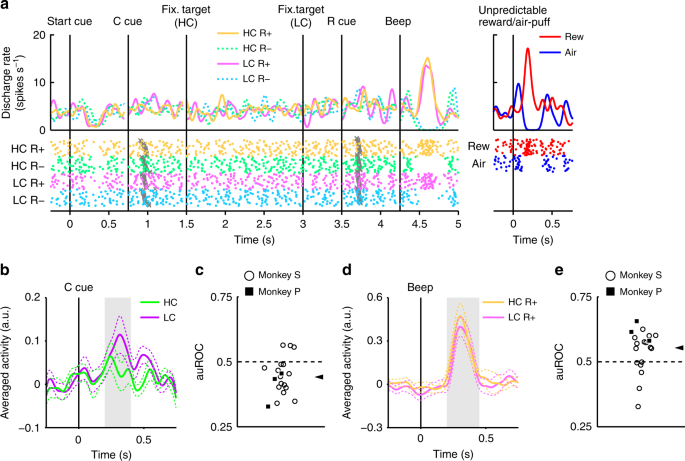

На рис. 2, ми показуємо активність репрезентативного нейрону дофаміну. Цей нейрон демонстрував скромну активацію LC-киї та фазову активацію або придушення до нагороди (RHC+ і RLC+) або немає підписів на винагороду (RHC- і RLC-) відповідно (рис. 2, Додатковий Рис. 3). Нейрон також демонстрував фазову активацію до непередбачуваної винагороди, а також фазове придушення у відповідь на неприємний стимул, непередбачуваний повітряний пухир (рис. 2, права панель). Крім того, нейрон демонстрував скромне придушення стартового сигналу, але не відповів на доставку винагороди. Уся популяція нейронів дофаміну, яку ми зафіксували, показала подібні відповіді на стартовий рейтинг і доставку винагороди (додаткова рис. 4a, б). У завданні сакади HLC перед оплатою винагород було оплачено зусилля. Оскільки передбачувана вартість знизила активність дофамінових нейронів22,23, відповіді на дофаміновий нейрон будуть придушені під час подання стартової киї16.

Активність репрезентативного дофамінового нейрона у завданні сакади HLC. Функції густини шипа (поєднані з функцією Гаусса) і растрові сюжети вирівнюються з часом настання стартової вивіски, київ витрат (C кий), цілі фіксації, виграшного кия (R кий) та звукового сигналу. Кожен колір являє собою умову (жовтий: HC +, зелений: HC−, рожевий: LC +, блакитний: LC−) відповідно. Часи настання сакади позначаються сірими хрестами. Відповіді нейронів дофаміну на непередбачувану винагороду або повітряний пуф також представлені на правій панелі (червоний: непередбачувана винагорода, синій: непередбачуваний повітряний пуф)

Дофамінові нейрони кодують інформацію як про винагороду, так і за вартість

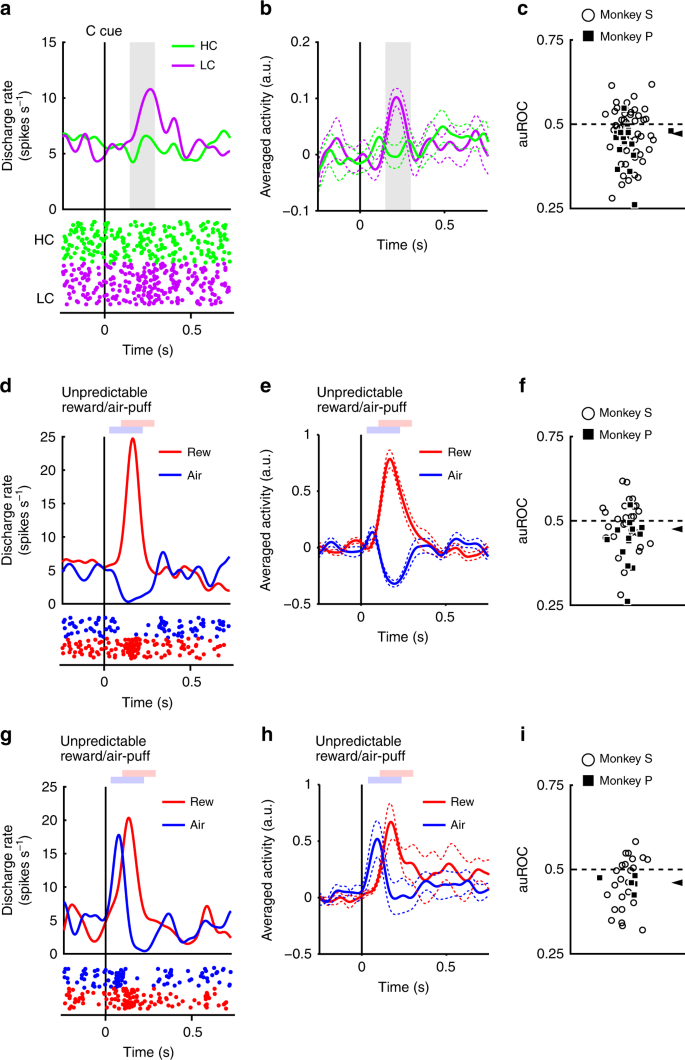

Нейрони реагували фазово на РК-кию, але менш надійно - на київку HC (рис. 3a, б). Викликані відповіді на підказки щодо умов витрат виявили меншу відповідь на сигнал киї, ніж кия LC (двосхилий Wilcoxon-підписний тест, P <3.2 × 10-4, n = 70). Ми кількісно оцінили вплив передбачуваної вартості на реакції нейронів за допомогою аналізу робочих характеристик приймача (ROC). Розподіл площі під кривою ROC (auROC) був суттєво <0.5 (рис. 3c; двосхилий тест Вілкоксона за підписом; P = 5.4 × 10-4, n = 70), що вказує на те, що відповіді на сигнали HC були меншими, ніж на сигнали LC. Раніше було встановлено, що передбачувана вартість зменшує активність нейронів дофаміну відповідно до наших результатів22,23. Крім того, популяція нейронів дофаміну виявляла значну активацію кишкою LC, не виявляючи значного придушення київ HC (Додатковий рис. 4c, буд). Ці результати говорять про те, що дофамінові нейрони кодують та інтегрують інформацію про винагороду та вартість під час подання викладу витрат.

Відповіді нейронових дофаміну на кошти. a Репрезентативна реакція допамінового нейрона на підказки щодо вартості. Функції щільності спайків розраховувались на основі нормалізованої активності нейрону дофаміну, записаного від мавпи П. Кольорові лінії позначають функції щільності спайків, а кольорові точки - час спайку. Зелений та фіолетовий кольори вказують на активність відповідно у дорогих та недорогих випробуваннях. Вертикальна лінія вказує час подання репліки витрат. Сіра область позначає період для обчислення швидкості стрільби як відповідь на сигнали стану. b Середня популяційна активність дофамінових нейронів, зафіксованих від мавпи Р до умовних значень. Суцільні лінії пунктирними лініями представляють середнє і SEM відповідно. c Розподіл площ під ROC для кількісного визначення ефекту передбачуваної вартості на реакцію нейрона на рейтинг витрат. Заповнені квадрати та відкриті кола вказують дані відповідно мавп Р і S. Наконечник стрілки вказує медіану auROC (0.47). d, g Репрезентативні відповіді дофамінового нейрона типу мотиваційного значення (d) або дофаміновий нейрон типу "слейкості" (g) до непередбачуваної винагороди або повітряного пуху. Червоні та сині криві вказують на реакцію на непередбачувану винагороду та непередбачуваний повітряний натяг відповідно. Вертикальна лінія вказує на терміни непередбачуваної винагороди або доставки повітряного пуху. Блідо-червоні та сині квадрати вказують на період для обчислення швидкості стрільби як відповідь на непередбачувану винагороду або повітряний затяг. e, h Середня популяційна активність дофамінових нейронів типу мотиваційного значення (e) або дофамінові нейрони типу "plias"h) до непередбачуваної винагороди або повітряного пуху. f, i Розподіл auROC, обчислений з мотиваційного значення дофамінових нейронів (f) або дофамінові нейрони типу "plias"i). Наконечниками стрілок вказують медіани auROC (f 0.48; i 0.46)

Раніше були описані два підтипи дофамінових нейронів: мотиваційна цінність і нейронізм виразності28,29. Ми знайшли докази в нашій популяції дофамінових нейронів у відповідь з обома підтипами. Нейрони ціннісного типу показали фазове пригнічення протилежно-повітряно-пухирних подразників (рис. 3d, e). І навпаки, нейрони слизової проявляли фазову активацію до аверсивних подразників (рис. 3g, год). Довга фіксація у дослідженні на ХК також неприємна та відверта; отже, можливо, що два підтипи нейронових нейронів показали б різні схеми реакції на відповідність вартості витрат. Якщо дофамінові нейрони представляють протилежні подразники і коштують аналогічно, то нейронні значення повинні демонструвати зниження активності до HC-киї через його відрази. З іншого боку, нейрони слинів повинні збільшувати активність до НК, оскільки вони також збільшуються до неприємних подразників. Однак спричинені відповіді обох типів нейронів були меншими за показник HC у порівнянні з LC-києм (двостулковий тест Вілкоксона за підписами рангів; P = 0.021, n = 41 і P = 0.0044, n = 29 для значень і типів виокремлення відповідно), а аналіз ROC показав менші реакції на HC порівняно з LC-сигналом в обох підтипах (рис. 3f, я; двосхилий тест Вілкоксона за підписом; P = 0.030, n = 41 і P = 0.0058, n = 29 для значень та типів виділення відповідно). Таким чином, прогнозована вартість знизила активність в обох підтипах нейронів дофаміну. Ці результати вказують на те, що інформація про витрати обробляється нейронами дофаміну якісно інакше, ніж аверсивні подразники.

У саккадному завданні HLC ми вставили примусовий аборт у частину досліджень LC, щоб вирівняти показники успіху та ймовірність винагороди між типами випробувань. Ця маніпуляція збільшила невизначеність отримання винагороди або ризик відсутності винагороди в умовах LC. Отже, вища активність нейронів дофаміну та підвищення оцінки мавп для LC над сигналом HC може бути обумовлене різницею в ризику або невизначеністю між умовами витрат. Однак ми не виявили взаємозв'язку між кількістю вимушених абортів та різницею в RT (додатковий рис. 5a, б), і ми виявили позитивну кореляцію між кількістю вимушених абортів та auROC (додаткова рис. 5c). Ми також порівнювали відповіді на дофамін на відповідність витрат після абортів проти правильних випробувань, але не виявили різниці в обох умовах витрат (Додатковий рис. 5d). Ці результати вказують на те, що кількість вимушених абортів у стані ЛК не пояснює ні збільшення оцінки, ні посилену дофамінергічну активацію до РК-киї.

Посилення реакцій на дофамін на винагороду за плату витрат

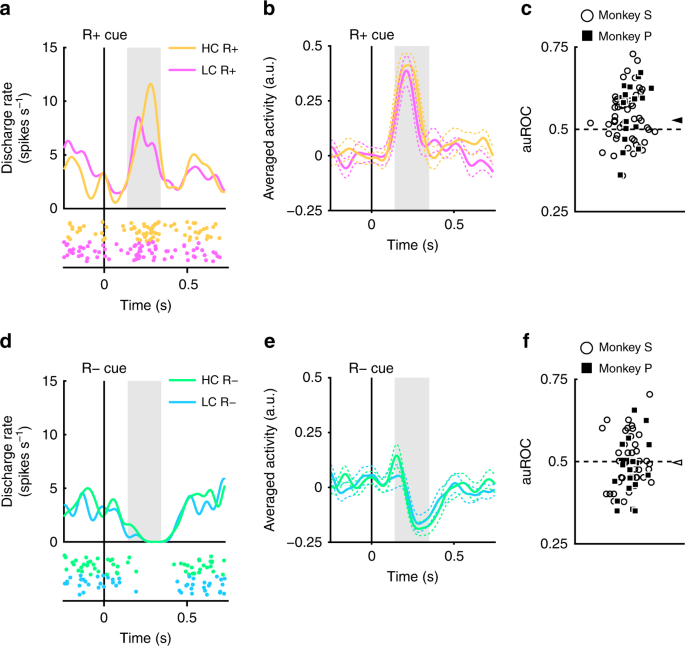

Було виявлено, що зареєстровані дофамінові нейрони демонструють фазову активацію та пригнічення для винагороди та не передбачають відповідно до прогнозу винагороди (рис. 2). Далі ми оцінили, чи були ці відповіді модульованими раніше здійсненими витратами. Приклад репрезентативного нейрона та середніх популяцій нейронів, що проявляють більшу активацію до RHC+ кий, ніж RLC+ кий показані на рисунку 4а та b відповідно. (двосторонній тест Уїлкоксона з підписами; P = 7.4 × 10-5, n = 70). Розподіл auROCs був> 0.5, що вказує на те, що реакція на RHC+ кия була більшою, ніж у RLC+ кия (рис. 4c; двосхилий тест Вілкоксона за підписом; P = 1.4 × 10-4, n = 70). Ці результати вказують на те, що реакція на кий, що передбачає винагороду, у стані HC значно більша, ніж у стані LC. Отже, наші висновки свідчать про те, що позитивний сигнал RPE, представлений нейронами дофаміну, збільшується на раніше понесені витрати.

Відповіді нейронів на дофамін на нагороди. a Приклад реакції нейрона на сигнали R +. Функції щільності шипа обчислювали з активності нейрону дофаміну, записаного у мавпи П. Кольорові лінії та крапки вказують відповідно на щільність спайка та час спайку. Жовтий та рожевий кольори вказують на активність у випробуваннях, що мають дорожнечу та низьку вартість відповідно. Вертикальна лінія вказує на термін подання R + кий. Область сірого кольору позначає період для обчислення швидкості стрільби як відповідь на нагороди. b Середня за популяцією активність нейронів дофаміну, зареєстрована від мавпи P до сигналів R +. Суцільні лінії та пунктирні лінії представляють середнє значення та SEM відповідно. c Розподіл auROC для кількісного визначення впливу оплаченої вартості на реакцію нейрона на сигнали R +. Заповнені квадрати та відкриті кола вказують дані відповідно мавп Р і S. Наголовок стрілки вказує медіану auROC (0.53). d Репрезентативна відповідь на знаки R. Зелений та блакитний кольори вказують відповідно на випробування з високими витратами та з низькими витратами. Вертикальна лінія позначає час подання R-cue. e Середня популяційна активність дофамінових нейронів, зафіксованих від мавпи Р до R-сигналів. f Розподіл auROC для кількісного визначення впливу оплачуваних витрат на реакцію нейронів на R-киї. Наголовник стрілки вказує медіану auROC (0.50)

Нейрони дофаміну також демонстрували фазове пригнічення R-сигналів (рис. 4d, e). Однак відповіді нейронів дофаміну на R-сигнали не показали суттєвої різниці як функція понесеної вартості (двосхилий тест Вілкоксона з підписами; P = 0.25, n = 70), а аналіз ROC не виявив жодних доказів упередженості розподілу відповіді (рис. 4f; Вилкоксон підписаний тест, P = 0.35; n = 70). Таким чином, оплачена вартість не відображалася в сигналі від'ємного RPE, викликаному сигналами непередбачуваного винагороди. Це може бути спричинено ефектом підлоги: спонтанна активність нейрону дофаміну низька (близько 5 Гц); і, отже, може не бути достатнього динамічного діапазону для адекватного кодування будь-якої такої різниці у витратах, витрачених на негативну відповідь RPE (рис. 4d, e).

Ми також вивчали вплив оплаченої вартості на підбір винагород для дофамінових нейронів значення та виразності, але обидва типи дофамінових нейронів показали подібну схему відповідей (Додатковий рис. 6a – h). Таким чином, оплачена вартість виявляє аналогічний вплив на відповідь на підказки як за значеннями, так і за дофаміновими нейронами типу slience.

Фактична тривалість фіксації мавп не була постійною, а змінювалася на основі спроб (рис. 1b). Таким чином, можливо, що відповіді на дофамін на виплату нагород модулюються фактичними тривалостями фіксації на основі пробних результатів. Однак ми не змогли знайти значної кореляції між ними за кожною умовою витрат та винагороди (Додатковий рис. 7a – d). Крім того, телевізійні виплати до київського винагороди також були модульовані витратами та умовами винагороди (рис. 1f). Одна з можливостей полягає в тому, що відповіді нейронів дофаміну можуть бути пояснені ІТ-сигналами на підбір винагороди на основі пробних результатів. Однак ми не змогли знайти значної кореляції між RT та нормалізованими реакціями на дофамін на нагороди (Додатковий рис. 7e – h). Отримані результати свідчать про те, що відповіді на дофамін не залежать як від RT, так і від тривалості фіксації в кожному випробуванні, проте вони модулюються кількістю необхідної вартості та очікуваної винагороди, що визначаються для кожного виду випробувань.

Крім того, можливо, що примусові аборти в стані ЖК породжували як мавпи, так і посилену активацію дофамінових нейронів до нагородного сигналу в стані HC. Якщо так, кількість вимушених абортів повинна бути пов'язана як з перевагою, так і зі ступенем посиленої активації. Однак кількість вимушених абортів не впливала ні на переваги мавп, ні на активацію дофамінових нейронів до нагородних прийомів (додаткова рис. 8). Тому швидше RT та вища відповідь DA на RHC+ кий, ніж RLC+ кия не пов’язана із вставленими примусовими абортами в умовах ЖК.

Поточна вартість збільшує відповіді на дофамін на винагороду

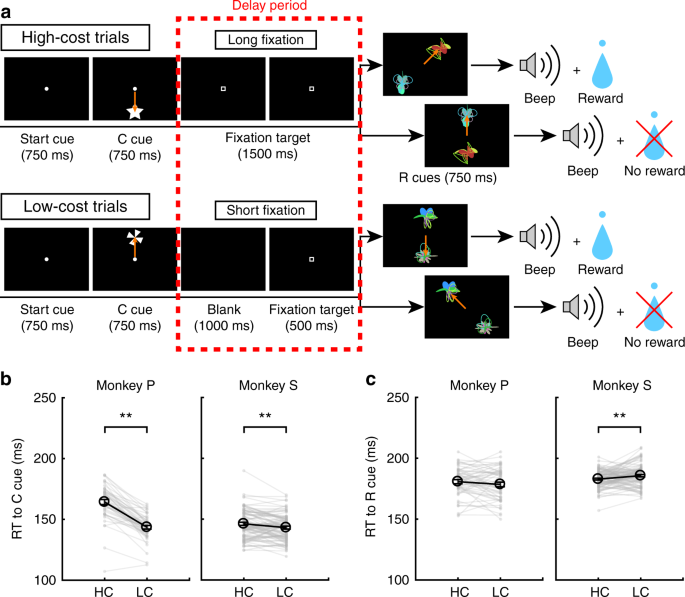

Відповідь нейронів дофаміну на сигнали R + має випливати з відповіді на саму винагороду, оскільки дофамінові нейрони змінюють свою реакцію на сигнали, що прогнозують нагороду, щодо асоціації стимулу-винагороди8,30. Таким чином, ми очікували, що нейрони дофаміну виявлять підвищення відповіді на оплату витрат на доставку винагороди. Для вимірювання активності дофамінових нейронів до доставки винагороди мавпи виконували невизначене завдання FLC за допомогою двох нових нагород (рис. 5a). Оскільки винагорода була вручена лише половині вручень нагород, подання нагород не надійно і по-різному прогнозувало вручення винагороди. Це було зроблено для досягнення максимальної чутливості дофамінових нейронів до отримання (непередбачуваної) винагороди, щоб збільшити нашу чутливість до виявлення модуляції в чутливості нейронів як функції витраченої вартості.

Невизначене завдання FLC. a Невизначене завдання FLC. У цьому завданні використовувались невизначені нагороди, за які нагороджувались 50% часу, незалежно від того, який рейтинг був представлений. b РТ до виплат витрат у випробуваннях високої та низької вартості. Тільки мавпа Р показала швидший RT до киї, ніж кия HC (**P <0.01; двохвостий парний t тест; t4 = 9.0, P = 8.5 × 10-4, n = 5 для мавпи P; t18 = 1.4, P = 0.19, n = 19 для мавпи S). Чорні кола та смужки помилок позначають середнє значення та SEM. c Технічні виклики до знаків винагороди у випробуваннях високої та низької вартості. У РТ не було різниці в рейтингу винагороди між умовами високої та низької вартості (парний двосторонній пар t тест; t4 = 0.97, P = 0.39, n = 5 для мавпи P; t18 = 0.99, P = 0.39, n = 19 для мавпи S)

Коли РТ порівнювали між київними витратами, мавпа Р показала більш швидкий РТ за києм ЖК, ніж кия НС (рис. 5b). Не було різниці в показниках РТ у нагородах між станом HC та LC у жодної мавпи (рис. 5c).

У невизначеному завданні FLC дойромінові нейрони демонстрували скромну активацію LC-киї, але не відповідали на підбір винагороди, оскільки вони не були винагороджуючими прогнозуванням (рис. 6a). У популяції викликані реакції були меншими за НС, ніж РК-кия (рис. 6b; двосхилий тест Вілкоксона за підписом; P = 2.7 × 10-3, n = 19), а аналізи ROC показали менші реакції на сигнал HC (рис. 6c; двосхилий тест Вілкоксона за підписом; P = 5.5 × 10-3, n = 19). Нейрональна реакція на доставку винагороди в стані HC була більшою, ніж LC (рис. 6d; двосхилий тест Вілкоксона за підписом; P = 0.036, n = 19). Розподіл auROCs був> 0.5, що вказує на більшу реакцію на винагороду в HC порівняно з дослідженнями LC (рис. 6e; двосхилий тест Вілкоксона за підписом; P = 0.049, n = 19). Ці результати вказують на те, що реакція на доставку винагороди посилюється у дослідженні HC та що оплачувана вартість збільшує сигнал позитивного RPE при доставці винагороди.

Відповідь нейронів дофаміну на доставку винагороди. a Репрезентативна активність дофамінових нейронів у невизначеній задачі FLC. Кожен колір відображає умови (жовтий: HC +, зелений: HC−, рожевий: LC +, блакитний: LC−). Часи настання сакади позначаються сірими хрестами. Відповіді цього нейрону дофаміну на непередбачувану нагороду та повітряний пухир також зображені на правій панелі (червоний: непередбачувана винагорода, синій: непередбачуваний повітряний пуф). b Середня за популяцією активність нейронів дофаміну, зареєстрована від мавпи S, до ознак стану. Зелений та фіолетовий кольори вказують на активність відповідно у дорогих та недорогих випробуваннях. Суцільні лінії та пунктирні лінії представляють середнє значення та SEM відповідно. Сіра область позначає часове вікно для обчислення швидкості стрільби як відповідь на сигнали стану. c Розподіл auROC для кількісного визначення впливу передбачуваної вартості на реакцію нейрона на відповідність витрат. Заповнені квадрати вказують на дані мавпи Р (n = 3), а відкриті кола вказують дані від мавпи S (n = 16). Стрілка показує медіану auROC (0.44). d Середня популяційна активність нейронів дофаміну, зафіксованих від мавпи S до доставки винагороди. Жовтий та рожевий кольори вказують на активність у випробуваннях, що мають дорожнечу та низьку вартість, відповідно. Область сірого кольору позначає часове вікно для обчислення швидкості вистрілу як відповідь на доставку винагороди. e Розподіл auROC для кількісного визначення впливу оплаченої вартості на реакцію нейрона на доставку винагороди. Наголовник стрілки вказує медіану auROC (0.55)

Крім того, ми порівняли відповіді на дофамін після відсутності винагороди. AuROC не показали упередженого розподілу, що свідчить про те, що оплачена вартість не впливала на негативні ІРВ на момент результату (Додатковий рис. 9a). Нейрони дофаміну не виявили різниці між реакціями на RHC і RLC киї (додаткові рис. 9b).

Потокова вартість підвищує швидкість навчання

Враховуючи, що RPE для винагороди збільшуються на оплачувану вартість, під гіпотезою, що RPE беруть безпосередню участь у опосередкуванні стимулюючого винагороди, ми очікували, що посилені RPE відображатимуться у поведінці навчання завдяки підвищеній швидкості навчання24. Щоб перевірити вплив оплаченої вартості на навчання, мавпи виконали завдання з дослідження ФЗС (рис. 7a; див. Методи). У цьому завданні одночасно були представлені два київські нагороди (R + і R−), і мавпи повинні були вибрати один. Ми зрівняли коефіцієнт успішності та ймовірність винагороди між випробувальними видами (парний пар) t тест; t48 = 0.15, P = 0.89, n = 49 для мавпи P; t85 = 1.2, P = 0.25, n = 86 для мавпи S). Коли РТ порівнювали за цінами на витрати, обидві мавпи демонстрували швидше РТ до кий, ніж кий, ніж кий (рис. 7b; двохвостий парний t тест; t48 = 12.9, P ≈ 0, n = 49 для мавпи P; t85 = 3.4, P = 9.4 × 10-4, n = 86 для мавпи S). Порівнюючи RT з підказками винагороди, мавпа S демонструвала швидше RT у HC, ніж стан LC (рис. 7c; двохвостий парний t тест; t48 = 1.3, P = 0.19, n = 49 для мавпи P; t85 = 2.8, P = 6.8 × 10-3, n = 86 для мавпи S). При порівнянні РТ протягом першої та другої половини навчального сеансу окремо, РТ до сигналу LC були швидшими, ніж до сигналу HC під час першого (додатковий рис. 10a) та останньої половини сеансу (Додатковий рис. 10c). Навпаки, РТ мавпи S до київської нагороди у стані HC були швидшими, ніж у стані ЖК, лише протягом останньої половини сеансу (Додатковий рис. 10d), але не першої половини (Додатковий рис. 10b).

Завдання розвідки FLC. a Завдання розвідки FLC. У цьому завданні мавпи повинні були вибирати між R + та R-сигналами, які були генеровані випадковим чином на кожному навчальному занятті. Якщо вони обрали R + кий, вони могли б отримати винагороду, а якщо обрали R-cue, вони не отримали б нагороди. b РТ до виплат витрат у випробуваннях високої та низької вартості. Мавпи демонстрували більш швидкі телевізійні сигнали до низької вартості (**)P < 0.01; двохвостий парний t тест). Чорні кола та смужки помилок означають середнє значення та SEM. c Технічні виклики до знаків винагороди у випробуваннях високої та низької вартості. Мавпа S показала швидші телевізійні передачі на нагороди у дорогоцінних умовах

У завданні з дослідження FLC винагороди були створені випадковим чином на кожному навчальному занятті. Тому мавпи повинні були навчитися взаємозв'язку між нагородами та нагородами в кожному сеансі. По мірі того, як випробування проходили протягом сеансу, мавпи обирали R + сигнали частіше за кожної умови витрат (рис. 8a). Для кількісної оцінки швидкості навчання ми підходимо до даних накопичувальної експоненціальної функції, включаючи два вільних параметри, a та b, що вказує на крутизну кривої та плато відповідно (Додатковий рис. 11a, б). Коефіцієнт журналу між параметрами крутизни (log aHC/aLC) був значно більшим за нуль, що вказує на більший показник крутості у HC, ніж у випробуваннях з LC (рис. 8b; двохвостий t тест; t48 = 2.1, P = 0.042, середнє = 0.58, n = 49 для мавпи P; t85 = 2.5, P = 0.013, середнє = 0.19, n = 86 для мавпи S). Коефіцієнт журналу між параметрами плато (log bHC/bLC), не відрізнявся від нуля, що вказує на відсутність різниці між умовами витрат (рис. 8c; двохвостий t тест; t48 = 0.76, P = 0.45, середнє = −0.0024, n = 49 для мавпи P; t85 = 0.56, P = 0.58, середнє = 0.010, n = 86 для мавпи S). Ці результати вказують на те, що швидкість навчання швидша у випробуваннях HC. Далі ми змоделювали криві навчання, використовуючи модель підкріплення навчання (RL) (див. Методи). Ця модель включає параметри швидкості навчання (αHC та αLC) та коефіцієнт розвідки (βHC та βLC) для обох умов витрат (Додатковий рис. 11c, буд). Підходячи до поведінки, ми виявили, що відношення журналу між параметрами швидкості навчання (log αHC/αLC) був більшим за нуль, що вказує на значно більший параметр швидкості навчання у ХК, ніж у випробуваннях з ЖК (рис. 8d; двохвостий t тест; t48 = 2.3, P = 0.026, середнє = 0.50, n = 49 для мавпи P; t85 = 2.2, P = 0.034, середнє = 0.25, n = 86 для мавпи S), а параметр β не виявило різниці (рис. 8e; двохвостий t тест; t48 = 0.77, P = 0.44, середнє = 0.0097, n = 49 для мавпи P; t85 = 0.64, P = 0.52, середнє = 0.038, n = 86 для мавпи S). Тут ми оцінили параметри швидкості навчання для кожної умови витрат (αHC та αLC) окремо пояснити більш високі швидкості навчання у стані HC. Однак якщо коефіцієнти навчання однакові між умовами витрат, відношення між орієнтовними параметрами курсу навчання (αHC/αLC) може розглядатися як значення посилення для RPE в стані HC. Отже, ці результати говорять про те, що посилення RPE може пояснити більш високі швидкості навчання у стані HC.

Тест на швидкість навчання. a Середній процес навчання мавп P і S. Частка R + вибору будується як функція випробування. Зелені та фіолетові точки вказують на дані відповідно до дорожнього та недорогого випробування. Пунктирні лінії представляють плавний процес навчання. Кумулятивні експоненціальні функції прилаштовувались до точок даних і представляли собою суцільні лінії. b Коефіцієнт журналу між параметрами підгонки a в умовах високої та низької вартості, коли дані відповідали накопичувальній експоненціальній функції (*P <0.05; двобічний тест Уїлкоксона зі знаком). Чорні кола та смужки помилок позначають середнє значення та SEM. c Коефіцієнт журналу між параметрами підгонки b в умовах високої та низької вартості, коли дані відповідали накопичувальній експоненціальній функції. d Коефіцієнт журналу між параметром швидкості навчання α в умовах високої та низької вартості, коли дані відповідали моделі підкріплення. e Коефіцієнт журналу між параметром підгонки β в умовах високої та низької вартості, коли дані відповідали моделі підкріплення

Ми також намагалися пояснити процес навчання альтернативними моделями RL, які враховували можливість того, що мавпи знають антикореляцію між стимулами та винагородою за кожне випробування. У цих моделях значення незбереженого параметра оновлюється поряд із обраною (Додатковий рис. 12). Навіть при застосуванні подібних альтернативних моделей до даних параметр швидкості навчання був значно більшим у ХК порівняно з умовою ЖК (Додатковий рис. 12b, f) параметр β не виявив різниці (Додатковий рис. 12d, h). Таким чином, наше висновок про посилення сигналу RPE у стані HC є стійким до форми моделі RL, що підходить до даних.

Обговорення

Ми досліджували вплив оплачуваних витрат на величину київ, що прогнозують нагороду, та на фазові реакції нейронів дофаміну середнього мозку. Мавпи демонстрували підвищену оцінку прийомів прогнозування нагород після виконання дії, що спричинило більшу вартість. Нейрони дофаміну виявили посилені реакції як на передбачувану винагороду, так і на винагороду після того, як були понесені більші витрати. Крім того, мавпи демонстрували більш високу швидкість навчання, коли для отримання винагороди потрібно було підвищити вартість.

Кілька досліджень показали, що оплачена вартість збільшує переваги щодо випереджувального кия1,2,3. У цьому дослідженні мавпи показали більш швидкі телевізійні показники до сигналів, що прогнозують нагороду в стані HC, порівняно з тими, що перебувають у стані ЖК, що відповідає можливості того, що значення виграшної виграші збільшується на оплачувані витрати27. Альтернативна можливість полягає в тому, що більш тривалий час фіксації пов'язаний з посиленою увагою до мішені саккади в стані HC, отже, зменшення RT при тривалій фіксації в дослідженні з HC. Однак ми не виявили різниці між RT-тами та сигналами R у випробуваннях HC та LC у невизначеній задачі FLC. Крім того, у першій половині сеансу розвідки FLC. РТ-сигнали R не суттєво відрізнялися між випробуваннями HC та LC. Таким чином, ці висновки вказують на те, що більш тривала фіксація не є ймовірним поясненням для коротших телевізійних передач, що спостерігаються за сигналами прогнозування винагороди. На додаток до ефекту оплаченої вартості на телевізійні телевізійні виграші, ціна також вплинула на телевізійні телевізори на непередбачувані репліки, незважаючи на те, що винагороду після вручень не було доставлено. Попереднє дослідження повідомляло про подібне явище, оскільки суб'єкти мавпи демонстрували коротші показники РТ у неперевірених випробуваннях, коли в альтернативних випробуваннях у кожному блоці використовувались більш переважні нагороди.30. Одне з можливих тлумачень ефекту в цьому дослідженні полягає в тому, що загальна вища мотивація відповідати в блоці з більш переважним винагородою, що впливає на RT, також на виграш без виграшу в блоці. Аналогічно, у цьому дослідженні очікування на більш цінну винагороду у випробуваннях на ХЗ могло б змінити РТ до безрезультатного виграшу у випробуваннях на ХК у нашому завданні. Крім того, ефект оплачуваної вартості від РТ на сигнали про винагороду був меншим, ніж на репліки, що не передбачають винагороди. Це, мабуть, артефакт того, що мавпи швидше зробили саккаду до РLC+ кия, по-перше, зменшено область застосування для виявлення скорочення RT на RHC+ кия. Таким чином, різниця RT-сигналів між сигналами R + буде наслідком.

Мавпи також проводили випробування вибору між RHC і RLC сигнали у завданні FLC. Однак поки мавпа S виявила перевагу перед RHC+ кия на РLC+ кий, мавпа Р не виявляла такої переваги. Ця невідповідність може бути пояснена контекстуальною різницею між випробуваннями FLC та виборами. У випробуваннях вибору було представлено два сигнали прогнозування нагород замість однієї киї, що передбачає нагороду. Крім того, мавпи не отримали винагороди після свого вибору, навіть якщо вони обрали кию, яка передбачає нагороду, таким чином тест на вибір був зроблений на вимирання. Процедура вимирання була застосована для того, щоб забезпечити вибір мавпи, залежно від того, що було засвоєно на випробуваннях зусиль, на відміну від того, щоб бути змішаним з новим навчанням на випробуваннях з вибором. Однак ця процедура може мати побічний ефект від того, що мавпа може швидко навчитися розпізнавати процедуру вимирання в контексті вибору і що немає підстав обирати більш переважні подразники. Тим не менш, одна з мавп насправді виявила перевагу за нагородою в умовах охорони здоров'я.

На момент подання сигналу, який передбачив подальшу вимогу сплатити вартість, активність дофамінових нейронів знижувалась, відповідно до попередніх досліджень22,23. У нашому дослідженні ми не спостерігали загального зниження нейрону дофаміну, що реагує як на реакції HC, так і на ЛК щодо базової лінії. Це говорить про те, що сигнал негативного RPE не виникає в цей момент часу, незважаючи на наступні витрати. Відсутність негативного RPE, мабуть, відображає інтеграцію прогнозу майбутньої винагороди, що очікується пізніше в процесі випробування. Нейрони дофаміну виявляли значну активацію в дослідженні ЛК, і активність була вищою порівняно з випробуванням на ХК. Це дозволяє припустити, що інформація про витрати включена в сигнал RPE, що переноситься нейронами дофаміну. Таким чином, дофамінові нейрони кодують інформацію як про винагороду, так і про витрати, а відповідь RPE відображає суму вартості та винагороди.

Ми продемонстрували, що сигнал RPE, представлений нейронами дофаміну, посилюється за рахунок оплаченої вартості в момент вручення винагороди (в завданні FLC на випадок) та доставці винагороди (у невизначеному завданні FLC). Об'єктивна сума винагороди, отриманої у випробуваннях з HC та LC, була рівною; отже, модифікація сигналів RPE повинна бути викликана безсенсорним процесом. Ця можливість підтримується декількома дослідженнями, що вказують на контекстуальний вплив на дофамінові RPE-сигнали, що відповідають обробці суб'єктивного значення та / або корисності в дофамінових нейронах11,19,20,21,31,32,33,34. Якщо сигнал RPE більший, це повинно спричинити більш швидке оновлення значення сигналу, що, отже, вплине на швидкість навчання стимуляцій-нагородних асоціацій. Попередні дослідження показали модифікацію швидкості навчання за допомогою безсенсорних факторів24,35. У відповідності з цим мавпи демонстрували більш високі швидкості навчання в HC відносно стану ЖК. Ми виявили, що підвищену швидкість навчання за рахунок оплаченої вартості можна пояснити моделлю RL з посиленою RPE. У наших експериментах було важко відокремити ефекти посиленого RPE та підвищити рівень навчання; однак ми знайшли посилений дофамінергічний сигнал RPE у стані HC. Крім того, попереднє дослідження fMRI показало, що параметр швидкості навчання представлений в корі переднього цингулату і що активність VTA не пов'язана з параметром швидкості навчання у мінливих середовищах36. Отже, ми стверджуємо, що сигнал RPE, кодований нейронами дофаміну, посилюється за рахунок оплаченої вартості і що підвищений сигнал RPE збільшує швидкість навчання.

Коли сигнал RPE формувався під час вручення нагороди та вручення нагороди, мавпи вже сплатили вартість. Отже, одним із можливих механізмів посиленого сигналу RPE є те, що винагорода, отримана після НС, може бути більш корисною. Підвищене сподівання на більш цінну винагороду після ЗК може посилити мотивацію закінчити випробування, тим самим скоротивши RT до виплат нагород у випробуваннях на ХК.

Інша можлива інтерпретація наших результатів полягає в тому, що полегшення після припинення дорогої дії може послужити винагородою для мавп. Дослідження функціональної магнітно-резонансної томографії (fMRI) показали, що полегшення болю може бути винагородою для учасників людини37,38; отже, вартість може зіграти аналогічну роль, як протилежний стимул до болю. Якщо звільнення від витрат буде корисним, і якщо це відображатиметься на дофамінергічній активності, ми очікуємо, що нейрони дофаміну відгукнуться в кінці тривалої фіксації, яка є терміном вручення винагороди. Однак ми не спостерігали різниці в дофамінергічній активності при термінах подання нагородних київ, а також різниці RT у відповідність між випробуваннями HC та LC у невизначеній задачі HLC. Тому ми вважаємо, що звільнення від витрат не дає належного пояснення ефекту, який ми спостерігали у нейронах дофаміну.

Крім того, нейрони дофаміну показали якісно різні відповіді на аверсивний подразник порівняно з києм прогнозування витрат. Одним з можливих пояснень цього є те, що витрати на зусилля були менш помітними, ніж повітряний витяг або винагорода, оскільки зусилля зусиль тимчасово збільшувались на кілька секунд, оскільки мавпи виконували фіксацію, а не пунктат. Таким чином, дофамінові нейрони, можливо, не були активовані для менш помітних витрат. Інша можливість полягає в тому, що дофамінові нейрони нейрохімічного типу реагують на події, після яких були викликані деякі рухи. Коли нагороду або повітряний пухир доставляли мавпам, вони роблять деякі рухи, такі як облизування або моргання очей. Однак у завданні сакади FLC мавпи повинні були тримати погляд на цілі фіксації без будь-якого руху як вартості. Насправді, нещодавнє дослідження показало, що вивільнення дофаміну в ядрі приєднується за сигналом, що передбачає нагороду, послаблюється, якщо рух не буде ініційовано правильно39. Оскільки вартість наших експериментів не передбачала ініціювання руху, це може призвести до непослідовної відповіді на дофамінові нейрони нейролітичного типу. У будь-якому випадку можна зробити висновок, що інформація про витрати обробляється інакше, ніж відразна інформація.

На закінчення ми пропонуємо, що оплачена вартість збільшує значення київ, що прогнозують нагороду, і це, в свою чергу, збільшує сигнал RPE, кодований в нейронах середнього мозку дофаміну. Цей ефект призвів до поведінкового прогнозу, що швидкість навчання тварин буде підвищена для прогнозування нагород за результатами досвіду лікарів. Це дійсно те, що ми спостерігали. Таким чином, наші спостереження за активністю дофамінових нейронів привели нас до гіпотези про існування поведінкового ефекту, а також про можливий обчислювальний механізм, що лежить в основі цього ефекту, що ми згодом підтвердили. Таким чином, наші результати є прикладом того, як може відбуватися тріангуляція між вимірюваннями нейронних даних, теорією обчислень та поведінкою: розвиток більш глибокого розуміння нейронної обробки в мозку може дати уявлення про поведінку та її базову обчислювальну основу.

Методи

Звірята

Ми використовували двох японських мавп-чоловіків (Fuscata Macaca; маса тіла, 6.5 кг = Мавпа Р; маса тіла, 9.0 кг = Мавпа S). Ми імплантували шевелюру на верхній частині черепа мавпи, щоб згодом її можна було пристебнути до стільця. Також була імплантована камера запису, яка дозволила встановити електродний мікроманіпулятор. Камера запису була нахилена 45 ° бічно в корональній площині і розміщена на стереотаксичних координатах: 15 мм перед зовнішнім каналом. Після періоду відновлення мавп навчили виконувати завдання саккади. Закінчивши навчання, ми просвердлювали отвір через череп всередині камери запису для введення електрода. Всі протоколи догляду за тваринами були затверджені Комітетом з експериментів над тваринами Університету Тамагава та відповідні до Посібника з охорони здоров'я та використання лабораторних тварин.

Поведінкове завдання

Мавп навчились виконувати завдання сакади HLC (рис. 1a), Невизначене завдання FLC (рис. 5a), а також завдання розвідки HLC (рис. 7a). Всі завдання виконували в темній кімнаті. Мавп посадили в крісло перед 22-дюймовим. РК-монітор (S2232W, Eizo) з імплантованими головними стійками, закріпленими на стільці. Відстань між їх очима та дисплеєм становила 70 см. Коли в центрі дисплея була представлена стартова кий (білий круг, діаметр 0.3 °), мавпа повинна була тримати погляд на кий. Стартовий кий зник через 750 мс, а потім був представлений кий-витрата (зірка та вітряк для випробувань HC та LC відповідно). Мавпи повинні були саккадуватися до вартості під час 750 мс презентації репліки. Якщо вони не саккадували, процес був перерваний і той самий процес розпочався знову. Під час випробувань HC, ціль фіксації (0.3 ° × 0.3 ° білого квадрата) була представлена відразу після зникнення витрати на 2000 мс (саккада HLC та невизначені завдання HLC) або 1500 мс (завдання дослідження HLC) і мавпи були потрібні щоб саккадувати до нього і не зводити з цього погляду. Якщо мавпи перенесли погляд за межі фіксаційного вікна 4 ° × 4 °, завдання було перервано. Вікно фіксації активувалося через 400 мс після презентації точки фіксації, оскільки мавпам потрібен був час, щоб підготуватися до саккади та налаштувати їх фіксацію. Таким чином, мавпи повинні були фіксуватися принаймні 1600 мс (саккада HLC та невизначені завдання HLC) або 1100 мс (завдання дослідження HLC) у випробуваннях HC. У випробуваннях LC пустий екран відображався протягом 1500 мс (сакрада HLC та невизначені завдання HLC) або 1000 мс (завдання дослідження HLC), а потім ціль фіксації з'явилася протягом 500 мс. Оскільки вікно фіксації активувалося через 400 мс після презентації точки фіксації, мавпи повинні були фіксуватися на цілі принаймні 100 мс у випробуваннях LC. Мавпи виявляли більше помилок у дослідженні HC; тому примусовий аборт був випадковим чином вставлений за 100 мс до презентації репліки (400 мс після презентації цільової фіксації, що є часом настання вікна фіксації) в дослідженні LC для вирівнювання рівня успіху. Після фіксації на цілі було представлено один або два сигнали винагороди, і мавпи повинні були саккадуватися до репліки. Якщо вони успішно зробили саккаду до сигналу нагороди, звуковий сигнал подавався через 750 мс після презентації сигналу нагороди. Коли мавпи зробили саккаду до сигналу R +, одночасно із звуковим сигналом було подано 0.3 мл води. Жодної винагороди не було вручено, коли вони зробили саккаду до R-кий.

У завданні сакади FLC чотири кольорових кола використовувались як сигнали нагород (RHC+: жовтий; RHC-: зелений; RLC+: рожевий; RLC-: синій; Рис. 1a). Один експериментальний сеанс складався з 80 випробувань саккади, 20 непередбачуваних випробувань винагороди, 20 непередбачуваних випробувань повітряного слою та 5 випробувань вибору. Випробування саккади включали 40 випробувань HC та 40 випробувань LC, обидва з яких включали 20 випробувань винагороди та 20 випробувань без винагороди. У непередбачуваних випробуваннях з нагородженням або затяжкою повітря 0.3 мл води за винагороду або 0.2 МПа затяжки повітря (150 мс для мавпи P; 200 мс для мавпи S) доставляли на обличчя мавп, не отримуючи сигналу. Випробування на вибір включали випробування, в якому мавпи робили вибір між сигналами R + (RHC+ проти RLC+) у випробуванні на HC, між R-сигналами (RHC- проти RLC-) у дослідженні HC, між R + (RHC+ проти RLC+) сигнали в пробі LC, між R− (RHC- проти RLC-) репліки в пробі з ЖК та між сигналами витрат (Додатковий рис. 1). У випробуваннях, які вибирали між нагородами, структура завдань була ідентичною завданню сакади перед врученням нагородного кию. Далі, замість того, щоб вручити винагороду, у виборчих випробуваннях було представлено два набори нагороди, і після вручення нагород не було вручено винагороду, навіть якщо мавпи зробили вибір між R + киями.

Щоб перевірити відповідь нейронів дофаміну на винагороду доставки, мавпи виконали невизначене завдання на ВЖХ (рис. 5a). Це завдання було подібне до завдань сакади HLC за винятком варіантів нагород. У цьому завданні ми використовували два набори винагороди (замість чотирьох наборів нагород, які використовувались у завданні FLC для вивіски), один для випробування HC та інший для випробування LC. Нагорода була доставлена в половині випробувань після вручення винагороди. Один експериментальний сеанс складався з випробувань саккади 80, непередбачуваних винагородних випробувань 20 та непередбачуваних випробувань на повітряному повітрі 20. Випробування на саккаде включали випробування 40 HC та випробування 40 LC, обидва з яких включали виграшні випробування 20 та винагороди 20 без винагороди. У ході непередбачуваних випробувань винагорода чи повітряне стягнення були доставлені без жодної скарги.

У завданні розвідки HLC два київські нагороди (RHC+, РHC- або RLC+, РLC-) були представлені одночасно, і мавпи повинні були пройти до однієї з нагород нагород (рис. 7a). Якщо вони обрали R + кий, їм забезпечили водну винагороду. Чотири нагороди (RHC +, RHC-, RLC +, RLC-) створювались для кожного розвідувального сеансу, і мавпи повинні були навчитися зв'язків між сигналами та винагороджувати випробування за випробуванням. Один експериментальний сеанс складався з випробувань 100 HC та випробувань 100 LC. Ми виявили, що для завдання розвідки, якщо встановити тривалість фіксації на рівні 2000 мс у стані HC, щоб вона відповідала тривалості стану HC в інших завданнях, мавпи виконували завдання з дуже низьким рівнем успішності, можливо, через складність завдання та / або, як наслідок, низький показник винагороди. Таким чином, для зменшення труднощів завдання та підвищення рівня успішності ми використовували тривалість фіксації 1500 мс як витрати на завдання з дослідження HLC.

Завдання контролювалися за допомогою наявного у продажу програмного пакету (TEMPO, Reflective Computing, St. Louis, MO, США). Для подання візуального стимулу була використана спеціально створена програма, що використовує інтерфейс програмування додатків (OpenGL). Автори створили візуальні стимули для вартості та винагороди.

Запис та отримання даних

Місце знаходження чорної речовини було оцінено за допомогою МР-зображень. Вольфрамовий електрод з покриттям епоксидного покриття (діаметр хвостовика, 0.25 мм, 0.5 – 1.5 MΩ, виміряний в 1000 Гц, FHC) вставляли в речовину нігра за допомогою мікроманіпулятора (MO-972, Narishige, Токіо, Японія), встановленого на камеру запису з нержавіюча направляюча трубка. Сигнали напруги підсилювали (× 10,000) і фільтрували (0.5 – 2 кГц). Потенціали дії від одного нейрона були виділені алгоритмом відповідності шаблонів (OmniPlex, Plexon, Dallas, TX, США). Рух очей контролювався системою інфрачервоної камери зі швидкістю вибірки 500 Гц (iView X Hi-Speed Primate, SMI, Teltow, Німеччина). Час потенціалів дії та поведінкових подій реєструвались з часовою роздільною здатністю 1 кГц.

Аналіз даних

Для аналізу поведінки мавп РТ визначали як часовий інтервал між початком дії стимулу та часом, коли мавпи ініціювали саккаду. Ініціювання саккади визначали шляхом обчислення часу, коли положення задирки перевищувало стандартні відхилення 5 від середнього положення погляду перед подачею киї.

У завданні розвідки HLC вибір поведінки мавп був кількісно визначений, встановивши кумулятивну експоненціальну функцію. Функція (P) описує пропорцію правильного вибору наступним чином:

де t означає суд, a та b вказують нахил і плато кривої відповідно. Ця функція незалежно підходила до даних для двох умов витрат. Шукали параметри функції, щоб збільшити ймовірність спостереження за даними за один сеанс та усередненими даними. Для оцінки довірчих інтервалів під час встановлення усереднених даних застосовувався метод завантаження. Для кількісної оцінки даних про поведінку також використовувалася стандартна модель RL. Значення стимулу Vj(t) для обраного вибору j (j = 1 для стану HC; j = 2 для стану LC) були оновлені наступним чином:

де αj вказують показники навчання, які були обмежені значеннями між 0 та 1. R(t) вказує суму винагороди (1: винагороджено, 0: винагорода немає) під час випробування t.

Ймовірність Pj(t) вибору стимулу j з двох подразників під час випробування t задається правилом softmax

де βj вказує на масштаб розвідки.

Ми реєстрували нейрональну активність під час саккади HLC та невизначеного завдання HLC, але не завдання дослідження HLC. Завдання дослідження HLC було реалізоване як суто поведінкове дослідження. Нейрони дофаміну ідентифікували, якщо вони виявляли кожну з наступних властивостей: низьку швидкість тонічного випалу (<6 Гц), тривалу форму сигналу (> 300 мкс) та фазову реакцію на непередбачувану винагороду (додатковий рис. 2a). Ми проаналізували випробування, в яких мавпи могли завершити випробування без будь-яких помилок (фіксація гальмування, відсутність саккади або штучне переривання). Середній коефіцієнт випалу нейрона розраховувався за допомогою бункерів 1 мс та згладжувався ядром Гаусса (σ = 30 мс, ширина = 4σ) виробляти функції щільності шипа. Відповіді нейронів дофаміну на кожну подію завдання розраховувались як нормалізована швидкість випалу відносно спонтанної активності (середня швидкість випалу протягом 500 мс перед початком початку дії). Коефіцієнти стрільби розраховувались у часові вікна, визначені для кожної події та предмета завдання. Ці часові вікна визначались із усередненої для населення діяльності. Ми визначили початкову та кінцеву точки часових вікон, визначених на основі часу зростання та падіння середньозваженої відповіді на популяцію, використовуючи попередні дослідження дофаміну мавпи в якості посилань (Додатковий рис. 3). Часове вікно для стартової киї було визначено як 200 – 400 мс після настання стартової киї для нейронів, записаних від мавп P та S. Час вікна для киї стану було визначено як 150 – 300 мс після настання виклику умови для мавпи P та 200 – 400 мс для мавпи S. Часове вікно для виграшного кия було визначено як 140 – 350 мс після настання київської нагороди для мавпи P та 220 – 420 мс для мавпи S. Час вікна для доставки винагороди було визначено як 225– 475 мс після початку звукового сигналу для мавпи P та 200 – 450 мс для мавпи S. Часове вікно для непередбачуваної доставки винагороди було визначено як 100 – 300 мс після доставки винагороди для мавпи P та 150 – 300 мс для мавпи S. часове вікно для непередбачуваного повітряного пуху було визначено як 30 – 230 мс після доставки повітряного слою для мавпи P та 50 – 200 мс для мавпи S.

Ми класифікували всі зареєстровані допамінові нейрони на дві різні категорії - мотиваційна цінність та видимість. Якщо реакція нейрона на подразнення повітряним задухом була меншою, ніж спонтанна активність, нейрон класифікували як тип мотиваційного значення (рис. 3d, e). На противагу цьому, якщо реакція нейрона на подразники повітряно-пухирчатого типу була більшою, ніж спонтанна активність, нейрон був класифікований як такий, що належить до виразності (рис. 3g, год).

Для кількісної оцінки диференціальної активності нейронів між умовами завдання було проведено аналіз ROC. Ми розрахували auROC для кожного нейрона. AuROC, менший або більший за 0.5, вказує на меншу або більшу відповідь у дослідженні HC відповідно. Оскільки кількість нейронів у деяких наборах нейрональних даних була невеликою, ми використовували тест Уїлкоксона з підписаним рангом, щоб зменшити ефект викидів для кількісного визначення упередженого розподілу auROC.

Програмне забезпечення MATLAB (MathWorks, Natick, штат Массачусетс, США) було використано для аналізу всіх даних.

Гістологічне дослідження

Після експерименту з записом обидві мавпи були евтаназовані та проведено гістологічний аналіз для перевірки положення запису (Додатковий рис. 2b). Мавп евтаназували введенням смертельної дози пентобарбіталу натрію (70 мг кг-1) і перфузії 4% формальдегіду у фосфатному буфері. Серійні корональні зрізи (товщина, 10 мкм) були вирізані та імунофарбовані антитілом до тирозин гідроксилази (TH) (кожні секції 25; антитіла проти TH, 1: 500; Мерк, Дармштадт, Німеччина) або фарбування Nissl (кожні 25 секції) .

Підсумок звітності

Більш детальна інформація про розробку досліджень доступна в Підсумок звітності про природознавство пов'язана з цією статтею.

Доступність коду

Коди Matlab, використані в аналізі цього дослідження, доступні у відповідного автора за розумним запитом.

посилання

- 1.

Клемент, TS, Фельтус, JR, Кайзер, DH & Zentall, TR “Трудова етика” у голубів: вартість винагороди безпосередньо пов’язана із зусиллями чи часом, необхідним для отримання винагороди. Психон. Бик. Преподобний 7, 100 – 106 (2000).

- 2.

Klein, ED, Bhatt, RS & Zentall, TR Контраст та виправдання зусиль. Психон. Бик. Преподобний 12, 335 – 339 (2005).

- 3.

Zentall, TR & Singer, RA Контраст під час випробувань: голуби віддають перевагу умовленим підсилювачам, які слідують за відносно більшою, а не менш відвертою подією. J. Exp. Анал. Behav. 88, 131 – 149 (2007).

- 4.

Aronson, E. & Mills, J. Вплив тяжкості ініціації на симпатію до групи. Дж. Абнорм. Соц. Психол. 59, 177 – 181 (1959).

- 5.

Фестінгер, Л. Теорія когнітивного дисонансу. (Stanford University Press, Каліфорнія, 1957).

- 6.

Алессандрі, Дж., Дарчевіль, Дж. К., Делевой-Туррелл, Ю. та Зенталл, ТР. Надання переваг винагородам, що випливають із більших зусиль та більшої затримки. Дізнайтеся Behav. 36, 352 – 358 (2008).

- 7.

Шульц, В., Кареллі, Р.М. & Вайтман, Р.М. Фазичні сигнали дофаміну: від суб'єктивної цінності винагороди до формальної економічної корисності. Curr. Думка. Бехав. Наук. 5, 147 – 154 (2015).

- 8.

Шульц, В., Даян, П. та Монтегю, ПР Нейронний субстрат прогнозування та винагороди. наука 275, 1593 – 1599 (1997).

- 9.

Бромберг-Мартін, Е.С., Мацумото, М. та Хікосака, О.Допамін у мотиваційному контролі: нагородження, неприязнь та оповіщення. Нейрон 68, 815 – 834 (2010).

- 10.

Bayer, HM & Glimcher, PW Нейрони дофаміну середнього мозку кодують кількісний сигнал про помилку прогнозування винагороди. Нейрон 47, 129 – 141 (2005).

- 11.

Nakahara, H., Itoh, H., Kawagoe, R., Takikawa, Y. & Hikosaka, O. Допамінові нейрони можуть представляти контекстно-залежну помилку прогнозування. Нейрон 41, 269 – 280 (2004).

- 12.

Tobler, PN, Fiorillo, CD & Schultz, W. Адаптивне кодування винагородного значення нейронами дофаміну. наука 307, 1642 – 1645 (2005).

- 13.

Nomoto, K., Schultz, W., Watanabe, T. & Sakagami, M. Тимчасово розширені реакції дофаміну на сприйнятливі до винагород передбачувальні стимули. J. Neurosci. 30, 10692 – 10702 (2010).

- 14.

Watabe-Uchida, M., Zhu, L., Ogawa, SK, Vamanrao, A. & Uchida, N. Картографування цілого мозку прямих надходжень до нейронів дофаміну середнього мозку. Нейрон 74, 858 – 873 (2012).

- 15.

Tanaka, SC та ін. Прогнозування негайних та майбутніх нагород різним чином набирає кортико-базальні петлі ганглій. Nat. Neurosci. 7, 887 – 893 (2004).

- 16.

Haber, SN, Kim, KS, Mailly, P. & Calzavara, R. Кортичні вхідні речовини, пов'язані з винагородою, визначають велику смугасту область у приматів, яка взаємодіє з асоціативними кортикальними зв'язками, забезпечуючи субстрат для навчання на основі стимулів. J. Neurosci. 26, 8368 – 8376 (2006).

- 17.

Доя, К. Модулятори прийняття рішень. Nat. Neurosci. 11, 410 – 416 (2008).

- 18.

Roesch, MR, Calu, DJ & Schoenbaum, G. Допамінові нейрони кодують кращий варіант у щурів, приймаючи рішення між різними затримками або розмірами винагород. Nat. Neurosci. 10, 1615 – 1624 (2007).

- 19.

Lak, A., Stauffer, WR & Schultz, W. Відповіді на помилки прогнозування дофаміну інтегрують суб'єктивну цінність з різних вимірів винагороди. Proc. Natl Acad. Sci. США 111, 2343 – 2348 (2014).

- 20.

Stauffer, WR, Lak, A. & Schultz, W. Відповіді на помилки прогнозування винагороди за дофамін відображають граничну корисність. Curr. Biol. 24, 2491 – 2500 (2014).

- 21.

Норітаке, А., Ніномія, Т. та Ісода, М. Моніторинг та оцінка соціальних винагород у мозку макак. Nat. Neurosci. 21, 1452 – 1462 (2018).

- 22.

Pasquereau, B. & Turner, RS Обмежене кодування зусиль дофаміновими нейронами в компромісному завданні з вигідною ціною. J. Neurosci. 33, 8288 – 8300 (2013).

- 23.

Вараццані, К., Сан-Галлі, А., Джилардо, С. та Буре, С. Норадреналін та дофамінові нейрони в компромісі винагорода / зусилля: пряме електрофізіологічне порівняння у мавп, що поводяться. J. Neurosci. 20, 7866 – 7877 (2015).

- 24.

Ватанабе, Н., Сакагамі, М. та Харуно, М. Сигнал про помилку передбачення винагороди, посилений взаємодією смугастого мигдалика, пояснює прискорення імовірнісного навчання винагородою емоціями. J. Neurosci. 33, 4487 – 4493 (2013).

- 25.

Di Ciano, P., Cardinal, RN, Cowell, RA, Little, SJ & Everitt, B. Диференціальна участь NMDA, AMPA / каїнату та дофамінових рецепторів в ядрі ядерного нагромадження у придбанні та виконанні поведінки павловського підходу. J. Neurosci. 21, 9471 – 9477 (2001).

- 26.

Flagel, SB та ін. Вибіркова роль дофаміну в навчанні стимулу-винагороди. природа 469, 53 – 57 (2011).

- 27.

Блу, Д.С. Вплив грунтовки, дискримінаційності та посилення на компоненти часу візуального пошуку голубів. J. Exp. Психол. Тварина. Бехав. Процес. 26, 50 – 63 (2000).

- 28.

Мацумото, М. та Хікосака, О. Два типи нейрону дофаміну чітко передають позитивні та негативні мотиваційні сигнали. природа 459, 837 – 841 (2009).

- 29.

Мацумото, М. і Такада, М. Виразні уявлення про когнітивні та мотиваційні сигнали в дофамінових нейронах середнього мозку. Нейрон 79, 1011 – 1024 (2013).

- 30.

Ватанабе, М. та ін. Поведінкові реакції, що відображають різні очікування нагород у мавп. Exp. Brain Res. 140, 511 – 518 (2001).

- 31.

Takikawa, Y., Kawagoe, R. & Hikosaka, O. Можлива роль нейронів дофаміну середнього мозку в коротко- та довгостроковій адаптації саккад до картографування винагороди за позицію. J. Neurophysiol. 92, 2520 – 2529 (2004).

- 32.

Кобаясі, С. та Шульц, В. Вплив затримок винагороди на відповіді нейронів дофаміну. J. Neurosci. 28, 7837 – 7846 (2008).

- 33.

Еномото, К. та ін. Дофамінові нейрони вчаться кодувати довгострокове значення декількох майбутніх винагород. Proc. Natl Acad. Sci. США 108, 15462 – 15467 (2011).

- 34.

Лак, А., Номото, К., Керамати, М., Сакагамі, М. і Кепеч, А. Середній мозок Допамінові нейрони сигналізують про віру в точність вибору під час прийняття перцептивного рішення. Curr. Biol. 27, 821 – 832 (2017).

- 35.

Вільямс, Б.А. та Макдевітт, М.А. Інгібування та суперкондиціонування. Психол. Sci. 13, 454 – 459 (2002).

- 36.

Беренс, ТЕ, Вулріч, М.В., Уолтон, М.Є. та Рашворт, М.Ф. Вивчення цінності інформації в невизначеному світі. Nat. Neurosci. 10, 1214 – 1221 (2007).

- 37.

Сеймур, Б. та ін. Апетитивно-аверсивні нейронні процеси у опонента лежать в основі прогнозного вивчення полегшення болю. Nat. Neurosci. 8, 1234 – 1240 (2005).

- 38.

Кім, Х., Шимохо, С. та О'Доерті, JP Чи уникнення недоброзичливих результатів нагороджує? Нейронні субстрати уникнення навчання в мозку людини. PLoS Biol. 4, e233 (2006).

- 39.

Syed, EC та ін. Ініціація дії формує мезолімбічне дофамінове кодування майбутніх нагород. Nat. Neurosci. 19, 34 – 36 (2016).

Подяки

Ця робота була підтримана MEXT / JSPS Grant-in-Aid for Scientific Research (Kakenhi) Номери грантів JP16H06571 та JP18H03662 для MS. Це дослідження було частково підтримано Програмою стратегічних досліджень наук про мозок за підтримки Японського агентства з медичних досліджень та розвитку (AMED ) та Програму співпраці з дослідження мозку Японії та США. Це дослідження було підтримано Національним проектом біоресурсів Національного інституту фізіологічних наук (NBRP при NIPS) від Японського агентства з медичних досліджень та розробок AMED. Ми дякуємо Бернарду В.Баллейн та Ендрю Р. Деламатеру за допомогу в написанні статті.